AnyDesk — популярное программное обеспечение для удаленного рабочего стола, получившее широкое признание благодаря простоте использования и надежной работе. Однако после недавнего выпуска Windows 11 некоторые пользователи столкнулись с трудностями при попытке запустить AnyDesk в этой новой операционной системе. Это заставило многих людей задаться вопросом, почему AnyDesk не работает должным образом на их ПК с Windows 11, и искать решения для решения этих проблем.

В этой статье мы рассмотрим некоторые распространенные причины несовместимости AnyDesk с вашей системой Windows и предоставим потенциальные решения, которые помогут пользователям преодолеть эти проблемы и беспрепятственно возобновить работу с удаленным рабочим столом.

Почему AnyDesk не работает в Windows 11?

Существует несколько причин, по которым AnyDesk может работать неправильно в Windows 11. Одна из возможных причин — проблемы совместимости. AnyDesk может быть не полностью оптимизирован или обновлен для бесперебойной работы с новыми функциями и изменениями, представленными в Windows 11.

Проблемы с конфигурацией сети также могут привести к тому, что AnyDesk не будет работать в Windows 11. Если сетевые параметры на компьютере настроены неправильно, это может помешать AnyDesk установить стабильное соединение.

Кроме того, конфликты с другим программным обеспечением или настройками компьютера также могут мешать работе AnyDesk. Важно выявить любые конфликтующие приложения или настройки, которые могут вызывать проблему.

Способы исправить AnyDesk, не работающий в Windows 11

Теперь, когда вы знаете о потенциальных причинах проблем, с которыми вы сталкиваетесь при использовании AnyDesk в Windows 11, давайте перейдем к некоторым важным решениям. Ниже вы найдете некоторые из наиболее распространенных исправлений, которые следует предпринять, если AnyDesk не работает должным образом на вашем ПК с Windows:

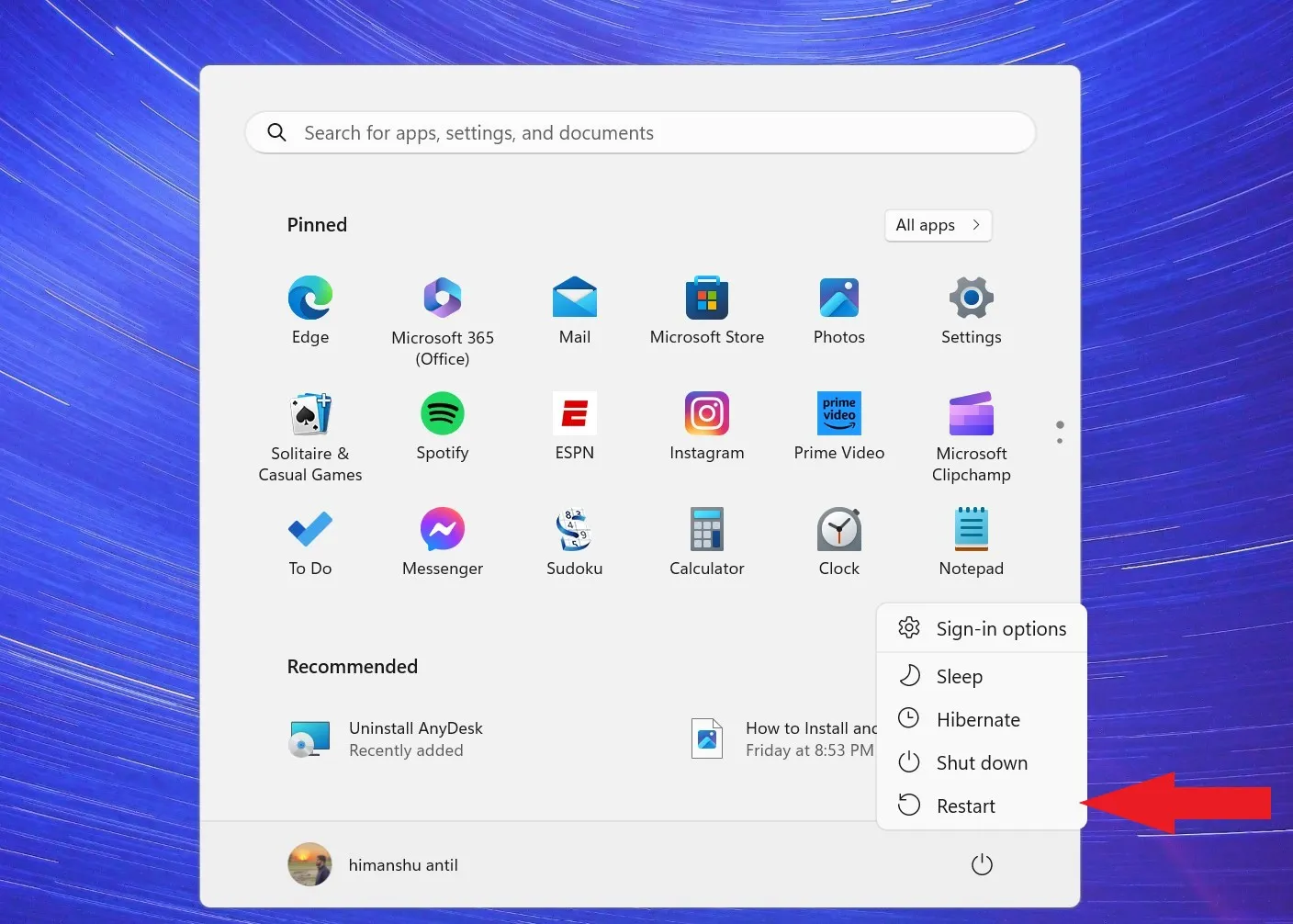

1. Перезагрузите компьютер.

Простой, но эффективный шаг — перезагрузить компьютер, поскольку это может помочь устранить временные сбои программного обеспечения и обновить системные процессы.

Выполните следующие действия, чтобы перезагрузить компьютер:

1. Нажмите клавишу Windows на клавиатуре, чтобы открыть меню поиска.

2. Отсюда найдите пункт меню «Питание», нажмите на него и выберите «Перезагрузить».

Это перезагрузит вашу систему. После завершения перезагрузки попробуйте проверить, снова ли работает AnyDesk.

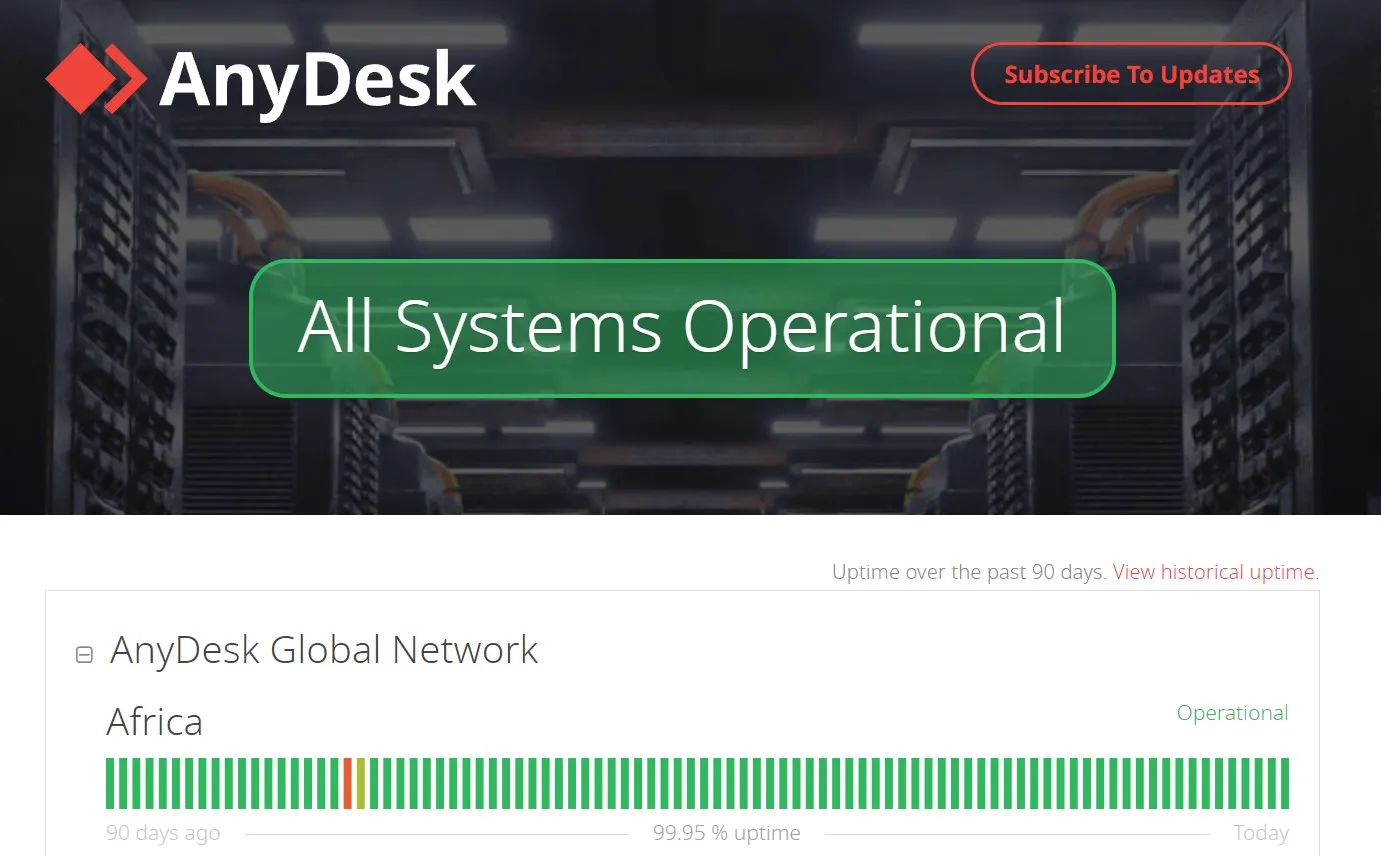

2. Проверьте статус сервера AnyDesk.

Иногда AnyDesk может не работать из-за проблем с сервером. Как и все другие онлайн-сервисы, AnyDesk в любой момент может выйти из строя сервер. В эти периоды простоя сервера приложение будет недоступно и непригодно для использования.

Чтобы проверить статус сервера, посетите официальный сайт AnyDesk или их каналы в социальных сетях. Если возникла проблема на стороне сервера, вы можете только подождать, пока она не будет решена технической командой.

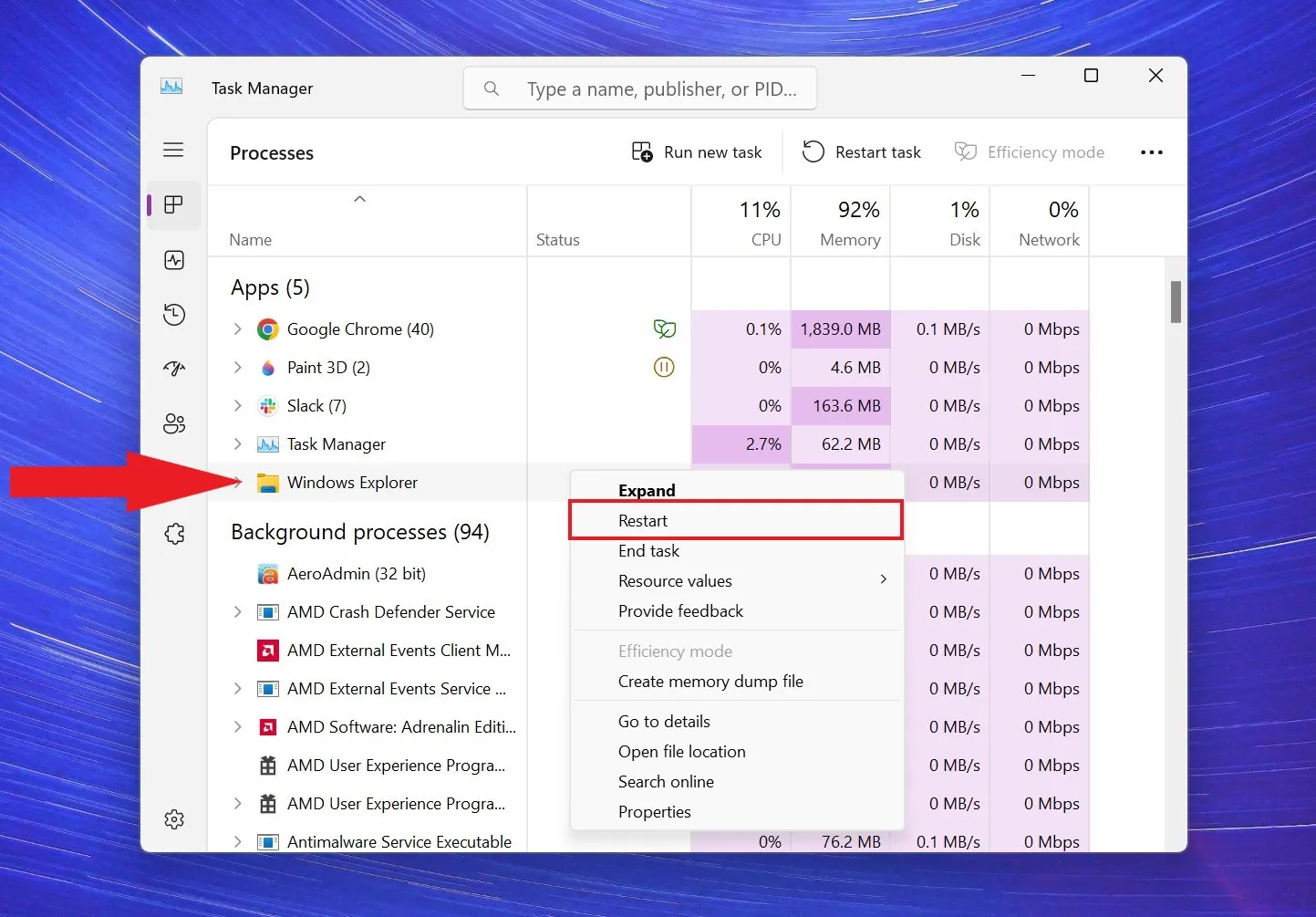

3. Перезапустите проводник.

Перезапуск проводника может эффективно обновить систему и устранить потенциальные конфликты, которые могут помешать правильной работе AnyDesk. Учитывая, что AnyDesk интегрирован в системный трей, обновление задачи Windows Explorer может сыграть решающую роль в исправлении ошибок, которые могут привести к сбоям в работе программного обеспечения AnyDesk.

Для этого выполните следующие действия:

1. Нажмите Ctrl+Shift+Esc, чтобы открыть диспетчер задач.

2. Теперь вам нужно открыть проводник, нажав, Win+E чтобы добавить задачу проводника Windows в диспетчер задач.

3. В окне «Диспетчер задач» найдите процесс «Проводник Windows».

4. Щелкните его правой кнопкой мыши и выберите пункт «Перезагрузить» в появившемся контекстном меню.

5. Вся панель задач Windows Explorer теперь обновится, включая AnyDesk.

После этого закройте окно диспетчера задач и попробуйте снова использовать AnyDesk. Если вы по-прежнему сталкиваетесь с теми же проблемами, вы также можете попробовать перезапустить AnyDesk.

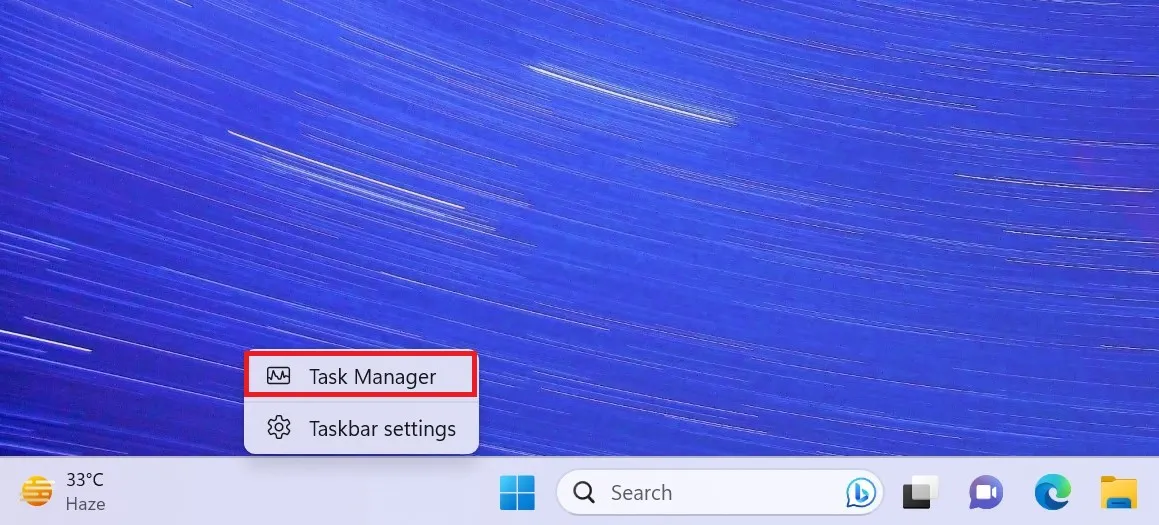

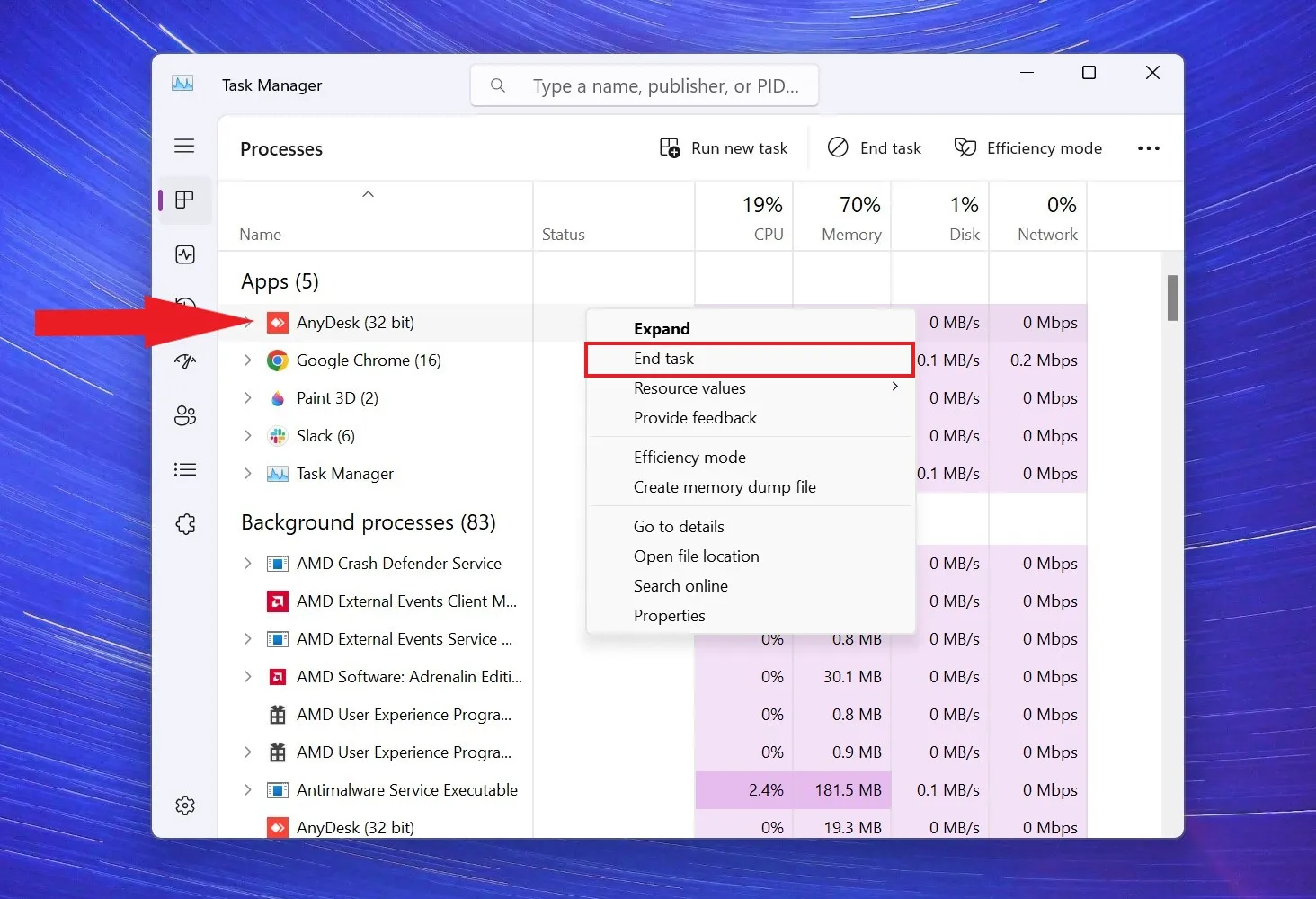

4. Попробуйте перезапустить AnyDesk.

Если AnyDesk не отвечает или зависает во время работы, попробуйте перезапустить приложение. Перезапуск AnyDesk должен решить все проблемы, с которыми вы столкнулись.

Выполните следующие действия, чтобы принудительно перезапустить AnyDesk с помощью диспетчера задач:

1. Нажмите стрелку на панели задач и щелкните правой кнопкой мыши значок AnyDesk. Затем выберите «Выход» или «Выход» в меню.

2. После этого, если в фоновом режиме выполняются какие-либо задачи AnyDesk, вы можете завершить их из диспетчера задач. Чтобы открыть диспетчер задач, щелкните правой кнопкой мыши область панели задач и выберите «Диспетчер задач», чтобы открыть его.

3. В окне диспетчера задач найдите процесс AnyDesk.

4. Щелкните его правой кнопкой мыши и выберите пункт «Завершить задачу» в контекстном меню.

Это полностью закроет AnyDesk, а затем перезапустит его, чтобы проверить, решена ли проблема.

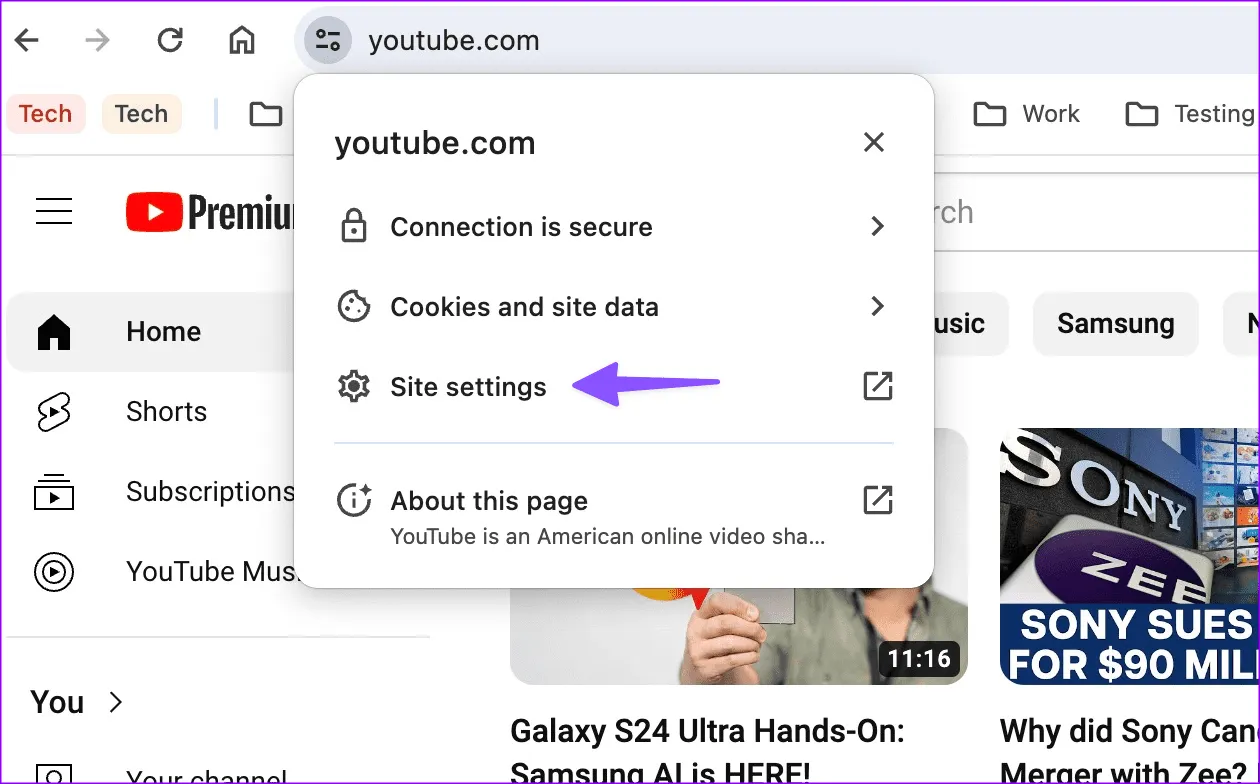

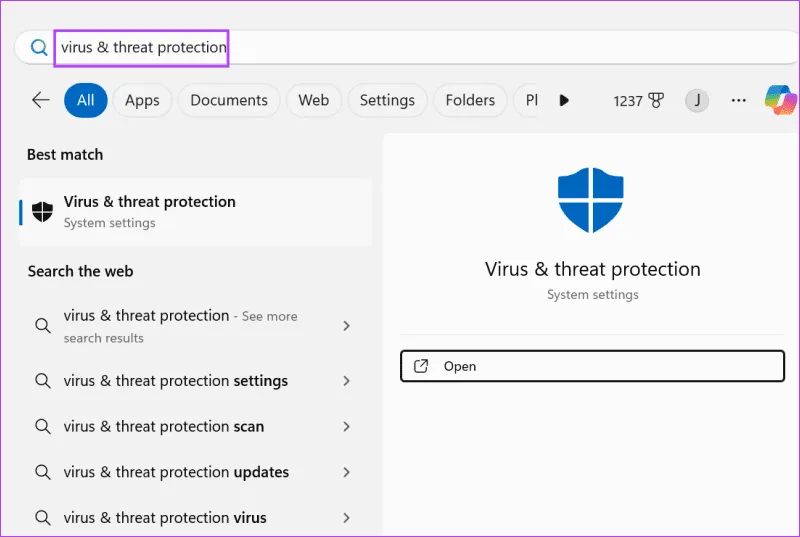

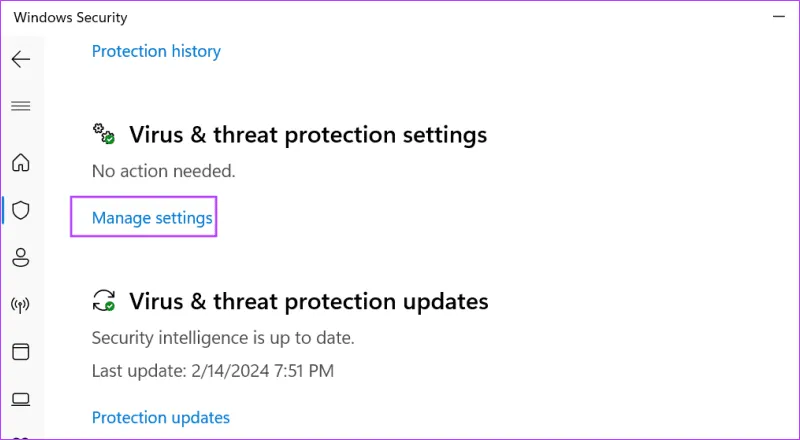

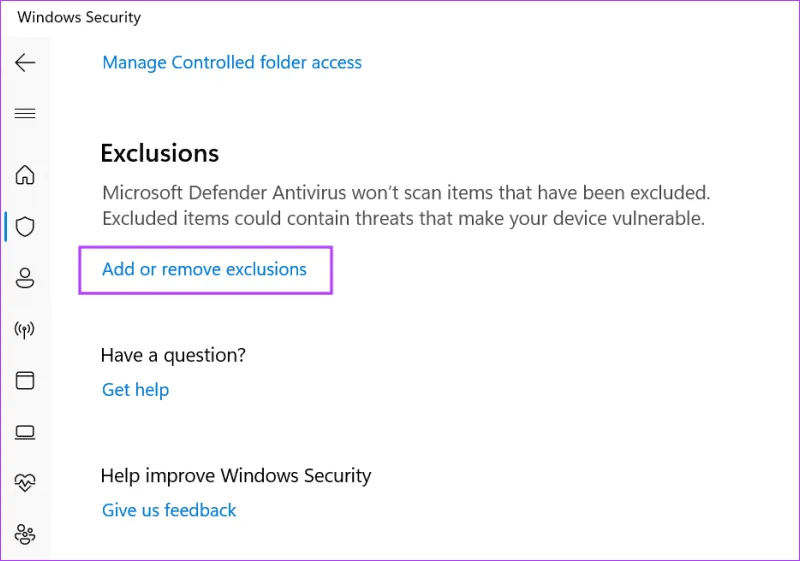

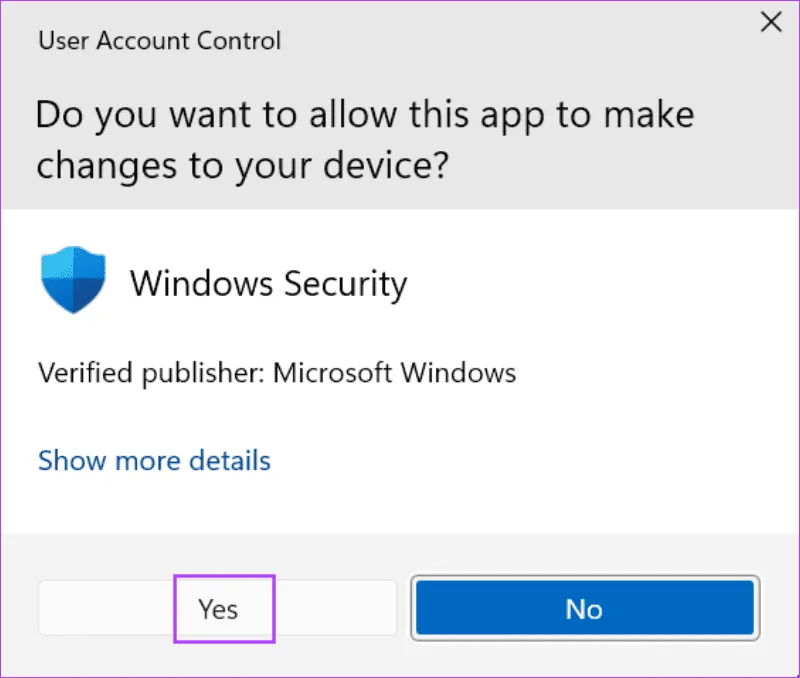

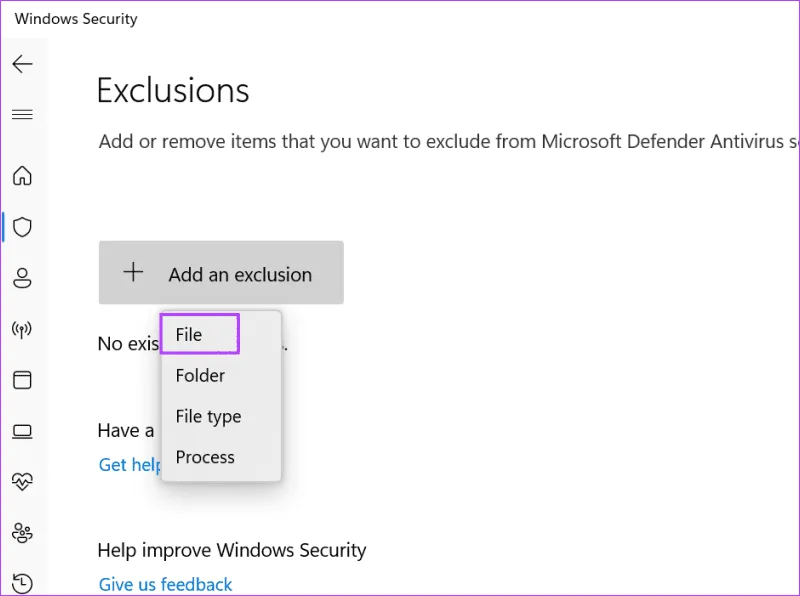

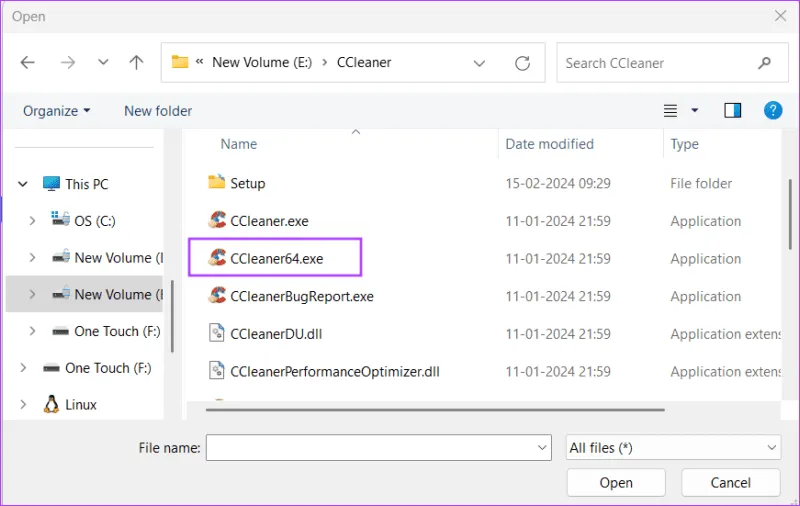

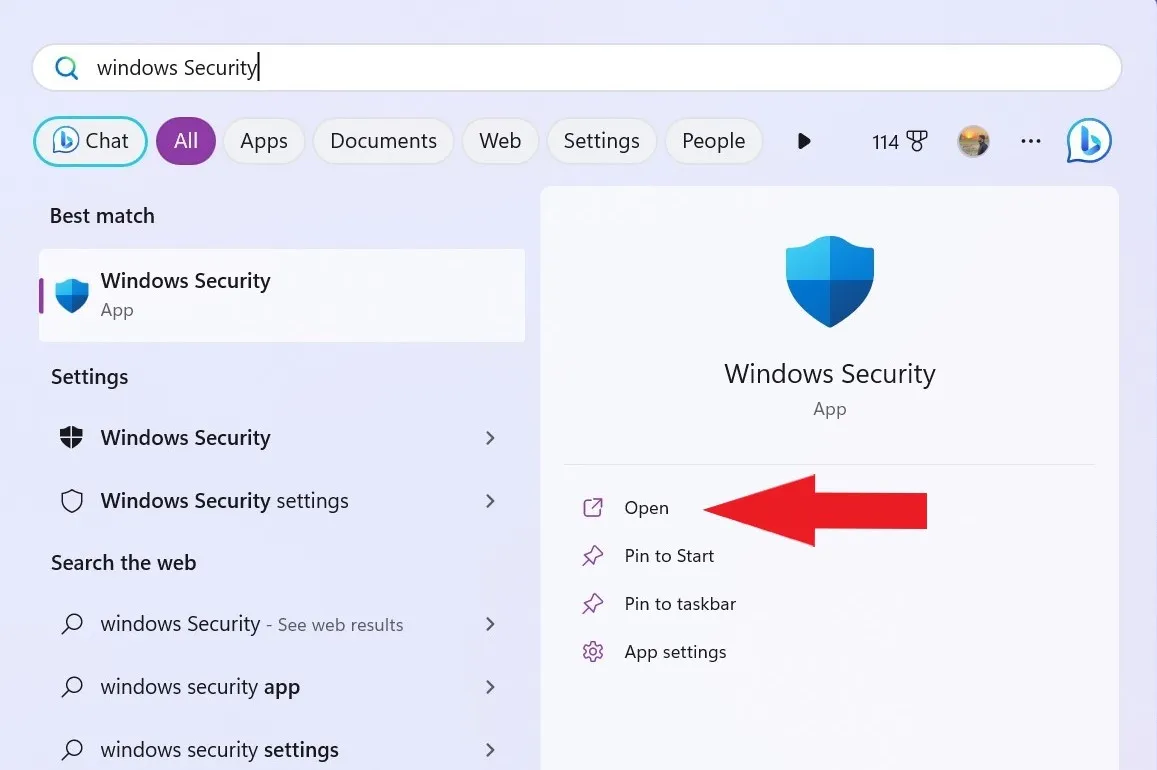

5. Проверьте настройки брандмауэра Защитника Windows.

Брандмауэр Защитника Windows иногда может блокировать AnyDesk при установке соединения. Чтобы убедиться, что AnyDesk разрешен через брандмауэр, выполните следующие действия:

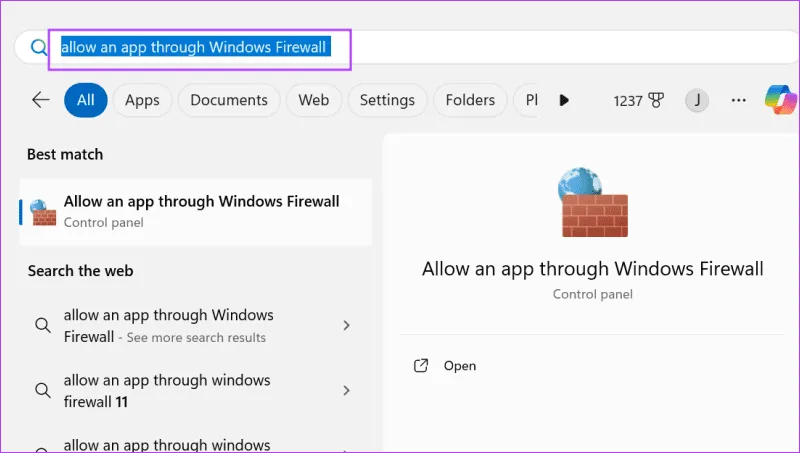

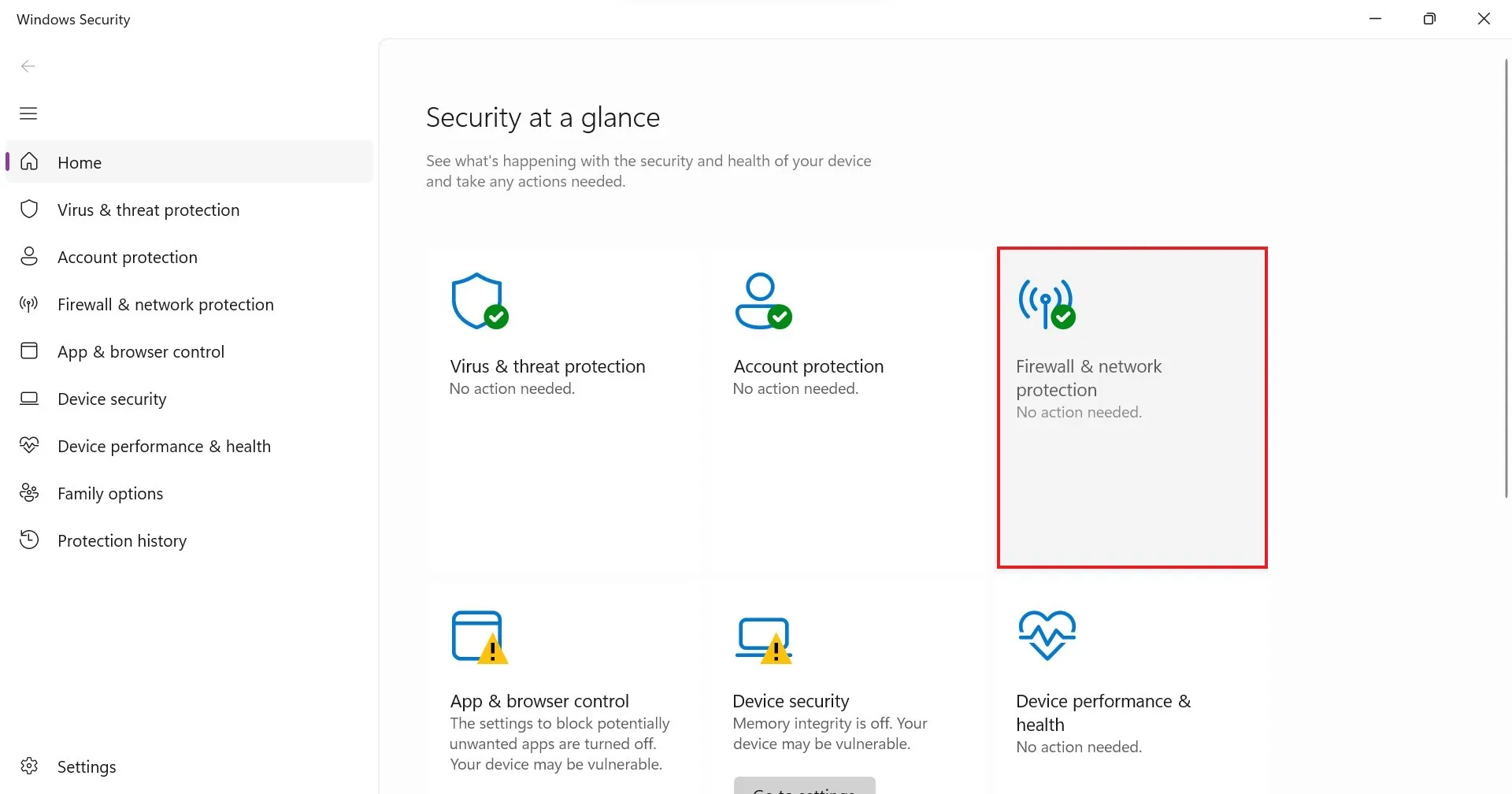

1. Откройте приложение «Безопасность Windows», выполнив поиск в меню «Пуск».

2. Нажмите на опцию «Брандмауэр и защита сети».

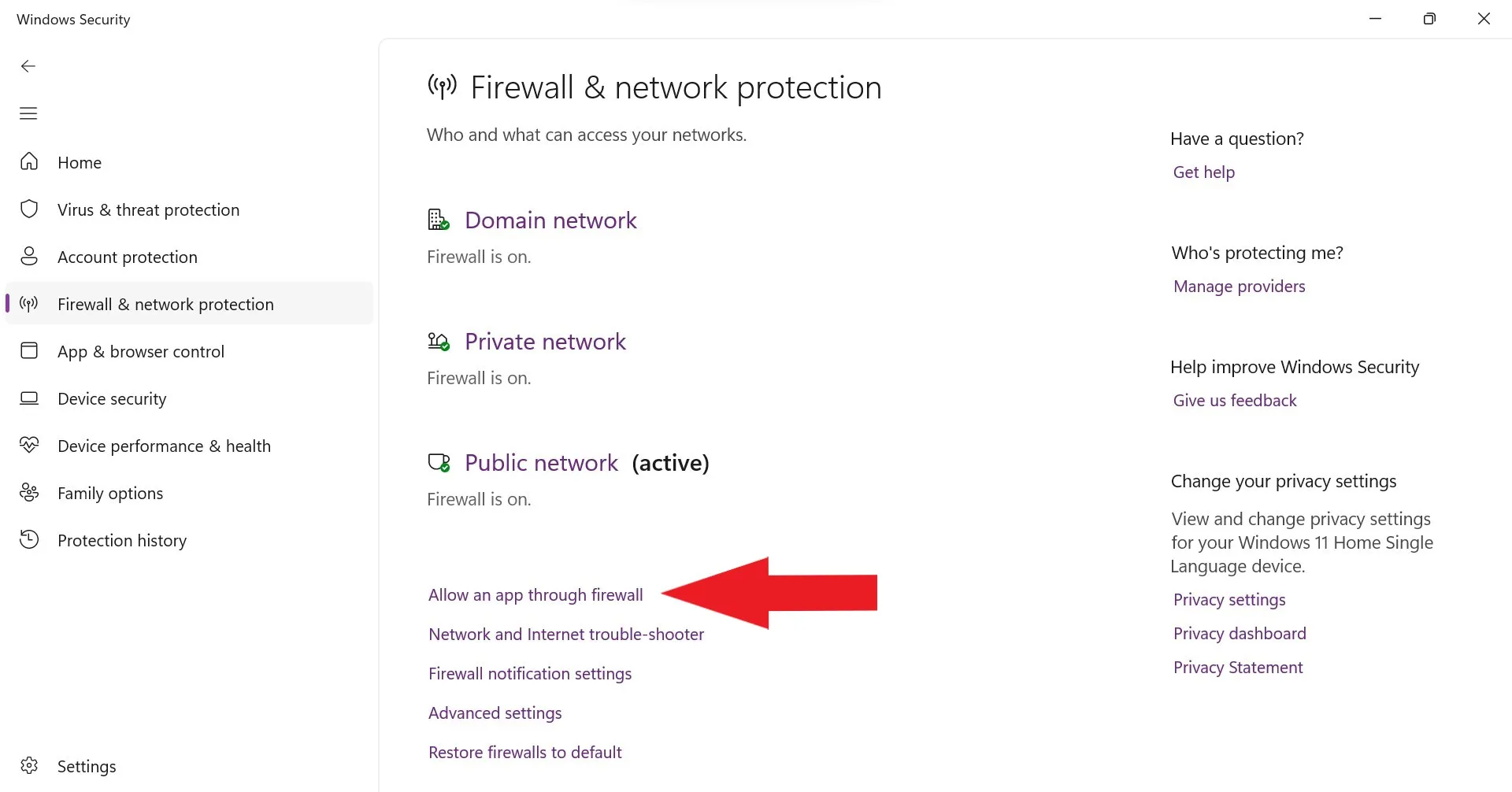

3. Здесь вы получите опцию брандмауэра и защиты сети. Чтобы разрешить использование AnyDesk через брандмауэр Windows, выберите параметр «Разрешить приложение через брандмауэр».

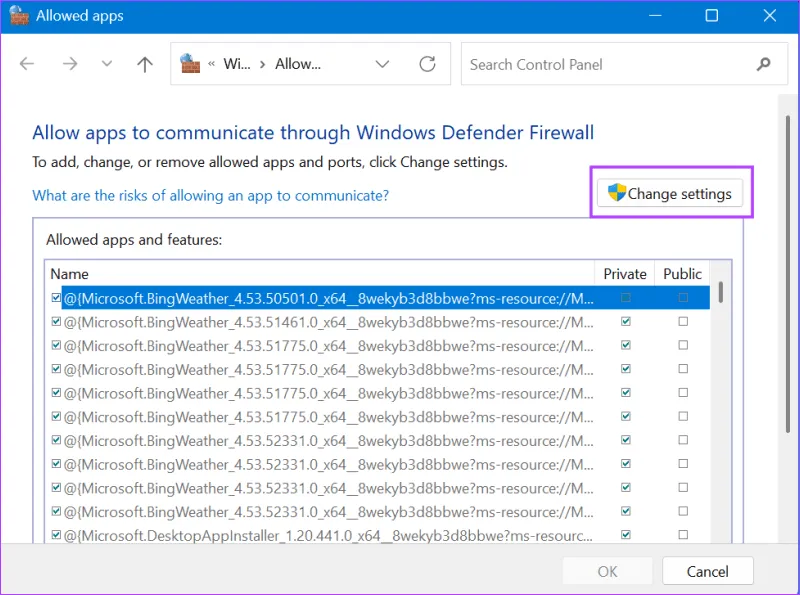

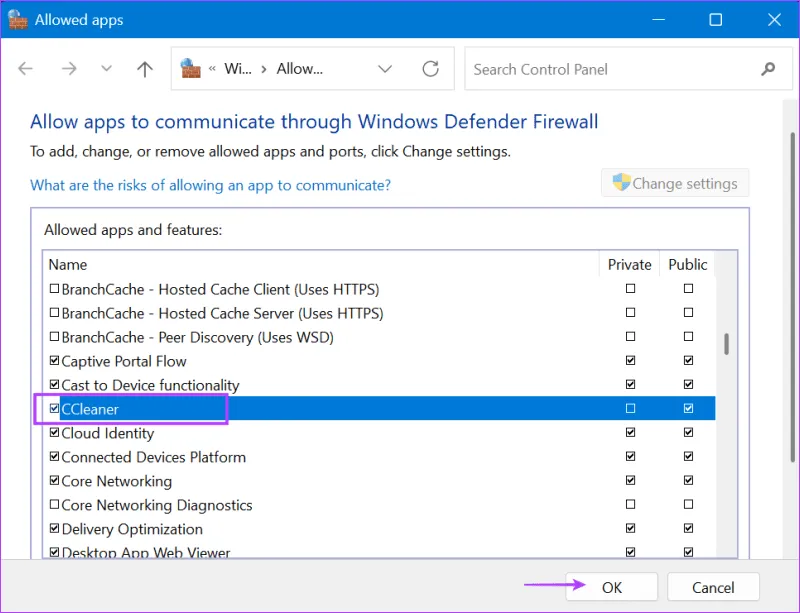

4. Нажмите на опцию AnyDesk в списке разрешенных приложений и функций. Затем нажмите кнопку «Изменить настройки» и убедитесь, что для AnyDesk установлены флажки «Частный» и «Общественный».

5. После этого нажмите ОК, чтобы применить изменения.

Если вы видите две опции AnyDesk, включите обе. Теперь попробуйте использовать AnyDesk и проверьте работоспособность приложения.

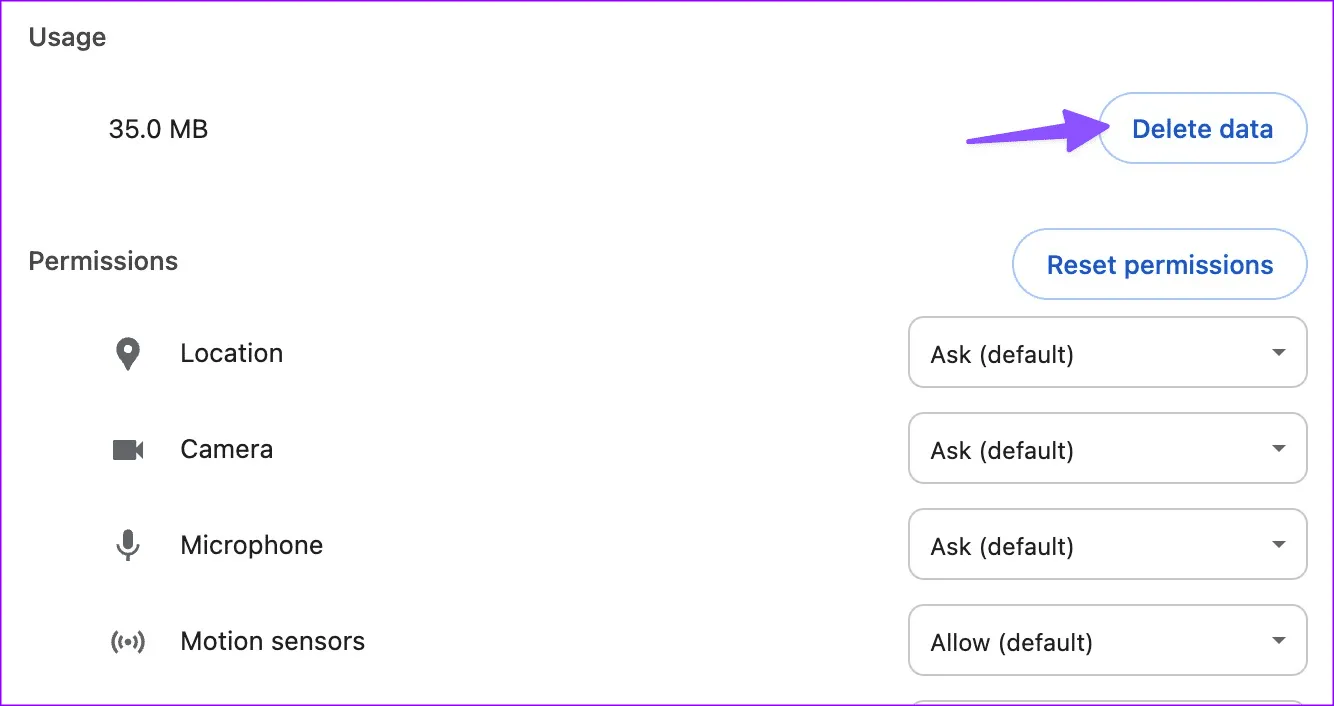

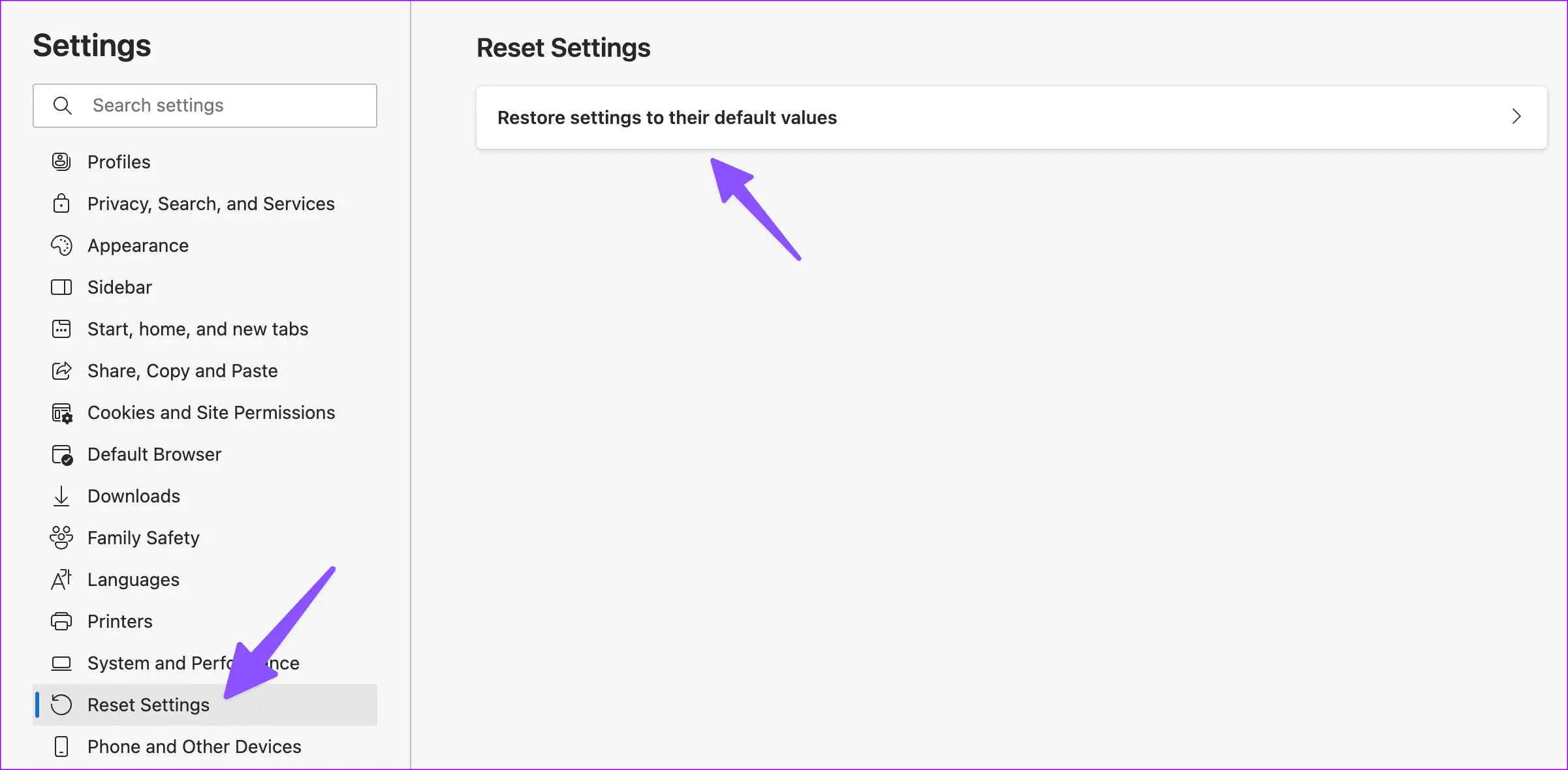

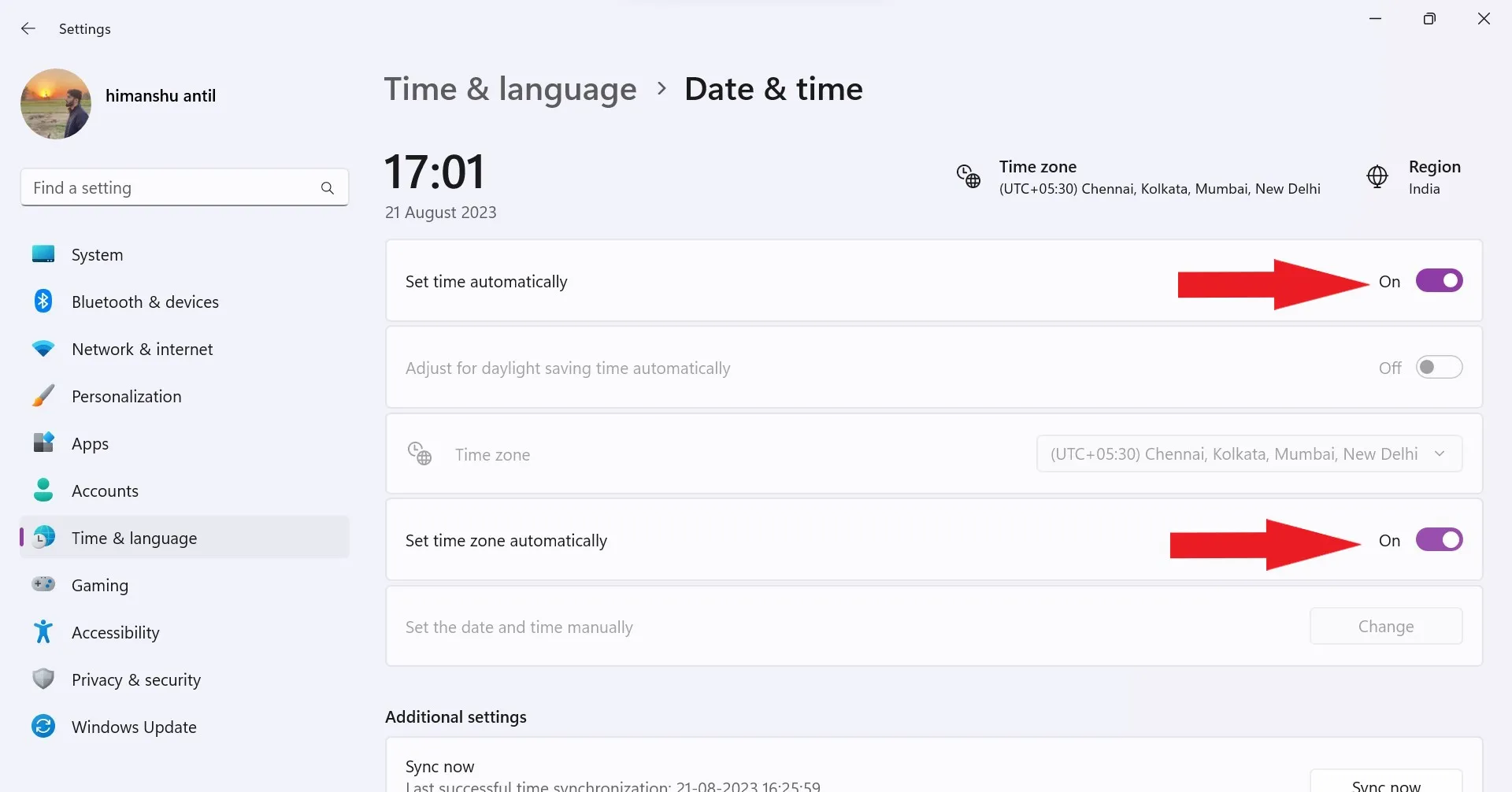

6. Измените дату и время

Неправильные настройки даты и времени на вашем компьютере могут вызвать проблемы с AnyDesk. Важно убедиться, что дата и время вашей системы установлены правильно.

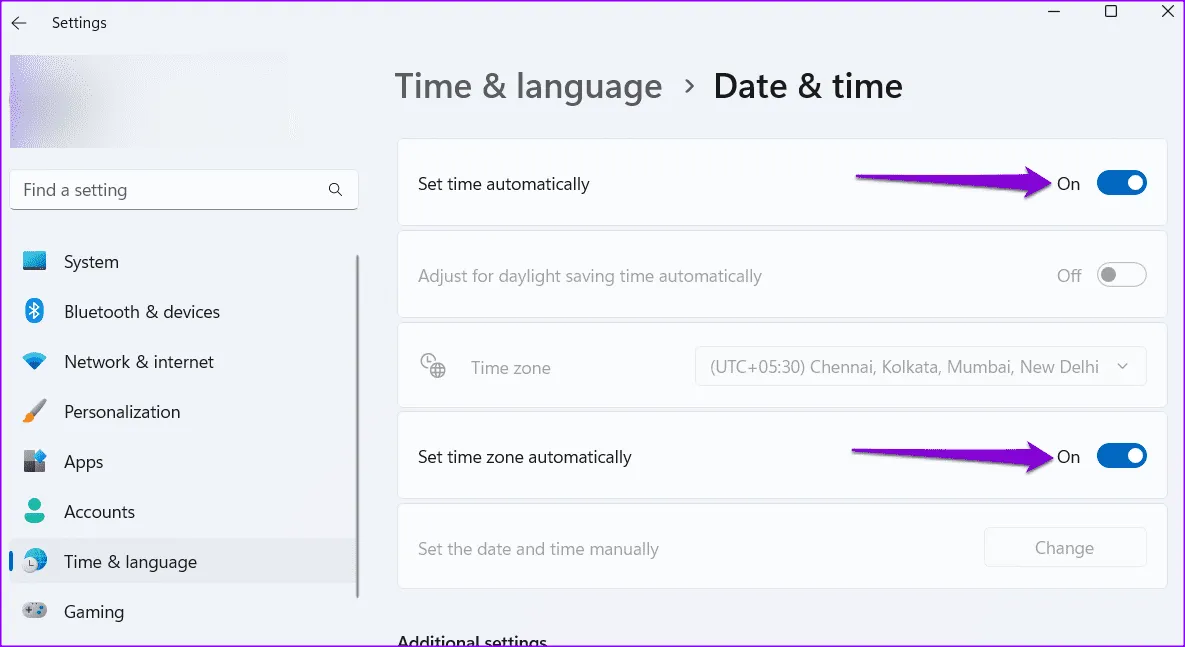

Чтобы изменить дату и время вашего устройства, выполните следующие действия:

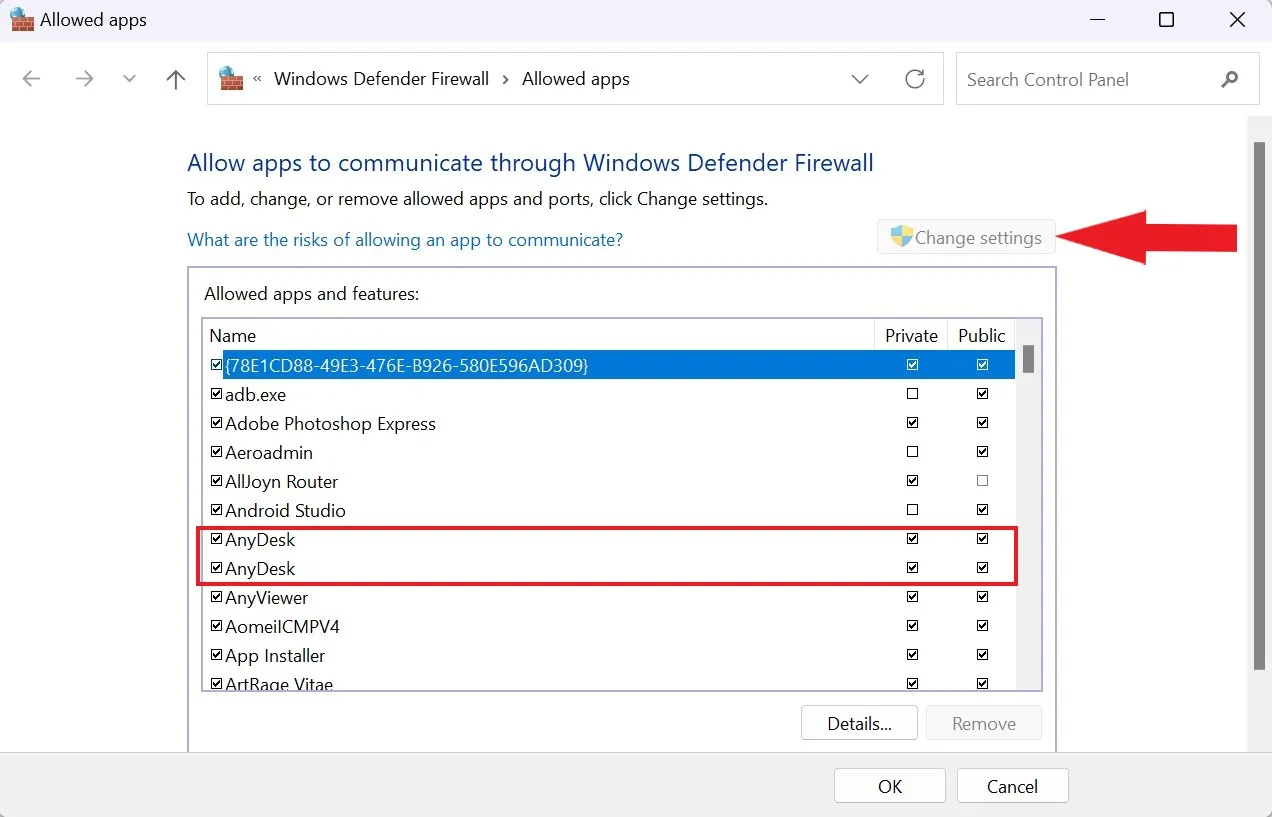

1. Откройте приложение «Настройки», одновременно нажав клавиши Windows+I на клавиатуре.

2. Нажмите на опцию «Время и язык», а затем выберите «Настройки даты и времени» на правой панели.

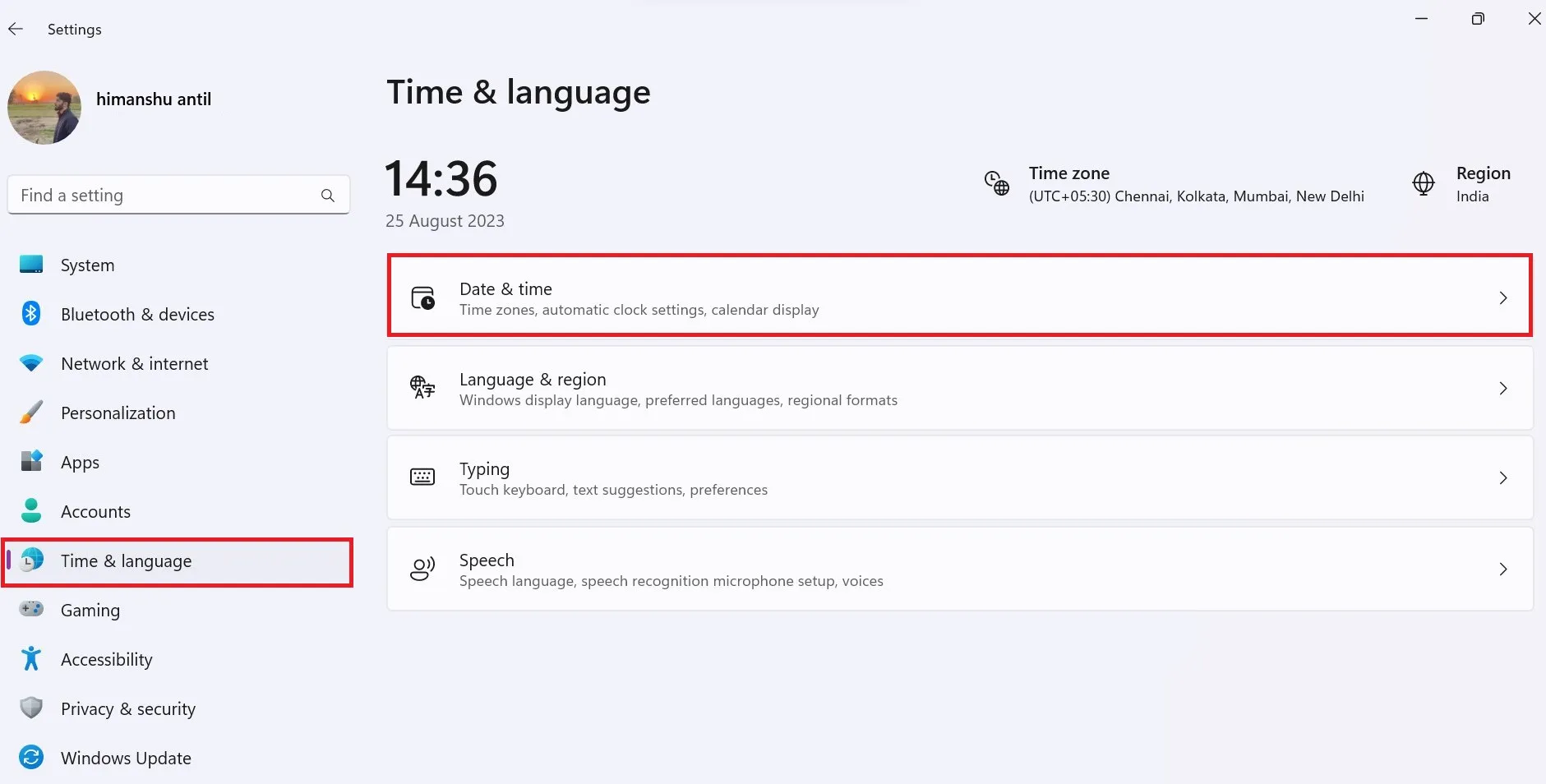

3. Убедитесь, что параметры «Установить время автоматически» и «Установить часовой пояс автоматически» включены.

4. Если время и дата неверны, отключите автоматические настройки и вручную установите правильное время и дату.

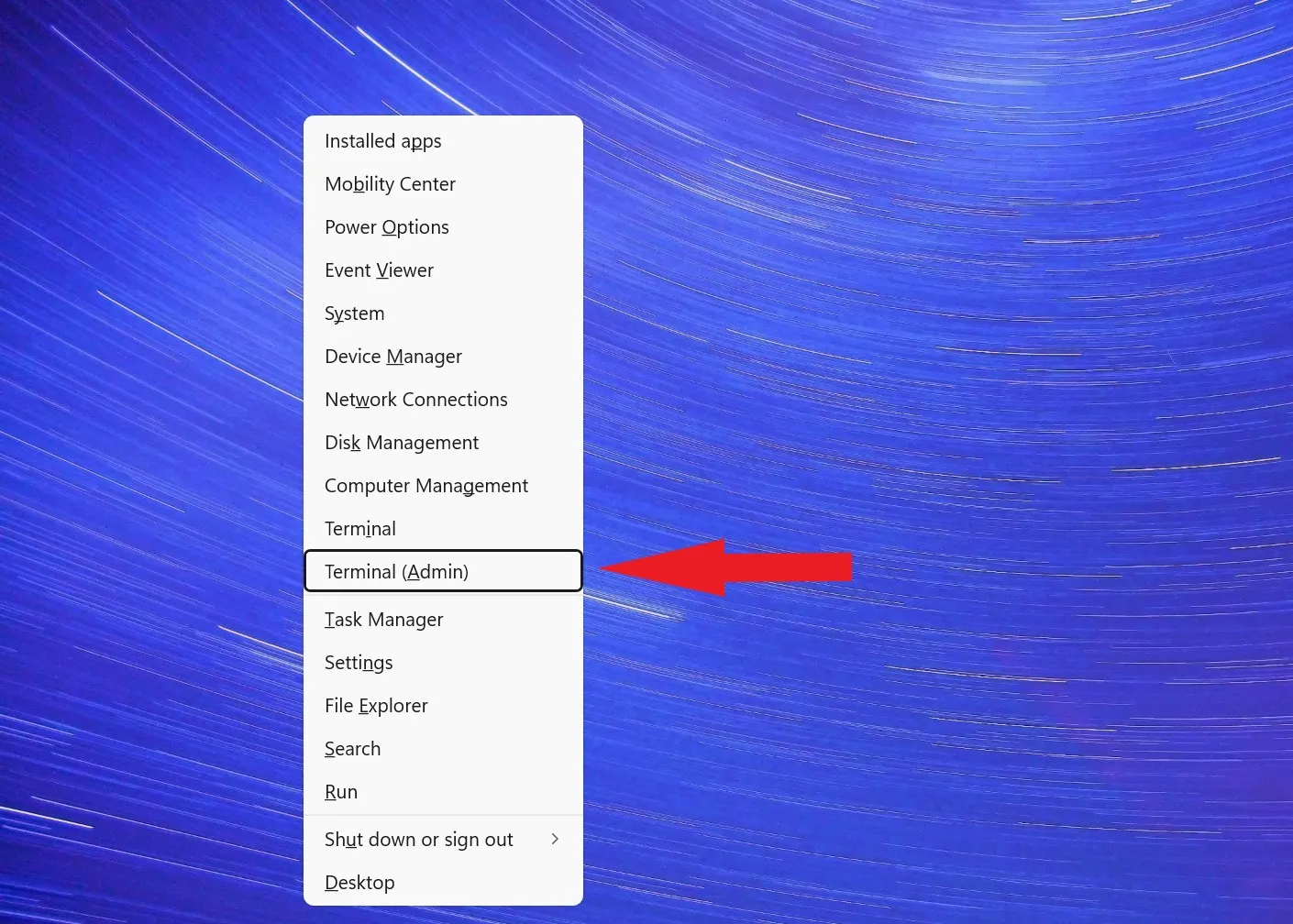

7. Попробуйте использовать команды сетевой командной строки.

Иногда сброс настроек сети может помочь решить проблемы с подключением к AnyDesk. Для решения проблем с сетью вы можете выполнять различные сетевые команды в командной строке или терминале Windows. Здесь, в этом руководстве, мы собираемся использовать терминал Windows в качестве администратора.

Для этого вы можете выполнить следующие шаги:

1. Нажмите Windows+X, чтобы открыть меню питания. Здесь выберите Терминал (Администратор), чтобы открыть интерфейс командной строки.

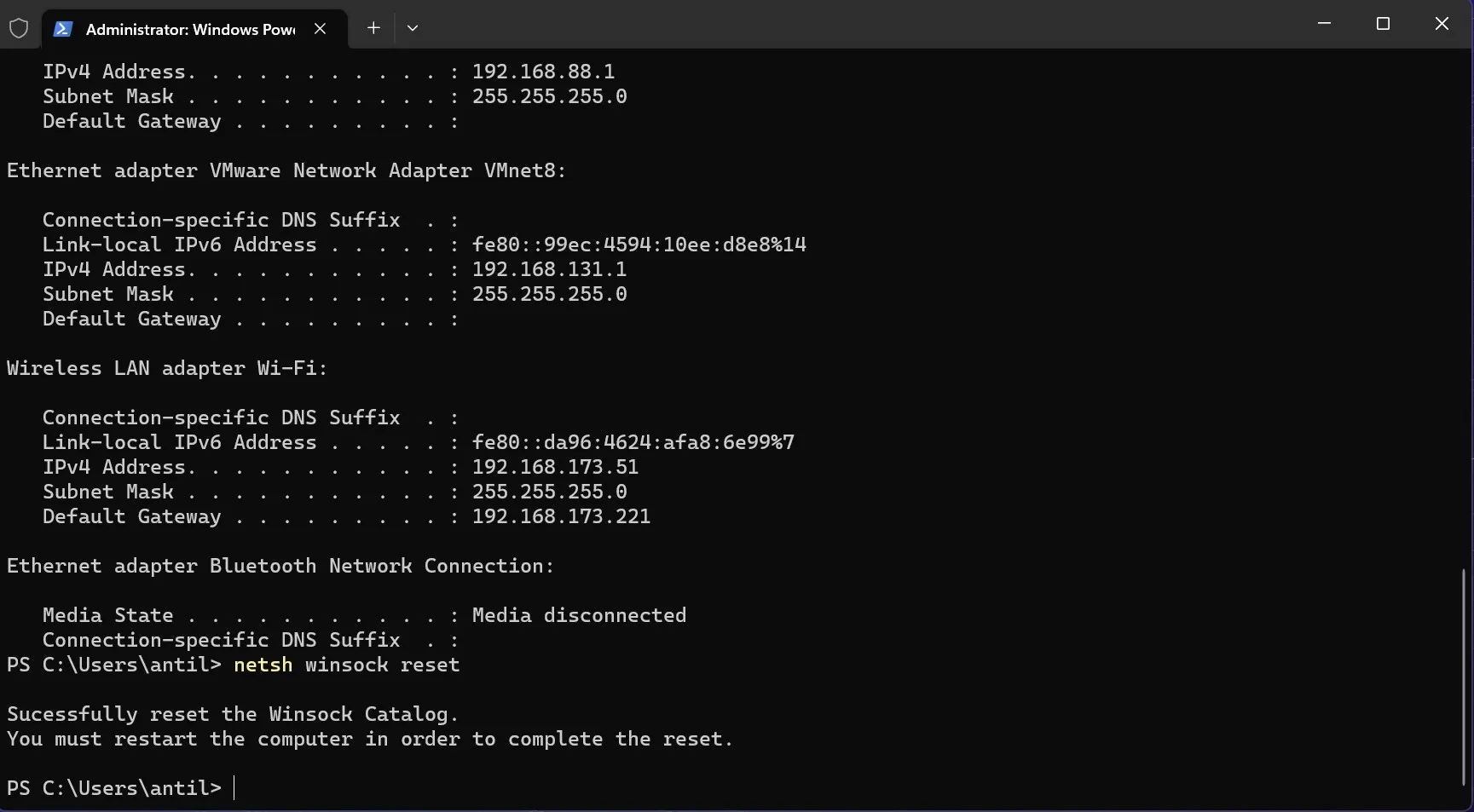

2. В окне командной строки введите одну за другой следующие команды и нажмите Enter после каждой:

ipconfig /flushdns

ipconfig /flushdns

ipconfig /registerdns

ipconfig /release

ipconfig /renew

netsh winsock reset

3. После выполнения команд перезагрузите компьютер и проверьте, работает ли AnyDesk.

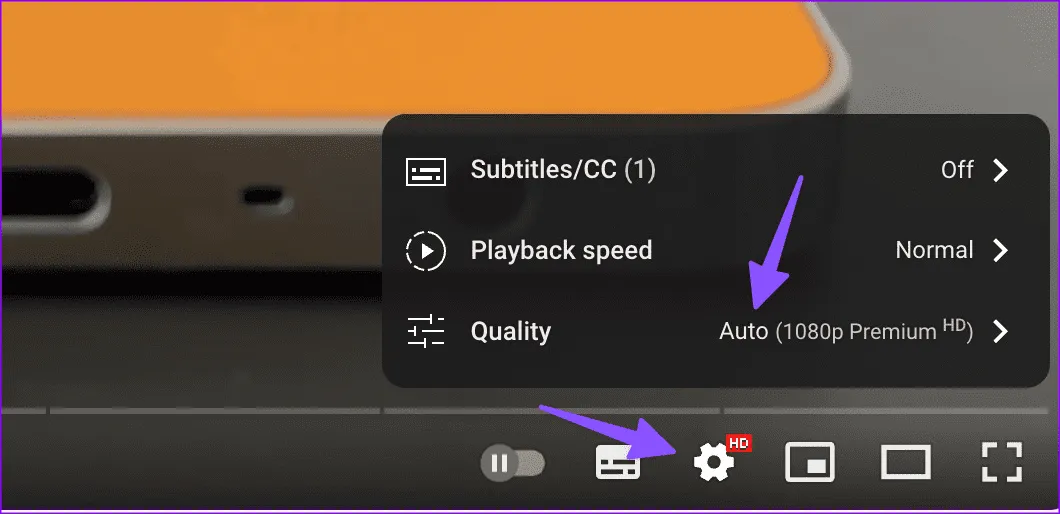

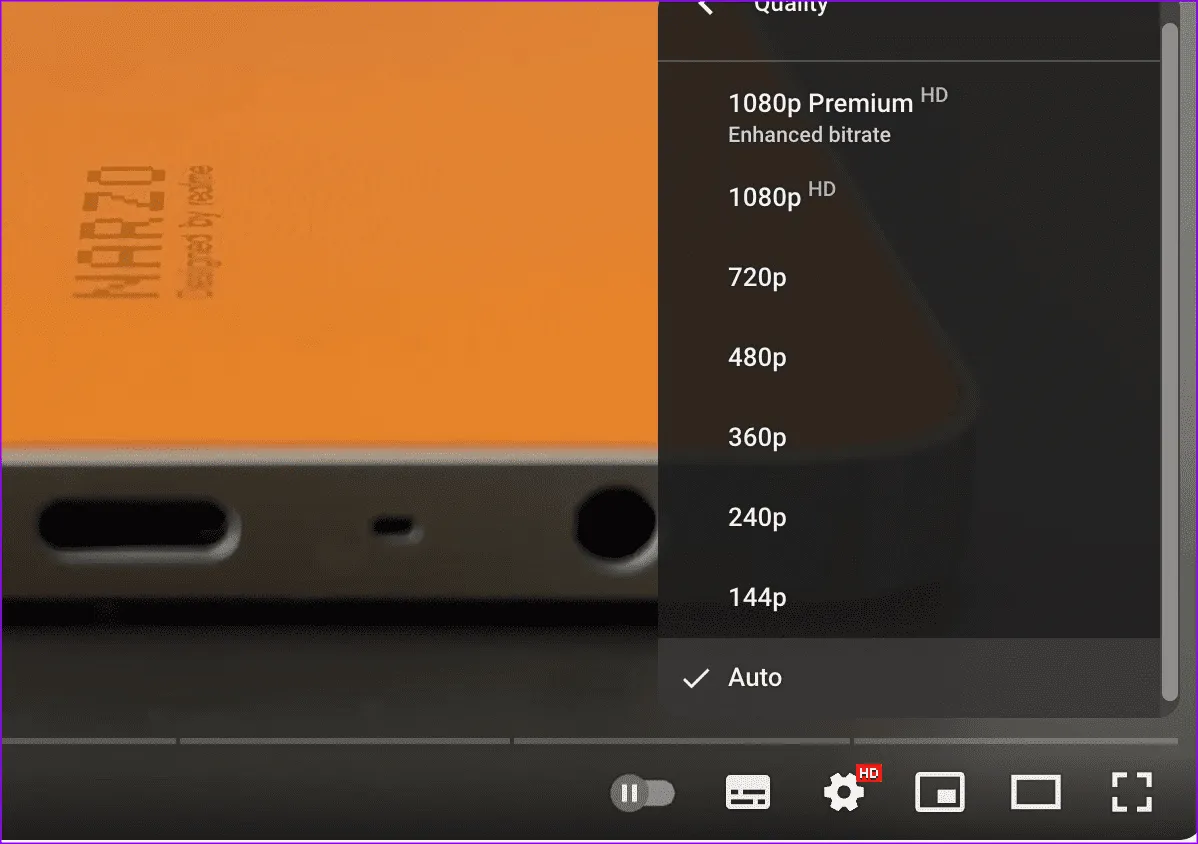

8. Изменить качество отображения

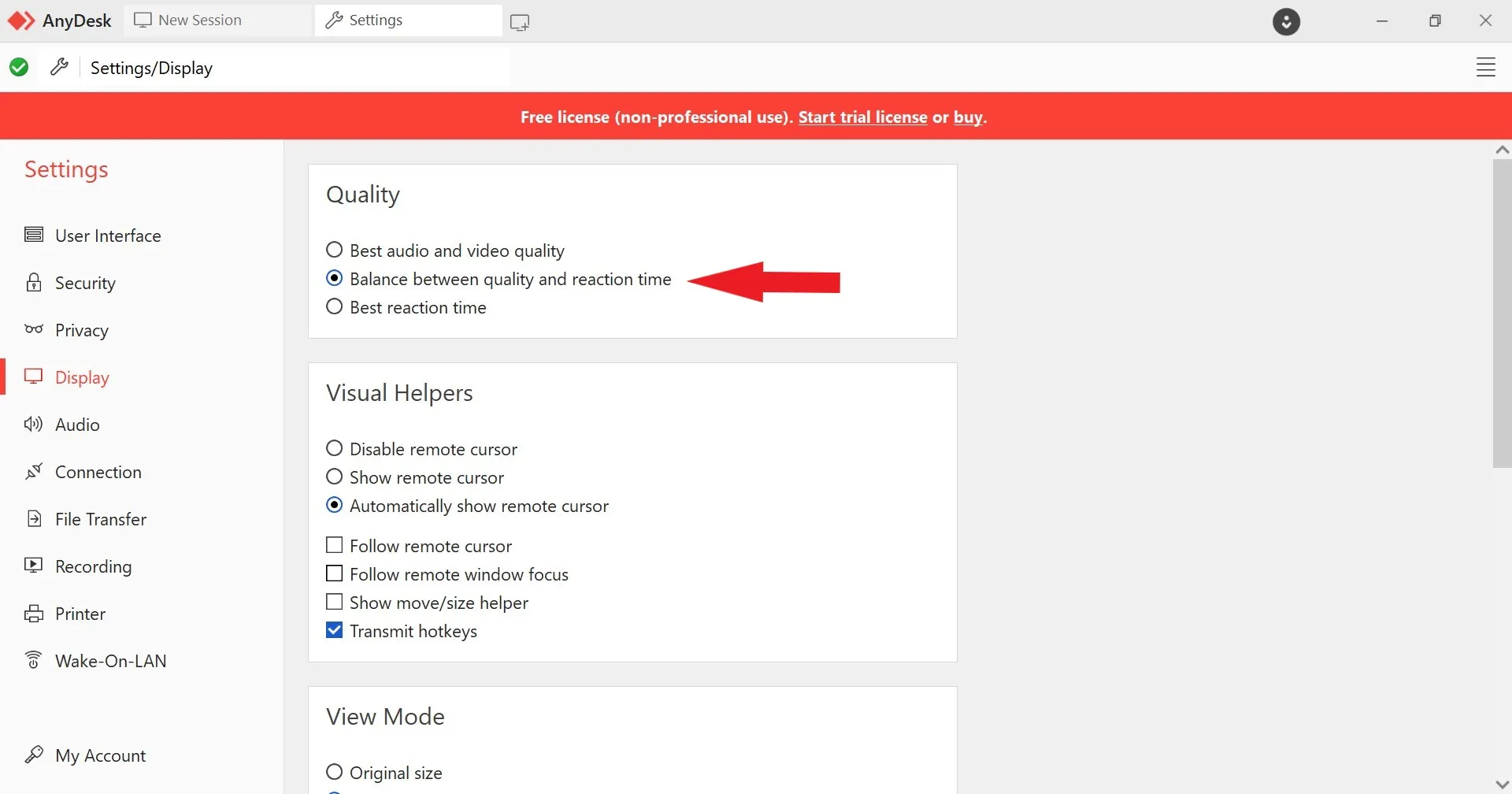

Если у вас плохое подключение к Интернету, у вас могут возникнуть пропадания кадров видео, поскольку для использования AnyDesk требуется стабильное соединение. Если вы столкнулись с проблемами качества отображения во время удаленных сеансов AnyDesk, вы можете попытаться настроить параметры отображения в приложении.

Вот как вы можете изменить качество отображения в AnyDesk:

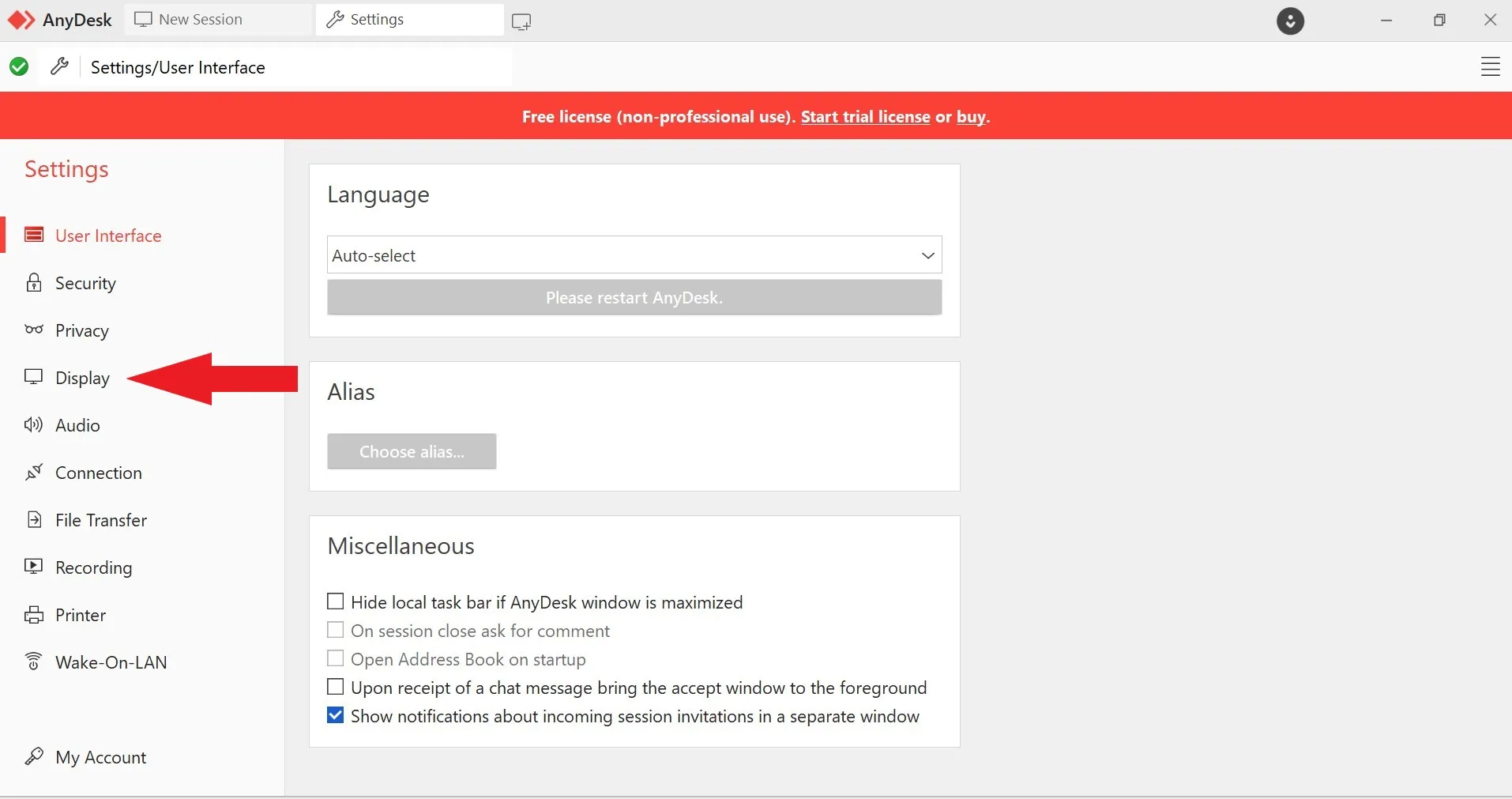

1. Откройте AnyDesk и щелкните значок «Настройки» в правом верхнем углу.

2. В меню настроек выберите вкладку «Дисплей» на левой панели.

3. Здесь вы можете настроить параметры дисплея в соответствии с вашими потребностями. Попробуйте уменьшить значение, чтобы уменьшить использование полосы пропускания и потенциально повысить производительность при более медленных соединениях.

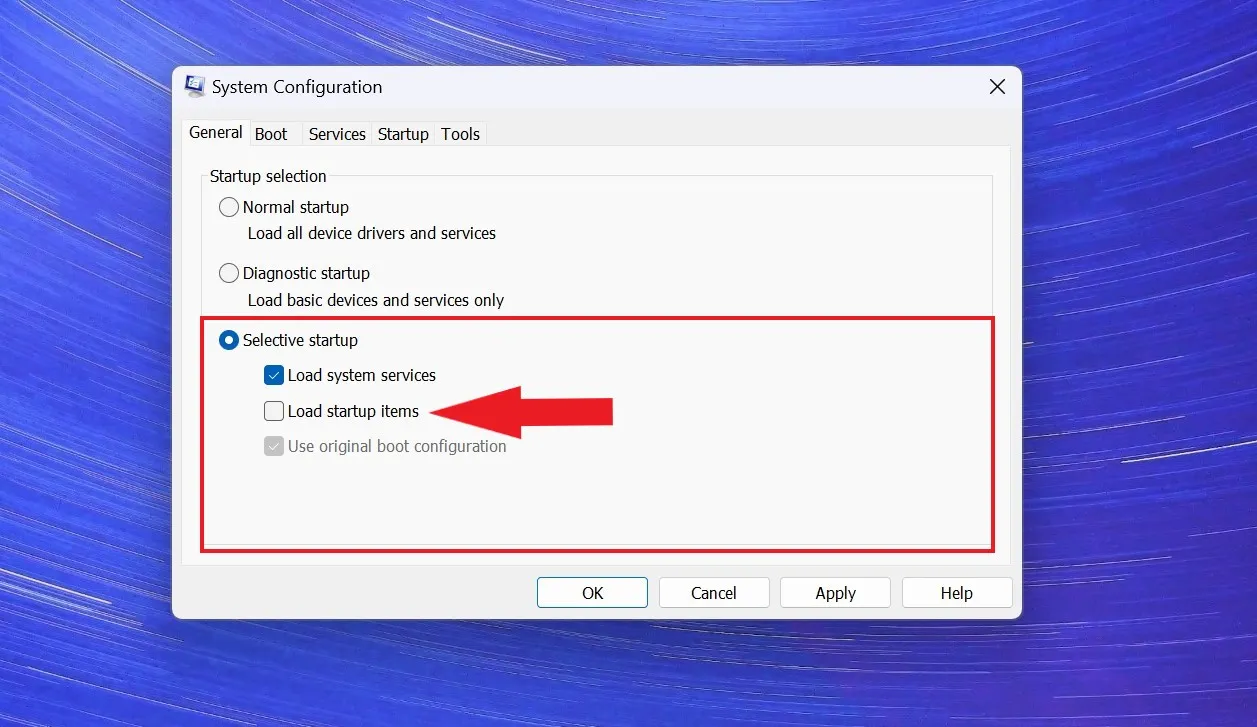

9. Выполните чистую загрузку

Выполнение чистой загрузки может помочь определить, вызывают ли сторонние программы или службы конфликты с AnyDesk. Этот метод предполагает запуск компьютера с активными только основными системными службами и без запуска дополнительного программного обеспечения, что помогает изолировать источник проблемы.

Чтобы выполнить чистую загрузку, выполните следующие действия:

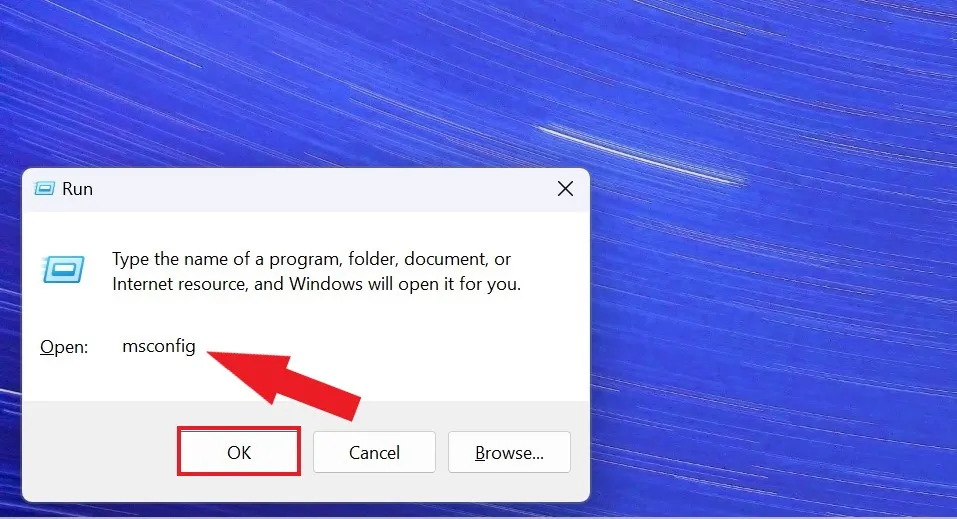

1. Нажмите Windows+R, чтобы открыть диалоговое окно «Выполнить».

2. Введите msconfig и нажмите Enter, чтобы открыть окно «Конфигурация системы».

3. На вкладке «Общие» выберите «Выборочный запуск» и снимите флажок «Загружать элементы автозагрузки».

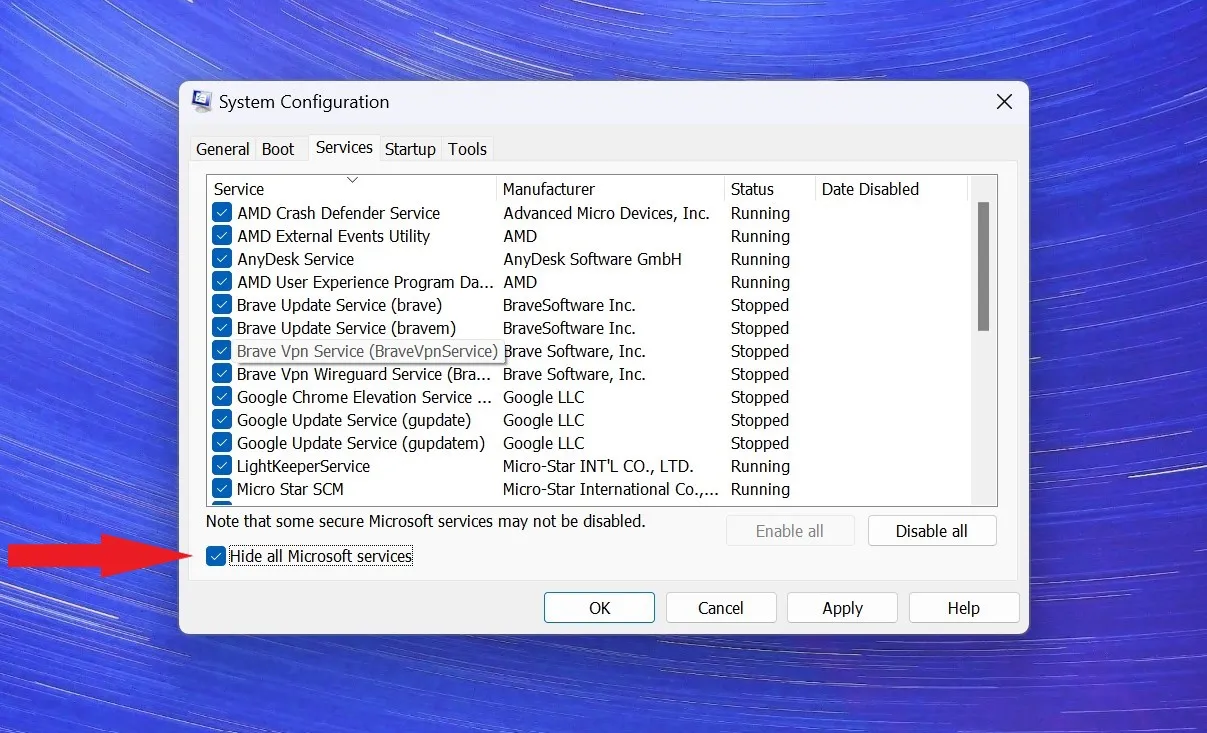

4. Перейдите на вкладку «Службы» и установите флажок «Скрыть все службы Microsoft».

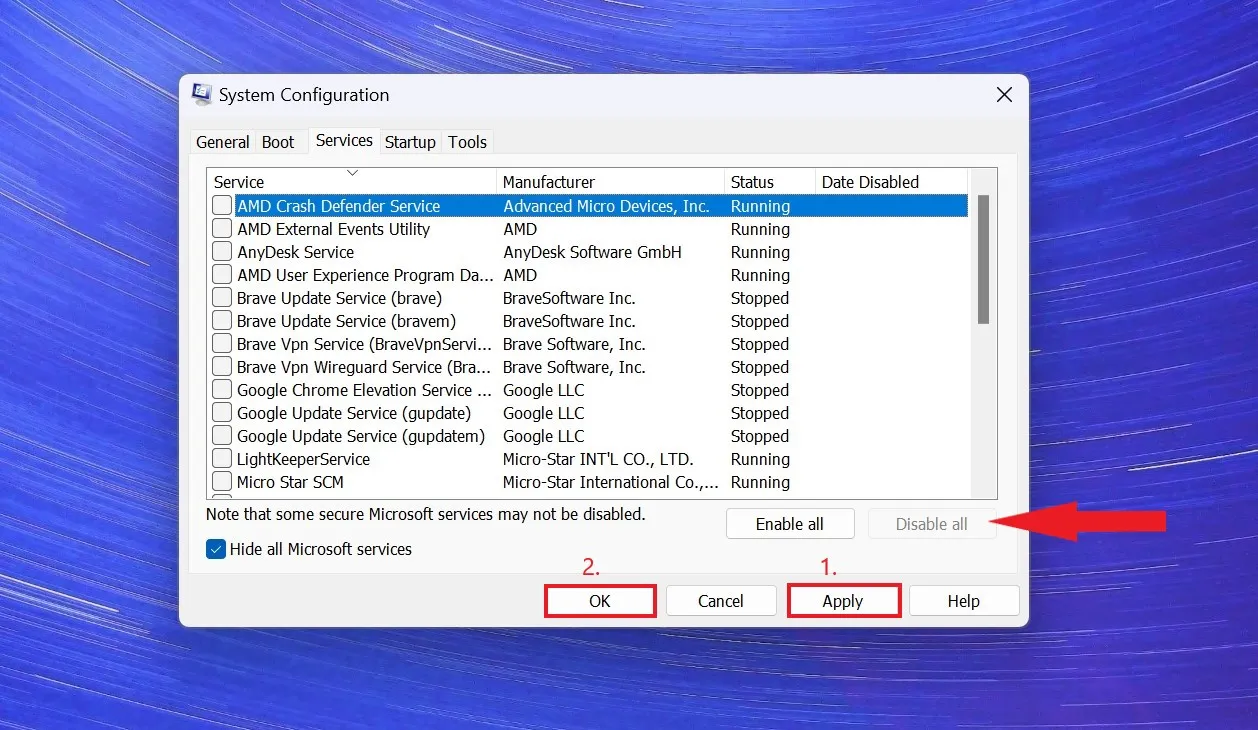

5. Нажмите кнопку «Отключить все», чтобы отключить все службы, не принадлежащие Microsoft. Нажмите «Применить», а затем «ОК», чтобы сохранить изменения.

После этого перезагрузите компьютер и проверьте, работает ли AnyDesk. Если это так, вы можете постепенно включать элементы автозагрузки и службы, чтобы определить конкретный из них, вызывающий проблему.

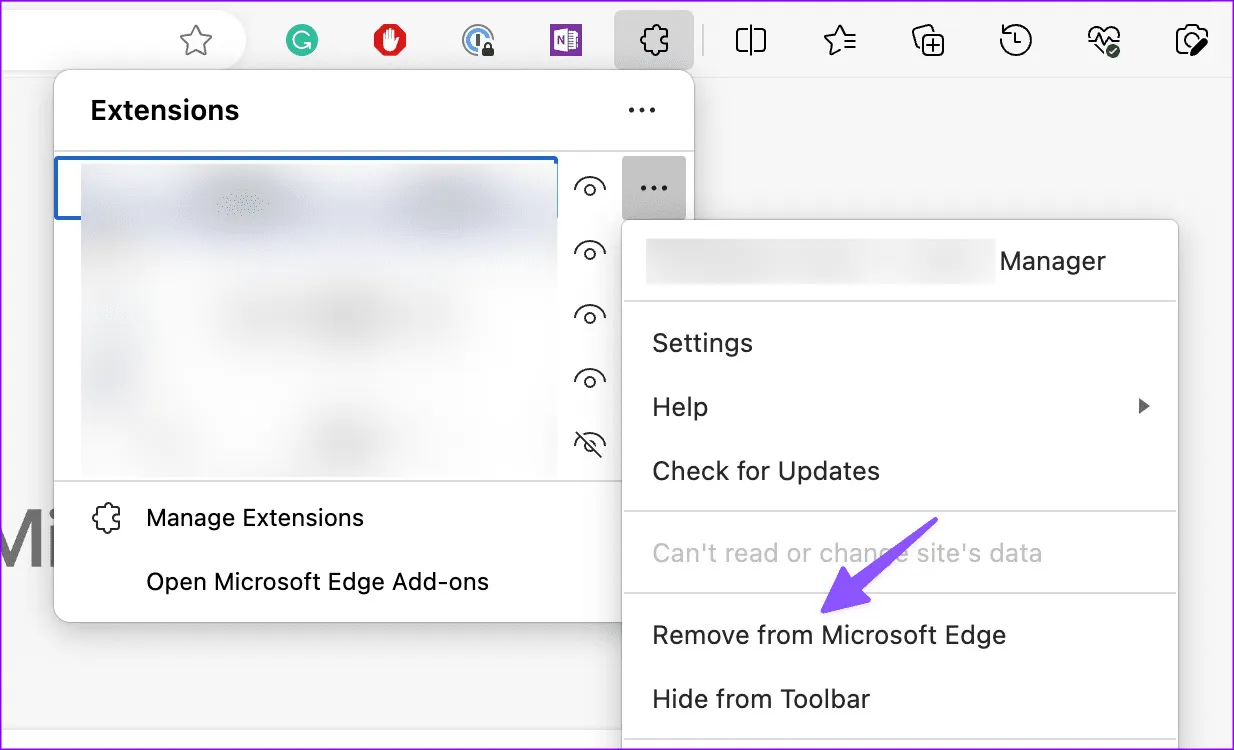

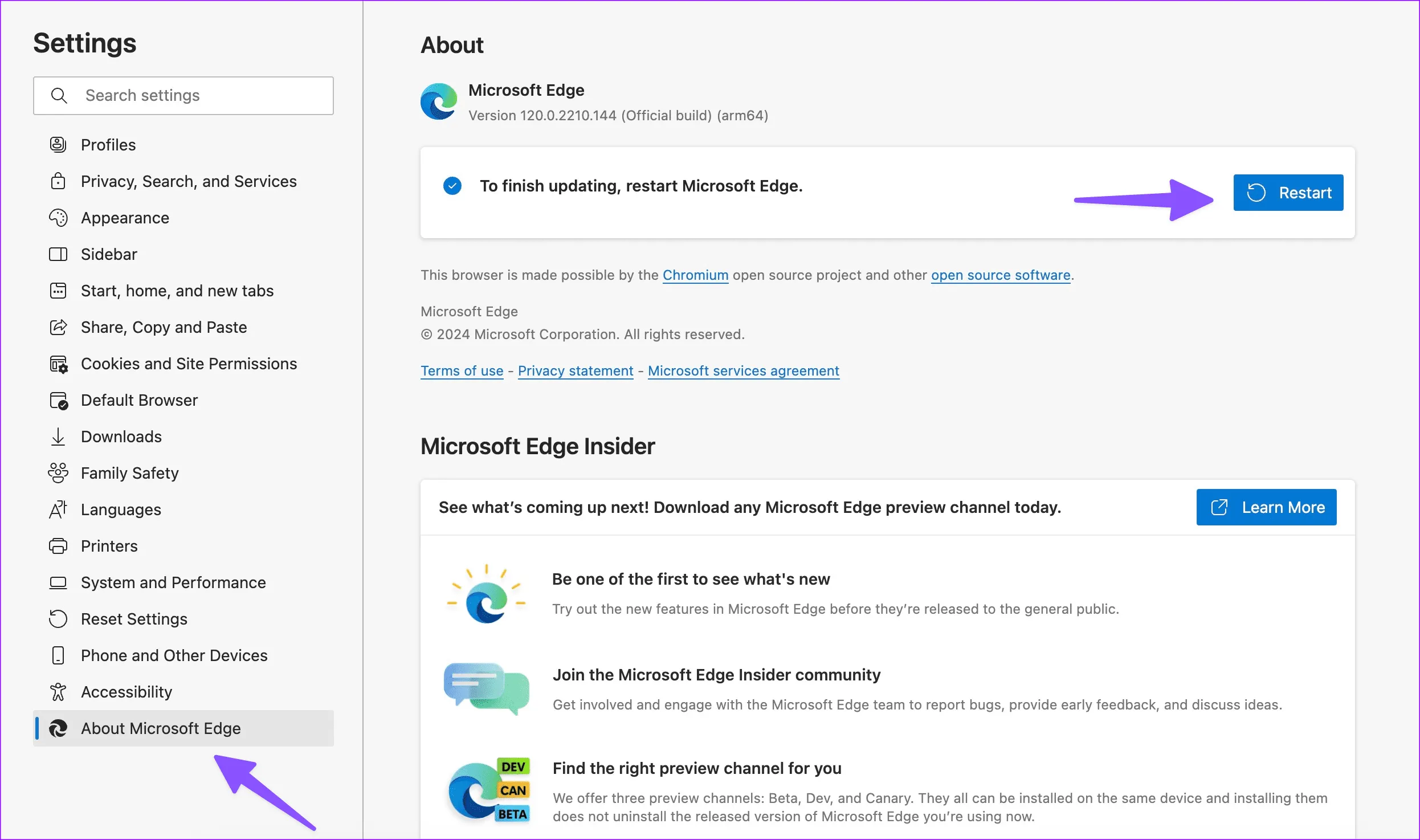

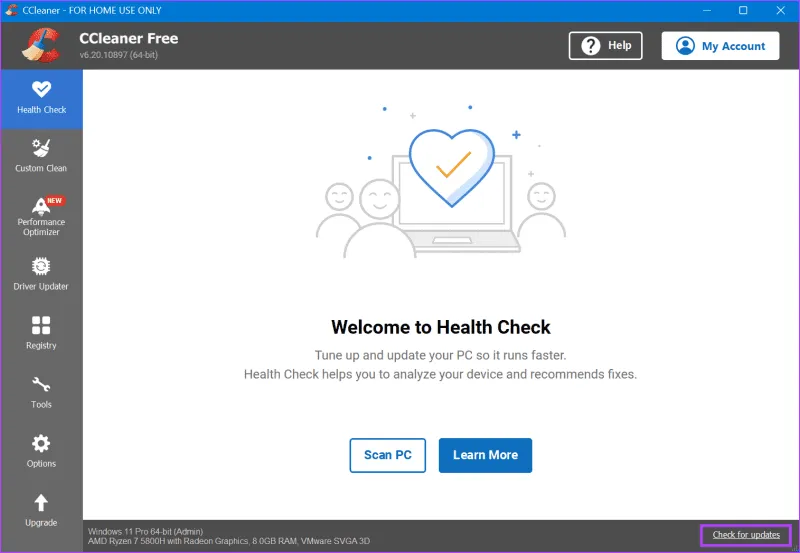

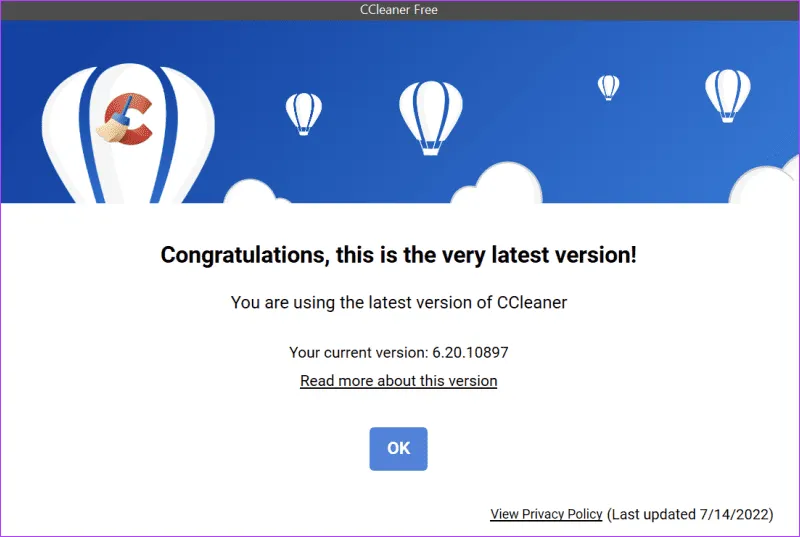

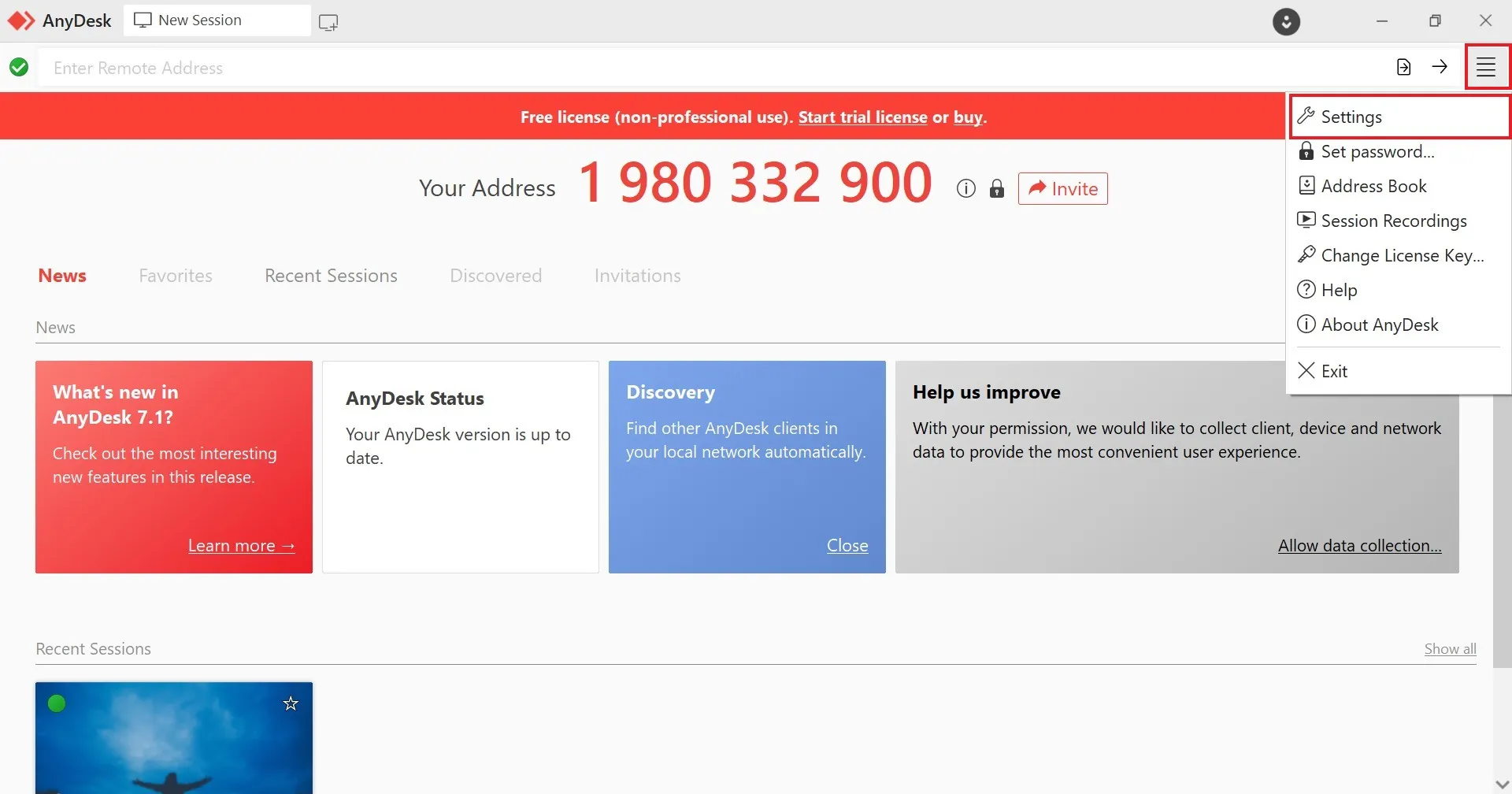

10. Обновите приложение AnyDesk.

После выполнения вышеупомянутых методов решения проблем с неработоспособностью AnyDesk попытка обновить AnyDesk до последней версии потенциально может решить проблемы совместимости с Windows 11. Чтобы обновить AnyDesk, выполните следующие действия:

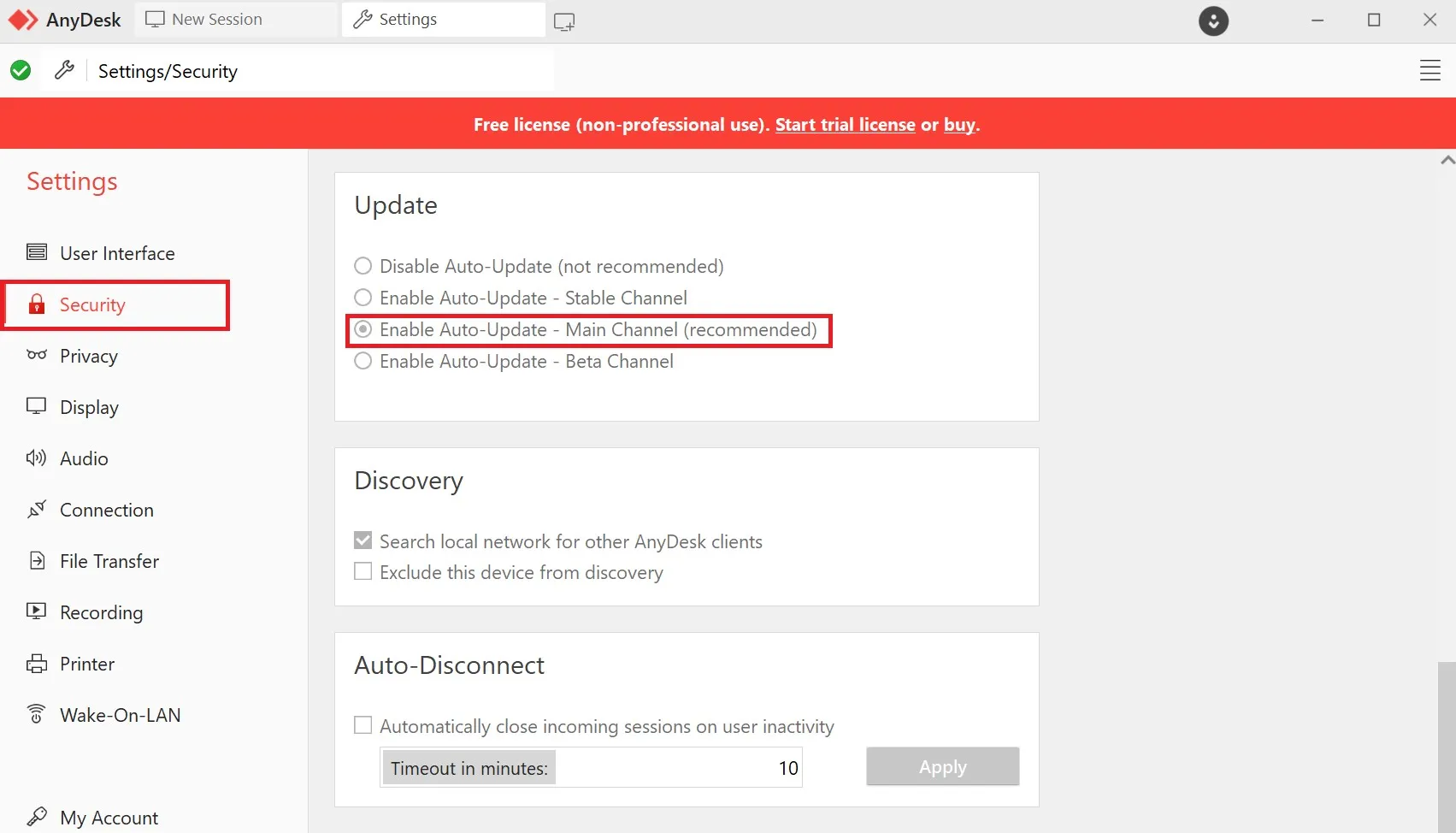

1. Откройте приложение AnyDesk, щелкните значок гамбургера в правом верхнем углу и выберите «Настройки» из списка.

2. Теперь на левой боковой панели приложения выберите «Безопасность».

3. Чтобы включить эту функцию, нажмите кнопку «Включить автоматическое обновление — основной канал» в разделе «Обновление».

Впоследствии приложение AnyDesk автоматически проверит и установит все доступные обновления в вашей системе. Это гарантирует, что вы постоянно используете самую последнюю версию приложения.

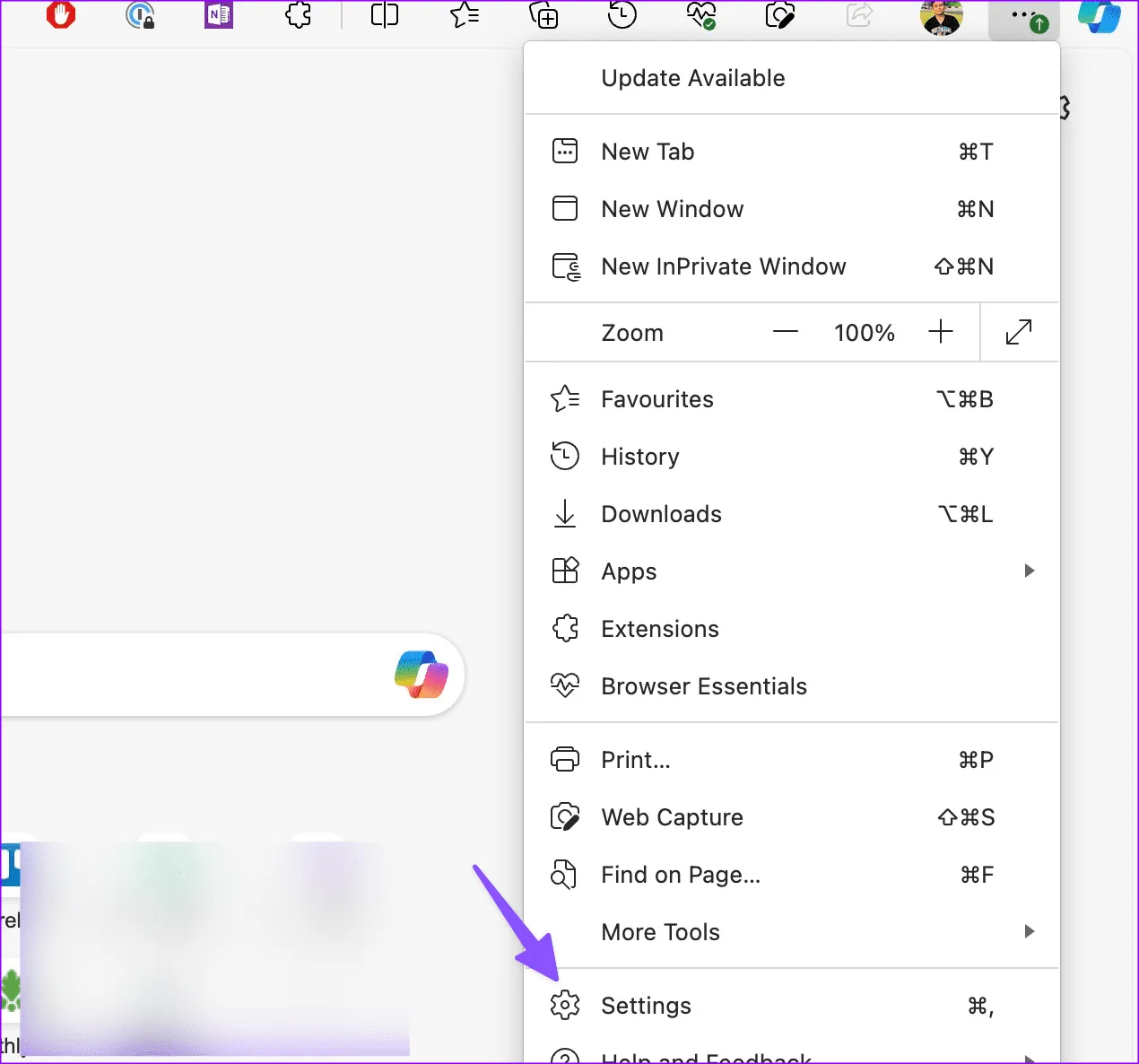

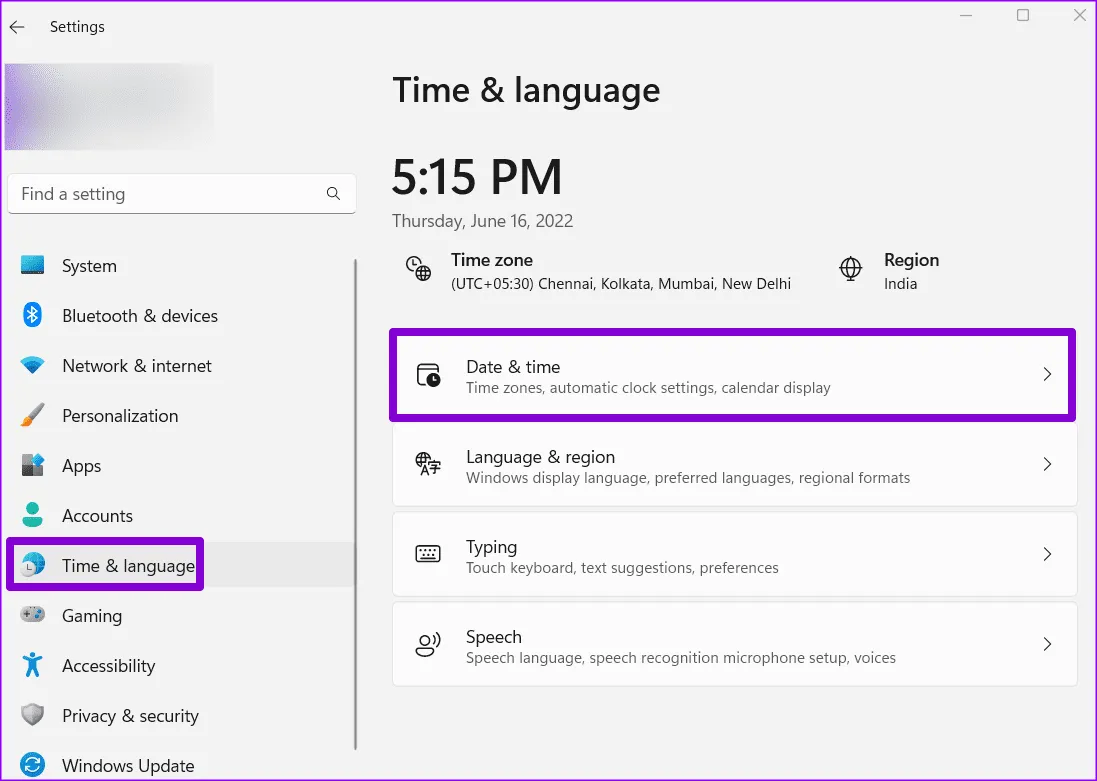

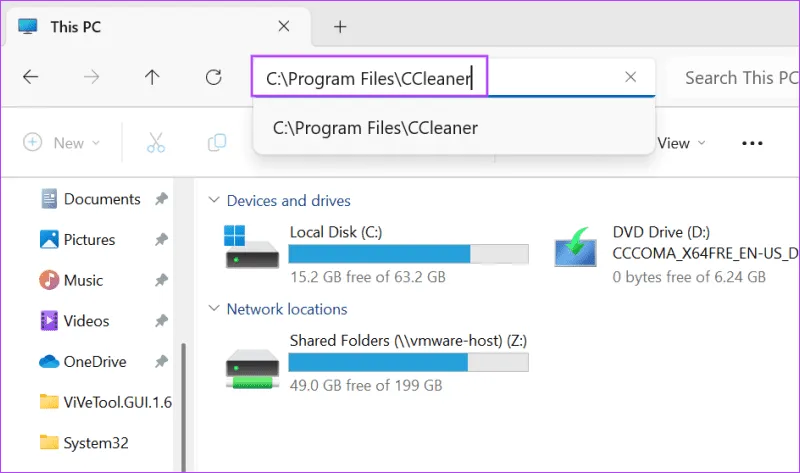

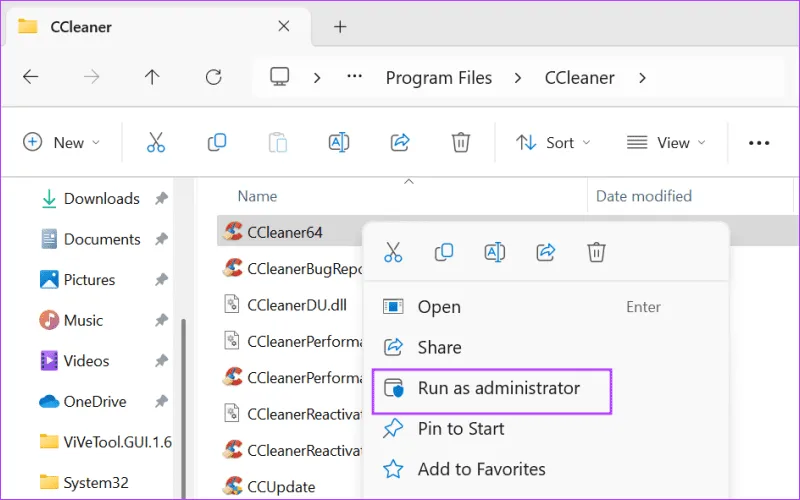

11. Переустановите AnyDesk

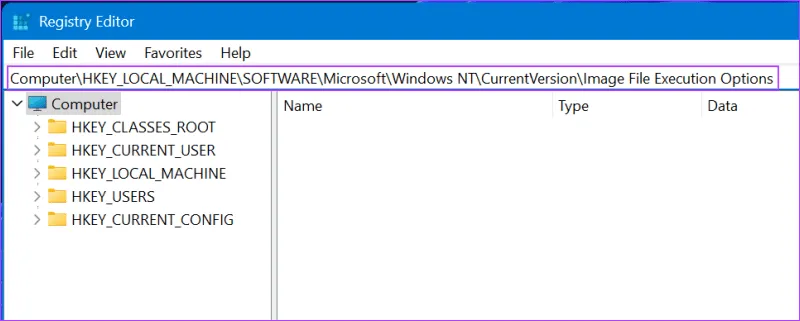

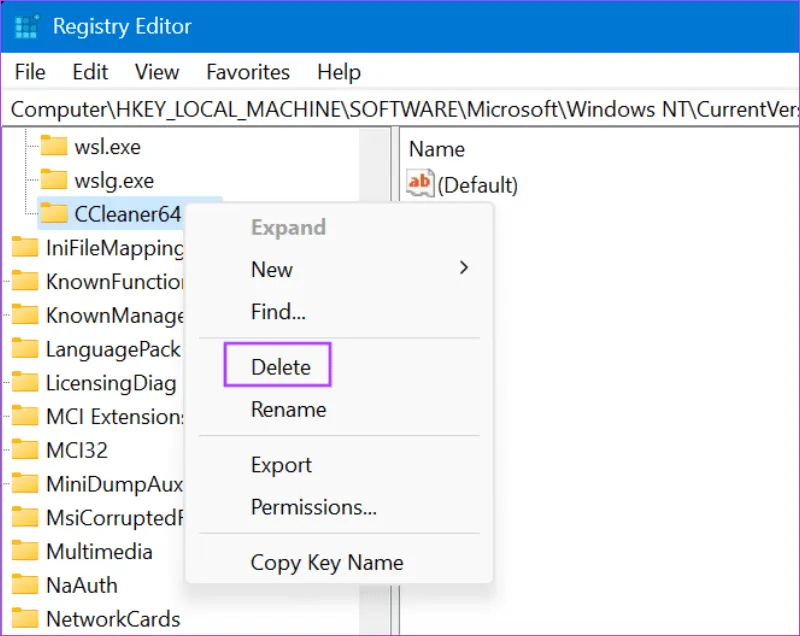

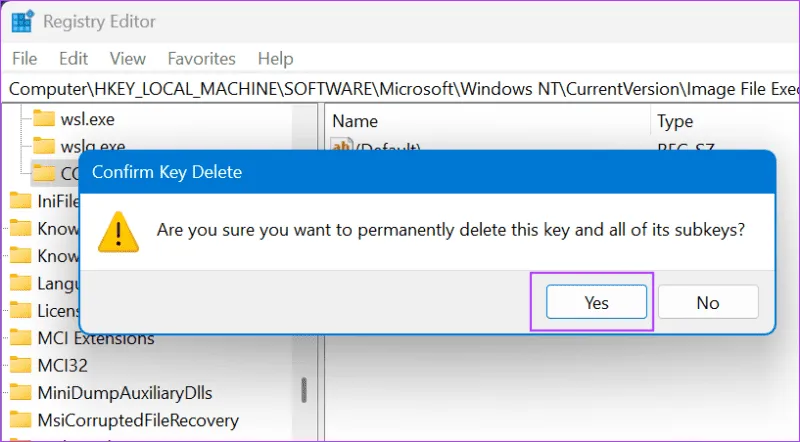

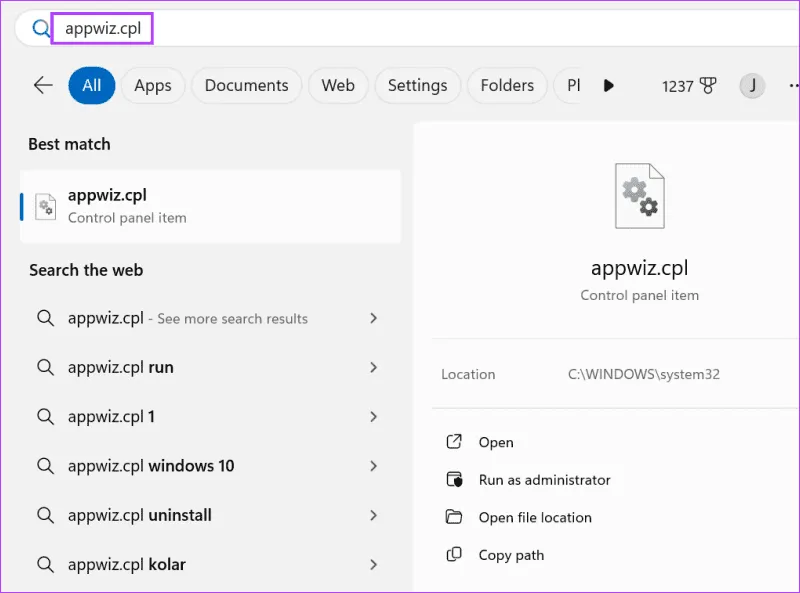

Если ни одно из приведенных выше решений не может привести к повреждению системных файлов AnyDesk. Чтобы исправить это, вы можете попытаться переустановить AnyDesk в вашей системе Windows 11.

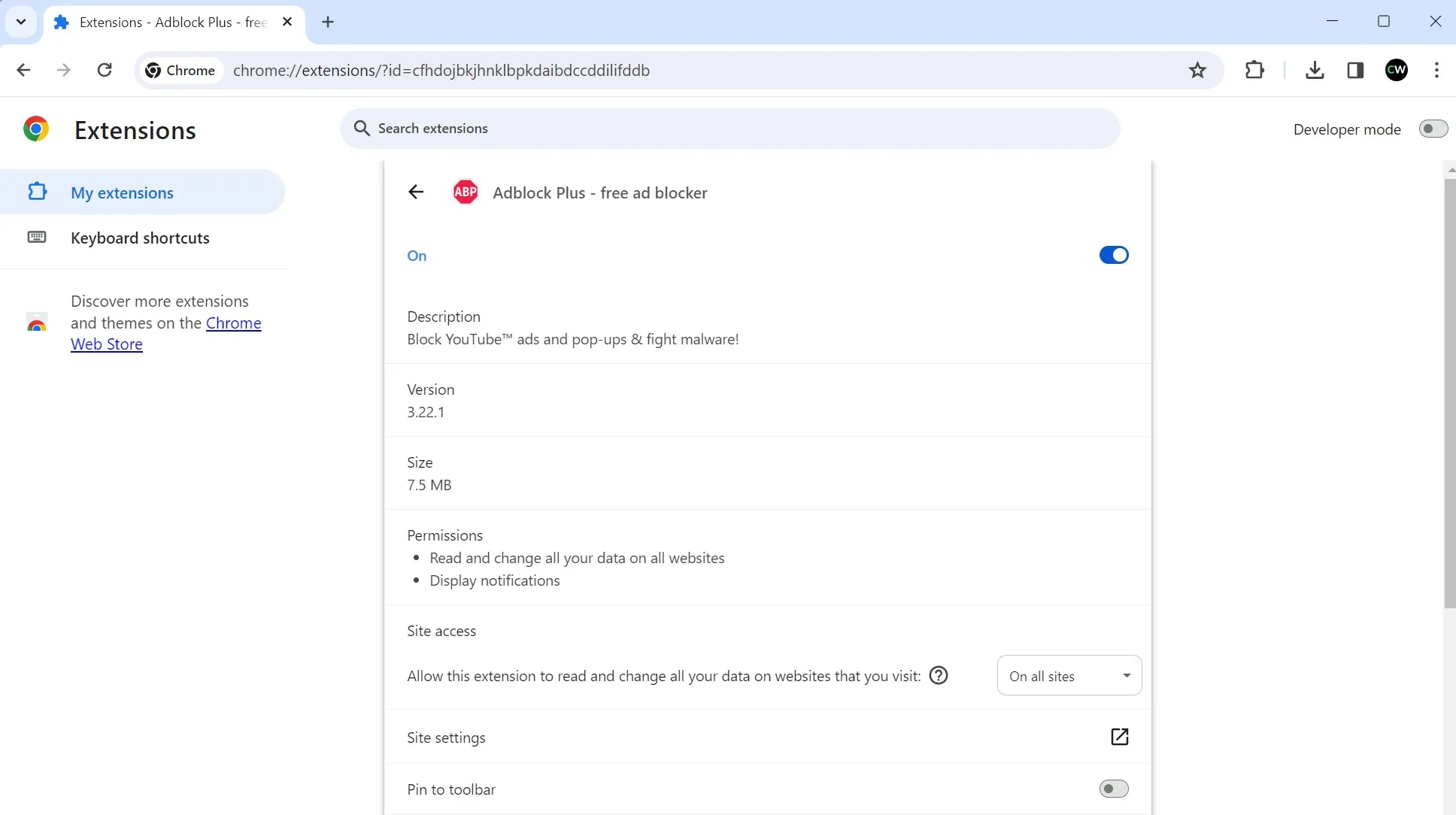

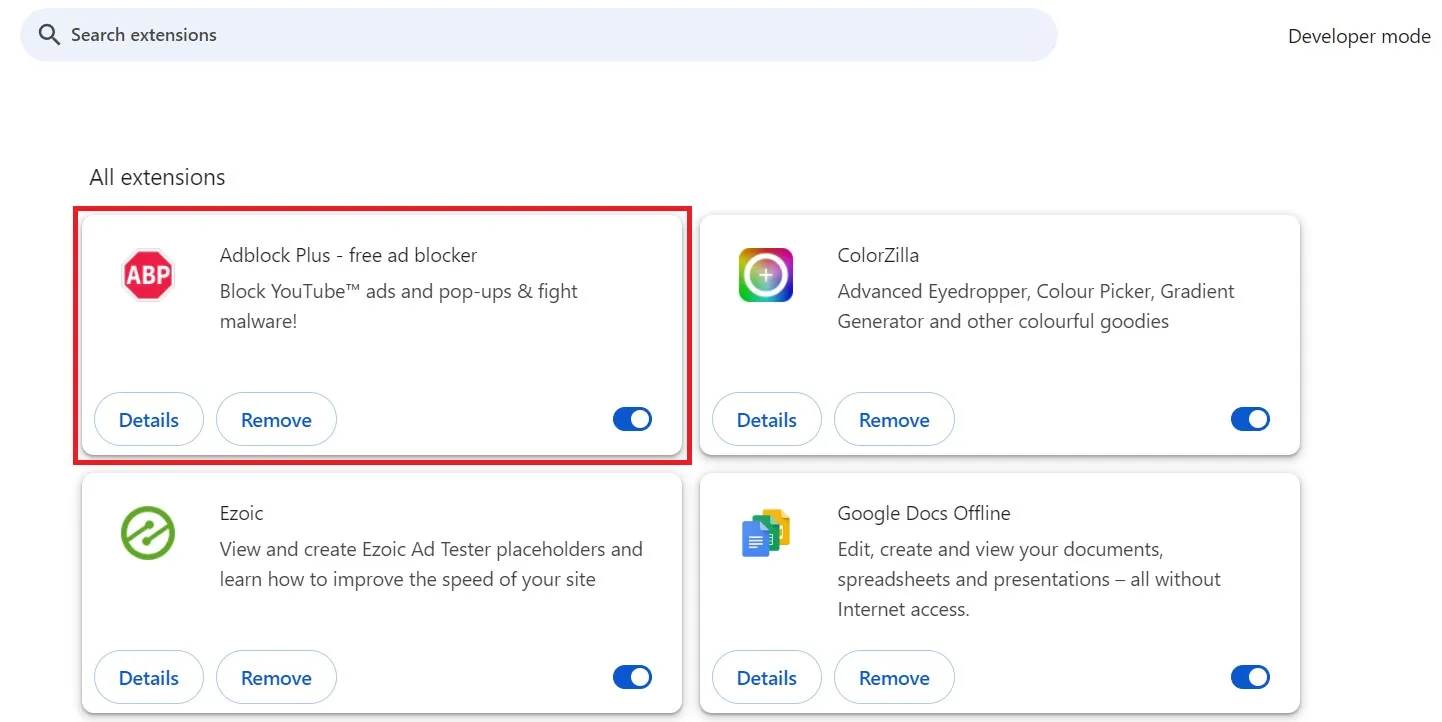

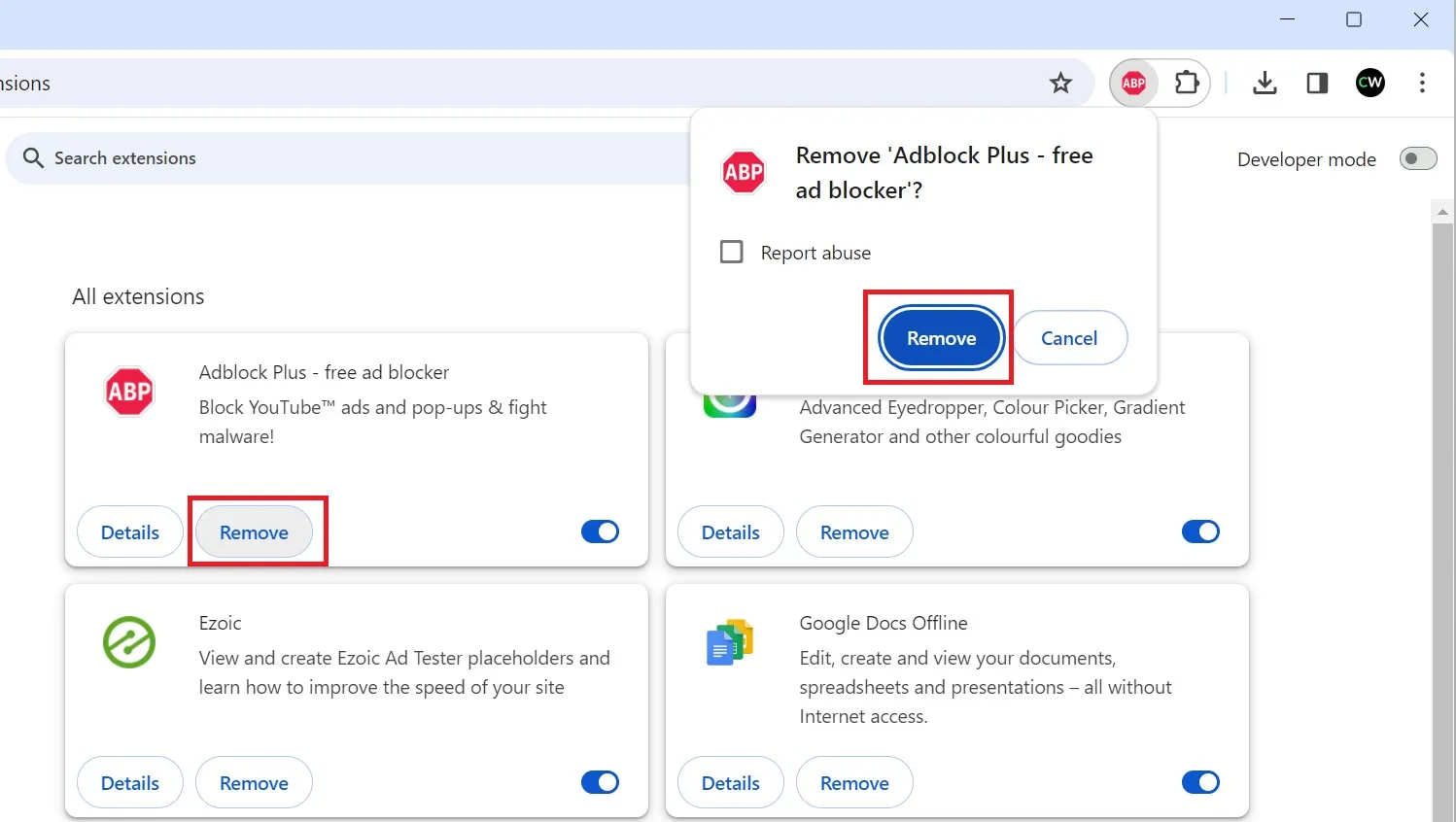

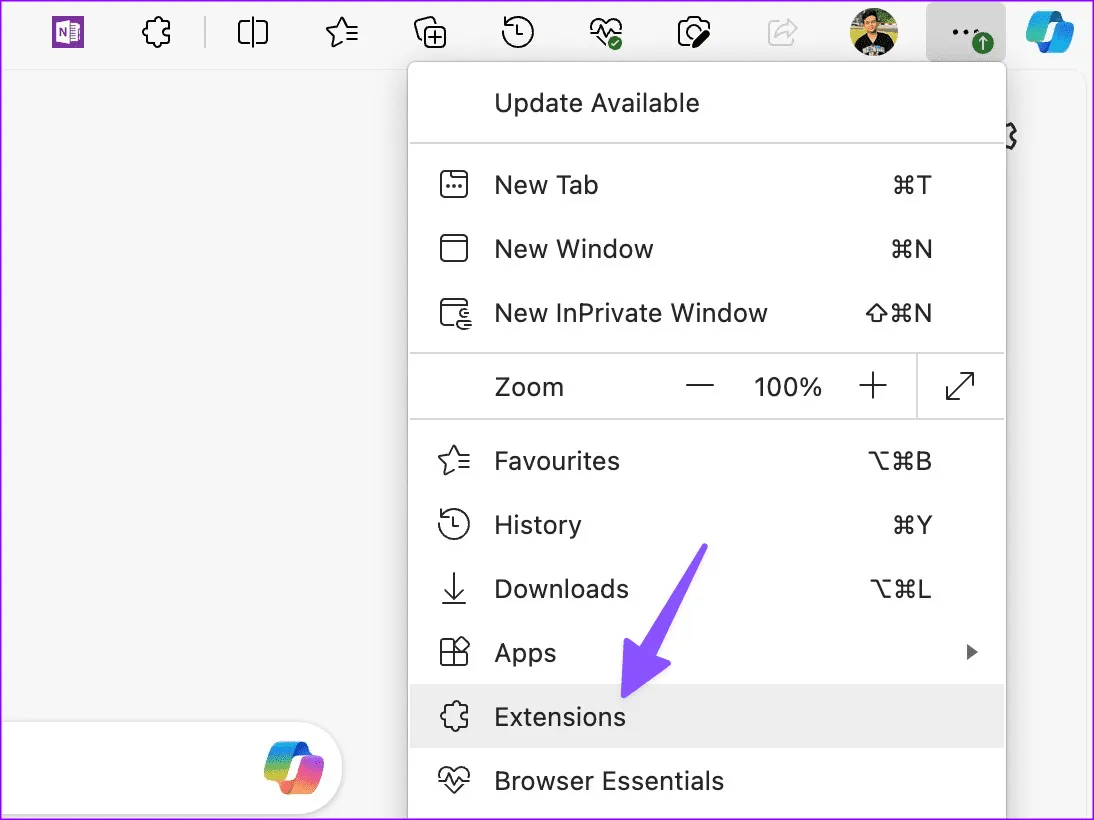

Чтобы переустановить AnyDesk, выполните следующие действия:

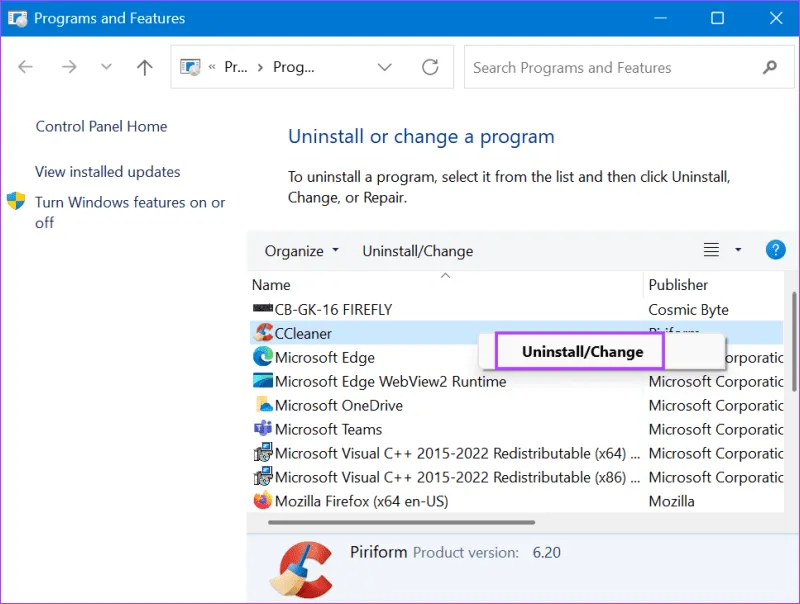

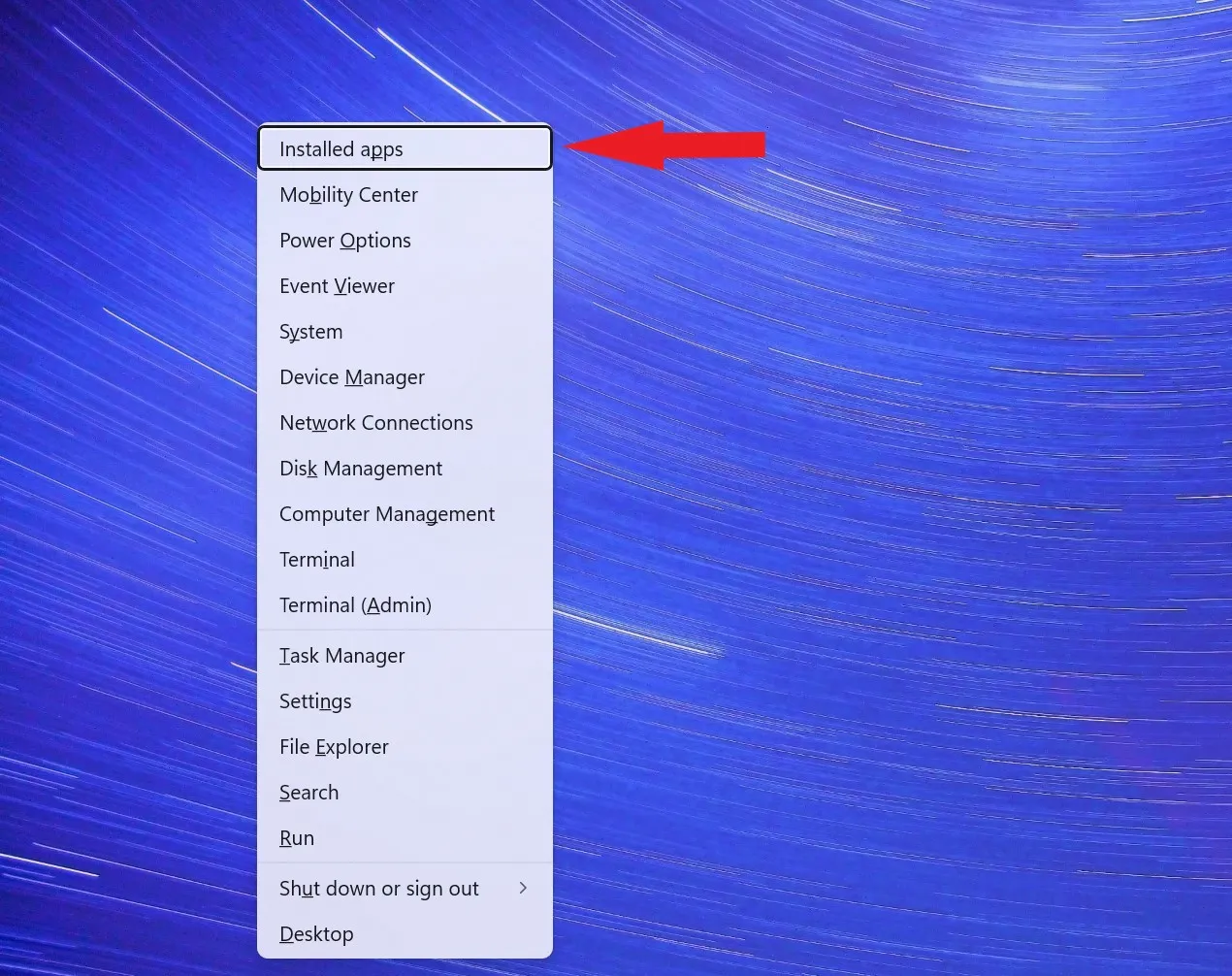

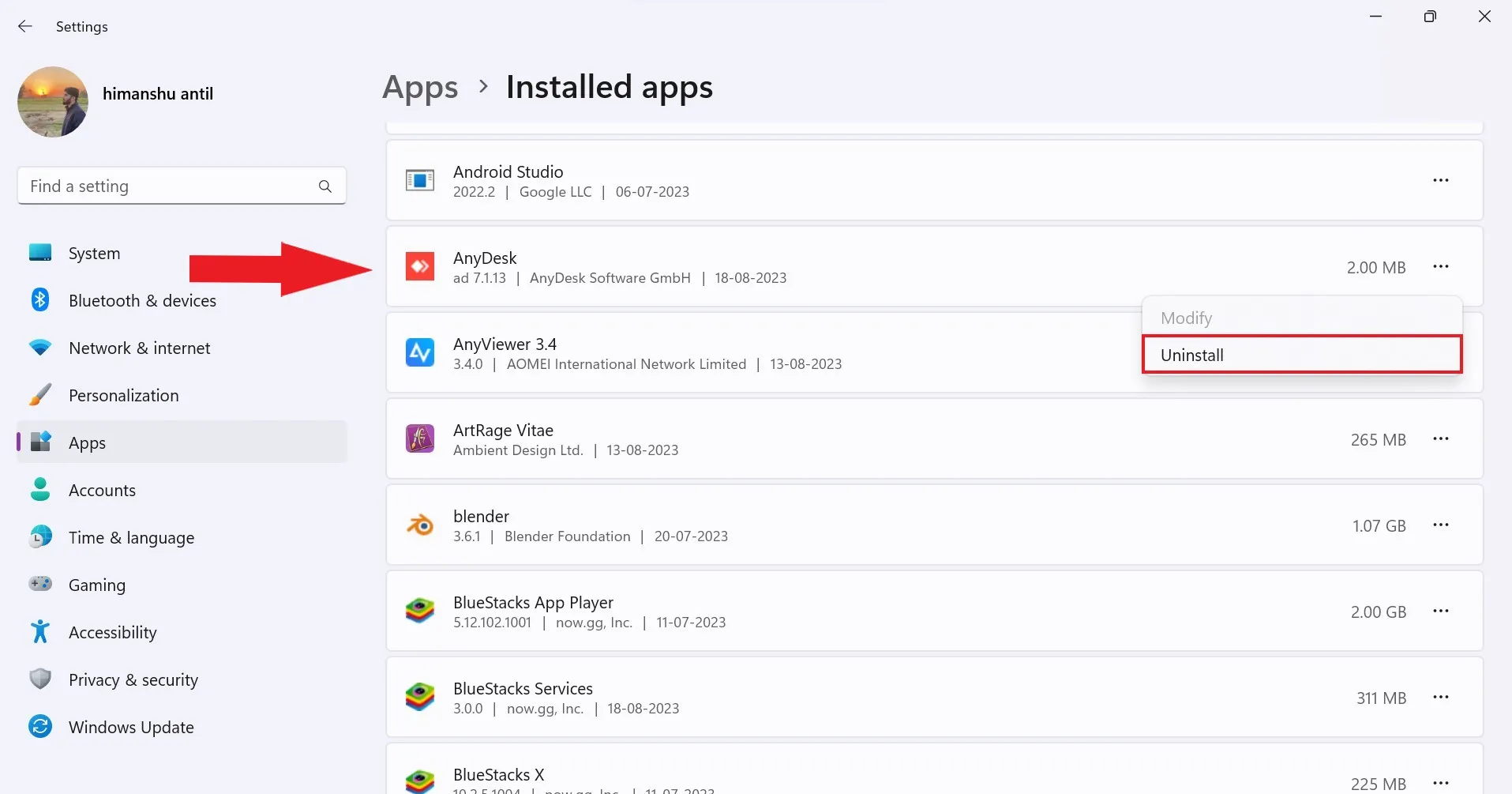

1. Нажмите Windows+X, чтобы открыть меню питания, и выберите «Установленные приложения».

2. Найдите AnyDesk в списке установленных приложений или выполните поиск через поле поиска.

3. Нажмите на трехточечный значок и выберите «Удалить» в контекстном меню. Следуйте инструкциям, чтобы полностью удалить AnyDesk.

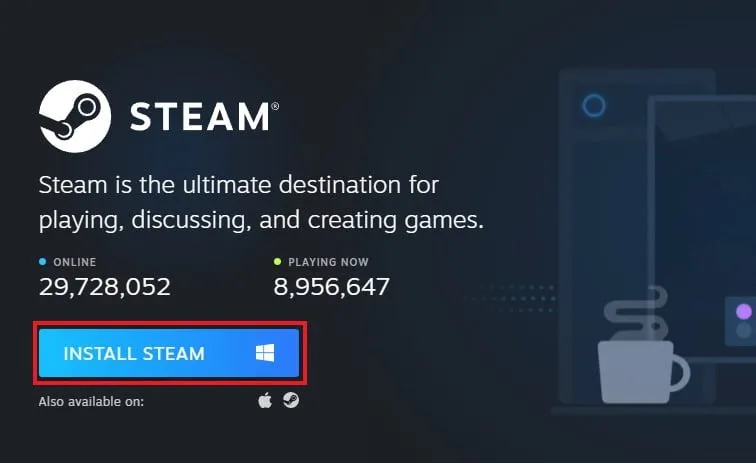

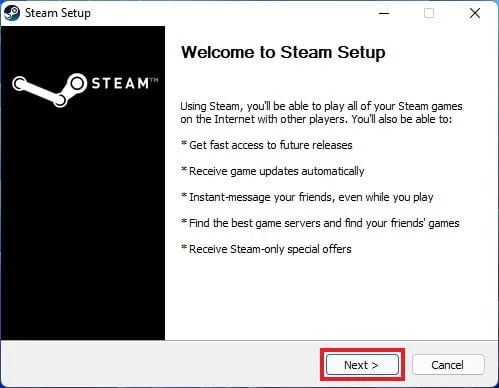

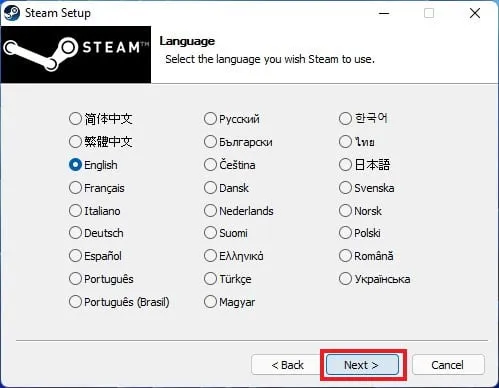

4. После успешного удаления приложения AnyDesk загрузите его с https://anydesk.com и переустановите.

Заключение

AnyDesk, не работающий в Windows 11, может расстраивать, но с помощью решений, изложенных в этом руководстве, вы сможете решить проблему и вернуться к использованию AnyDesk для удаленного доступа к рабочему столу.

Не забудьте попробовать каждое решение по одному и проверить, работает ли AnyDesk после каждого шага. Если проблема не устранена, возможно, стоит обратиться в службу поддержки AnyDesk за дальнейшей помощью.