Инструменты искусственного интеллекта стали довольно распространенными, и Copilot от Microsoft является одним из самых популярных, доступных на данный момент. Copilot, основанный на GPT-4, языковой модели, разработанной OpenAI, можно использовать для написания кода, создания контента и быстрого и легкого поиска в Интернете.

Кроме того, Microsoft также выпустила несколько пользовательских GPT, которые представляют собой адаптированные версии Copilot, адаптированные для конкретной цели. Так что же такое GPT Copilot и как их использовать? Давай выясним.

Что такое GPT второго пилота

Microsoft разработала несколько пользовательских GPT Copilot для конкретных целей, которые были настроены для решения только специальной задачи, а не широкого спектра задач, которые может выполнять Copilot.

В настоящее время в дополнение к Copilot доступны четыре GPT, которые могут помочь вам создавать изображения из текста, планировать отпуск, изучать кулинарию и заниматься фитнесом. Обратите внимание: когда вы спрашиваете GPT о чем-то, выходящем за рамки его компетенции, он, хотя и может ответить, в большинстве случаев отказывается, сославшись на то, что не входит в его область компетенции. Итак, вы хотите использовать GPT только тогда, когда вам нужна помощь в решении конкретной проблемы, например, при планировании отпуска. В остальное время лучше использовать Copilot.

GPT Copilot не зависят от браузера, и вы можете получить к ним доступ из любого браузера, включая Google Chrome, Mozilla Firefox и Microsoft Edge. Но GPT в настоящее время доступны только в веб-приложении Copilot; вы пока не можете получить к ним доступ на боковой панели Edge или через Windows 11 Copilot, в отличие от плагинов.

Хотя доступ к ним можно получить бесплатно, Microsoft также выпустила собственный GPT Builder, который поможет вам создать любой собственный GPT для конкретной задачи или темы, представляющей для вас особый интерес. Это инструмент, который позволяет вам создавать собственные модели ИИ, используя естественный язык, без какого-либо опыта или знаний в области кодирования. Его можно использовать для разработки ИИ-помощников, чат-ботов, игр и многого другого.

Однако вам понадобится подписка Copilot Pro, чтобы использовать конструктор Copilot GPT для разработки пользовательских моделей искусственного интеллекта. Эта подписка также открывает расширенные функциональные возможности и возможности Copilot.

Если у вас есть подписка Copilot Pro, вы можете использовать браузер Edge на платформах Windows или Mac OS для создания собственных моделей искусственного интеллекта, не изучая программирование. А если вы являетесь бесплатным пользователем, вот как вы можете попробовать некоторые пользовательские GPT Copilot от Microsoft, не тратя ни копейки.

Использование GPT Copilot

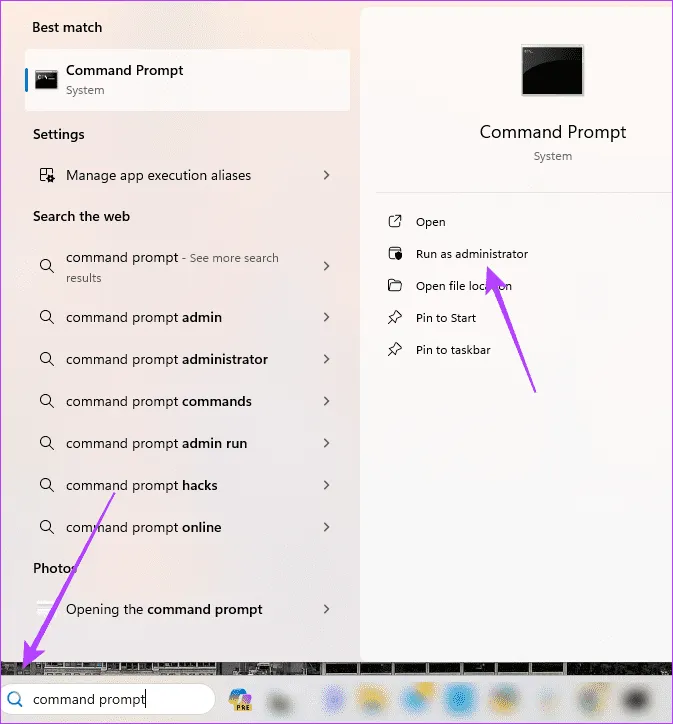

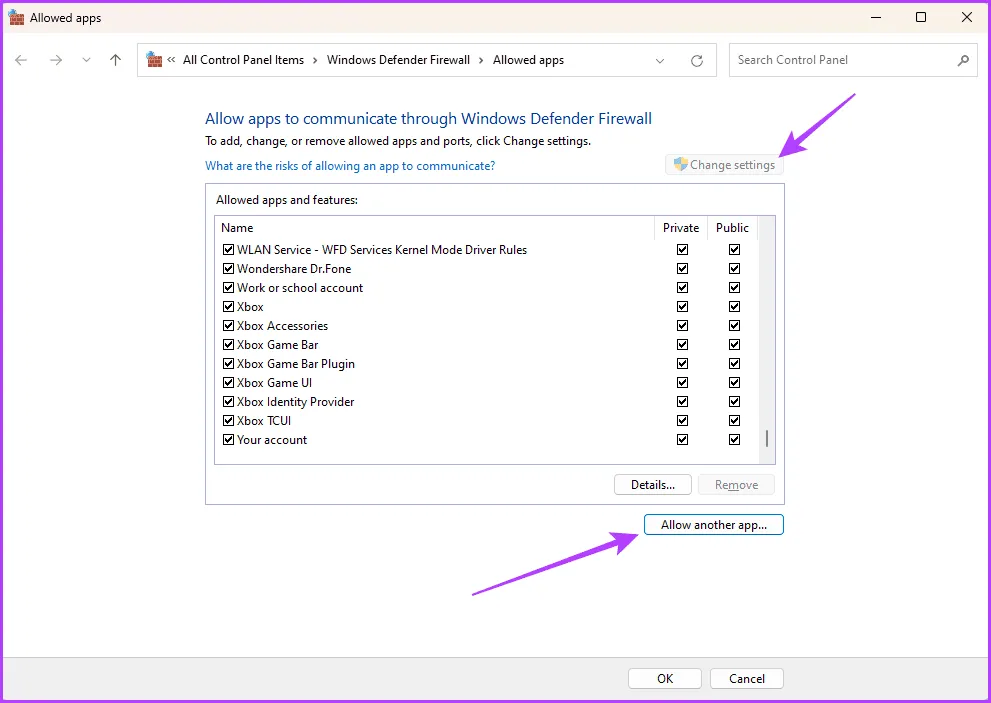

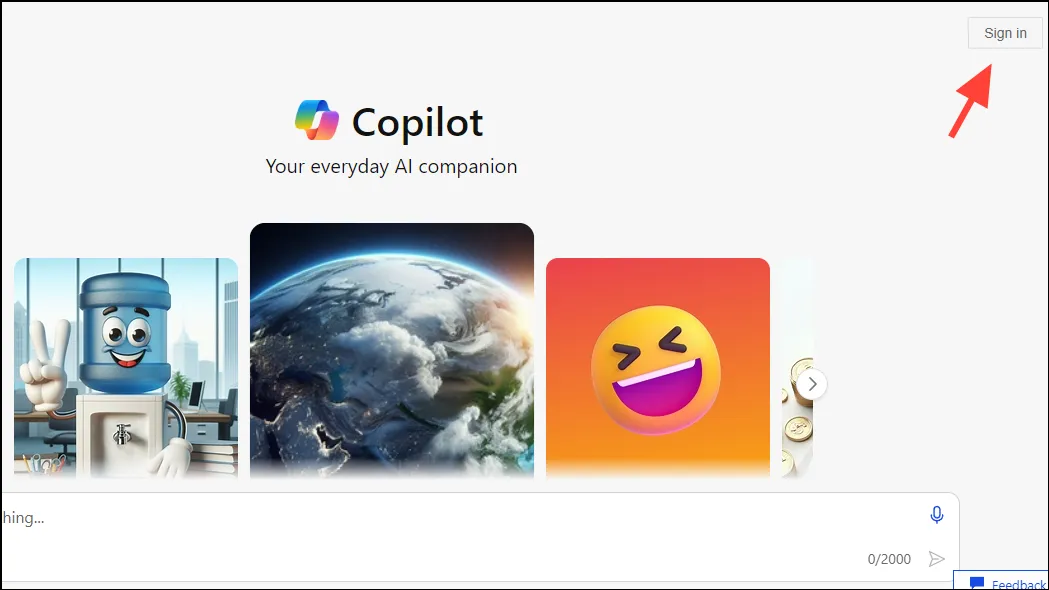

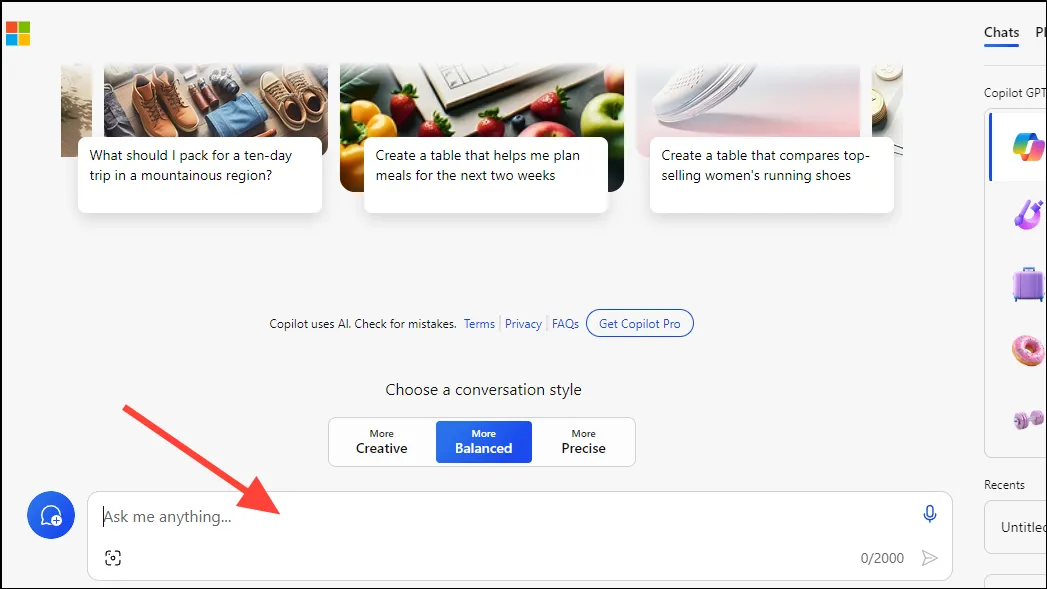

Чтобы начать использовать GPT Copilot, откройте браузер и посетите copilot.microsoft.com. Оказавшись там, войдите в свою учетную запись Microsoft, используя кнопку «Войти» в правом верхнем углу страницы.

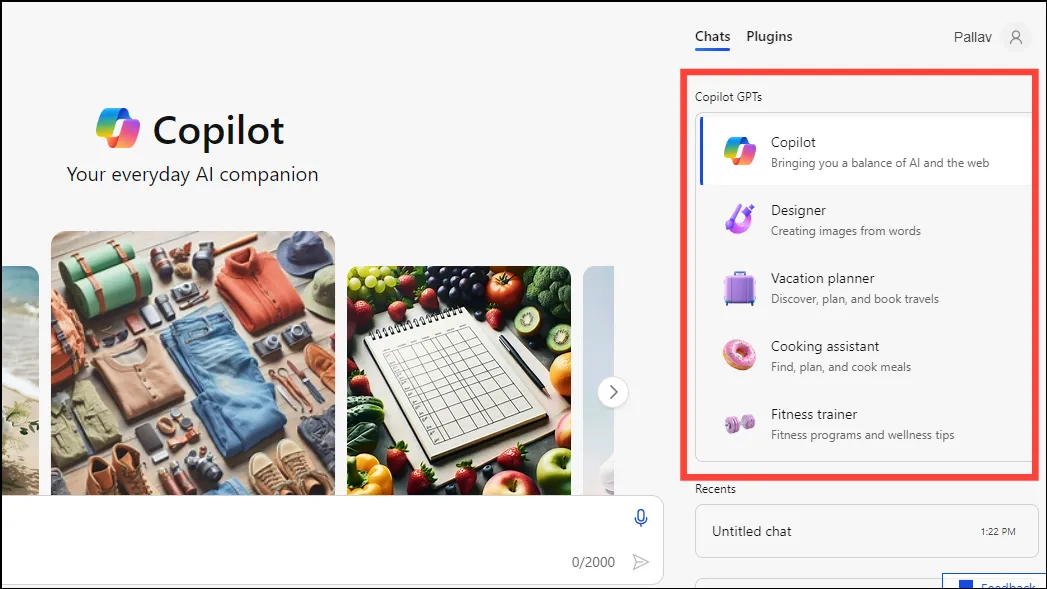

После входа в систему вы сможете увидеть GPT Copilot, которые вы можете использовать. В настоящее время доступно пять вариантов, в том числе «Второй пилот», «Дизайнер», «Планировщик отпуска», «Помощник по кулинарии» и «Фитнес-тренер».

Вы можете выбрать Copilot GPT, который хотите использовать, на панели справа и ввести подсказку в поле поиска внизу. Тип требуемого ответа также можно настроить, выбрав «Креативный», «Сбалансированный» и «Точный».

Теперь давайте посмотрим на различные GPT Copilot в действии.

Второй пилот:

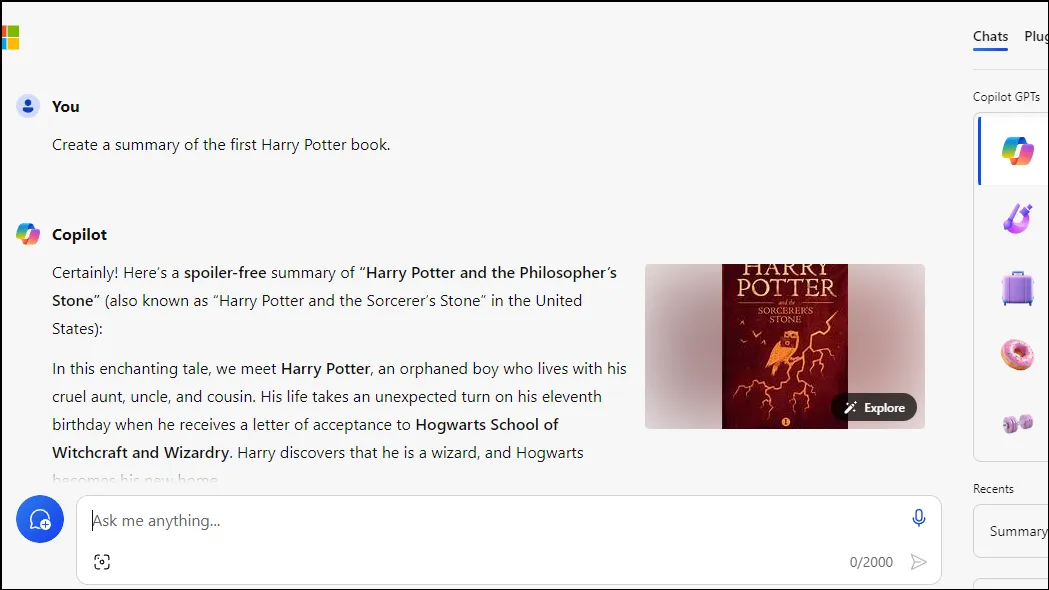

По умолчанию будет выбран первый вариант Copilot. Вы можете ввести подсказку в поле поиска внизу, поставить лайк Create a summary of the first Harry Potter book и нажать клавишу «Ввод», чтобы получить результаты.

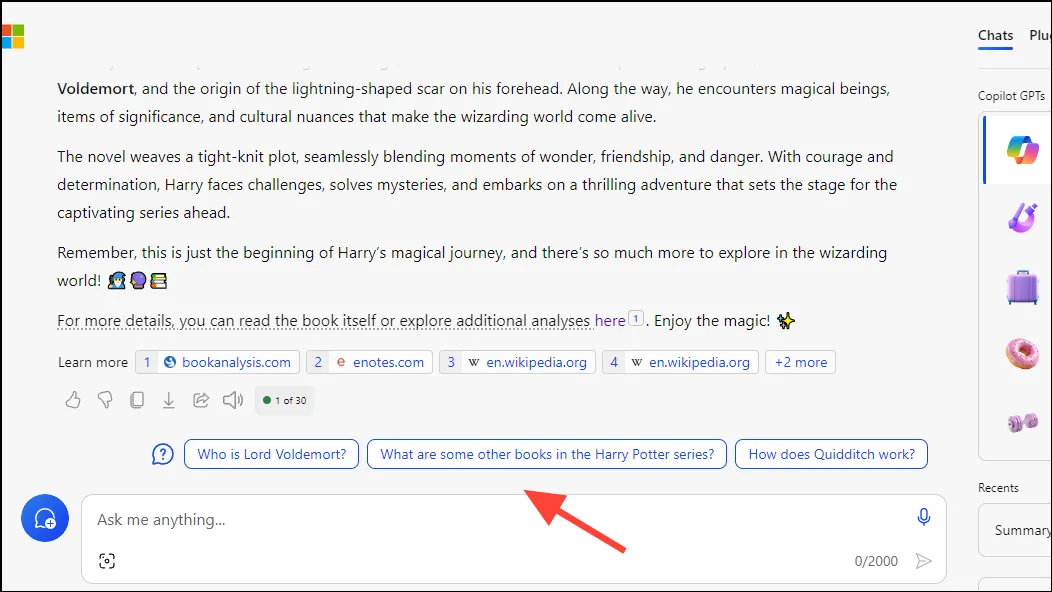

Как упоминалось выше, предоставленный ответ будет зависеть от выбранного вами стиля разговора. Copilot также предоставляет предложения и ссылки, которые вы можете использовать для получения дополнительной информации по этой теме.

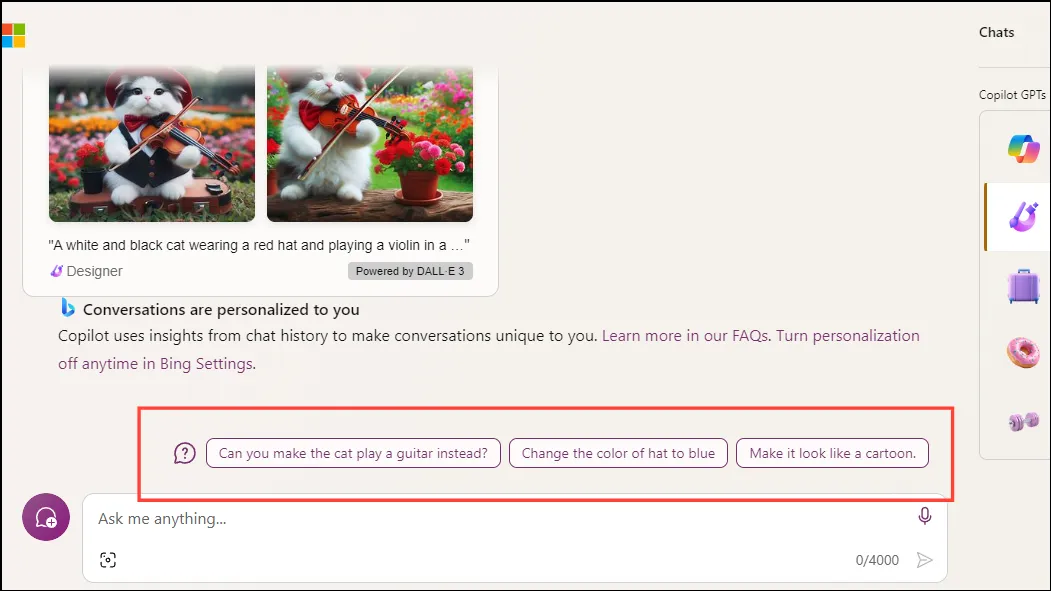

Дизайнер:

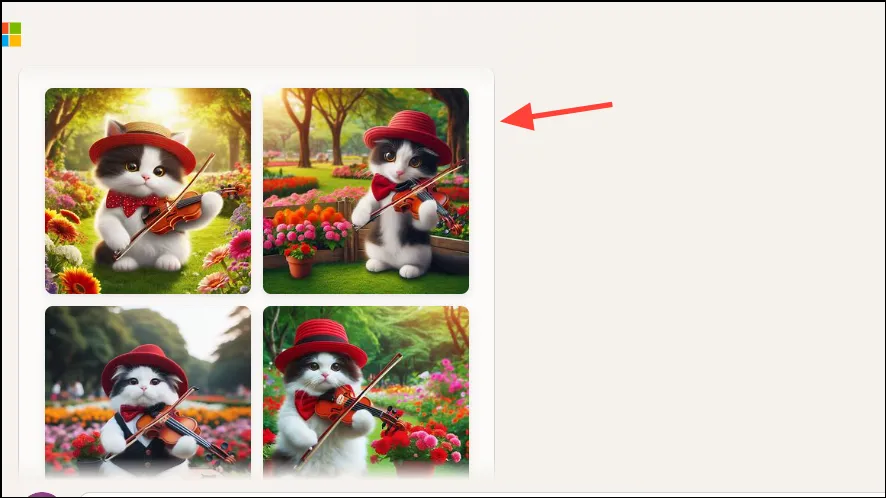

Конструктор можно использовать для создания изображений с помощью текстовых подсказок. Введите подсказку, например, A black and white cat wearing a red hat and playing a violin и нажмите клавишу «Ввод».

Designer Copilot предоставит на выбор четыре варианта изображения.

В этом случае под изображением также появятся предложения, позволяющие отредактировать его по мере необходимости.

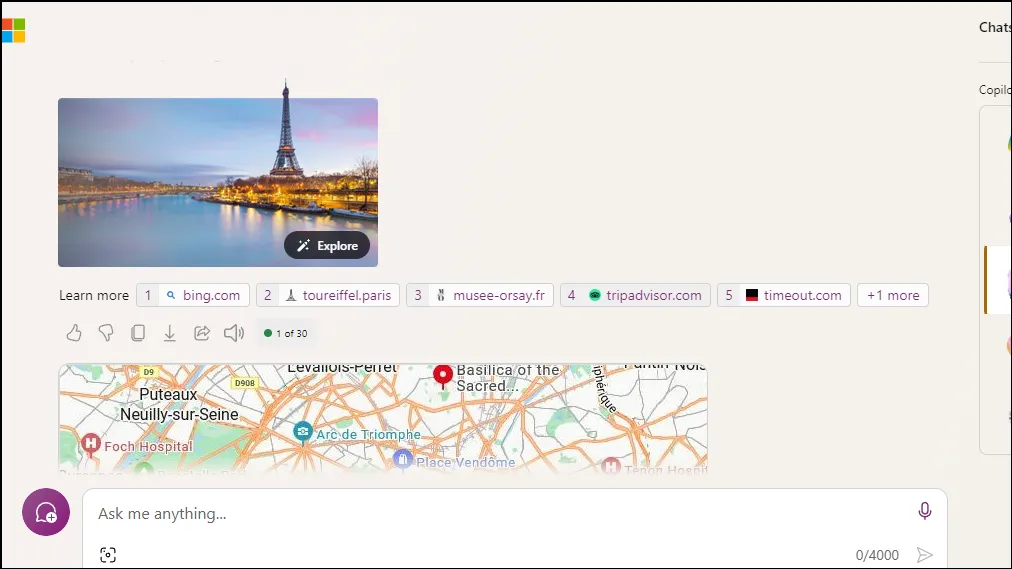

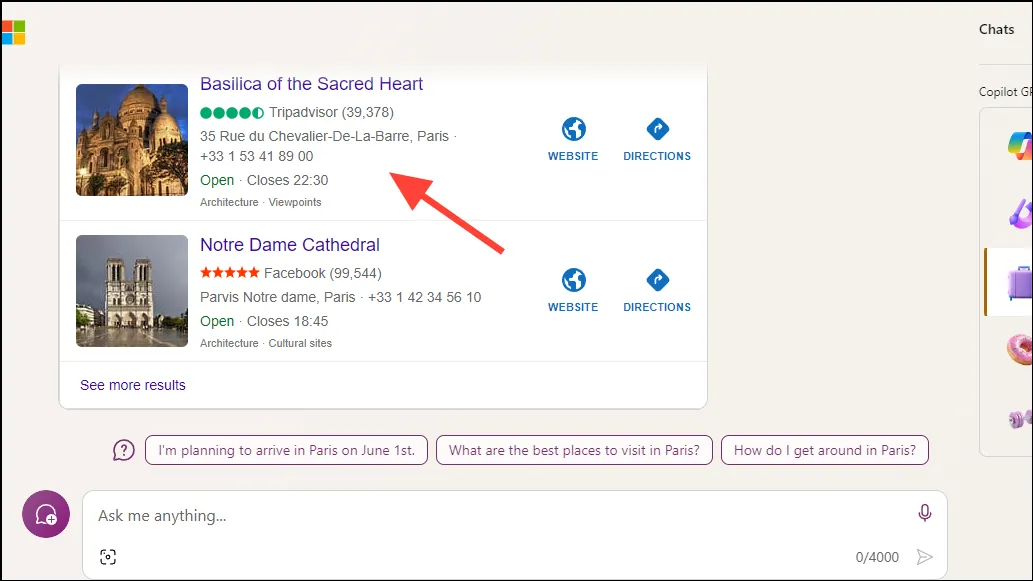

Планировщик отпуска:

Планировщик отпуска может значительно упростить планирование поездки. Вы можете дать ему подсказку, например Create a vacation plan for visiting Paris, и дождаться, пока он предоставит подробный маршрут.

Помимо отображения подробной карты пункта назначения, Travel Planner Copilot может предоставить список известных достопримечательностей, которые стоит посетить. Вы можете нажать на ссылки, чтобы получить дополнительную информацию о местах.

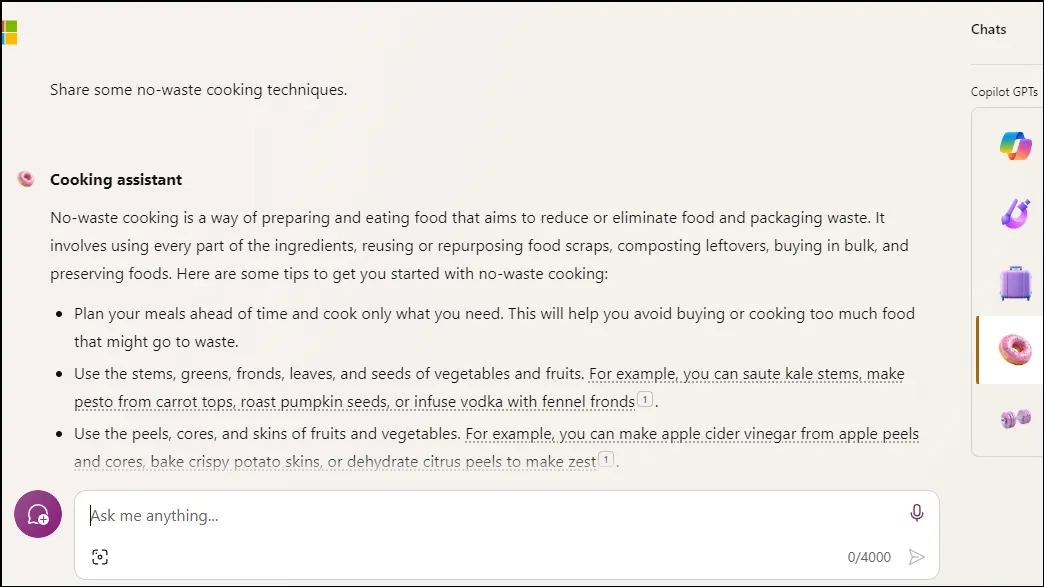

Помощник по кулинарии:

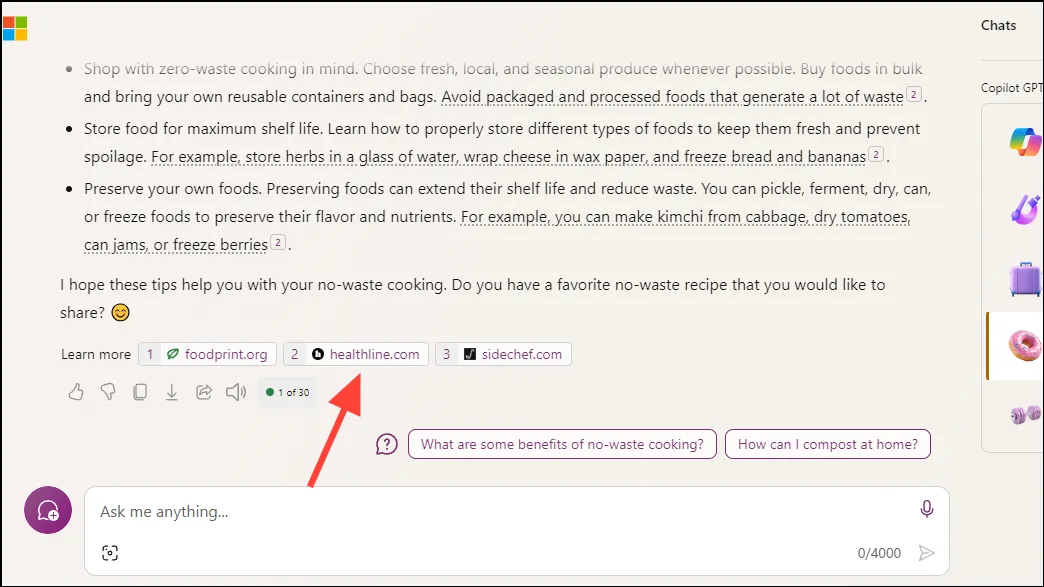

Далее идет Cooking Assistant Copilot, который может быстро предоставить вам рецепты и советы по приготовлению. Просто дайте ему подсказку, например Share some no-waste cooking techniques. Как только вы нажмете клавишу «Ввод», появится необходимая информация.

Поскольку Cooking Assistant получает информацию с различных веб-сайтов, он делится ссылками на источники под сгенерированными результатами. Вы можете нажать на них, чтобы напрямую перейти к источнику.

Тренер по фитнесу:

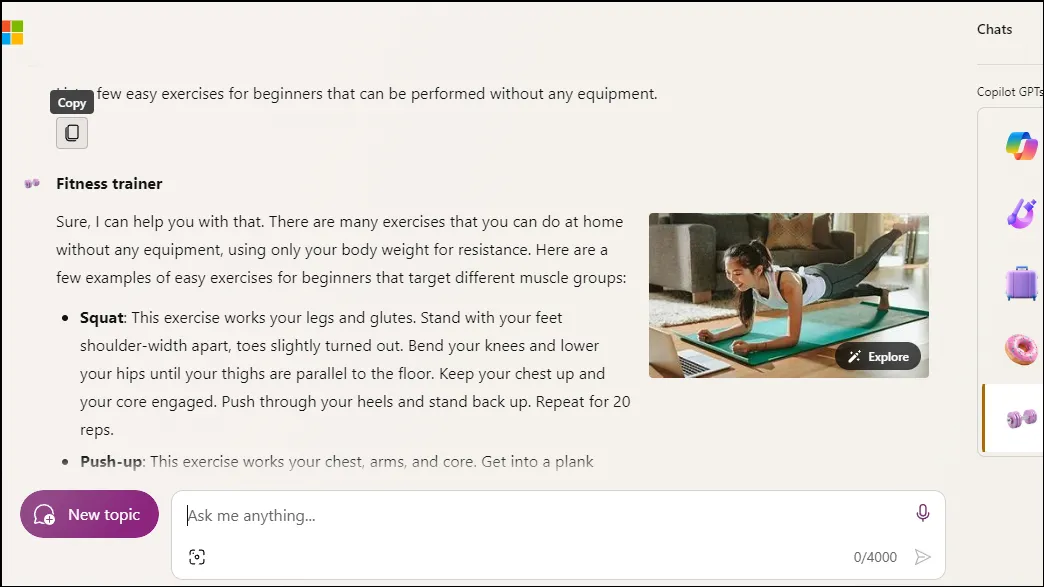

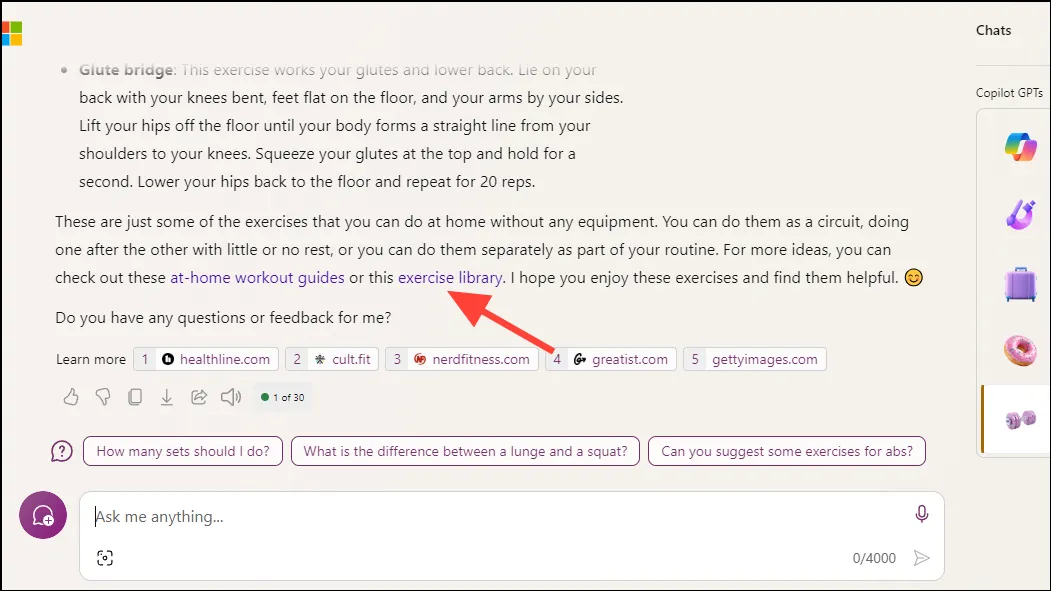

Fitness Trainer Copilot может помочь в поддержании хорошего здоровья. Вы можете использовать его, чтобы выучить новые упражнения или получить советы по тренировкам. Чтобы использовать его, введите приглашение, например List a few easy exercises for beginners that can be performed without any equipment.

Ответы, предоставленные этим вторым пилотом, могут содержать ссылки на другие полезные ресурсы в Интернете. Нажав на них, вы перейдете на веб-сайты, где сможете найти дополнительные руководства по тренировкам, стратегии диеты и соответствующую информацию.

Эти методы помогут вам использовать различные GPT Copilot, предлагаемые в настоящее время Microsoft. Помимо вашей личной учетной записи, Microsoft разрешает использовать их через рабочие учетные записи, поэтому их можно использовать как для отдыха, так и для профессиональных целей.

Copilot GPT, предлагаемые Microsoft, могут изменить способы, которыми пользователи создают контент, потребляют информацию и расширяют свои знания и навыки. С помощью этого руководства вы сможете легко начать их использовать, чтобы повысить свою эффективность и сэкономить время и усилия при выполнении различных задач.