Программное обеспечение для восстановления данных — одно из обязательных приложений на вашем ПК или ноутбуке. На вашем устройстве хранится много важных данных, которые будут использоваться сейчас или позже. Но иногда эти файлы могут быть случайно потеряны. Вы можете удалить их по ошибке, или они могут быть удалены автоматически из-за вирусной атаки, форматирования жесткого диска или сбоя системы.

Здесь вы можете почувствовать необходимость в программном обеспечении для восстановления данных, чтобы восстановить потерянные файлы. Сегодня мы познакомим вас с 8 лучшими программами для восстановления данных для операционной системы Windows.

В этом разделе мы обсудим лучшее программное обеспечение для восстановления данных для операционной системы Windows, которое поможет вам восстановить удаленные данные с любого внешнего/внутреннего диска. Итак, начнем:

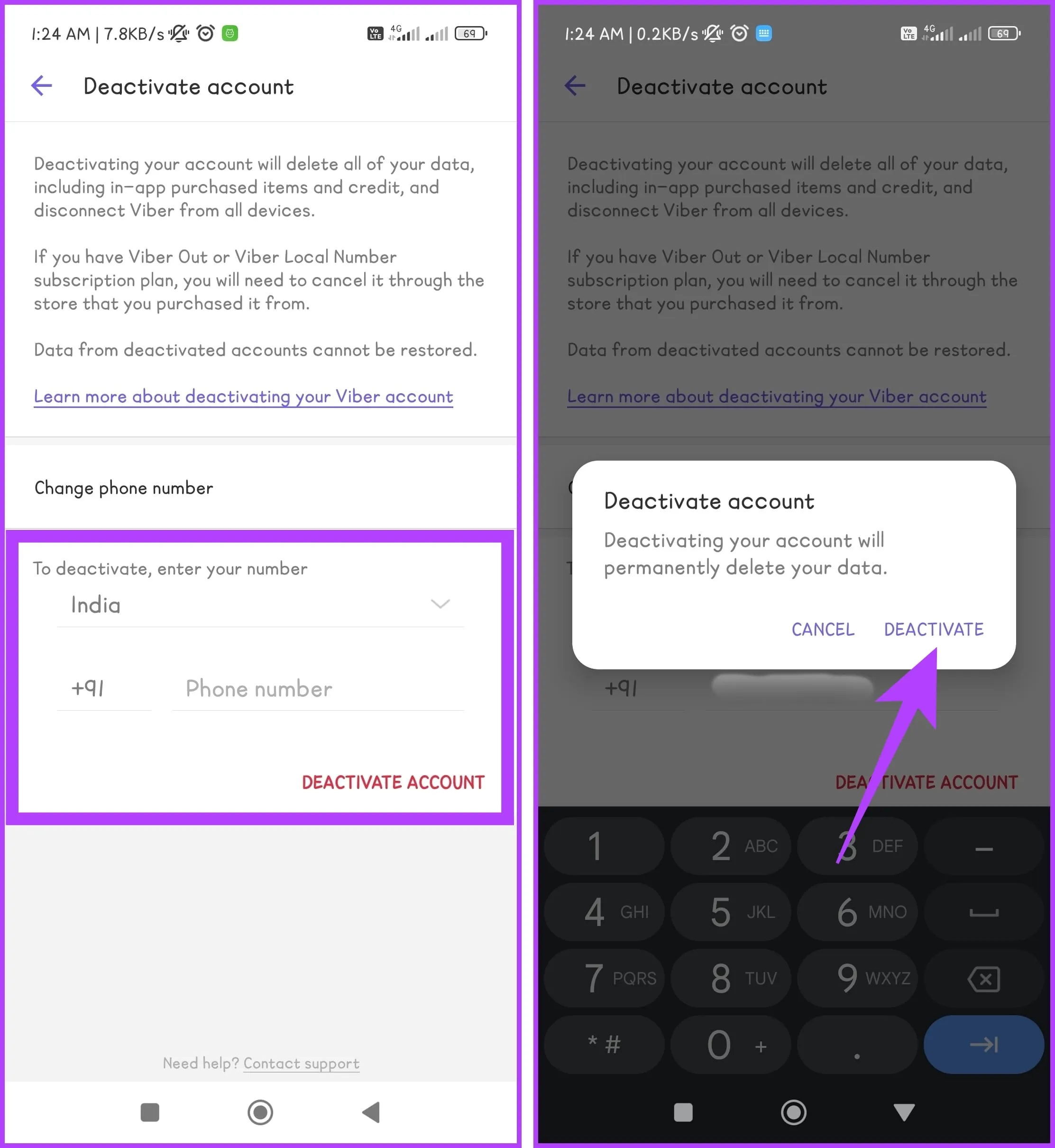

1. Восстановление файлов ReclaiMe

ReclaiMe File Recovery – очень простое, но мощное программное обеспечение для восстановления данных. Он может восстанавливать данные из всех файловых систем Windows — FAT, exFAT, NTFS и ReFS. Кроме того, он работает с файловыми системами Linux и MacOS. Программа ReclaiMe File Recovery справляется со всеми случаями потери данных, легко восстанавливает данные после случайного удаления, ошибочного форматирования, сбоя файловой системы, при различных логических ошибках и так далее.

О ReclaiMe очень много положительных отзывов на проверенных сайтах и очень часто пользователи описывают ReclaiMe как единственный инструмент, который помог восстановить данные. Отличительной и очень важной особенностью ReclaiMe является лицензионная политика.

Лицензионный ключ является бессрочным и может использоваться на всех ваших компьютерах. То есть, купив один раз лицензионный ключ, вы сможете пользоваться им всю жизнь! В ReclaiMe доступны все необходимые функции – возможность оценить результат перед покупкой с помощью предварительного просмотра, функция расширенного поиска, а также восстановление файлов и папок в исходной структуре. ReclaiMe File Recovery — отличный выбор в 2023 году.

Скачать ReclaiMe File Recovery

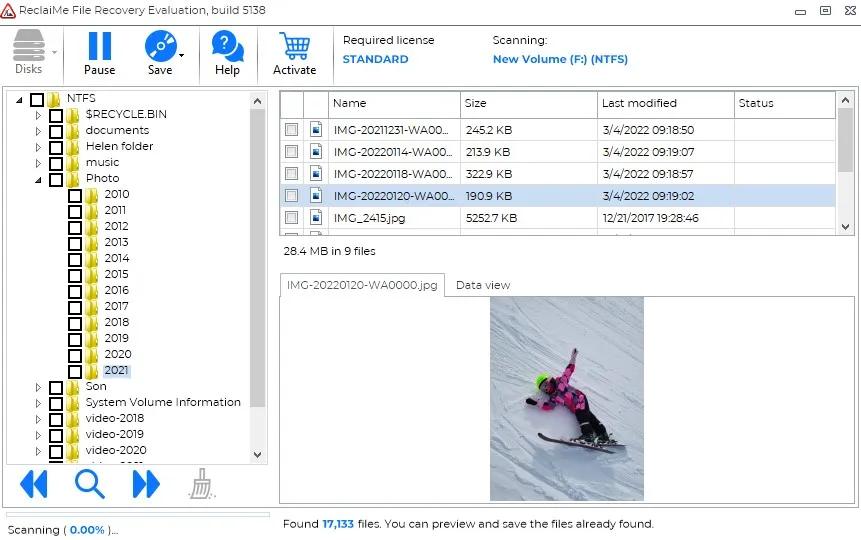

2. Recoverit

Recoverit — это недорогое программное обеспечение для восстановления данных, которое безупречно работает во многих хранилищах. Если вы хотите восстановить данные с жестких дисков видеокамер или карт памяти, Wondershare Recoverit может стать для вас универсальным решением.

Приложение охватывает комплексные аудиоформаты, позволяющие восстанавливать данные из всех видов изображений, документов, видео, аудио и других файлов. Вы можете ожидать, что это приложение будет работать в любой версии Windows без каких-либо проблем. Одна из постоянных особенностей этого приложения, которую вы можете не увидеть в других программах восстановления, заключается в том, что вы можете приостановить сканирование в любой момент и возобновить его, когда захотите.

Процесс восстановления данных очень прост. Вам нужно выполнить всего три шага: выбрать, отсканировать и восстановить. Этот эффективный сервис под прикрытием простоты сделал его самым популярным программным обеспечением для восстановления данных.

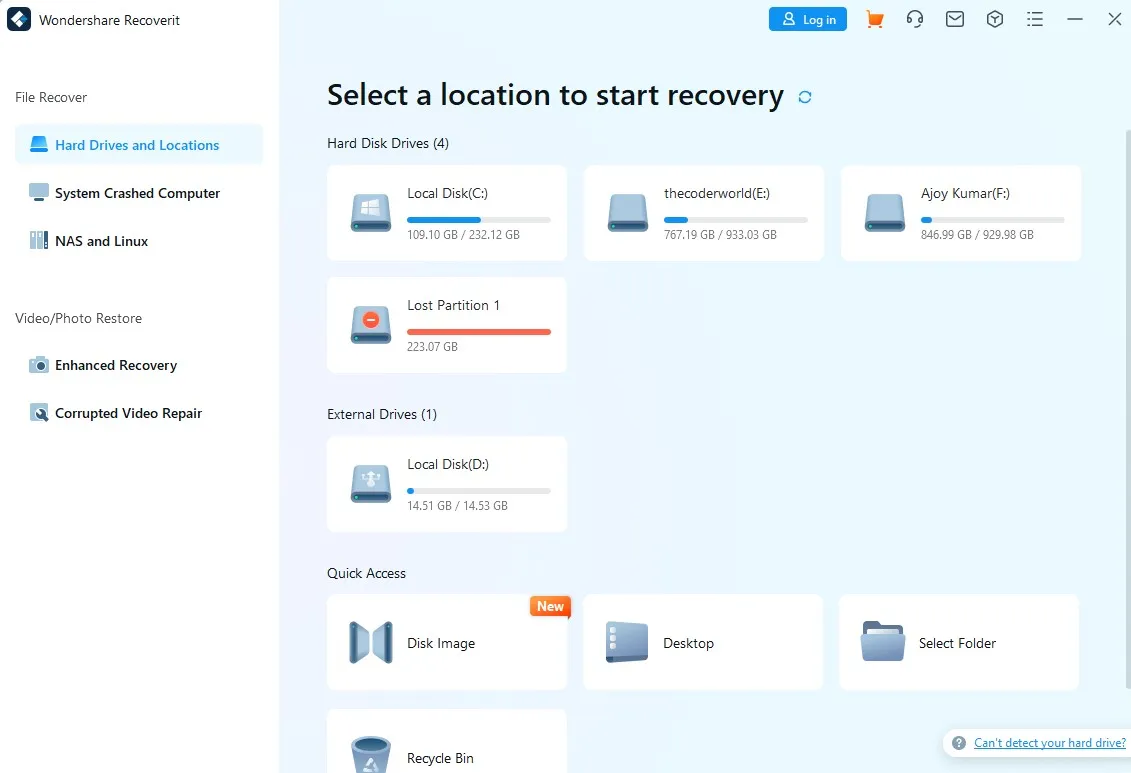

3. Восстановление данных EaseUs

EaseUS Data Recovery предоставляет различные функции, такие как восстановление случайно удаленных файлов, восстановление после вирусных атак, повреждение жесткого диска, восстановление пустых данных из корзины, восстановление после сбоя операционной системы, восстановление потерянных разделов и восстановление разделов RAW. Он также способен восстанавливать данные с различных устройств, таких как ПК, ноутбуки, флэш-накопители, цифровые камеры, видеоплееры и т. д.

Это программное обеспечение идеально подходит для восстановления таких документов, как PPT, PDF, видео практически любого формата, фотографий, графики, электронных писем и т. д. EaseUs поддерживает файловые системы FAT, exFAT, NTFS, NTFS5, ext2/ext3, HFS+, ReFS. Для запуска этого приложения вам потребуется минимум 128 МБ ОЗУ и 32 МБ дискового пространства.

Инструмент восстановления данных EaseUS предлагает гибкие функции сканирования, такие как глубокое сканирование и быстрое сканирование. Помимо восстановления данных, EaseUs предлагает предварительный просмотр, чтобы вы могли легко избежать нежелательного восстановления.

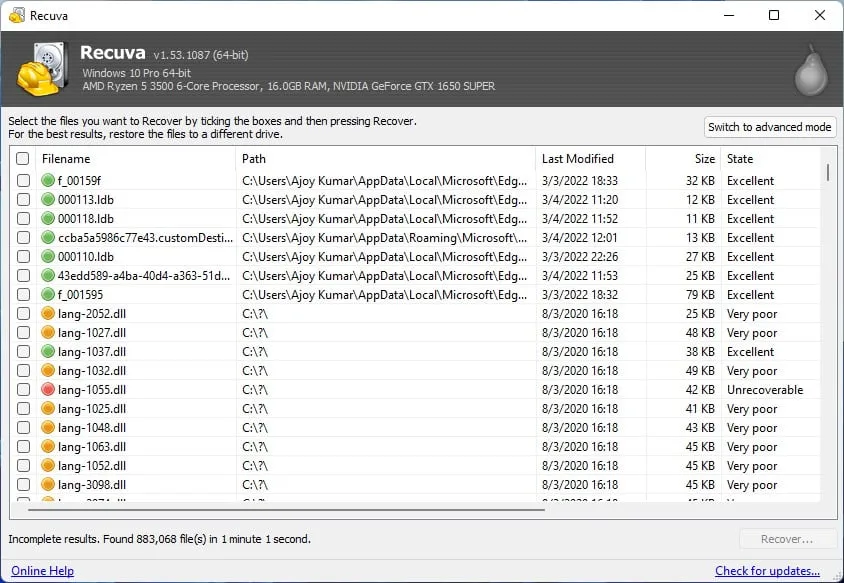

4. Рекува

Третье популярное программное обеспечение для восстановления данных в нашем списке — Recuva для Windows. Это программное обеспечение может восстановить файлы с жесткого диска, корзины и USB-накопителя. Наряду с Windows 11 он также может работать в Windows 10, Vista и XP. Recuva доступна в двух версиях: бесплатной и профессиональной.

Recuva обеспечивает скорость восстановления 90%. Вы можете восстановить удаленные файлы, а также поврежденные или недавно отформатированные файлы на ПК с Windows. Recuva предлагает два типа процедур сканирования: быстрое сканирование и глубокое сканирование. Иногда быстрое сканирование не может дать удовлетворительных результатов, т. е. может не восстановить все удаленные файлы. В таком случае вам следует пойти на глубокую чистку.

Бесплатное приложение Recuva поддерживает практически все типы файлов, включая электронные письма. Он настолько прост в использовании, что поэтому популярен среди новичков. Recuva предлагает мастер, который поможет вам выбрать тип файла, который вы хотите восстановить, и диск, на котором будут храниться удаленные файлы. Это экономит время пользователей. Вы можете ознакомиться с нашим подробным руководством по; как восстановить удаленные файлы в Windows 11 с помощью Recuva.

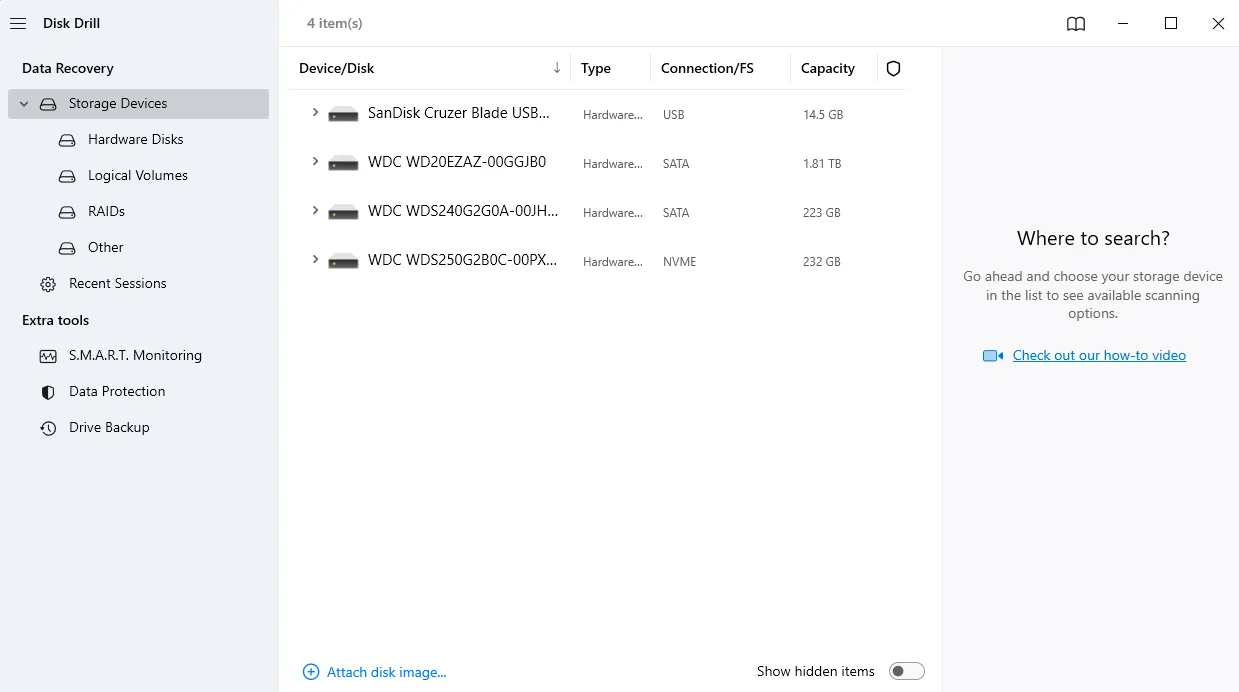

5. Disk Drill

Далее у нас есть Disk Drill, который предоставляет пользователям множество привлекательных функций, а также поддерживает и восстанавливает все форматы файлов. Документы, видео, музыка, фотографии и электронные письма попадают в его вспомогательную категорию. Вы можете восстановить удаленные файлы с жестких дисков HDD, USB-накопителей, SD-карт и камер.

Некоторые из основных функций этого приложения — несколько вариантов сканирования и защита данных. Опция многократного сканирования этого приложения обеспечивает мощное сканирование, которое поможет вам легко восстановить потерянный файл.

Программа гарантирует пользователям предотвратить дальнейшую потерю данных в будущем. Некоторые из важнейших функций защиты данных — это хранилище восстановления и гарантированное восстановление, которые помогают защитить диск от потери данных. Уникальная и интересная особенность этого программного обеспечения заключается в том, что оно может восстанавливать ваши данные с мобильных устройств, таких как Android и iPhone. Он также предлагает полную поддержку FAT, NTFS, HFS+ и EXT4.

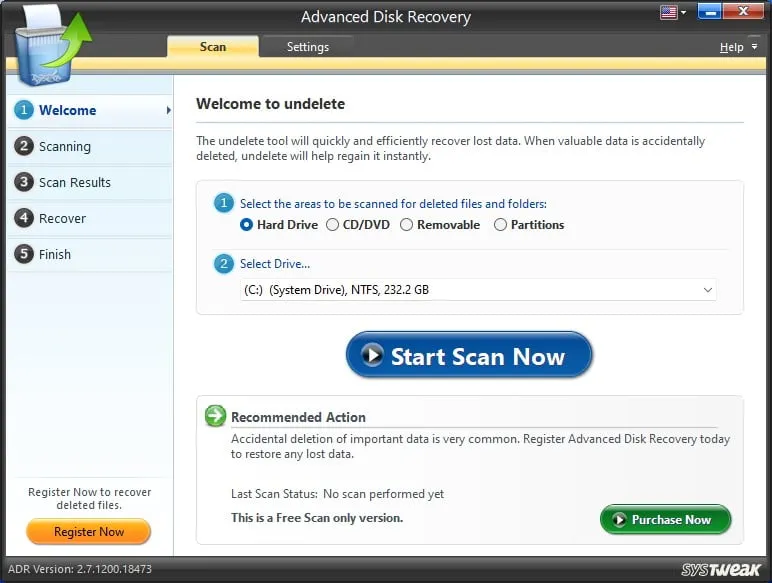

6. Расширенное восстановление диска

Advanced Disk Recovery — это удобное и бесплатное программное обеспечение, которое восстанавливает потерянные данные быстрее, чем другое программное обеспечение для восстановления. Это программное обеспечение восстанавливает данные с внешних карт памяти, USB, SSD и жестких дисков. Кроме того, это программное обеспечение совместимо со всеми типами форматов файлов. Он предлагает фильтры, которые позволяют находить и восстанавливать файлы по времени, размеру, данным и т. д.

Он также предлагает пользователям как бесплатное, так и профессиональное программное обеспечение. Расширенное восстановление диска — простое решение. Это поможет вам восстановить удаленные данные, не перезаписывая исходные данные. Самое удивительное в этом программном обеспечении то, что вы можете восстанавливать файлы данных с компакт-дисков и DVD-дисков. Еще одна сильная сторона в этом отношении — чрезвычайно эффективное сканирование.

Скачать расширенное восстановление диска

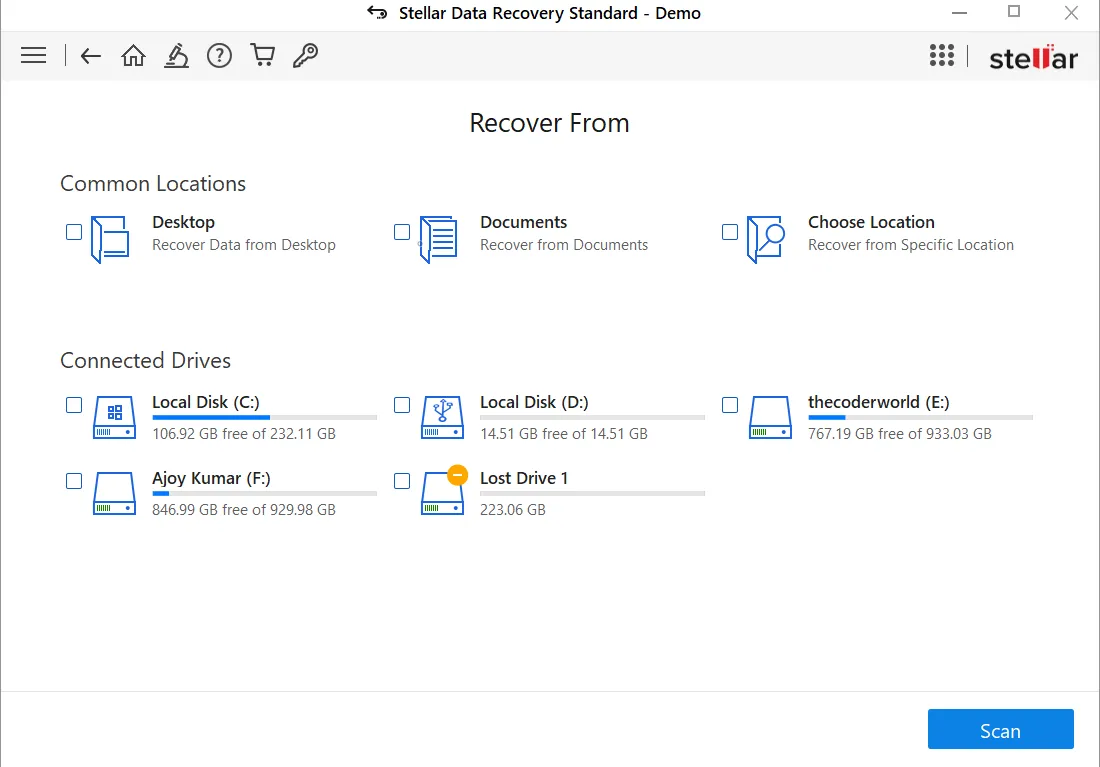

7. Звездное восстановление данных

Если и существует какое-либо программное обеспечение для восстановления данных, то оно правит отраслью уже два десятилетия; тогда вам на ум приходит Stellar Data Recovery. Приложение привлекло внимание многих профессионалов благодаря своим надежным функциям, быстрым и чистым результатам. Он также стал свидетелем высокого уровня успеха.

Он поддерживает различные функции, такие как восстановление диска, восстановление оптического носителя и сканирование определенного файла, о котором стоит упомянуть здесь. Одной из примечательных особенностей этого приложения, которое классифицирует сканирование определенного файла, является удаленный файл, который позволяет пользователю также сканировать пространство хранения, из которого был удален контент, с соответствующими результатами восстановления.

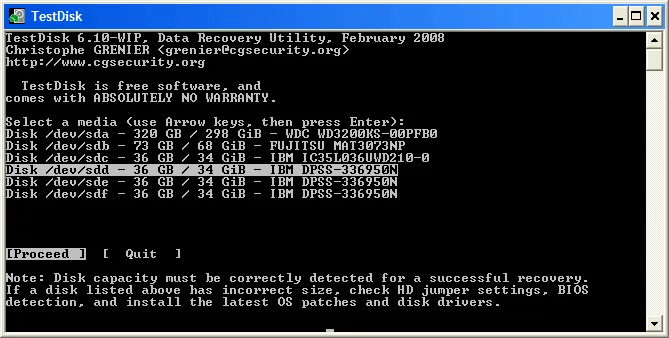

8. Тестовый диск

Testdisk является новинкой на рынке и считается революционным программным обеспечением в этой области. Причина, по которой он вырвался со сцены, заключается в его надежных функциях и мощных инструментах восстановления. Основной целью приложения было восстановление потерянного раздела и поиск решения проблем при загрузке.

Однако с течением времени и различными обновлениями приложение было признано лучшим программным обеспечением для восстановления данных с жесткого диска. Более того, было несколько комментариев критиков относительно инструмента командной строки, над которым разработчики работают, чтобы как можно скорее устранить проблему. Инструмент командной строки довольно сложен и вызывает дискомфорт у пользователей, которым нравится простой пользовательский интерфейс.

Приложение предлагает различные преимущества, поскольку облегчает восстановление загрузочного сектора, а также работает на всех основных версиях Windows. Вы можете ожидать, что это приложение восстановит все типы популярных версий файлов.

Заключение

Если вы не создаете резервную копию своих данных и они каким-то образом удаляются, это становится для вас катастрофой. Поэтому использование программного обеспечения для восстановления данных — мудрое решение. Вот наш лучший выбор программного обеспечения для восстановления данных для операционной системы Windows.

Мы надеемся, что эта статья была для вас полезной. Если вы нашли это полезным, пожалуйста, поделитесь им с другими. Кроме того, если у вас есть какие-либо вопросы или предложения, пожалуйста, оставляйте их в разделе комментариев, и мы включим их в статью.