Бадяга – это природное вещество, получаемое из предварительно высушенных и измельченных до состояния порошка пресноводных губок. Оно содержит большое количество кремния, фосфора и других полезных элементов. Благодаря этому, крем, в составе которого используется данный компонент, активно воздействует на кожу, способствует омоложению, улучшает ее внешний вид и стимулирует регенерацию в тканях.

Бадяга обладает раздражающим действием, вследствие чего происходит расширение сосудов и усиление кровообращения. За счет повышения микроциркуляции крови увеличивается скорость обменных процессов в клетках, устраняется отечность, улучшается цвет кожного покрова, разглаживаются морщины, осветляются пигментные пятна. Сочетая в себе все эти полезные свойства растительный продукт обеспечивает максимальную эффективность в борьбе с синяками и гематомами. Скопившаяся кровь рассасывается гораздо быстрее, и кожа приобретает свой естественный цвет.

Рекомендации по выбору кремов:

- Желательно выбирать средства, содержащие только натуральные ингредиенты, такие как экстракты растений, витамины и антиоксиданты. Такие продукты не только эффективны, но и безопасны.

- Концентрация вещества. Чем выше ее содержание, тем более выраженным будет эффект, поэтому данный компонент в составе должен находиться на первых позициях.

- Спектр действия. Идеальный крем с бадягой должен обладать многофункциональным действием, способным решать несколько проблем сразу: увлажнять, питать, укреплять и омолаживать кожу.

- Наличие дополнительных свойств, например охлаждение за счет содержания ментола.

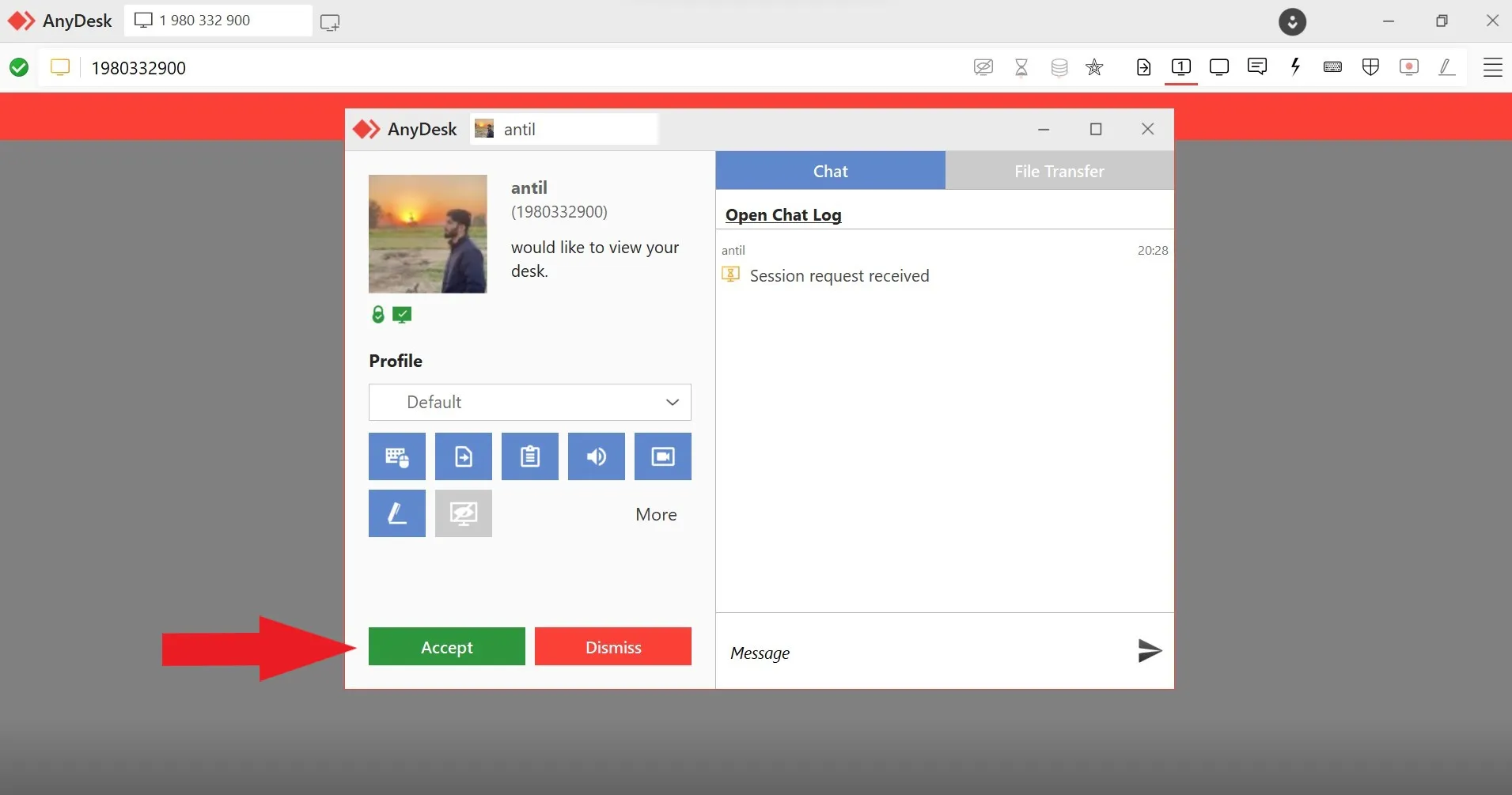

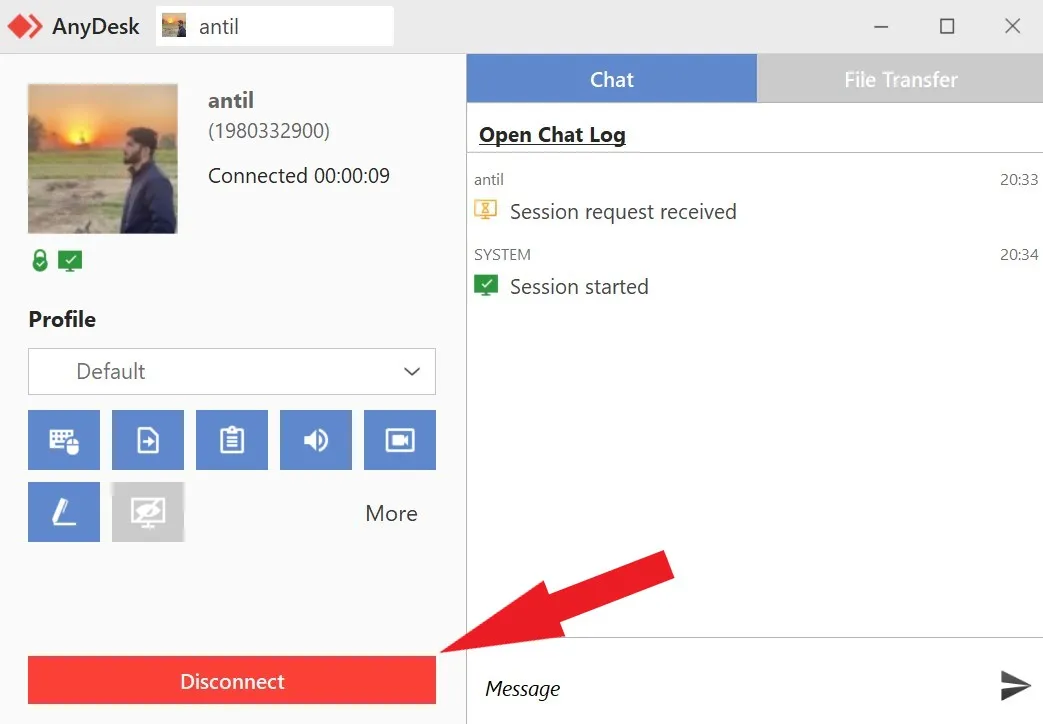

Как правильно использовать:

- Перед нанесением средства нужно очистить кожу, чтобы улучшить проникновение активных веществ.

- Состав распределяется по проблемным зонам кожи массажными движениями до полного впитывания.

- Для достижения наилучших результатов продукт используется необходимо использовать регулярно, 1-2 раза в день.

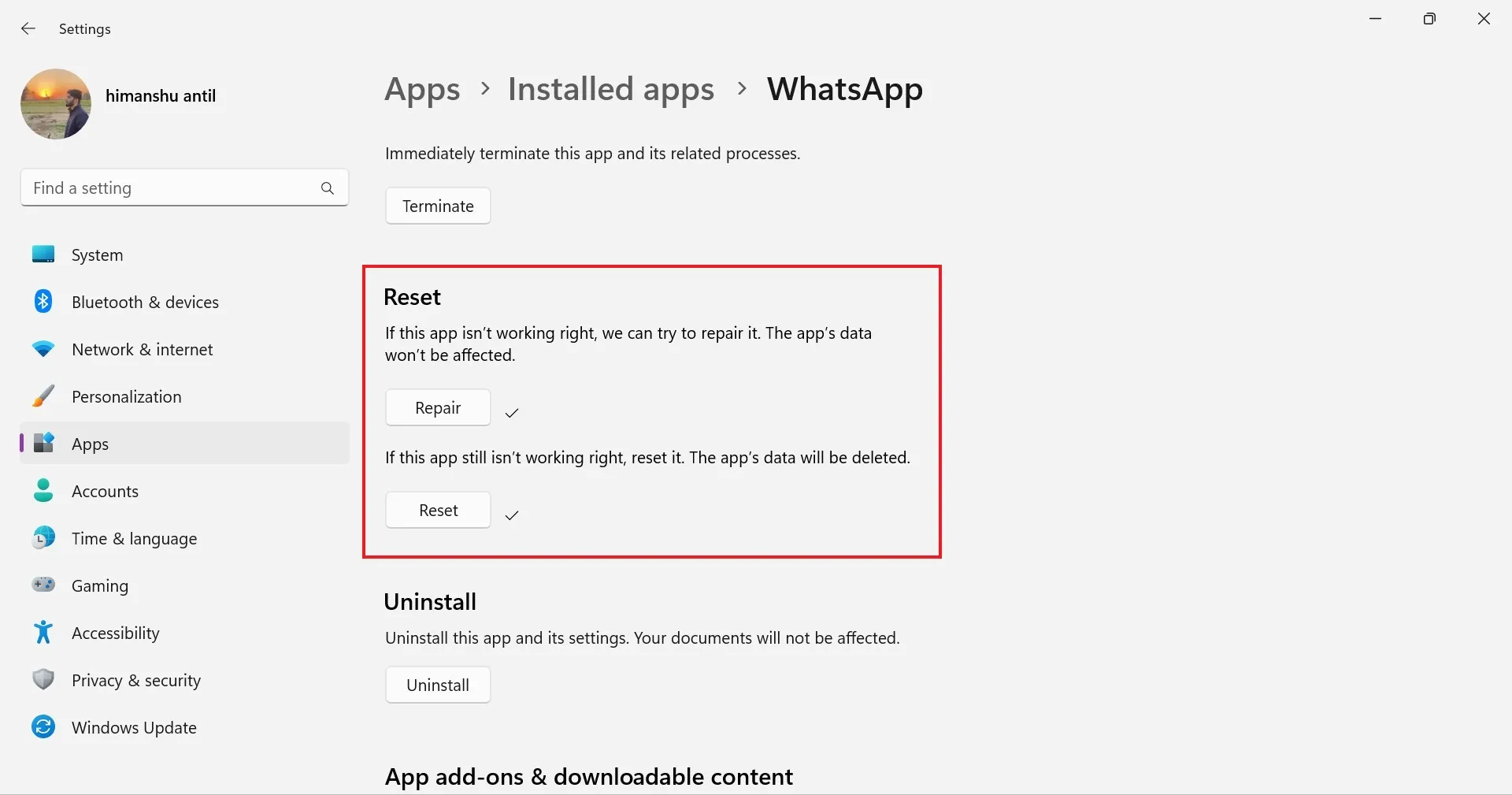

Представляем рейтинг кремов для тела с бадягой 2024. Лучшие 6 средств, которые были отобраны нашими экспертами по отзывам и оценкам пользователей.

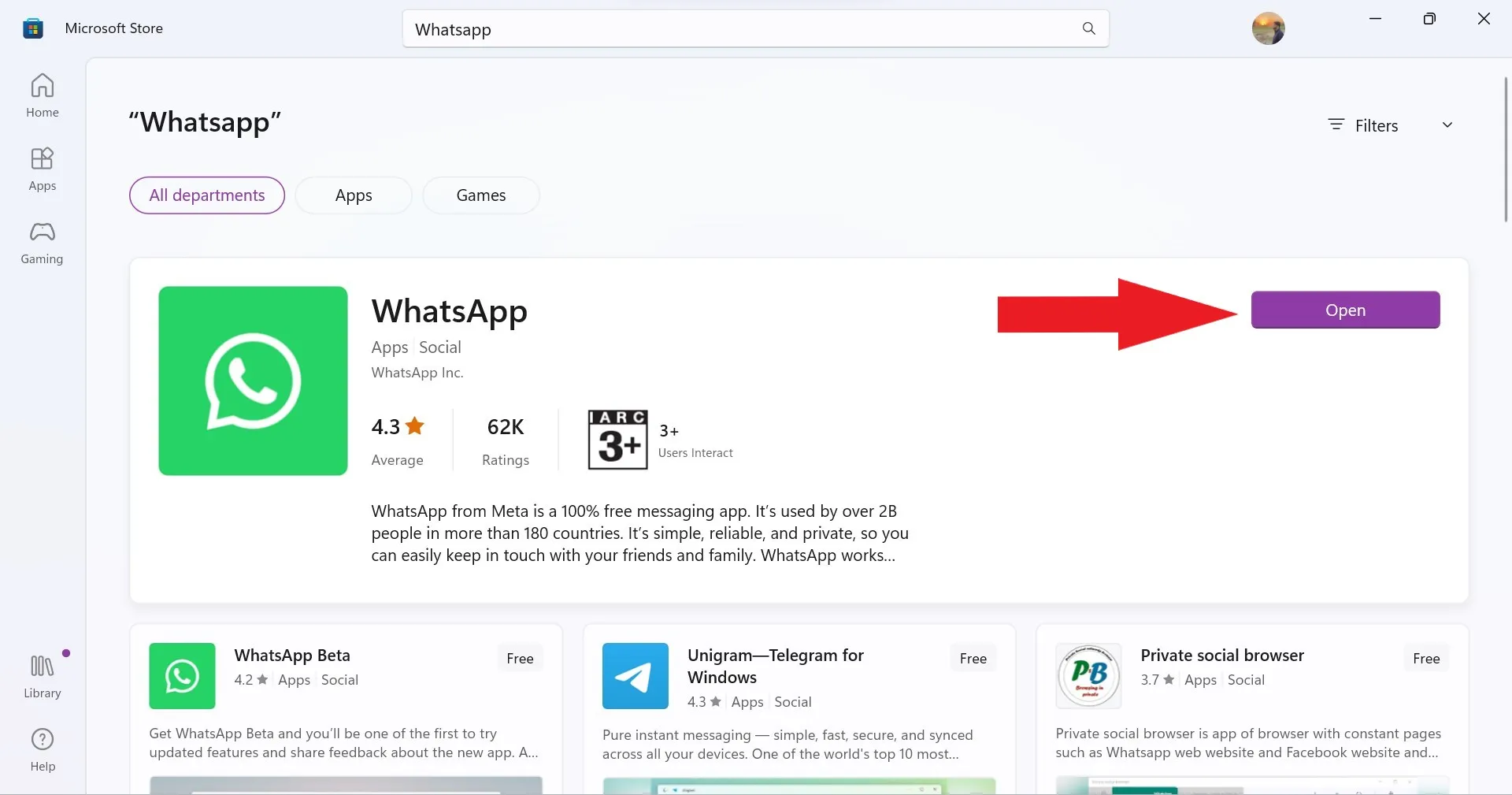

| Рейтинг (2024) | Цены, ₽ | Страна |

|---|---|---|

| 1. 112 Быстрая помощь с бадягой и маслом горчицы | от 240₽ | Россия |

| 2. Домашняя аптечка для тела с бадягой и арникой | от 300₽ | Россия |

| 3. Лекарь с бадягой для тела | от 220₽ | Россия |

| 4. Маклюра восстанавливающий с бадягой, от ушибов | от 340₽ | Россия |

| 5. Ай-Болит при синяках с тонирующим эффектом | от 200₽ | Россия |

| 6. Золотой Алтай от синяков и ушибов | от 130₽ | Россия |

Читайте также: 11 лучших средств от синяков

6 Золотой Алтай от синяков и ушибов арника, мумие, бадяга, д-пантенол

Открывает наш рейтинг крем для тела «Золотой Алтай с мумие, арникой и бадягой» марки Алтэя. Он является универсальным средством, которое помогает справиться с различными повреждениями кожного покрова, ускоряя процесс их заживления.

Продукт содержит уникальное сочетание активных компонентов, которые работают вместе для облегчения боли, уменьшения воспаления и ускорения регенерации. Мумие — это натуральное источник минералов и микроэлементов, который способствует активации процессов восстановления. Арника — природный антибактериальный ингредиент, помогающий снять отечность и гематомы, вызванные ушибами. Эфирное масло чайного дерева и экстракт шалфея оказывают противовоспалительное действие. Д-пантенол, масло виноградной косточки, сорбитол, масло грецкого ореха питают, увлажняют и смягчают. Входящий в состав ментол охлаждает поверхность эпидермиса, насыщает клетки кислородом.

Регулярное использование крема способствует снятию болевых ощущений, в т.ч. и в суставах, быстрому избавлению от синяков, улучшению состояния кожи.

Плюсы:

- Избавляет от синяков.

- Убирает отеки.

- Уменьшает боль.

- Состав.

- Охлаждающий эффект.

Минусы:

- Аромат.

5 Ай-Болит при синяках с тонирующим эффектом

Крем Ай-Болит занимает пятое место. Это не просто косметический продукт, а полноценный союзник в борьбе за красоту и здоровье кожи. Главная особенность средства заключается в сочетании эффективного ухода за поврежденными участками эпидермиса и легкого тонирующего эффекта. Его формула содержит бежевый пигмент, который обеспечивает легкую маскировку синяков.

Ключевыми компонентами являются троксерутин, экстракты арники и пиявки известные своими противовоспалительными и ранозаживляющими свойствами. Крем ускоряет процесс заживления ушибов, способствует уменьшению отечности и рассасыванию гематом. Биоактивный комплекс в составе питает и увлажняет кожный покров.

Продукт выпускается в небольшой тубе объемом 30 мл, которая не займет много места в сумке, благодаря чему ее всегда можно держать под рукой. Крем равномерно распределяется и быстро впитывается, оставляя матовый финиш.

Покупатели отмечают, что средство помогает сократить процесс восстановления кожи после ушибов, однако не все остались довольны тонирующими свойствами.

Плюсы:

- Маслá в составе.

- Ускоряет процесс заживления.

- Быстро впитывается.

- Матовый финиш.

- Удобная туба.

Минусы:

- Слабый тонирующий эффект.

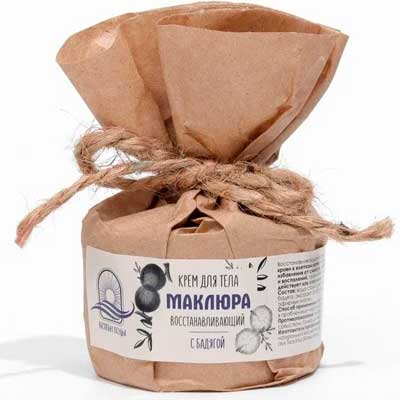

4 Маклюра восстанавливающий с бадягой, от ушибов

Производитель Божьи Воды разрабатывает натуральную косметику, используя только полезные и эффективные ингредиенты. Кроме того, вся продукция проходит контроль качества и не тестируется на животных.

На четвертом месте рейтинга располагается восстанавливающий крем с бадягой «Маклюра». Он выпускается в пластиковой баночке объемом 50 мл, которая дополнительно упакована в бумажный пакет, что визуально производит впечатление экологичности продукта.

Это средство станет незаменимым для тех, кто подвержен ударам и ушибам. Благодаря его применению, можно быстро справиться с последствиями травм и вернуть коже здоровый и ухоженный вид. Имеет легкую текстуру, которая быстро впитывается и не оставляет жирной пленки, даря ощущение комфорта.

В состав входят компоненты, обеспечивающие быстрое устранение отеков и воспалений. Маклюра снижает боль в мышцах и суставах. Экстракт гриба чаги способствует улучшению кровоснабжения. Пчелиный воск увлажняет, живица смягчает и успокаивает, облепиховое масло активизирует процесс регенерации в клетках.

Плюсы:

- Натуральный продукт.

- Снимает отеки.

- Устраняет синяки.

- Увлажняет.

- Эффектная упаковка.

3 Лекарь с бадягой для тела

Третью позицию занимает крем с бадягой для тела бренда ЛЕКАРЬ. Он обладает противовоспалительным и антисептическим эффектом, уменьшает воспаление и успокаивает кожу. Выпускается в двух вариантах: тубы объемом 50 мл и 75 мл.

У средства легкая текстура, обеспечивающая быстрое впитывание без липкости и жирного блеска. Натуральные компоненты состава делают его одним из лучших средств при возникновении ушибов. Аллантоин снимает раздражения и покраснения. Экстракт корня имбиря и бадана оказывают противовоспалительное действие, укрепляют сосуды, улучшают циркуляцию крови и стимулируют обновление клеток. Витамин Е помогает восстановить естественный баланс влаги эпидермиса, защищает его от вредного воздействия окружающей среды и улучшает состояние. Этот комплекс ингредиентов обеспечивает эффективный уход за кожей и возвращает ей здоровый вид.

Покупатели оставляют восторженные отзывы. Продукт демонстрирует хорошие результаты: быстро рассасывает гематомы, снижает боль и устраняет синяки. Помимо этого он питает кожный покров, делая его гладким и мягким.

Плюсы:

- Помогает при ушибах.

- Хороший состав.

- Приятный аромат.

- Объем.

- Формат упаковки.

2 Домашняя аптечка для тела от синяков и ушибов с бадягой и арникой

Компания Две линии предлагает широкий ассортимент косметических средств для ухода за лицом, волосами и телом. Вся продукция создается на основе уникальных алтайских трав и компонентов, благодаря внимательно отобранным ингредиентам и профессиональной разработке она обладает высокой эффективностью и безопасностью.

Крем для тела «Бадяга и арника» располагается на второй позиции. Его формула сочетает в себе полезные масла и экстракты, обеспечивает максимальную эффективность в борьбе с синяками и ушибами. Нежная текстура быстро впитывается, не оставляя ощущения липкости, кроме того, продукт также отлично увлажняет и питает.

Регулярное использование средства – это простой и удобный способ ускорить процесс заживления тканей и избавиться от эстетического дискомфорта. Отсутствие искусственных красителей, отдушек и консервантов делает продукт безопасным и подходящим для даже чувствительной кожи. Богатый комплекс активных растительных экстрактов позволяет достигнуть максимального эффекта уже после нескольких применений.

Плюсы:

- Устраняет отеки.

- Избавляет от синяков.

- Увлажнение.

- Высокая эффективность.

- Масла и травы в составе.

Минусы:

- Небольшой объем.

1 112 Быстрая помощь для ухода за кожей с бадягой и маслом горчицы

Лидером нашего рейтинга становится крем с бадягой и маслом горчицы бренда 112 Быстрая помощь. Он представляет собой уникальное сочетание активных компонентов растительного происхождения, обладающих полезными свойствами. Средство разработано с учетом потребностей всех типов кожи: от сухой и чувствительной до проблемной и склонной к жирности. Оно имеет легкую текстуру, хорошо впитывается и не оставляет ощущения липкости. Отсутствие агрессивных синтетических компонентов снижает риск появления аллергических реакций.

Состав обогащен натуральными ингредиентами. Бадяга и масло горчицы обеспечивают быструю помощь и эффективное восстановление кожного покрова. Д-пантенол оказывает противовоспалительное действие. Арника, лаванда и прополис выступают в качестве антисептика.

Для достижения максимального результата продукт можно использовать утром и вечером. При регулярном применении кожа приобретет здоровый и естественный вид.

Покупатели высоко оценивают средство. Оно эффективно борется с последствиями ушибов, с его помощью синяки становится менее заметными уже через несколько дней.

Плюсы:

- Устраняет синяки.

- Снимает боль.

- Быстрый результат.

- Натуральные компоненты.

- Экономичный расход.

Какой крем для тела с бадягой лучше выбрать

Появление синяков и гематом – довольно частое последствие после ушибов. Использование эффективного крема – это простой способ избавиться от эстетического дискомфорта и ускорить процесс заживления поврежденных мягких тканей. Средства с бадягой способны решить множество проблем с кожей и принести радость от здорового и красивого внешнего вида.

Продукт компании Алтэя способствует снятию болевых ощущений за счет легкого охлаждающего свойства. Его рекомендуют использовать не только при появлении синяков, но и для профилактики заболевания суставов.

Ай-Болит позволяет не только запустить процесс заживления травмированных мягких тканей, но и маскирует внешние признаки их проявления благодаря легкому тонирующими эффекту.

Восстанавливающий крем для тела «Маклюра» включает в себя только натуральные ингредиенты. Отсутствие опасных синтетических компонентов делает его безопасным для применения.

Средство марки 112 Быстрая помощь обладает множеством полезных свойств, которые делают его незаменимым в уходе за кожей, в т.ч. и за чувствительной. Наличие масел, экстрактов растений, витаминов способствует комплексному оздоровлению кожного покрова за короткое время.

Ускорить регенерацию клеток, снять отек и укрепить защитные функции эпидермиса помогают продукты брендов Две линии и ЛЕКАРЬ. Наряду с бадягой они содержат природные экстракты, улучшающие состояние кожи.

Удачных покупок!

The post 6 лучших кремов для тела с бадягой appeared first on Рейтинги, подборки и список лучшего.

Source: spasibovsem.ru krasota-i-zdorove