Когда оболочка получает какую-то командную строку на выполнение, она до начала выполнения команды осуществляет «грамматический разбор» полученной командной строки. Одним из этапов такого «разбора» является раскрытие или подстановка выражений (expansion). В оболочке bash имеется семь типов подстановки выражений: Читать

Архив рубрики: Linux

BASH. Часть 5. Параметры и переменные. Окружение оболочки.

Понятие параметра в оболочке bash подобно понятию переменной в обычных языках программирования. Именем (или идентификатором) параметра может быть слово, состоящее из алфавитных символов, цифр и знаков подчеркивания (только первый символ этого слова не может быть цифрой), а также число или один из следующих специальных символов: *, @, #, ?, — (дефис), $, !, 0, _ (подчеркивание).Говорят, что параметр задан или установлен, если ему присвоено значение. Значением может быть и пустая строка. Чтобы вывести значение параметра, используют символ $ перед его именем. Так, команда Читать

BASH. Часть 4. Стандартный ввод/вывод.

Потоки ввода/вывода

Когда программа запускается на выполнение, в ее распоряжение предоставляются три потока (или канала).

Стандартный ввод (standard input или stdin). По этому каналу данные передаются программе.

Стандартный вывод (standard output или stdout). По этому каналу программа выводит результаты своей работы.

Стандартный поток сообщений об ошибках (standard error или stderr). Поэтому каналу программы выдают информацию об ошибках. Читать

BASH. Часть 3. Выполнение команд.

В одной из предыдущих статей я кратко описывал типовые последовательности команд. Начиная с этой статьи все, что там описывалось, будет дано более подробно. Одна из основных функций оболочки состоит в том, чтобы организовать исполнение команд пользователя, вводимых им в командной строке. В частности, оболочка предоставляет пользователю два специальных оператора для организации задания команд в командной строке: «;» и «&». Читать

BASH. Часть 2. Специальные символы.

Оболочка bash использует несколько символов из числа 256 символов набора ASCII в специальных целях либо для обозначения некоторых операций, либо для преобразования выражений. В число таких символов входят: Читать

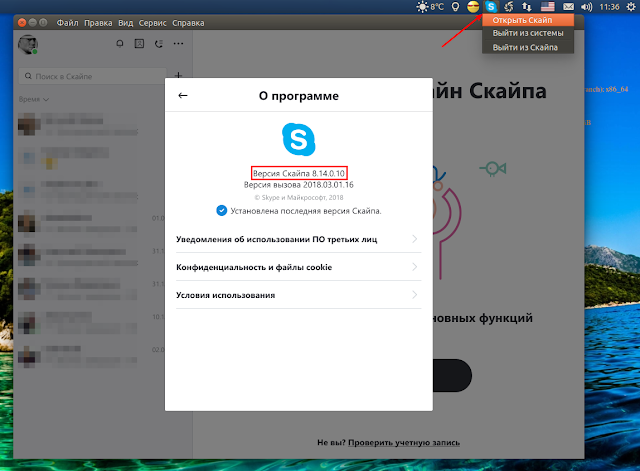

Установка Skype стала проще snap-пакетом в Linux

Установка Skype для дистрибутивов Linux теперь намного проще универсальным пакетом Snap, т.к компания Canonical 1 февраля создала snap-пакет Skype и включила его в Snap Store, т.е в магазин приложений Snap.

О Snap я писал ЗДЕСЬ подробно, поэтому не буду повторяться. Стоит лишь отметить, что snap-пакеты можно устанавливать в любую систему Linux, независимо от пакетной базы дистрибутива: Debian (.deb); RedHat (.rpm) и пр., главное чтобы в системе был установлен инструмент snapd, поддерживающий установку snap-пакетов.

В дистрибутивах Ubuntu и производных, начиная с Ubuntu 17.10 инструмент snapd установлен по умолчанию, что делает возможным простую установку программ «завёрнутых» в пакет snap.

Для установки инструмента snapd в предыдущие дистрибутивы Ubuntu и производные, а также другие дистрибутивы Linux, необходимо установить инструмент snapd.

Для дистрибутивов Debian/Ubuntu/RedHat/Fedora/Opensus выполните в терминале одну из установочных команд:

Для дистрибутивов Debian/Ubuntu

sudo apt install snapd

Для дистрибутивов RedHat/Fedora

sudo yum install snapd

Для дистрибутива Opensuse

sudo zypper install snapd

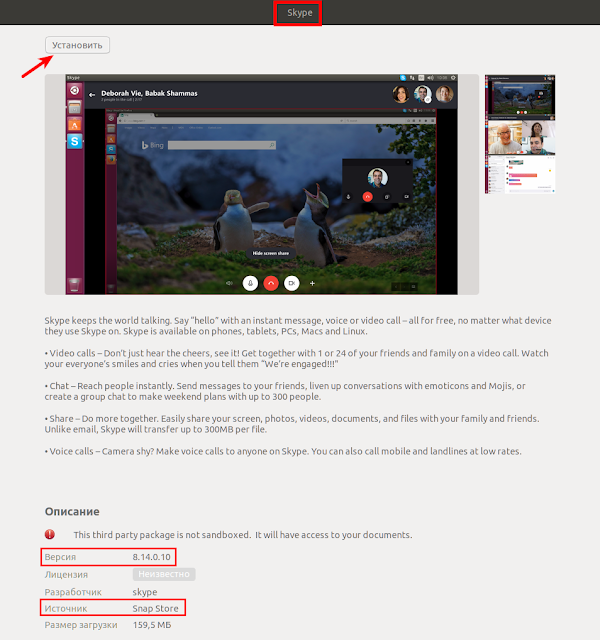

Теперь устанавливать Skype snap-пакетом в любой дистрибутив Linux можно универсальной командой:

sudo snap install skype —classic

По окончании установки Skype snap-пакетом, запустить его в первый раз можно следующей командой в терминале:

/snap/bin/skype

Примечание. Немаловажно заметить, что программа Skype является приложением с закрытым исходным кодом, поддерживаемой Microsoft (Windows), т.е. разработчики дистрибутивов Linux не могут делать улучшения/обновления программы, но Canonical упаковали Skype в пакет snap таким образом, что по мере обновления Skype (стабильная версия) компанией Microsoft, установленный Skype пакетом snap в вашей системе также будет получать обновления. Для этого установка Skype дополнена, флагом —classic.

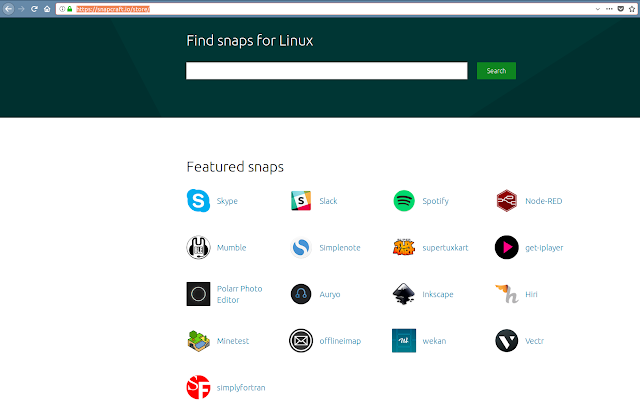

Приложения в Snap Store https://snapcraft.io/store/:

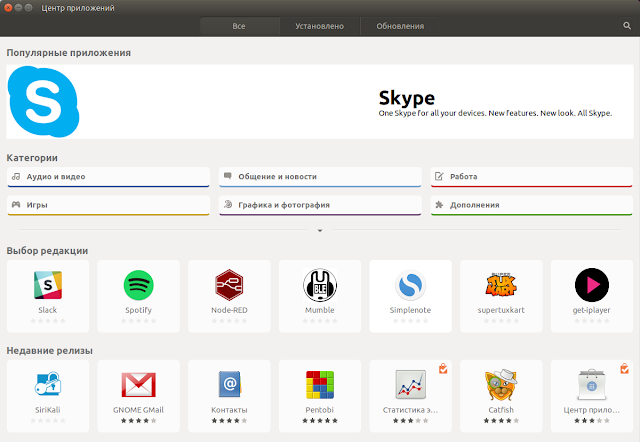

Все приложения из Snap Store также дублируются в Центре приложений:

Источник: https://insights.ubuntu.com/

P.S. Если у вас появились вопросы по данной статье, обсудить их можно на нашем форуме:

http://compizomania.54672.x6.nabble.com/Skype-snap-Linux-td6186.html

Удачи.

Автор: Владимир Долгирев