Отправление в виртуальные приключения Roblox обычно приносит волнующие эмоции, но что, если неожиданное отключение света омрачит ваш игровой процесс? Вы можете видеть только меню и значки Roblox без реального игрового процесса на своем телефоне или компьютере. К счастью, проблему черного экрана в Roblox можно решить.

Мало что так раздражает, как проблемы, которые отвлекают вас от любимых игр Roblox. Чтобы помочь вам, мы составили список решений, которые в кратчайшие сроки вернут Roblox к работе. Итак, давайте посмотрим.

1. Закройте и снова откройте Roblox.

Иногда у Roblox могут возникать проблемы при открытии на телефоне или компьютере. Если это всего лишь временный сбой, из-за которого Roblox отображает черный экран, простой перезапуск должен решить проблему.

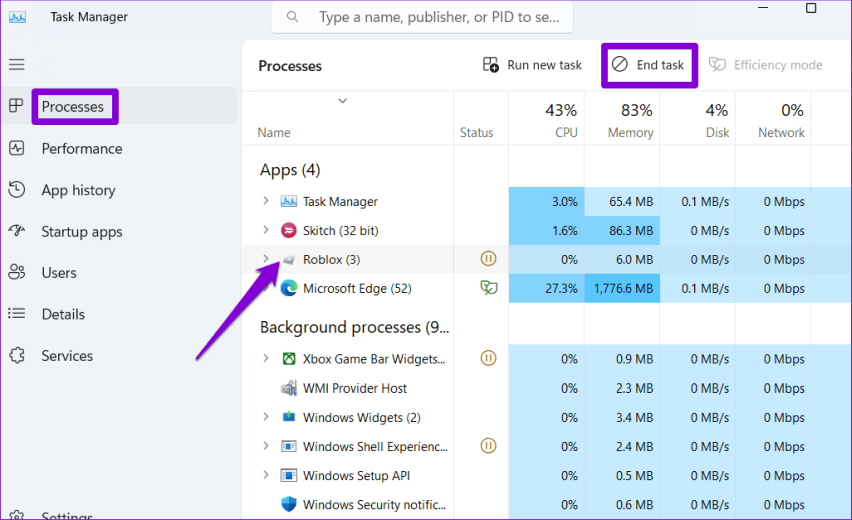

В Windows нажмите сочетание клавиш Ctrl+Shift+Esc, чтобы открыть диспетчер задач. На вкладке «Процессы» выберите Roblox и нажмите кнопку «Завершить задачу».

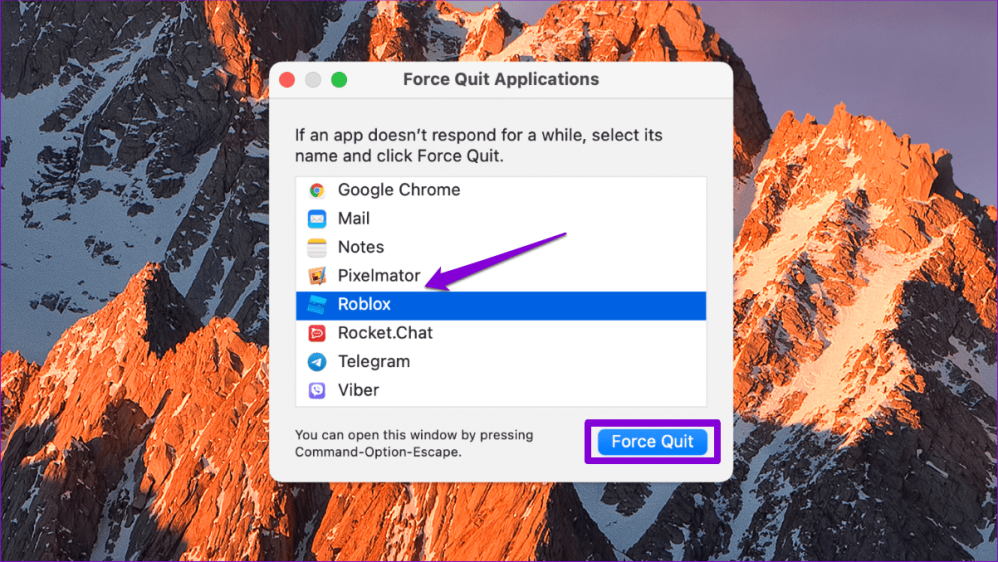

На Mac нажмите сочетание клавиш Command+Option+Esc, выберите Roblox в окне «Принудительное завершение приложений» и нажмите кнопку «Принудительное завершение».

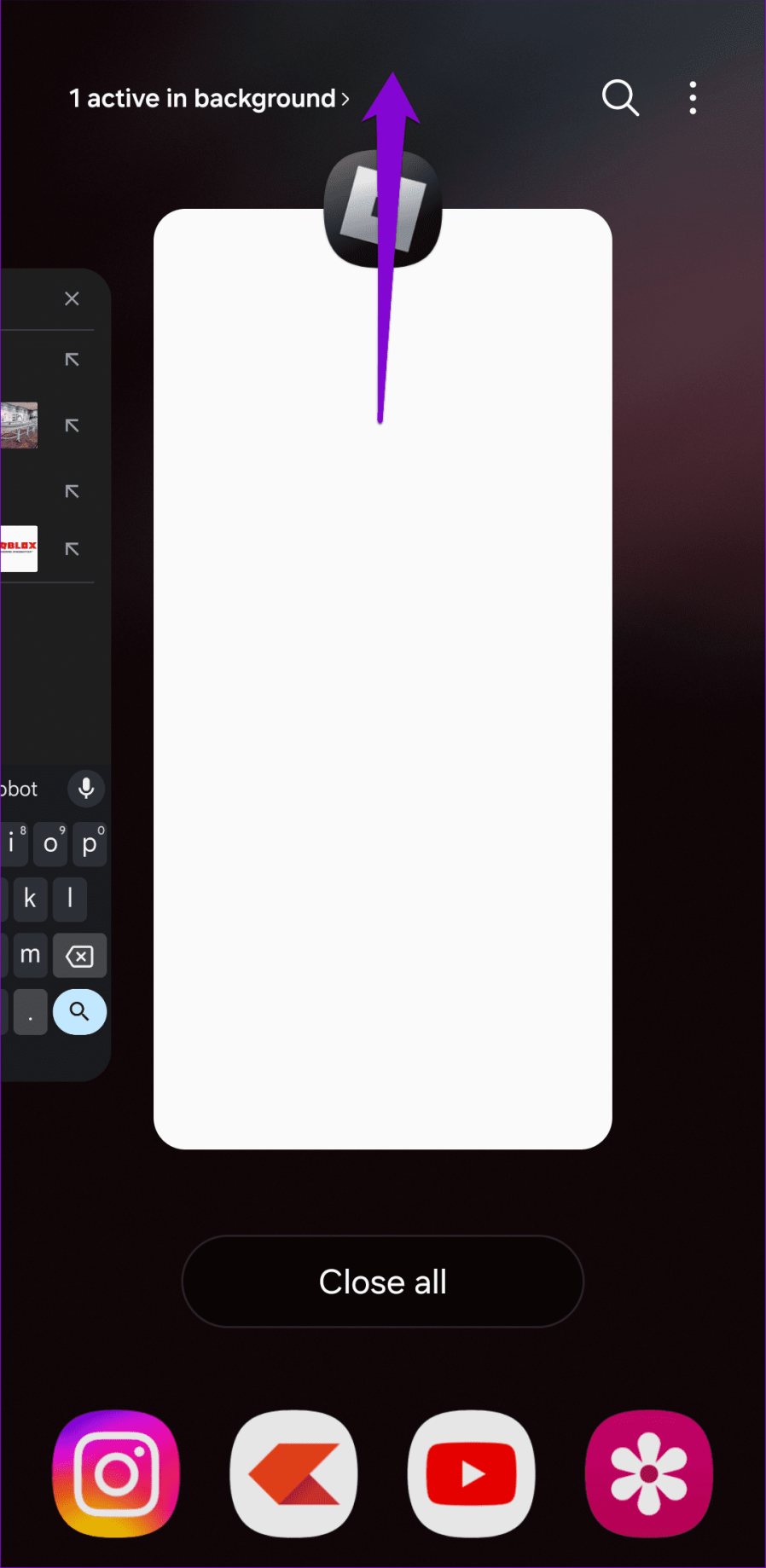

Те, кто играет в Roblox на Android или iPhone, могут провести пальцем вверх от нижней части экрана (или нажать кнопку «Обзор приложений»), чтобы вызвать переключатель приложений, и провести вверх по карточке Roblox, чтобы закрыть игру.

После этого снова откройте Roblox и проверьте, работает ли он нормально.

2. Включите функцию замедленного движения.

Roblox показывает черный экран, когда вы пытаетесь присоединиться к опыту? Вы можете включить опцию «Уменьшить движение», которая помогла нескольким пользователям Reddit практически мгновенно решить проблему.

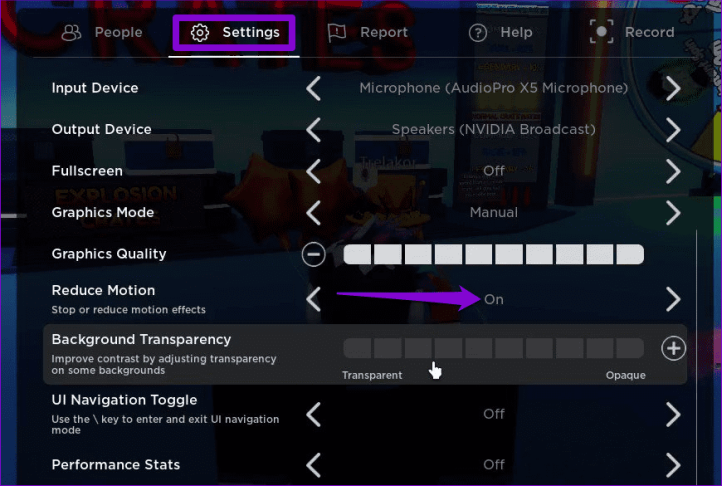

Шаг 1: Запустите Roblox и откройте любую игру. Нажмите значок Roblox в верхнем левом углу.

Шаг 2. Перейдите на вкладку «Настройки» и установите для параметра «Уменьшение движения» значение «Вкл.». Вернитесь в игру и проверьте, нормально ли она загружается.

3. Понизьте настройки графики.

Другая причина, по которой экран Roblox может стать черным при входе в игру, заключается в том, что качество графики в игре слишком высокое и оборудование вашего компьютера не может его обработать. Чтобы решить эту проблему, понизьте качество игровой графики, что также уменьшит задержку Roblox.

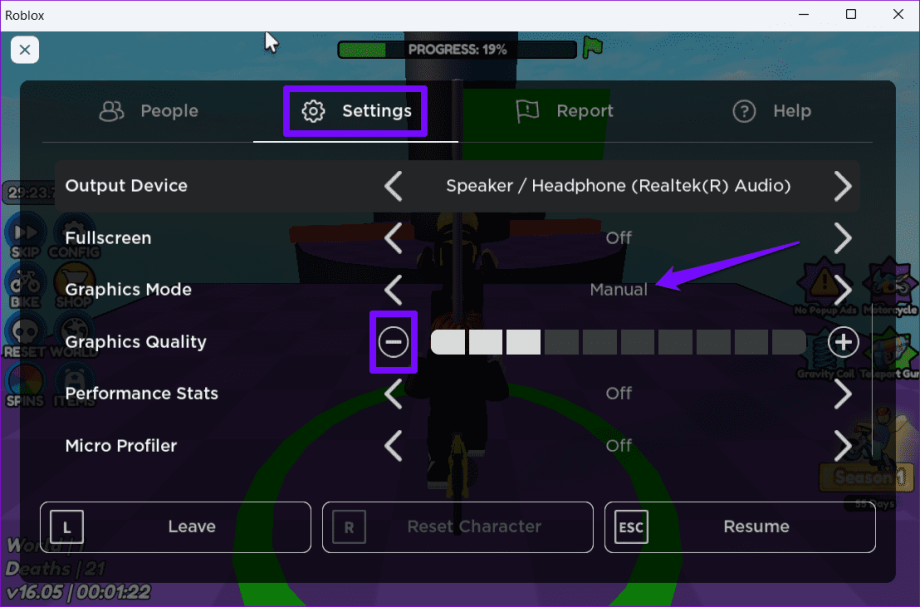

Шаг 1: Откройте Roblox и запустите свою любимую игру.

Шаг 2: Нажмите значок Roblox в верхнем левом углу.

Шаг 3: Перейдите на вкладку «Настройки» и установите для графического режима значение «Вручную». Затем щелкните значок минуса рядом с надписью «Качество графики», чтобы снизить качество игровой графики.

Вернитесь в свою игру Roblox и проверьте, сохраняется ли проблема.

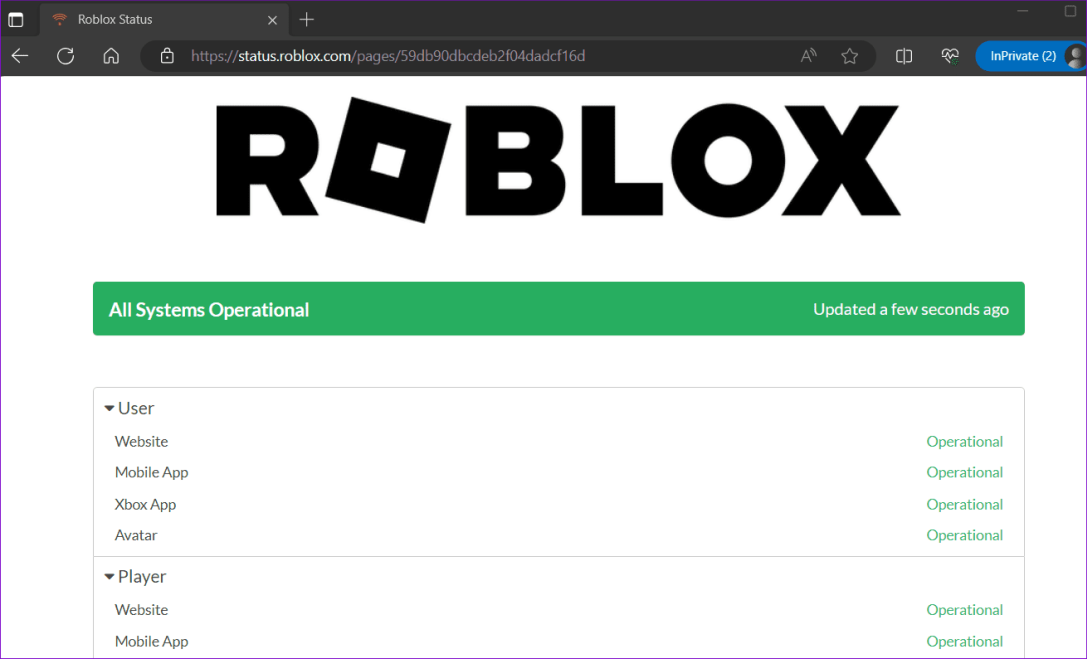

4. Проверьте статус сервера Roblox.

Проблемы с загрузкой в Roblox также могут возникнуть из-за проблем, связанных с сервером. Вам необходимо проверить статус сервера Roblox, чтобы проверить эту возможность. В случае сбоя вам придется подождать, пока серверы Roblox снова заработают, прежде чем вы сможете возобновить игру в свои любимые игры.

Проверьте статус сервера Roblox

5. Обновите графический драйвер (Windows).

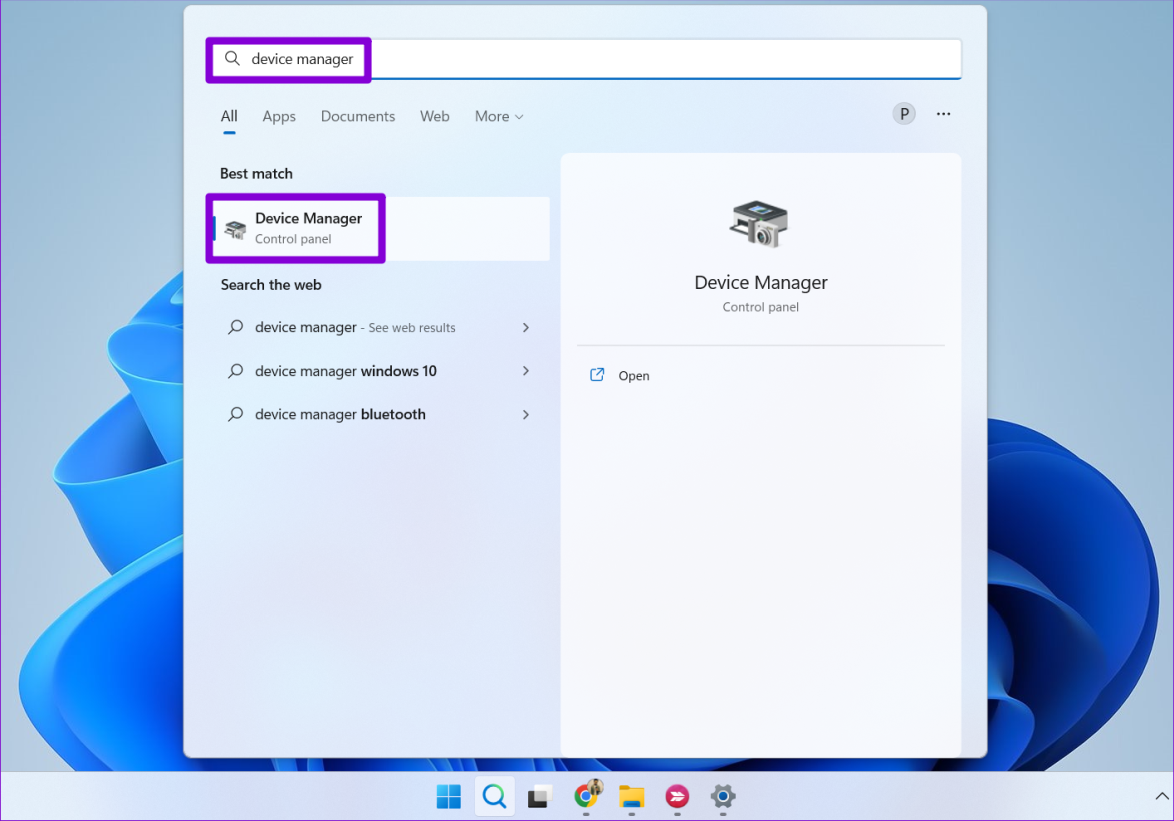

Если вы столкнулись с проблемой черного экрана в Windows при работе с другими приложениями и играми, возможно, графический драйвер на вашем компьютере устарел. В этом случае вы можете попробовать обновить проблемный драйвер, выполнив следующие действия:

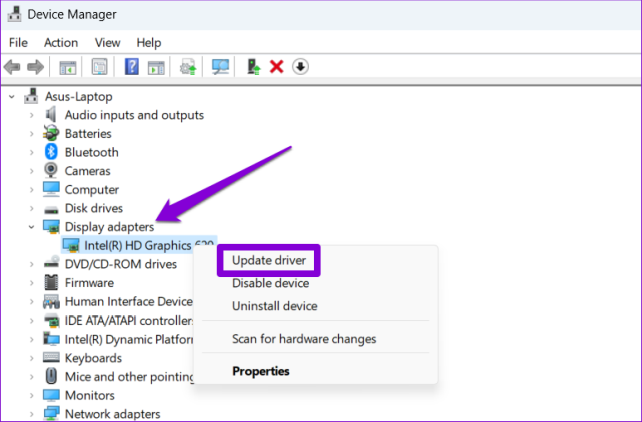

Шаг 1: Нажмите сочетание клавиш Windows+S, чтобы получить доступ к меню поиска. Введите диспетчер устройств и выберите первый появившийся результат.

Шаг 2. В окне «Диспетчер устройств» разверните «Адаптеры дисплея». Щелкните правой кнопкой мыши свой драйвер и выберите опцию «Обновить драйвер».

Далее следуйте инструкциям на экране, чтобы обновить драйвер.

6. Очистить кэш Roblox

Устаревшие или поврежденные данные кэша Roblox на вашем телефоне или компьютере также могут вызывать такие аномалии. Вы можете очистить существующие данные кэша Roblox и посмотреть, восстановит ли это нормальное состояние.

Окна

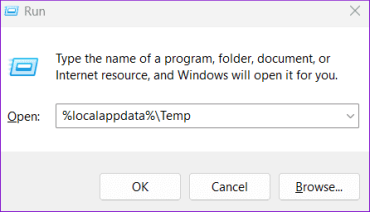

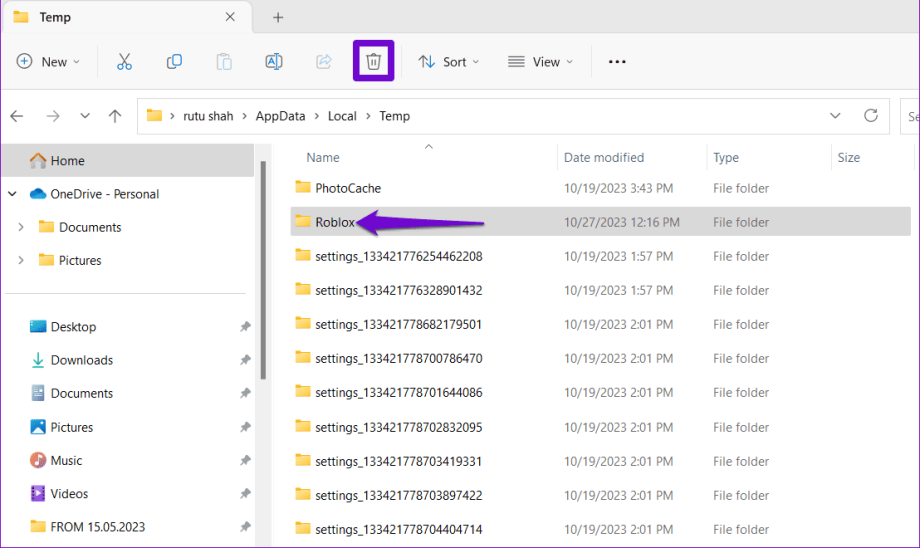

Шаг 1. Нажмите сочетание клавиш Windows+R, чтобы открыть диалоговое окно «Выполнить». Введите %localappdata%Temp в поле Открыть и нажмите Enter.

Шаг 2. В открывшемся окне проводника выберите папку Roblox и щелкните значок корзины вверху, чтобы удалить ее.

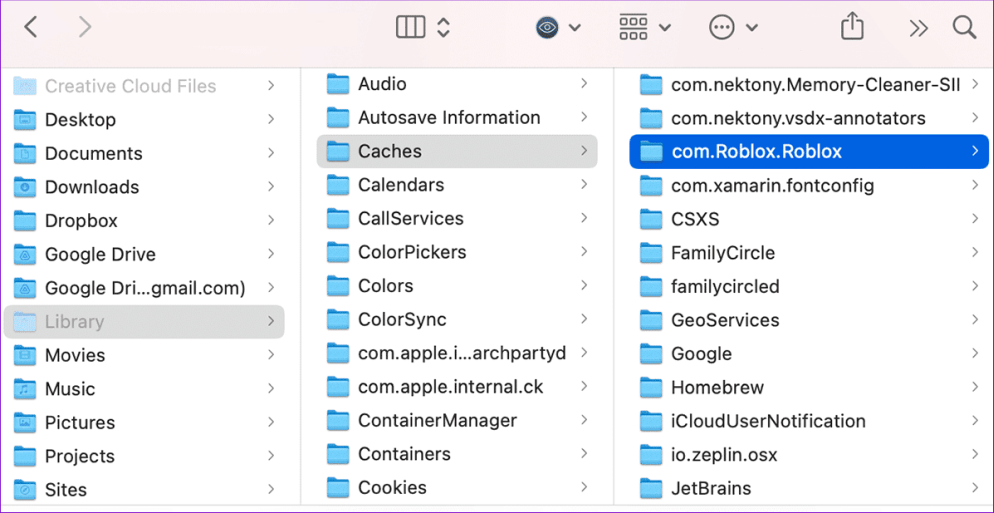

Мак

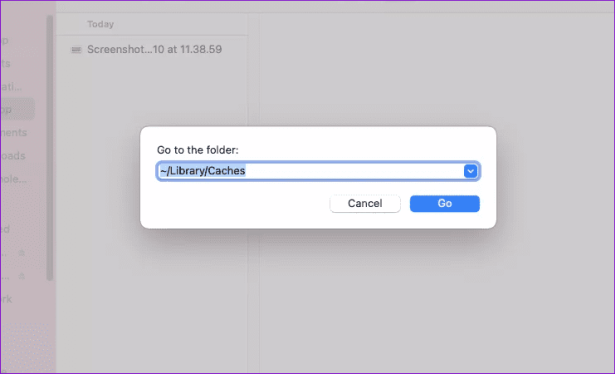

Шаг 1. Нажмите сочетание клавиш Shift+Command+G, введите ~/Library/Caches и нажмите Enter.

Шаг 2. Выберите папку com.Roblox.Roblox и нажмите клавишу «Удалить».

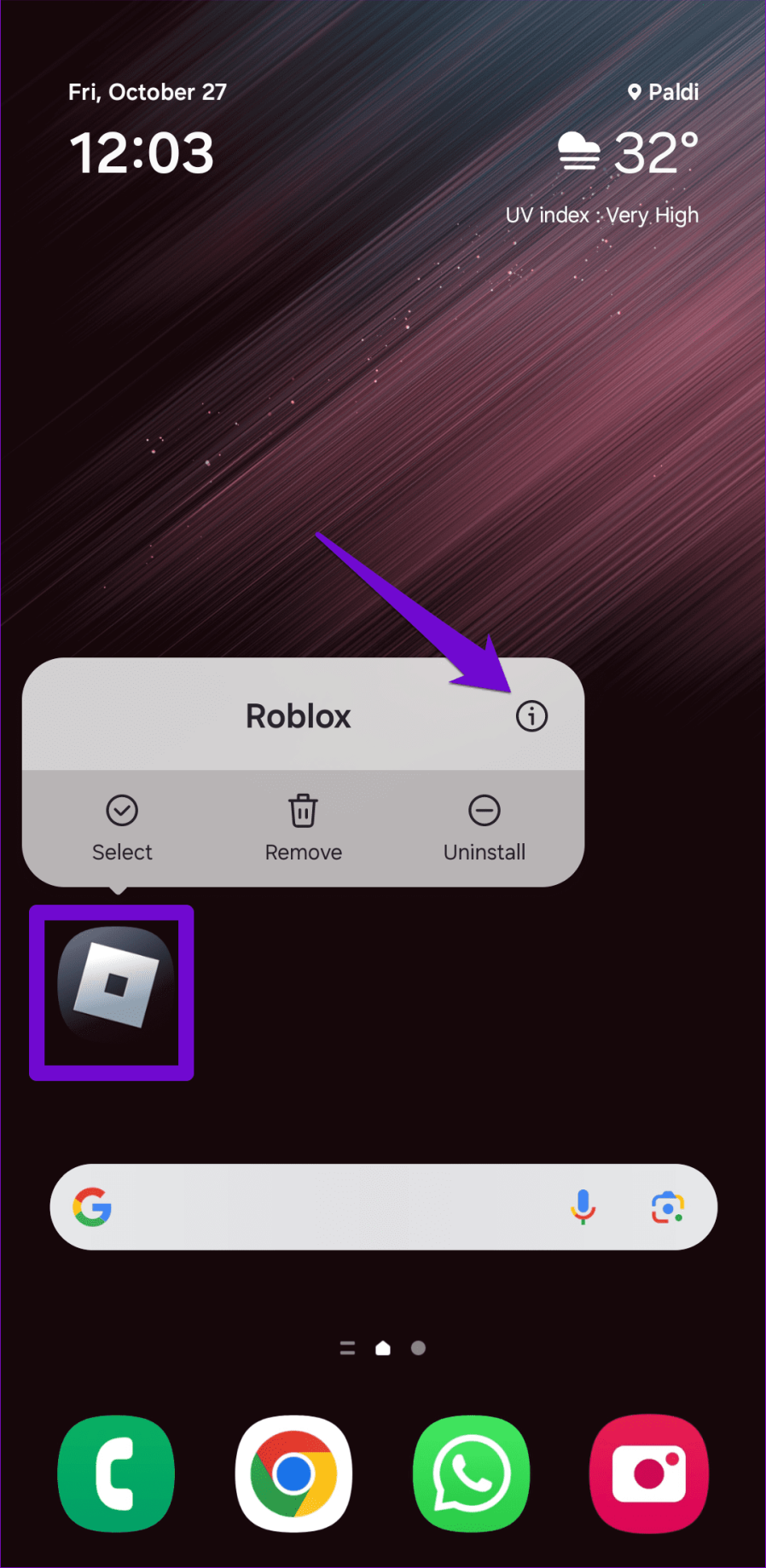

Андроид

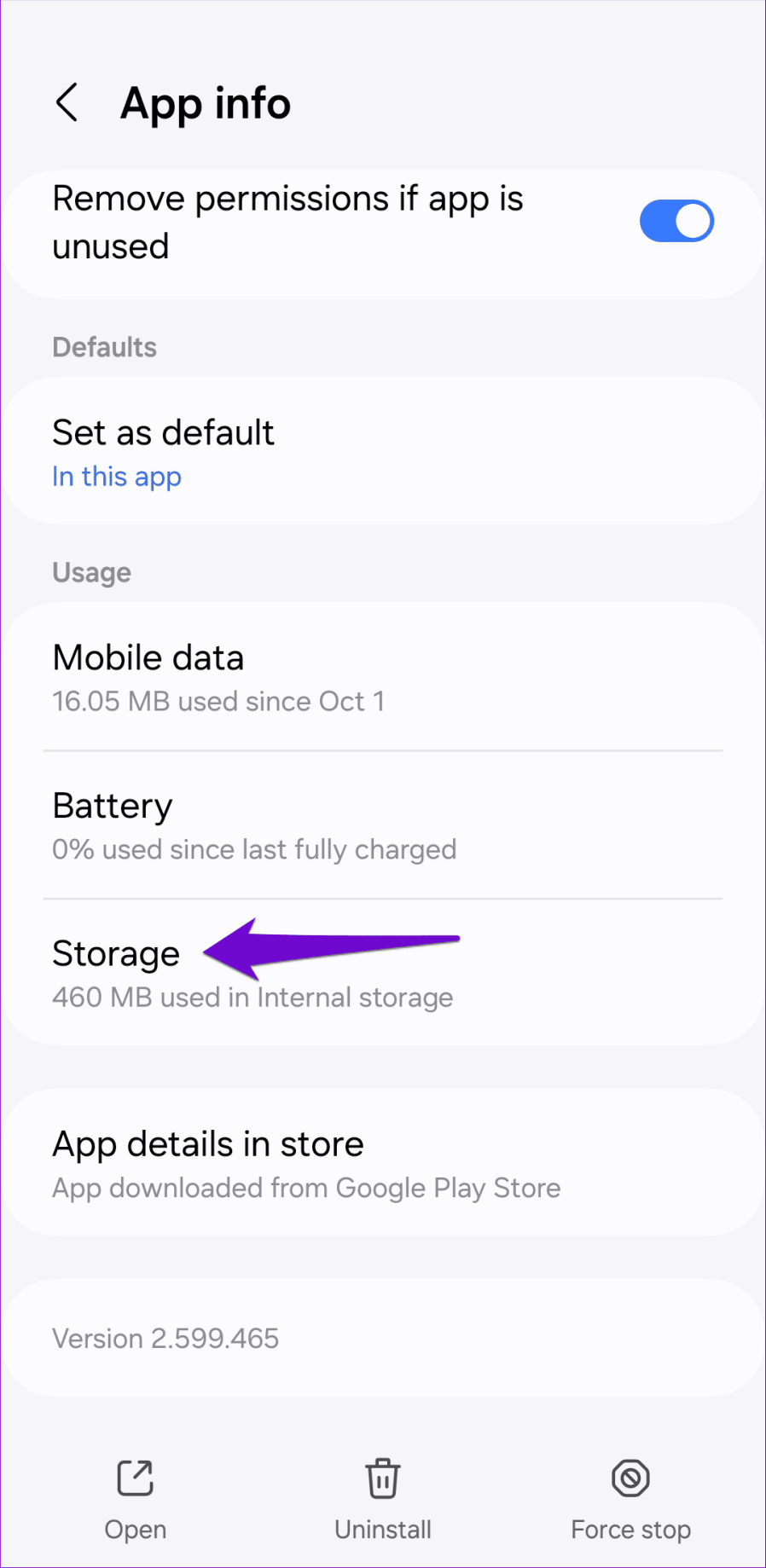

Шаг 1. Нажмите и удерживайте значок приложения Roblox на своем телефоне и коснитесь значка «i» в появившемся меню.

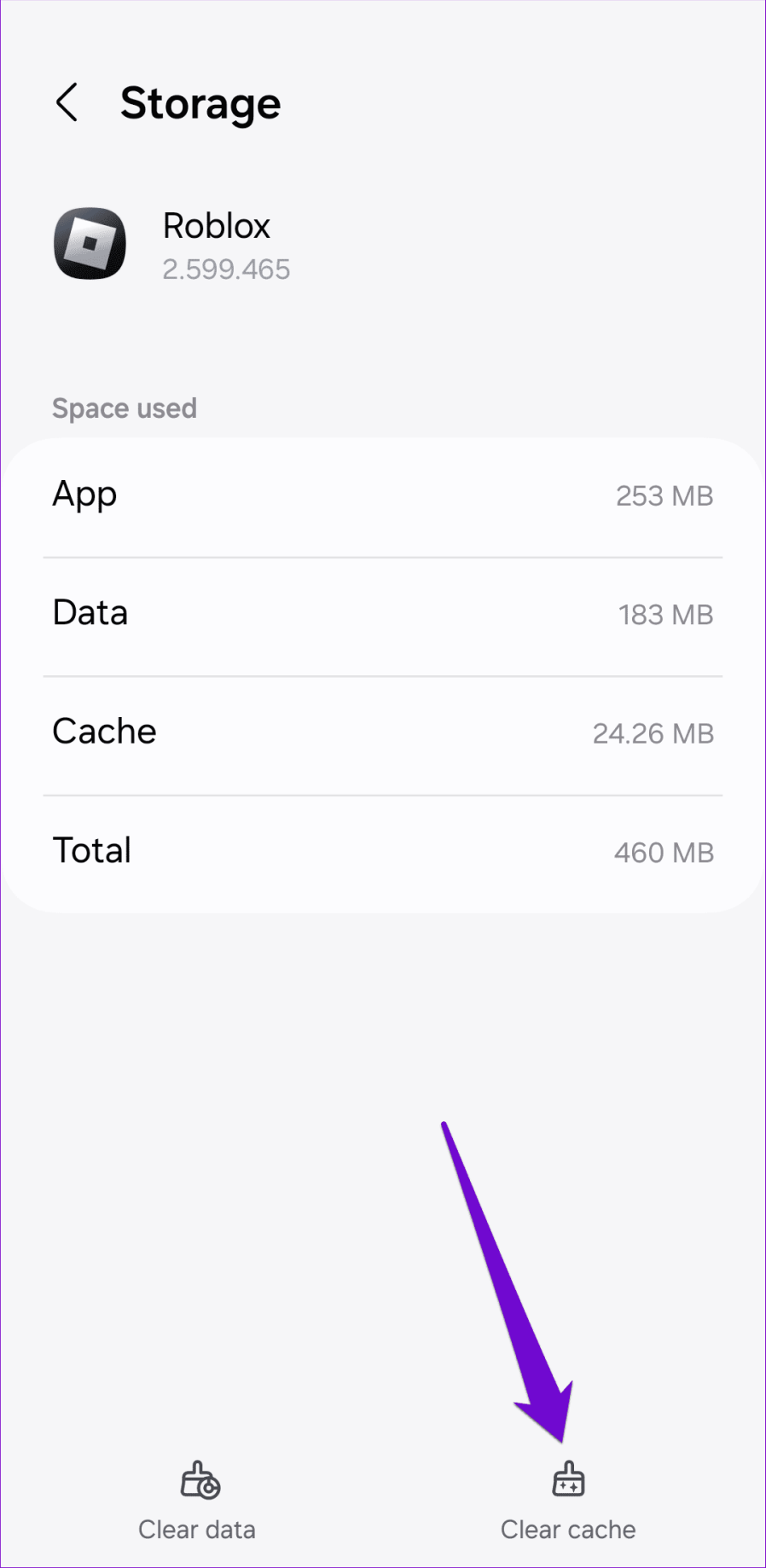

Шаг 2. Перейдите в «Хранилище» и нажмите «Очистить кэш».

Поскольку очистить кеш приложения Roblox на iPhone невозможно, вам придется удалить его и переустановить.

7. Переустановите Роблокс

Все еще не повезло? Вы можете попробовать удалить Roblox со своего устройства, а затем переустановить его. Это поможет вам избавиться от проблемных данных приложения, а также обновить приложение до самой последней версии.

Рабочий стол

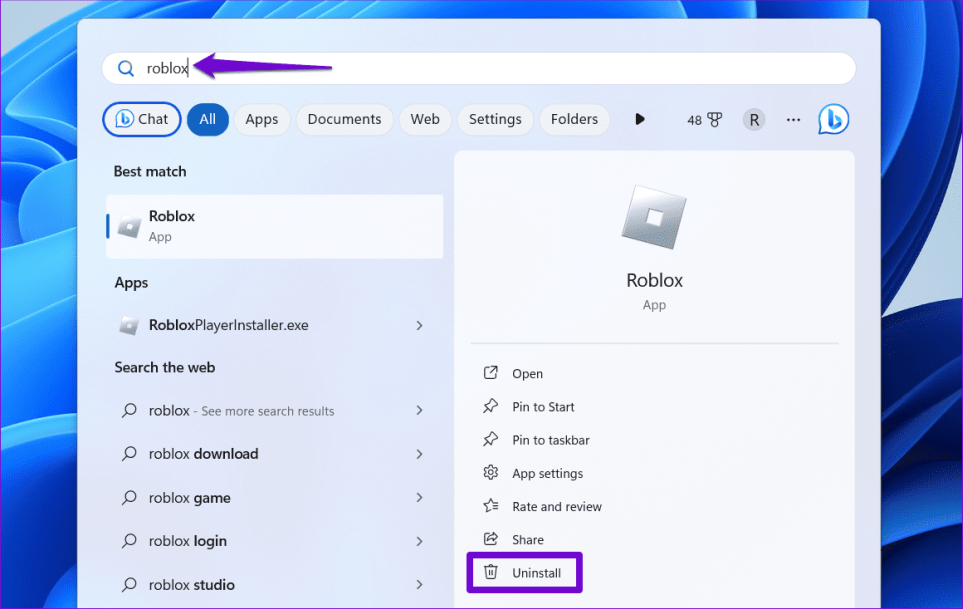

В Windows нажмите сочетание клавиш Windows+S, чтобы открыть меню поиска. Введите Roblox в поле поиска и выберите «Удалить».

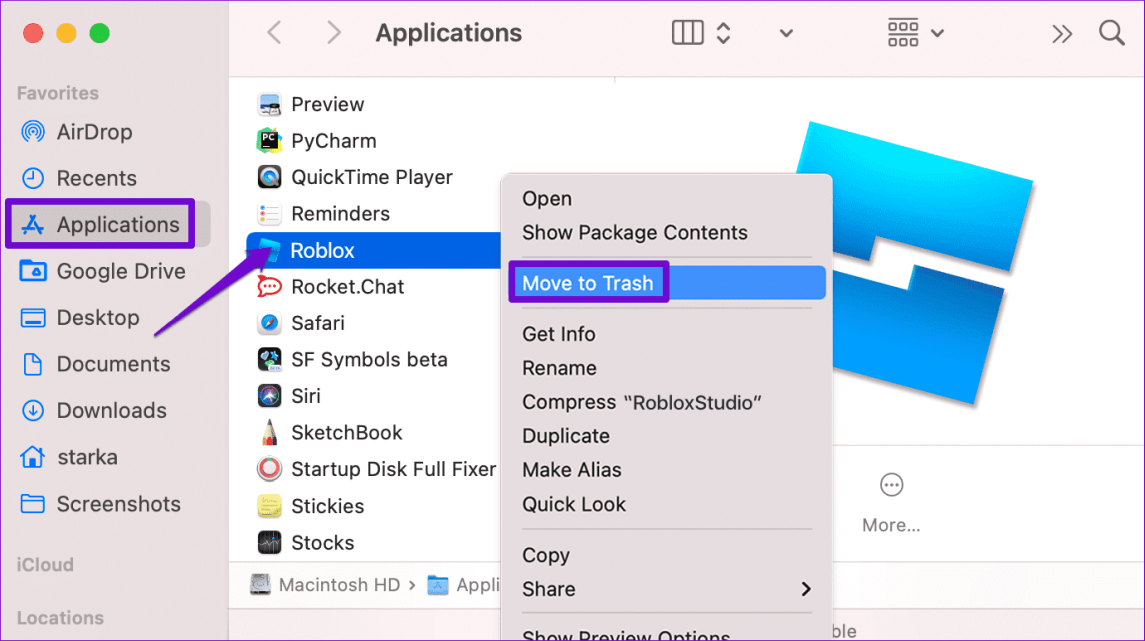

На Mac откройте приложение Finder и выберите «Приложения» на боковой панели. Щелкните правой кнопкой мыши приложение Roblox и выберите «Переместить в корзину».

мобильный

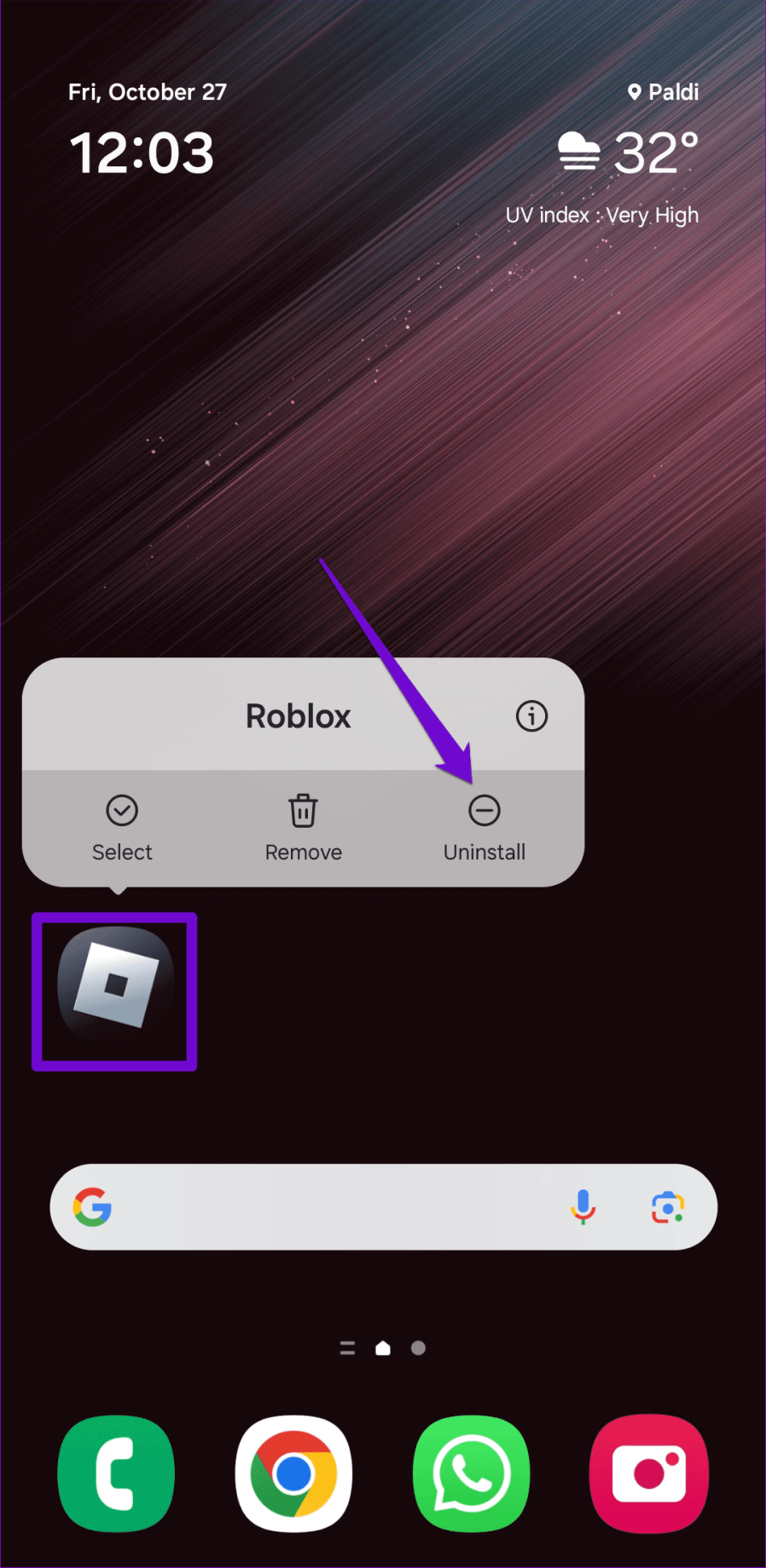

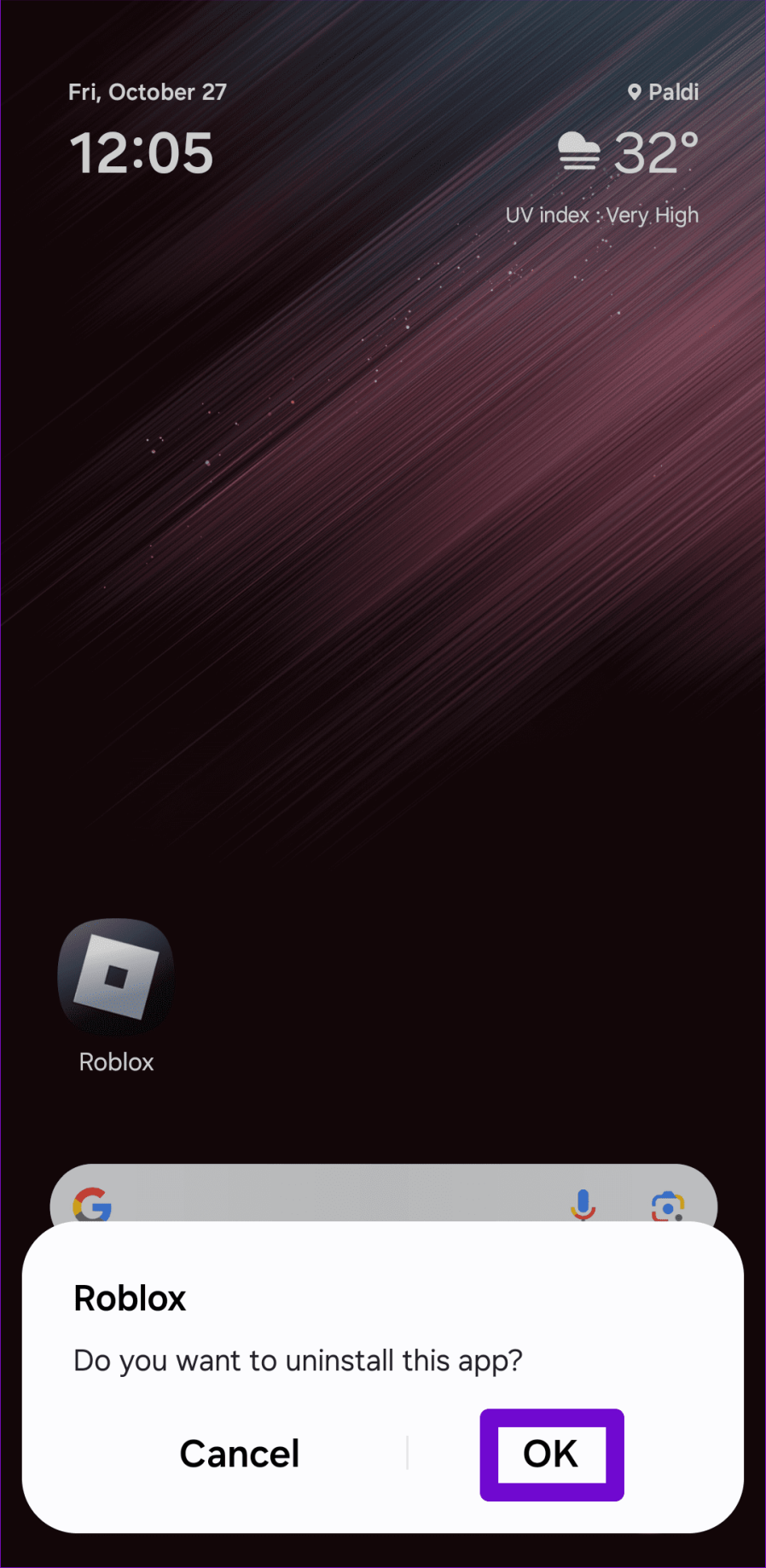

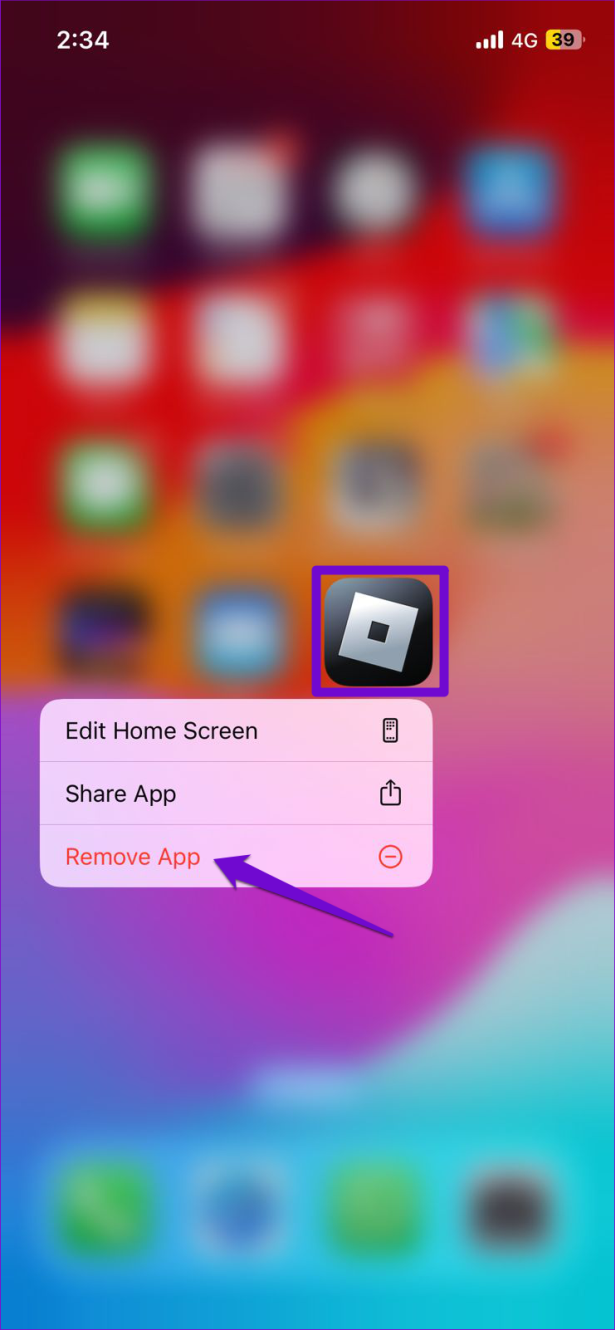

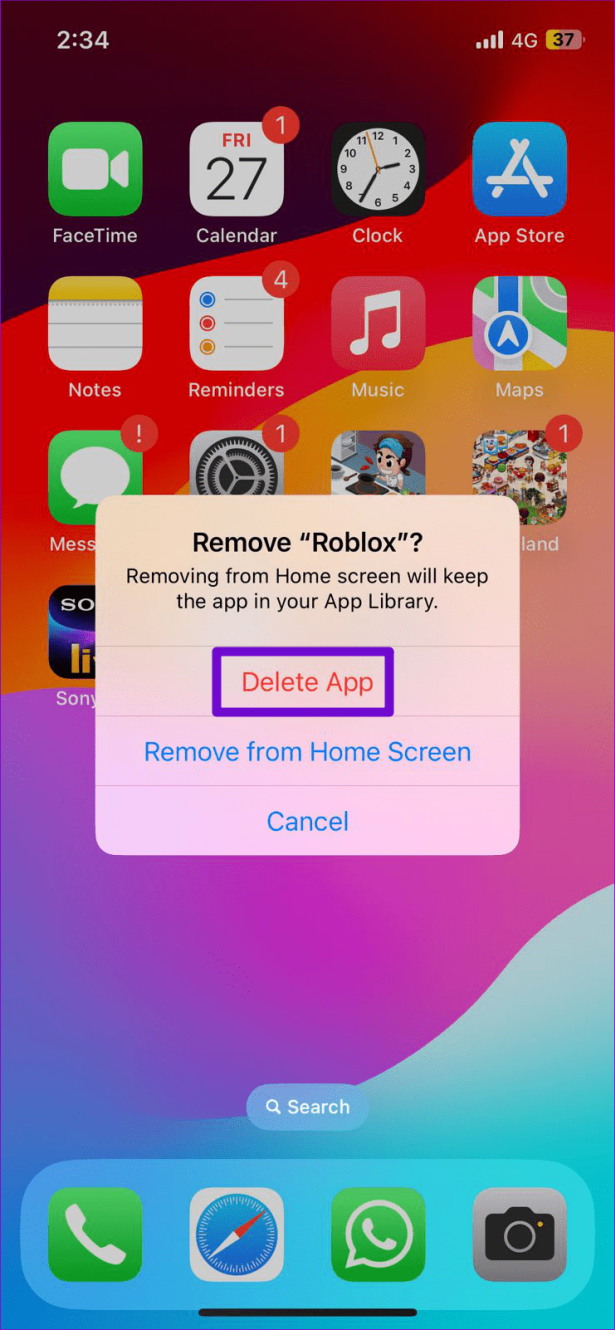

Чтобы удалить Roblox с Android, нажмите и удерживайте значок приложения и нажмите «Удалить». Затем нажмите «ОК» для подтверждения.

На iPhone нажмите и удерживайте значок приложения Roblox и выберите «Удалить приложение». Затем нажмите «Удалить приложение» для подтверждения.

Загрузите и установите Roblox на свой мобильный или настольный компьютер и проверьте, возникает ли проблема после этого.

Снова в действии

Без четкого индикатора того, что происходит не так, устранение проблемы с черным экраном Roblox может показаться хождением в темноте. Надеемся, что упомянутые выше советы помогут решить основную проблему и снова запустят Roblox на вашем компьютере или мобильном телефоне.