Иногда, из-за некачественного товара или ошибки продавца покупателям приходится открывать спор на Алиэкспресс. И даже если вы его выигрываете, то бывают случаи, что денежные средства все равно не поступают обратно на счет. В данной статье мы рассмотрим вопрос, что делать если спор закрыт, но деньги с AliExpress не вернулись. Читать

Архив автора: admin

unsnap, отличный инструмент для миграции Ubuntu с Snap на Flatpak

unsnap, инструмент для переноса пакетов snap в flatpak

Snap — это пакетная система, разработанная Canonical. для Ubuntu и может быть реализован в операционных системах, использующих ядро Linux и систему инициализации systemd.

Эта система пакетовs представлена как «универсальная» система, которую Canonical продвинула до такой степени, что в новых версиях, разработанных для Ubuntu, она оставила в стороне поддержку Flatpak и, таким образом, сделала ставку на все для своей системы пакетов.

Пример реализации Ledger API wallet. Что означает ошибка 503

Реализация Ledger API wallet позволяет использовать аппаратное кошелька Ledger для выполнения операций с криптовалютами и обеспечивает более высокий уровень безопасности для пользователей. Вот пример реализации Ledger API wallet на языке Python:

- Установка зависимостей: Установите необходимые зависимости, включая библиотеки Python для работы с Ledger API. Например, можно использовать библиотеку «ledgerwallet» для общения с аппаратным кошельком Ledger.

- Подключение к Ledger: Установите соединение с вашим аппаратным кошельком Ledger, используя соответствующий транспортный протокол, такой как USB или Bluetooth. Для этого может потребоваться использование специфических методов API, предоставляемых библиотекой.

- Выбор и инициализация криптовалютного протокола: Выберите конкретный криптовалютный протокол, с которым вы хотите работать (например, Bitcoin или Ethereum). Инициализируйте соответствующий протокол, используя методы API библиотеки.

- Создание транзакции: Создайте объект транзакции, указывая необходимые детали, такие как адрес получателя, сумму перевода и другие параметры, в зависимости от выбранного протокола.

- Подпись транзакции: При использовании аппаратного кошелька Ledger для безопасного хранения приватных ключей, подпишите созданную транзакцию, используя методы API библиотеки. Это обеспечит аутентификацию и подтверждение операции на аппаратном кошельке.

- Отправка транзакции: После успешной подписи транзакции отправьте ее в сеть криптовалюты, используя соответствующий метод API библиотеки. Транзакция будет включена в блокчейн и выполнена.

- Управление балансом и историей операций: Используйте методы API, предоставляемые библиотекой, для получения информации о балансе вашего кошелька, истории транзакций и других данных, связанных с вашим аккаунтом.

Приведенный выше пример является общей концепцией реализации Ledger API wallet и может варьироваться в зависимости от используемой библиотеки и выбранного языка программирования. Рекомендуется ознакомиться с официальной документацией и примерами, предоставляемыми библиотекой, для получения более подробной информации и специфических примеров реализации.

Вот пример кода на Python, демонстрирующий использование Ledger API для работы с аппаратным кошельком Ledger:

from ledgerwallet import LedgerWallet

# Подключение к аппаратному кошельку

wallet = LedgerWallet(transport='usb') # Используем USB-подключение, но может быть и другой тип транспорта

# Выбор протокола (например, Bitcoin)

wallet.select_app('Bitcoin')

# Получение адреса аккаунта

address = wallet.get_address("m/44'/0'/0'/0/0") # Пример пути BIP32

print("Адрес:", address)

# Создание транзакции

transaction = wallet.create_transaction(

inputs=[("transaction_id_1", 0)], # Пример входных данных транзакции

outputs=[("recipient_address", 0.01)] # Пример выходных данных транзакции

)

# Подписание транзакции

signed_transaction = wallet.sign_transaction(transaction)

# Отправка транзакции

transaction_id = wallet.send_transaction(signed_transaction)

print("Транзакция отправлена. ID:", transaction_id)

# Получение баланса

balance = wallet.get_balance()

print("Баланс:", balance)

Примечание: Приведенный выше код является общим примером и может потребовать настройки и изменений в зависимости от конкретной библиотеки, которую вы используете для взаимодействия с Ledger API. Убедитесь, что вы установили соответствующие зависимости и изучили документацию для выбранной библиотеки, чтобы правильно настроить и использовать API аппаратного кошелька Ledger.

Что делать если API Ledger выдает ошибку 503

Ошибка 503 обычно указывает на то, что сервис, предоставляющий API Ledger, недоступен. Если вы столкнулись с такой ошибкой, вот несколько действий, которые можно предпринять:

- Проверьте соединение с Интернетом: Убедитесь, что ваше устройство имеет стабильное подключение к Интернету. Попробуйте открыть другие веб-сайты или выполнить другие сетевые операции, чтобы убедиться, что проблема не связана с вашим интернет-соединением.

- Проверьте статус API Ledger: Проверьте официальные источники информации о статусе API Ledger, такие как официальный сайт или официальные каналы в социальных сетях. Возможно, проводятся обслуживание или обновление, что может вызывать временную недоступность.

- Повторите запрос позже: Если причина ошибки 503 связана со временной недоступностью сервиса, попробуйте повторить свой запрос через некоторое время. Вероятно, проблема будет устранена, и сервис станет снова доступным.

- Свяжитесь с поддержкой: Если проблема с ошибкой 503 продолжается или вы не нашли информацию о временной недоступности сервиса, обратитесь в службу поддержки Ledger. Они могут предоставить вам более подробную информацию о проблеме и помочь вам найти решение.

Важно отметить, что ошибка 503 может быть вызвана временными проблемами и может быть вне вашего контроля. В таких случаях необходимо ожидать, пока сервис не восстановится или не получить дальнейшие инструкции от поддержки.

Источник: cryptoblog.pro api

Python 3. Классы и ООП

В этой статье разбираем классы в Python 3 и программирование в стиле ООП. А также узнаем про методы, наследование, полиморфизм и другое.

Фьючерсы на биткоин — что это такое, для чего нужны и как на этом заработать?

Биткоин-фьючерс представляет собой контракт на покупку или продажу актива в будущем по определенной цене. После заключения контракта стороны обязаны выполнить его условия вне зависимости от рыночной цены на дату истечения фьючерса.

Это позволяет инвесторам воспользоваться преимуществами потенциального изменения цен без необходимости владеть реальными биткоинами, а также использовать «кредитное плечо». Например, если вы считаете, что цена биткоина в будущем будет выше, вы можете приобрести «длинный» контракт и заработать деньги, когда цена актива вырастет.

Где можно торговать фьючерсами на биткоин?

Лучшей платформой для торговли биткоин-фьючерсами является Binance Futures от крупнейшей криптовалютной биржи Binance. Помимо нее еще существуют специализированные платформы CME и CBOE в США, но они жестко регулируются американскими законами, что фактически закрывает доступ к ним для инвесторов и трейдеров из Европы и СНГ.

Особенностью Binance Futures являются гораздо менее жесткие KYC-процедуры и требования политики AML — можно не указывать личные данные и оставаться анонимным. Кроме того, на платформе Binance Futures намного ниже порог для входа, а это значит, что они доступны не только для крупных инвесторов, но и для обычных пользователей.

Также платформа Binance Futures позволяет торговать с минимальными комиссиями и кредитным плечом x125.

Официальный сайт платформы https://www.binance.com/ru/futures/

ВНИМАНИЕ! В связи с ограничениями для пользователей из РФ, с сентября 2023 года Binance предоставляет для России отдельную платформу CommEX с поддержкой полного функционала и ликвидности основной площадки.

Официальный сайт платформы: https://commex.com

Как начать торговать фьючерсами на Binance Futures?

Что бы торговать биткоин-фьючерсами на крупнейшей бирже мира Binance вам понадобится завести аккаунт на данной площадке — процесс регистрации на этой бирже довольно простой и не должен вызывать затруднений. Торговля на Binance Futures возможна без верификации основного аккаунта Binance.

Ссылка для регистрации на официальном сайте Binance Futures с активированной скидкой 10% на все торговые комиссии https://www.binance.com/.

ВНИМАНИЕ! В связи с ограничениями для пользователей из РФ, с сентября 2023 года Binance предоставляет для России отдельную платформу CommEX с поддержкой полного функционала и ликвидности основной площадки.

Официальный сайт платформы: https://commex.com

В верхнем навигационном меню есть кнопка «Фьючерсы». Нажмите на нее и выберите опцию «Фьючерсы».

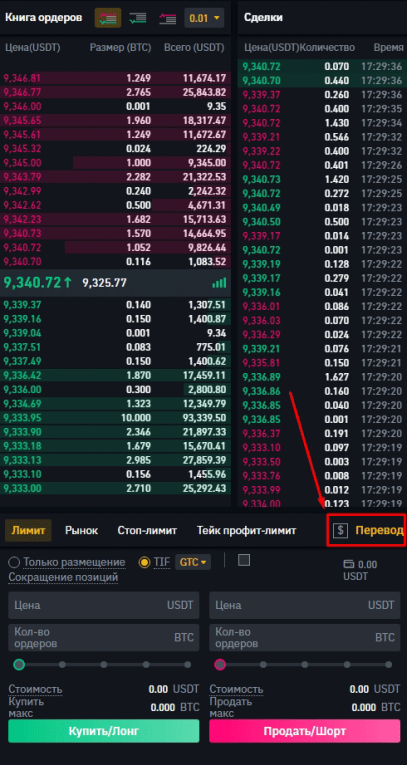

Справа внизу, под книгой ордеров, есть отдельное меню с кнопкой «Открыть счет». Нажав на эту кнопку вы подтвердите создание фьючерсного счета. После этого вы увидите меню ордеров для открытия длинных и коротких позиций. Чтобы начать торговать фьючерсами, вам необходимо перевести USDT на свой фьючерсный счет.

Сделать это довольно просто. Для этого нужно назать кнопку «Перевод». В новом окне вас спросят, сколько USDT вы хотите перевести. Просто укажите сумму и нажмите кнопку «Подтвердить перевод». Передача происходит автоматически и без комиссии; для смены направления перевода нужно просто нажать соответствующую кнопку между кошельками.

Для чего нужны фьючерсы?

Фьючерсы на биткоин — это относительно новый вид инвестиций, который набирает обороты в финансовом мире. Они являются разновидностью деривативов, что означает, что они получают свою стоимость от базового актива — в данном случае биткоина. Инвестируя во фьючерсы на биткоин, вы можете спекулировать на будущей цене биткоина, фактически не владея им.

С фьючерсами трейдер может открывать как длинные, так и короткие позиции, используя эффект кредитного плеча. Последнее подразумевает высокую доходность сделок, равно как и повышенный риск.

Однако изначально фьючерсы были придуманы как инструмент хеджирования ценовых рисков. Таким образом, посредством фьючерсов можно также снижать риски неблагоприятных ценовых колебаний на различные активы.

Например, основной риск для биткоин-майнеров — падение цены криптовалюты до уровня, при котором ее добыча становится нерентабельной, то есть затраты на электроэнергию превышают доход от добываемых монет.

Чтобы обезопасить свой бизнес, майнер может продавать фьючерсы на количество имеющихся биткоинов. Если курс криптовалюты существенно снизится, то фьючерс даст возможность нивелировать убытки от снижения цены актива прибылью от короткой сделки.

Какие бывают виды фьючерсов?

Фьючерсы бывают поставочными и расчетными. Первые предполагают, что на дату истечения (экспирации) контракта покупатель должен купить, а продавец — продать базовый актив в количестве, указанном в спецификации к нему.

В качестве примера поставочных фьючерсов можно привести срочные контракты на нефть или пшеницу. Однако и тут в подавляющем в большинстве случаев сделки проводятся без фактической поставки базового актива, то есть являются сугубо спекулятивными.

Также операции с поставочными фьючерсами часто бывают хеджирующими, другими словами, направленными на минимизацию ценовых рисков. Таким образом, большинство поставочных фьючерсов закрываются до даты экспирации.

Расчетные фьючерсы изначально не предполагают поставку базового актива, а лишь денежный расчет в сумме разницы между ценой контракта и стоимостью актива на дату исполнения. Такие инструменты также в основном используются для спекулятивных целей и для хеджирования ценовых рисков.

В чем особенность фьючерсов на биткоин?

Фьючерсные контракты могут быть на самые различные активы — ценные бумаги, фондовые индексы, биржевые товары и криптовалюты. В целом фьючерсы на биткоин мало чем отличаются от других срочных контрактов, они также позволяют делать ставки на рост или снижение цены в будущем.

Отметим, что можно торговать срочными контрактами на BTC, не обладая самой криптовалютой, а лишь спекулируя на ее цене. Именно так, в частности, происходят сделки на таких известных биржах, как CME и CBOE, ориентированных в основном на крупных инвесторов.

Однако на готовящейся к запуску торговой платформе Bakkt будут представлены фьючерсы, предполагающие поставку физического биткоина после истечения контракта.

Что такое спецификация фьючерса?

Это утвержденный биржей документ, в котором закреплены все условия фьючерсного контракта, включая:

- название контракта;

- сокращенное его наименование или тикер (например, XBT на бирже CBOE или BTC — на CME);

описание; - размер контракта (например, для CBOE это 1 BTC, для CME — 5 BTC);

- тип (поставочный или расчетный);

- минимальный шаг цены (например, на CBOE это пять пунктов, что в паре USD/XBT соответствует $5);

- дата поставки и сроки обращения контракта и т. д.

Что такое экспирация фьючерса?

Это прекращение обращения контракта на бирже. В день экспирации исполняются обязательства по фьючерсу — осуществляются взаимные расчеты между участниками сделки посредством уплаты разницы в ценах (вариационной маржи), либо производится поставка базового актива.

Дата экспирации прописывается в спецификации к фьючерсу.

Что такое начальная, поддерживающая и вариационная маржа?

Депозитная или начальная маржа — возвращаемый гарантийный взнос, взимаемый биржей при открытии позиции по фьючерсу. Другими словами, это сумма, необходимая для открытия позиции. Обычно составляет 2-10 % от текущей рыночной стоимости базового актива.

Однако в случае с фьючерсами на биткоин, ввиду частых периодов высокой волатильности, размер начальной маржи гораздо выше в сравнении с традиционными финансовыми инструментами. Так, на CME и CBOE он превышает 40%.

Начальная маржа взимается с продавцов и покупателей и призвана защитить брокера от риска неисполнения обязательств по сделке.

Поддерживающая маржа — это сумма, необходимая на счете, чтобы позиция сохранялась открытой во избежание срабатывания маржин-колла (принудительного закрытия позиции брокером, которая влечет за собой фиксацию убытка трейдера и резкое уменьшение его баланса).

Доступ к платформам CME и CBOE предоставляют брокеры (например, TD Ameritradeи Interactive Brokers). Эти компании могут устанавливать свои размеры маржинальных требований, которые могут быть больше, чем у биржи. Например, американский брокер E-Trade установил маржинальные требования для биткоин-фьючерсов на уровне 80%.

Есть также термин вариационная маржа. Это сумма денег, которая представляет собой прибыль или убыток от открытых или закрытых контрактов. Итоговое значение вариационной маржи рассчитывается по результатам торговой сессии.

Что такое контанго и бэквордация?

До даты экспирации цены контракта и базового актива, как правило, различаются. По мере приближения даты исполнения фьючерса разница в ценах уменьшается.

Предположим, что до исполнения цена фьючерса выше стоимости базового актива. Такая ситуация называется контанго (англ. Contango, что дословно означает «надбавка к цене»). В данном случае участники рынка уверены в росте цены актива в будущем. Контанго может возникать, например, перед уполовиниванием награды за блок, накануне возможного одобрения биткоин-ETF или запуска платформы Bakkt.

Если же цена фьючерса ниже рыночной стоимости актива — это бэквордация (от англ. Backwardation — «запаздывание»). Это значит, что на рынке преобладают медвежьи настроения.

Как фьючерсы могут влиять на курс биткоина и криптоиндустрию в целом?

Многие эксперты уверены, что появление биткоин-фьючерсов на традиционном рынке способствует массовому принятию и популяризации криптовалют, поскольку мейнстрим-инвесторы станут менее скептично воспринимать криптовалюты. Это, в свою очередь, может стимулировать спрос и положительно влиять на цену и капитализацию рынка в долгосрочной перспективе.

Появление традиционных финансовых инструментов на базе биткоина фактически означает его признание регуляторами как объекта инвестиций. То, что биткоин-фьючерсы набирают популярность на жестко регулируемом и самом крупном в мире американском рынке, может послужить примером для финансовых институтов из других стран. Помимо прочего, в юрисдикциях, где торговля криптовалютой запрещена, фьючерсы позволяют спекулировать на цене лежащих в их основе цифровых активов.

С другой стороны, у крупных участников рынка появилась возможность открытия коротких позиций, большой объем которых может оказывать давление на цену биткоина. Однако топ-менеджер Чикагской товарной биржи (CME) Тим Маккорт считает, что фьючерсы не влияют на цену биткоина, поскольку срочные контракты на BTC пока представляют лишь небольшую часть рынка. С ним солидарен знаменитый трейдер Питер Брандт, который убежден, что не стоит недооценивать влияние на рынок со стороны огромного числа мелких биткоин-инвесторов.

В то же время поставочные фьючерсы на Bakkt могут послужить дополнительным фактором спроса на биткоин. Кроме того, с развитием этого рынка возрастает вероятность, что SEC все же, наконец, одобрит привязанные к биткоин-фьючерсам биржевые фонды (ETF).

Существует также мнение, что фьючерсы на биткоин способствуют снижению волатильности его цены.

Как бы то ни было, интеграция криптовалютного рынка с традиционным может в потенциале способствовать массовому принятию новых активов, а значит и долгосрочному их росту.

Как можно спрогнозировать цену BTC на основании отчета по фьючерсам?

Фьючерсный контракт можно заключить на что угодно — на товар, ценные бумаги, валюту и, в том числе, криптовалюту. Их также можно перепродавать другим. На данный момент крипторынок преимущественно довольствуется фьючерсами на биткоин, хотя нельзя исключать, что в будущем мы можем увидеть и фьючерсы на Ethereum. Пока контракты на эфир не одобряют регуляторы.

В то же время биткоин-фьючерсы уже уверенно торгуются на биржах CBOE и CME. Правда, эти инструменты не предполагают реальной покупки по ним биткоина, все расчеты по ним идут в фиате. То есть вы либо выигрываете, либо проигрываете на разнице курса в валютном эквиваленте, не получая настоящие биткоины на свой кошелек. И при покупке фьючерса у того, кто заключил его раньше, вы приобретаете не биткоин, а лишь контракт на него.

Зачем нам наблюдать за фьючерсами?

Теперь, когда мы знаем логику, которая стоит за заключением фьючерсных контрактов, становится понятно, почему важно за ними следить. Очевидно, что если большое количество крупных игроков одновременно открывает шорт — значит, стоит задуматься о возможной скорой просадке на рынке. И наоборот, когда киты начинают переплывать в лонг-позиции, можно ожидать разворота.

Также по тому, в каких объемах продают или покупают фьючерсы, можно оценить уровень интереса к самому биткоину, что может отразиться на рыночной цене актива.

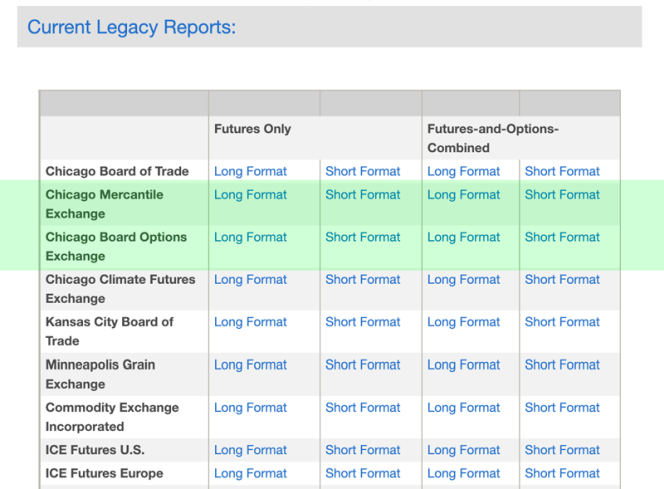

Куда смотреть?

Фьючерсные отчеты регулярно публикует Комиссия по срочной биржевой торговле (CFTC), один из главных финансовых регуляторов США. Именно поэтому, кстати, сейчас трейдеры остались без этого инструмента — в результате так называемого «шатдауна» работа американского правительства заблокирована.

Пока правительство не придет по определенным вопросам к соглашению с президентом Дональдом Трампом, регуляторы не смогут продолжить работу, а значит и отчетов мы не увидим. Самое время для тех, кто их еще не анализировал, поднабраться знаний и подойти к новому отчету во всеоружии!

Отчеты Комиссии можно найти на официальном сайте ведомства. Обычно они выходят в пятницу около 15:30 по североамериканскому восточному времени. В праздничные дни отчеты переносятся. Во вкладке по ссылке выше мы проматываем страничку вниз до списка площадок. Нам нужны отчеты в Long format от CME и CBOE.

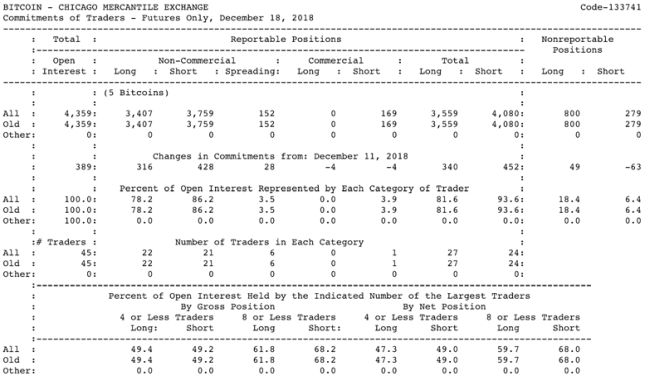

По клику на нужный формат мы получим целый список отчетов, среди которых нам нужен конкретно биткоин (для экономии времени ищем его через поиск по странице — Ctrl+F). Вот как выглядит последний отчет от 18 декабря:

Выглядит пугающе, но на деле смысл каждой колонки достаточно прост. Давайте пройдемся по их списку:

Open Interest — общее количество открытых контрактов, каждый контракт — 5 BTC. После него идут позиции, по которым есть данные, подходящие под регламент отчета Комиссии.

Non-Commercial — это позиции крупных игроков, которые не заполняют форму CFTC-40. Как правило сюда попадают спекулянты и хедж-фонды. Посмотрим на содержимое раздела. Если с понятием лонгов и шортов мы уже познакомились выше, то Spreading — это что-то новое. В эту колонку заносятся перекрывающиеся позиции у одних и тех же участников рынка.

Например, у одного и того же спекулянта открыты 100 лонг-позиций и 50 шорт-позиций. В таком случае разница в количестве позиций будет занесена в нужную колонку (50 контрактов в данном случае учтены в лонг). При этом еще 50 лонг- и шорт-контрактов будут внесены в отчет как 50 spreading-контрактов. Одновременно и шорт- и лонг-позиции трейдер как правило открывает, если хочет застраховаться от возможных убытков.

Commercial — это официальные крупные игроки-институционалы, которые обязаны заполнять форму CFTC-40.

Total (Общая сумма) суммирует все позиции с учетом спрединга.

Nonreportable positions — это мелкие игроки рынка, данные по которым не попадают под типовой формат отчетности Комиссии. Иронично, что в подавляющем большинстве случаев они обманываются в своих ожиданиях по рынку.

Changes in commitments — это разница в числе разных позиций по сравнению с прошлой неделей. В приведенном отчете, например, видим, что институционалы на этой неделе закрыли четыре лонга и шорта. Если при этом растет спрединг — значит, держатели контрактов не очень уверены в своей позиции и хотят подстраховаться.

Percent of Open Interest — показывает соотношение лонгов и шортов в процентах, считается с учетом спрединга.

Ниже — количество трейдеров в каждой категории, в Spreading тут попадают те игроки, у которых открыты и лонги, и шорты.

Последние строки отчета рассказывают нам о том, какое количество контрактов в процентном соотношении в конкретной категории сосредоточены в руках четырех и менее трейдеров и восьми и менее трейдеров. Это позволяет нам оценить, насколько «разжирели» на рынке киты и сколько именно контрактов они прибрали к рукам.

Как анализировать эти данные?

Конечно, самое интересное — это изменение в числе открытых и закрытых позиций от недели к неделе. Уже по этим движениям можно многое предположить по тому, куда пойдет рынок, и будет ли вообще какое-то значительное движение в ближайшем будущем.

Также очень интересно наблюдать за моментами, когда большое количество позиций какой-либо направленности собирается в одних руках. Это может говорить о том, что крупная рыба что-то знает о грядущих событиях в своем пруду и реагирует заранее. Особенно часто подобными инсайдами славятся институционалы.

Разная динамика цифр может намекать на очень различные сценарии, поэтому оцениваем данные в комплексе, стараемся смотреть на всю картину целиком.

Сообщение Фьючерсы на биткоин — что это такое, для чего нужны и как на этом заработать? появились сначала на Майнинг Криптовалюты.

Источник: mining-cryptocurrency.ru

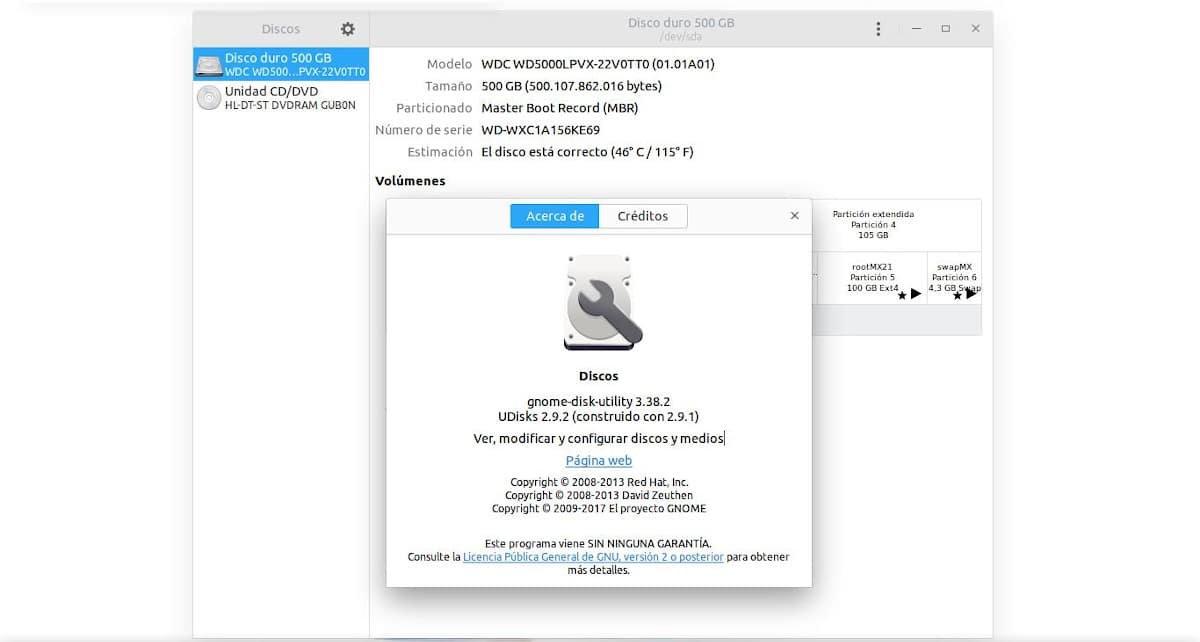

GNOME Disk: полезный менеджер разделов для GNU/Linux.

GNOME Disk: полезный менеджер разделов для GNU/Linux.

Когда дело доходит до GNU/Linux, все еще многие считают, что проблемы ранних лет все еще сохраняются. Хорошим примером этого является, прежде всего, отсутствие возможности иметь, играть и наслаждаться высококачественными игровыми приложениями, которые многие из нас уже знают, что это в значительной степени преодолено, и что существующий разрыв все больше и больше сокращается. каждый день. . Однако в более мелких и технических вещах хорошим примером этого является возможность легко и быстро управлять нашими дисками, устройствами хранения и их соответствующими разделами.

Но правда в том, что и этот момент уже вполне преодолен. Поскольку существуют различные приложения для управления дисками и накопителями, которые могут быть как для одной среды рабочего стола, так и для нескольких. В моем случае я использую многое в дополнение к Format USB (From MX Linux), чтобы быстро отформатировать любой USB-накопитель, который я использую на своем компьютере, чтобы «ГНОМЕДиск» (Дисковая утилита GNOME) на английском языке или Диски (Дисковая утилита для GNOME) на испанском языке для любых нужд, связанных с моими IDE, SATA, SCSI, USB-накопителями и многим другим. По этой причине сегодня эта публикация будет посвящена тому, чтобы узнать, что нового об этом, спустя более 7 лет с момента последнего раза.