Приветствую, уважаемые читатели на третьей части цикла!

В прошлый раз мы установили и настроили Систему виртуализации Proxmox-VE.

Список цикла статей:

- Домашний Сервер: Часть 1 – Предисловие, аппаратная и софтовая начинка

- Домашний Сервер: Часть 2 – Установка системы виртуализации Proxmox

- Домашний Сервер: Часть 3 — Внутренний DNS или свои доменные имена в локальной сети (вы тут)

- Домашний Сервер: Часть 4 – Настройка Transmission daemon в контейнере LXC Proxmox-VE

- Домашний Сервер: Часть 5 – Установка и настройка Plex Media Server в контейнере LXC Proxmox-VE

Предисловие

В данной статье мы установим отдельный контейнер LXC, я кратко расскажу чем контейнеры отличаются от обычных виртуальных машин.

Установим и настроим сервис для обработки доменных имен в своей локальной сети BIND9

Настроим роутер(MikroTik) и сеть для того, чтобы наши устройства в локальной сети могли находить наши доменные имена.

И для примера настроим наш PVE1(сам сервер) для доступа к нему по доменному имени, а не IP адресу.

Для чего вообще это делать?

В общих чертах это не обязательно, но намного приятнее обращаться к своим сервисам по привычному доменному имени, а не IP адресу.

Например к медиасервису Plex я обращаюсь по адресу plex.gregory-gost.ru, а не 192.168.88.8:32400/web. Согласитесь удобнее 🙂

Вроде ничего не упустил 🙂 Кому интересно прошу далее под кат!

Текста много, предупреждаю сразу 😉

Установка контейнера LXC в Proxmox-VE

Для того, чтобы наш DNS сервис работал самостоятельно и не зависел от наших попыток, что-то сломать сделать, я его установил в отдельный LXC контейнер(виртуальную среду).

Что такое LXC контейнер?LXC (англ. Linux Containers) — система виртуализации на уровне операционной системы для запуска нескольких изолированных экземпляров операционной системы Linux на одном узле. LXC не использует виртуальные машины, а создаёт виртуальное окружение с собственным пространством процессов и сетевым стеком. Все экземпляры LXC используют один экземпляр ядра операционной системы.

В чем отличие обычной Виртуальной машины от LXC контейнера?

Подробно разбирать не буду, к данной статье это не относится. Просто для справки опишу основное отличие:

Контейнер использует ядро операционной системы сервера. У виртуальной машины может быть совершенно отличное ядро. Для лучшего понимания — в виртуальной машине можно запустить почти все, от Windows, до специфических Linux систем, а в контейнере можно запустить только Linux систему с тем же ядром, Windows уже не запустишь.

Начнем мы с добавления в наш сервер специального шаблона(Template) операционной системы. В Proxmox их можно скачать из своих репозиториев.

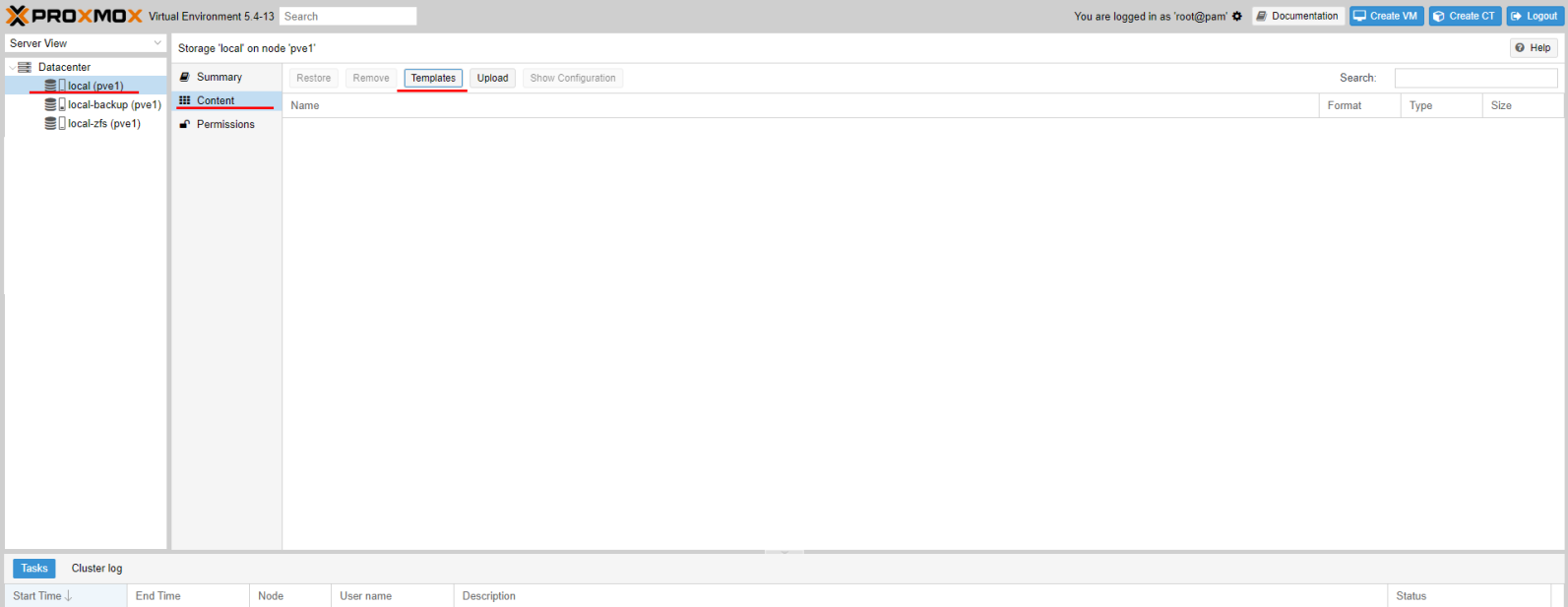

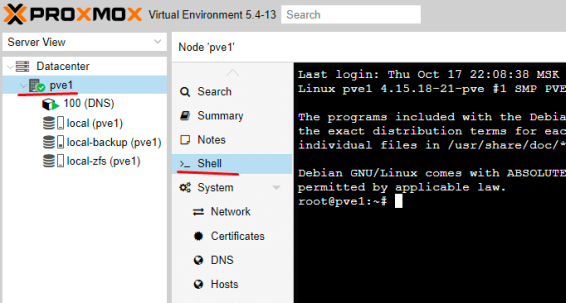

Откроем панель управления через WEB по IP адресу. И перейдем к нашему хранилищу Local(pve1), потом переходим к содержимому(Content) и нажмем кнопку Шаблоны(Templates)

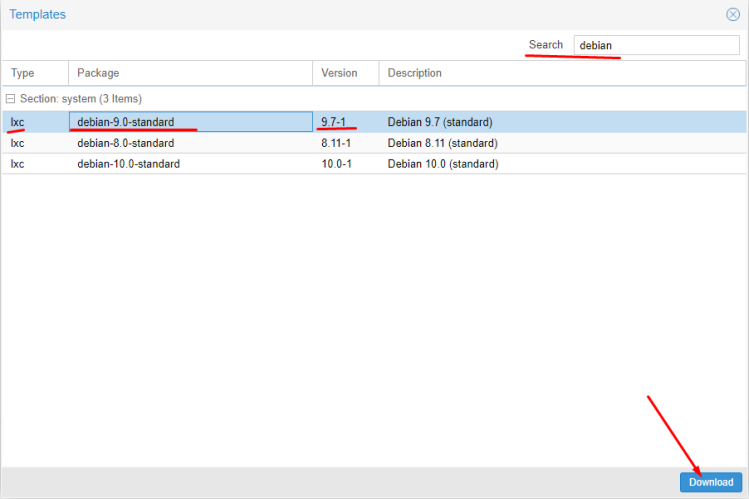

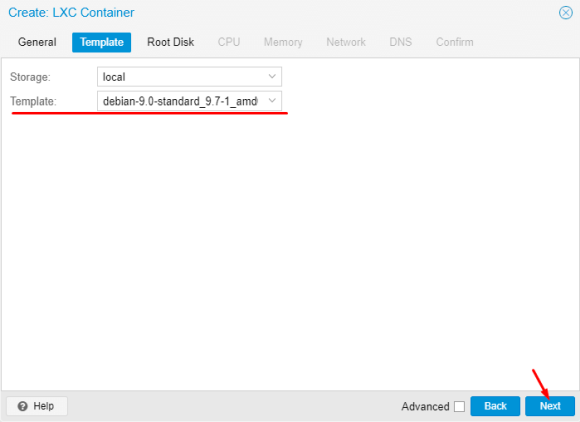

Т.к. наш Proxmox основан на ОС Debian, то я принял для себя решение использовать LXC Debian 9 версии. Мне с ними удобнее работать. Если опыт вам позволяет, то вы можете использовать и другие дистрибутивы, благо выбор позволяет. В 17 версии Proxmox доступен также Alpine, который используют практически во всех Docker контейнерах, как один из самых легковесных.

Находим нужный шаблон и грузим его.

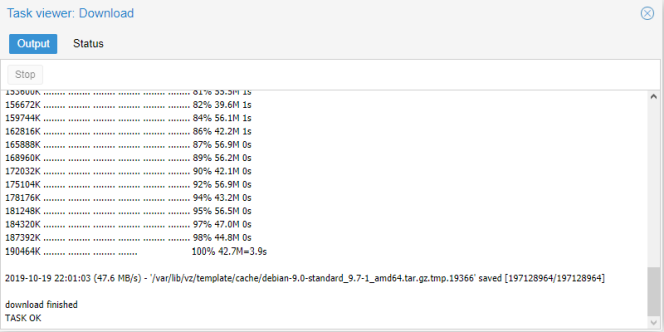

Нам остается только подождать окончания загрузки.

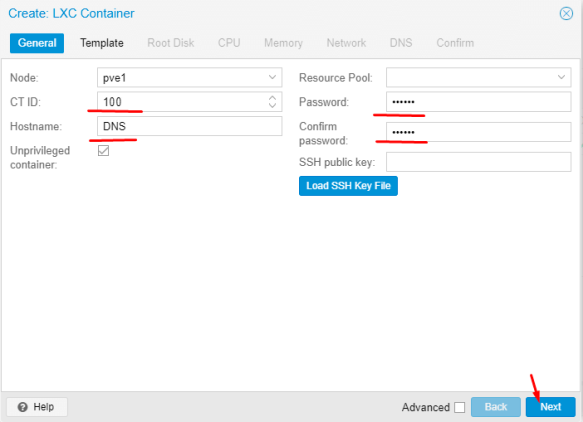

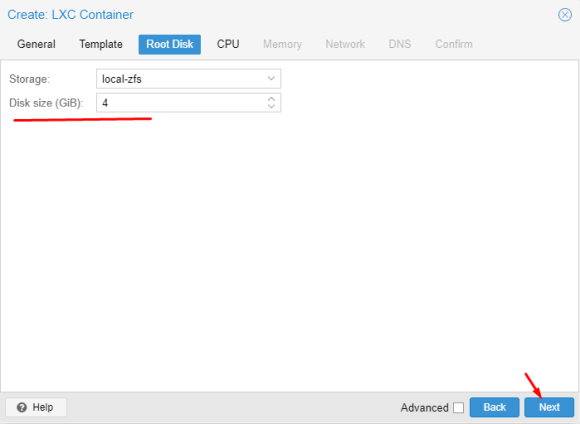

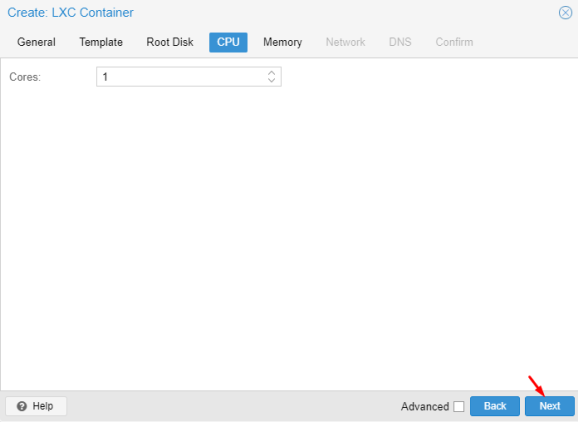

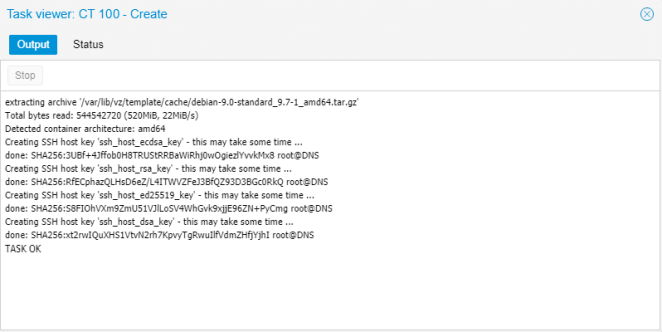

Начинаем установку.

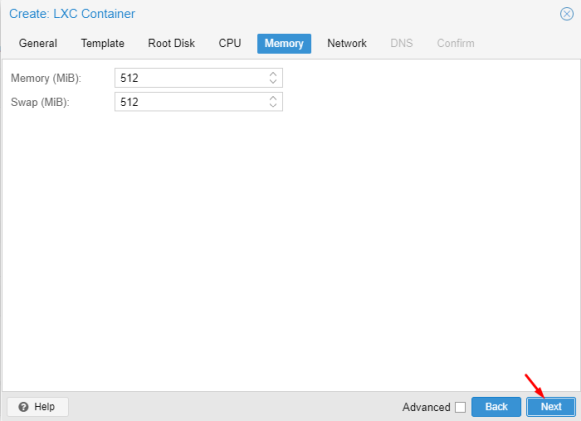

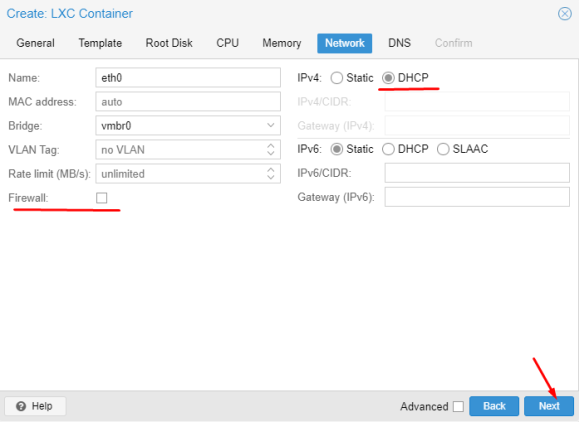

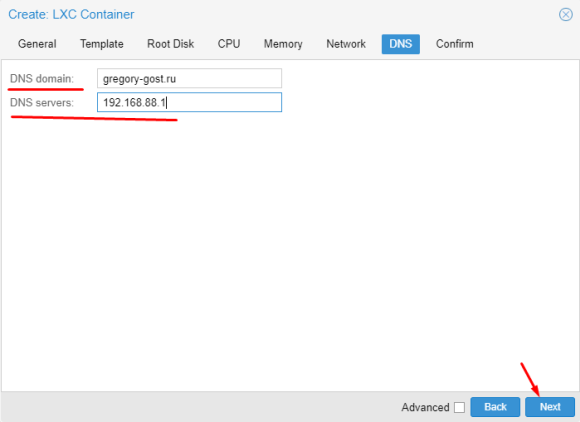

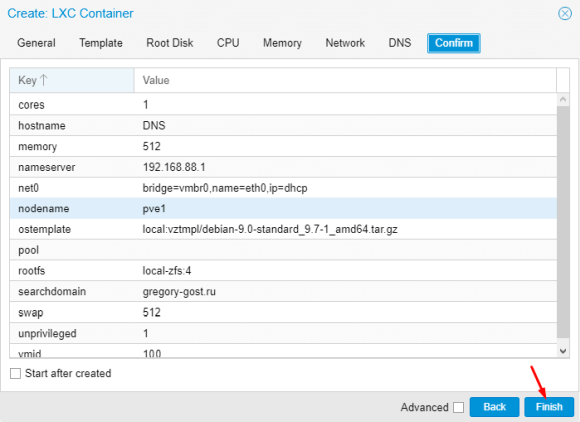

Проводим действия по настройке контейнера

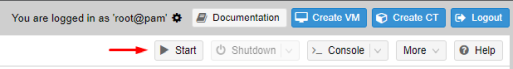

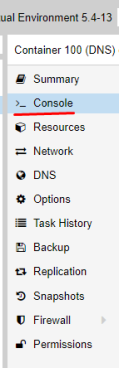

Запускаем контейнер по кнопке Start если еще не сделали это сами 🙂

Все дальнейшие действия будем проводить через консоль:

Далее начинается сам процесс установки и настройки DNS сервиса…

Установка и настройка DNS сервиса BIND9

Обновляем контейнер

apt update && apt full-upgrade -y

Устанавливаем BIND9

apt install bind9 -y

Ждем окончания установки и пока останавливаем сервис

service bind9 stop

Для того, чтобы все работало как нужно в моей нашей сети, необходимо продумать как будут проходить запросы от сети с другим шлюзом и другим роутером обрабатывающим основные DNS запросы не относящиеся к нашей локальной сети.

Согласно статьи: Создание домашней сети на базе устройств MikroTik: Часть 7 – Firewall правильное перенаправление портов в сети с двумя шлюзами

Необходимо сделать так, чтобы локальный DNS сервис корректно обрабатывал локальное доменное имя, а остальные запросы отправлял основному роутеру(шлюзу)

Все файлы настроек и зон в bind9 находятся по пути /etc/bind/

root@DNS:~# ls -l /etc/bind/

total 55

-rw-r--r-- 1 root root 3923 May 3 20:34 bind.keys

-rw-r--r-- 1 root root 237 May 3 20:34 db.0

-rw-r--r-- 1 root root 271 May 3 20:34 db.127

-rw-r--r-- 1 root root 237 May 3 20:34 db.255

-rw-r--r-- 1 root root 353 May 3 20:34 db.empty

-rw-r--r-- 1 root root 270 May 3 20:34 db.local

-rw-r--r-- 1 root root 3171 May 3 20:34 db.root

-rw-r--r-- 1 root bind 463 May 3 20:34 named.conf

-rw-r--r-- 1 root bind 490 May 3 20:34 named.conf.default-zones

-rw-r--r-- 1 root bind 165 May 3 20:34 named.conf.local

-rw-r--r-- 1 root bind 890 Oct 20 17:13 named.conf.options

-rw-r----- 1 bind bind 77 Oct 20 17:13 rndc.key

-rw-r--r-- 1 root root 1317 May 3 20:34 zones.rfc1918

Я решил немного изменить принцип хранения файлов и зон, чтобы было удобнее.

Вот к такому виду необходимо привести конструкцию. Давайте разбираться, что тут и к чему!

root@DNS:~# ls -l /etc/bind/

total 45

drwxr-sr-x 2 root bind 5 Oct 20 20:44 key

-rw-r--r-- 1 root bind 554 Oct 20 20:46 named.conf

-rw-r--r-- 1 root bind 1044 Oct 13 18:32 named.conf.acl

-rw-r--r-- 1 root bind 514 Oct 13 18:33 named.conf.default-zones

-rw-r--r-- 1 root bind 917 Oct 13 18:33 named.conf.local-zones

-rw-r--r-- 1 root bind 891 Oct 13 18:36 named.conf.logging

-rw-r--r-- 1 root bind 397 Oct 13 18:34 named.conf.options

-rw-r--r-- 1 root bind 215 Oct 20 20:45 rndc.conf

drwxr-sr-x 2 root bind 10 Oct 14 20:33 zone

-rw-r--r-- 1 root root 1317 May 3 20:34 zones.rfc1918

Т.к я пока не планирую выводить работу BIND9 на IPv6, то я запустил службу только для IPv4. Для этого необходимо добавить опцию запуска в файл /etc/default/bind9

Добавляем опцию -4 в параметр OPTIONS

# run resolvconf?

RESOLVCONF=no

# startup options for the server

OPTIONS="-u bind -4"

Правим основной файл настроек named.conf:

// Access List

include "/etc/bind/named.conf.acl";

// Options

include "/etc/bind/named.conf.options";

// Key file

include "/etc/bind/key/rndc.key";

include "/etc/bind/key/ns.gregory-gost.ru.key";

// Server

server 192.168.88.7 {

keys { "ns.gregory-gost.ru"; };

};

// Trusted DNS

acl trusted-dns {

127.0.0.1;

key ns.gregory-gost.ru;

};

// Controls Channel

controls {

inet 127.0.0.1 port 953

allow { 127.0.0.1; } keys { "rndc-key"; };

};

// Logging

include "/etc/bind/named.conf.logging";

// Zones

include "/etc/bind/named.conf.local-zones";

Создаем отдельный файл named.conf.acl:

Acl (access control list) — позволяет задать именованный список сетей. Формат раздела: acl «имя_сети» {ip; ip; ip; };

У меня пока две разделенные зоны, но с одной подсетью, соответственно разделяю по выделенным диапазонам. Я прописывал все выделенные IP адреса.

acl "loc" {

192.168.88.7;

127.0.0.1;

};

acl "lan-pool-one" {

192.168.88.1;

192.168.88.2;

192.168.88.3;

192.168.88.4;

192.168.88.5;

192.168.88.6;

...

};

acl "lan-pool-two" {

192.168.88.30;

192.168.88.31;

192.168.88.32;

192.168.88.33;

...

};

acl "ext" {

!192.168.88.0/24;

any;

};

Если у вас разные подсети, то достаточно прописать сами подсети с их маской

- 192.168.88.0/24;

- 192.168.89.0/24;

- и т.д.

Файл named.conf.options уже есть, проводим некоторые настройки:

options {

directory "/var/cache/bind";

dnssec-enable no;

dnssec-validation no;

dump-file "/var/log/bind/bind.dump";

statistics-file "/var/log/bind/bind.stats";

auth-nxdomain no;

version none;

port 53;

max-cache-size 241172480;

listen-on {

127.0.0.1;

192.168.88.7;

};

listen-on-v6 {

none;

};

allow-transfer {

none;

};

allow-query {

any;

};

allow-recursion {

loc;

lan-pool-one;

lan-pool-two;

};

};

Создаем отдельный файл named.conf.logging:

В этом разделе описывается условие ведения журнала.

logging {

channel update_debug {

file "/var/log/bind/update_debug.log" versions 3 size 100k;

severity debug;

print-severity yes;

print-time yes;

};

channel security_info {

file "/var/log/bind/security_info.log" versions 1 size 100k;

severity info;

print-severity yes;

print-time yes;

};

channel bind_log {

file "/var/log/bind/bind.log" versions 4 size 4m;

severity info;

print-category yes;

print-severity yes;

print-time yes;

};

channel query {

file "/var/log/bind/query.log" versions 4 size 4m;

print-time yes;

print-severity no;

print-category no;

};

category default {

bind_log;

};

category lame-servers {

null;

};

category update {

update_debug;

};

category update-security {

update_debug;

};

category security {

security_info;

};

category resolver {

null;

};

category queries {

query;

};

};

На файле named.conf.local-zones я бы хотел остановится немного подробнее. Именно в данном файле мы определяем направления. Именно в этом файле указываются сами зоны с доменными именами и правила их обработки. Как я уже писал, у меня всего две зоны и именно для двух зон мне необходимо сделать идентичные описания, но с различными параметрами.

Переименуем стандартный файл named.conf.local в named.conf.local-zones

mv /etc/bind/named.conf.local /etc/bind/named.conf.local-zones

И отредактируем файл named.conf.local-zones:

view "lan_zone_one" {

match-clients {

loc;

lan-pool-one;

};

allow-query {

loc;

lan-pool-one;

};

allow-transfer {

trusted-dns;

};

allow-update {

none;

};

recursion yes;

forwarders {

192.168.88.1;

};

include "/etc/bind/named.conf.default-zones";

zone "gregory-gost.ru" {

type master;

file "/etc/bind/zone/db.gregory-gost.ru";

};

zone "88.168.192.in-addr.arpa" {

type master;

file "/etc/bind/zone/db.gregory-gost.ru.inverse";

};

};

view "lan_zone_two" {

match-clients {

loc;

lan-pool-two;

};

allow-query {

loc;

lan-pool-two;

};

allow-transfer {

trusted-dns;

};

allow-update {

none;

};

recursion yes;

forwarders {

192.168.88.30;

};

include "/etc/bind/named.conf.default-zones";

zone "gregory-gost.ru" {

type master;

file "/etc/bind/zone/db.gregory-gost.ru";

};

zone "88.168.192.in-addr.arpa" {

type master;

file "/etc/bind/zone/db.gregory-gost.ru.inverse";

};

};

Файл rndc.conf создавать не обязательно, но если вы хотите изменить ключ rndc.key, то можно воспользоваться данным механизмом.

Необходимо подать команду:

rndc-confgen > rndc.conf

Содержимое файла выглядит так:

# Start of rndc.conf

key "rndc-key" {

algorithm hmac-md5;

secret "S+vUL+wY/RO5JdNZ6VVX2A==";

};

options {

default-key "rndc-key";

default-server 127.0.0.1;

default-port 953;

};

# End of rndc.conf

# Use with the following in named.conf, adjusting the allow list as needed:

# key "rndc-key" {

# algorithm hmac-md5;

# secret "S+vUL+wY/RO5JdNZ6VVX2A==";

# };

#

# controls {

# inet 127.0.0.1 port 953

# allow { 127.0.0.1; } keys { "rndc-key"; };

# };

# End of named.conf

Блок key «rndc-key» это и есть содержимое файла ключа rndc.key. Потому вы можете скопировать этот текст в файл rndc.key

С файлами настроек разобрались, теперь необходимо создать нужные папки и переместить туда базовые файлы с описанием зон.

Создаем папки:

mkdir /etc/bind/zone

mkdir /etc/bind/key

Переносим файлы с описанием базовых зон:

mv /etc/bind/db.0 /etc/bind/zone

mv /etc/bind/db.127 /etc/bind/zone

mv /etc/bind/db.255 /etc/bind/zone

mv /etc/bind/db.empty /etc/bind/zone

mv /etc/bind/db.local /etc/bind/zone

mv /etc/bind/db.root /etc/bind/zone

Переносим базовые файлы ключей:

mv /etc/bind/bind.keys /etc/bind/key

mv /etc/bind/rndc.key /etc/bind/key

Теперь самое интересное, а именно описание доменных зон!

Описание локальных доменных зон

У нас уже есть базовые доменные зоны и мы указали в файле конфигурации наши локальные зоны. Возможно вы это заметили в файле named.conf.local-zones

Пункты:

zone "gregory-gost.ru" {

type master;

file "/etc/bind/zone/db.gregory-gost.ru";

};

zone "88.168.192.in-addr.arpa" {

type master;

file "/etc/bind/zone/db.gregory-gost.ru.inverse";

};

Соответственно нам необходимо создать два файла:

1. /etc/bind/zone/db.gregory-gost.ru

2. /etc/bind/zone/db.gregory-gost.ru.inverse

Эти два файла называются зонами прямого просмотра и зонами обратного просмотра. Почему так? А потому что DNS работает в обе стороны! Вы можете попасть через доменное имя, как на IP адрес так и наоборот, проверить IP адрес на привязку к нему доменного имени.

Представляю вам файл зоны прямого просмотра:

;

; Zone Front view

;

$TTL 3600

@ IN SOA gregory-gost.ru. example.gregory-gost.ru. (

2019101401 ; Serial

1d ; Refresh

1h ; Retry

1w ; Expire

2h ; Negative Cache TTL

)

@ IN NS ns1.hostdomen.ru.

@ IN NS ns2.hostdomen.ru.

@ IN NS ns3.hostdomen.org.

@ IN NS ns4.hostdomen.org.

@ IN A 99.55.99.199

www IN CNAME gregory-gost.ru.

@ IN NS ns.gregory-gost.ru.

ns IN A 192.168.88.7

pve1 IN A 192.168.88.6

Как видите после записи доменных имен в этих файлах всегда ставится точка: gregory-gost.ru.

Будьте внимательны!

Остался файл зоны обратного просмотра:

;

; Zones invert view

;

$TTL 3600

@ IN SOA gregory-gost.ru. example.gregory-gost.ru. (

2019101401 ; Serial

1d ; Refresh

1h ; Retry

1w ; Expire

2h ; Negative Cache TTL

)

@ IN NS ns1.hostdomen.ru.

@ IN NS ns2.hostdomen.ru.

@ IN NS ns3.hostdomen.org.

@ IN NS ns4.hostdomen.org.

@ IN NS ns.gregory-gost.ru.

7 IN PTR ns.gregory-gost.ru.

6 IN PTR pve1.gregory-gost.ru.

Сохраняем все наши файлы и пробуем запустить сервис BIND9

service bind9 start

Для проверки работает или нет, сначала проверяем сервис

service bind9 status

Если видим что-то похожее значит все ок

Active: active (running) since Sun 2019-10-20 20:57:57 UTC; 21h ago

После правки файлов зон, необходимо обнулить кеш и обновить файлы зон:

rndc reload

И не забывайте менять строку Serial при каждом внесении изменений!

Теперь проверим, как резолвится доменное имя:

root@DNS:~# nslookup pve1.gregory-gost.ru

Server: 192.168.88.7

Address: 192.168.88.7#53

Name: pve1.gregory-gost.ru

Address: 192.168.88.6

Очистить кеш данных DNS сервиса можно командой rndc flush

Для нормальной обработки доменных имен обычно необходимо подождать некоторое время, от минуты до десяти минут.

Все хорошо. Займемся настройкой сети, ведь мы хотим, чтобы локальные доменные имена работали на всех наших локальных устройствах (умеющих работать с DNS)

Настройка локальной сети для обработки внутренних DNS запросов

Локальная сеть настраивается достаточно просто.

Вам необходимо указать IP адрес LXC контейнера, как основной DNS сервер. Его будут получать клиенты через DHCP.

Для устройств со статическими IP настройками, необходимо DNS прописать вручную.

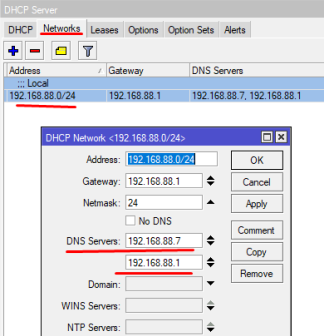

Я покажу, как добавить DNS в DHCP сервер, на примере своего роутера MikroTik

Открываем Winbox или терминал, подключаемся к нашему роутеру и идем по пути: IP -> DHCP Server вкладка Networks

Консольно:

[RC]/ip dhcp-server network set dns-server=192.168.88.7,192.168.88.1[/RC]

Далее обновляем аренду для всех клиентов или какого-то одного для проверки.

Например в Windows 10 можно запустить командную строку(cmd) и проверить получение DNS:

ipconfig /all

Адаптер беспроводной локальной сети Беспроводная сеть:

DNS-суффикс подключения . . . . . :

Описание. . . . . . . . . . . . . : Broadcom 802.11ac Network Adapter

Физический адрес. . . . . . . . . : DE-AD-00-00-BE-EF

DHCP включен. . . . . . . . . . . : Да

Автонастройка включена. . . . . . : Да

Локальный IPv6-адрес канала . . . : fe80::f541:4077:7558:57f3%4(Основной)

IPv4-адрес. . . . . . . . . . . . : 192.168.88.24(Основной)

Маска подсети . . . . . . . . . . : 255.255.255.0

Аренда получена. . . . . . . . . . : 21 октября 2019 г. 20:57:33

Срок аренды истекает. . . . . . . . . . : 24 октября 2019 г. 20:57:32

Основной шлюз. . . . . . . . . : 192.168.88.1

DHCP-сервер. . . . . . . . . . . : 192.168.88.1

IAID DHCPv6 . . . . . . . . . . . : 408986700

DUID клиента DHCPv6 . . . . . . . : 00-01-00-01-24-56-5F-89-70-22-37-35-61-F4

DNS-серверы. . . . . . . . . . . : 192.168.88.7

192.168.88.1

NetBios через TCP/IP. . . . . . . . : Включен

Видим строку DNS-серверы. . . . . . . . . . . : 192.168.88.7 значит наш ПК получает DNS корректно.

Но для нормального открытия WEB страницы по доменному имени этого еще не достаточно!

Необходимо, чтобы на целевом IP адресе, WEB интерфейс корректно обработал такой запрос.

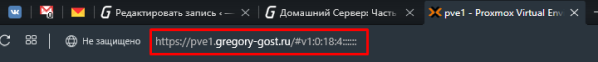

Давайте на примере основной хост машины PVE, попробуем получить к ней доступ через указанное нами доменное имя pve1.gregory-gost.ru.

Настройка открытия WEB интерфейса Proxmox-VE по доменному имени

Для того, чтобы запрос к доменному имени был обработан корректно, нам необходимо настроить специальный сервис, который будет за это отвечать.

Этот сервис nginx. Очень мощная штука по которой пишут не маленькие мануалы. Поэтому мы ограничимся самым простым функционалом.

Переходим к консоли хост машины:

Для начала давайте поставим nginx:

apt install nginx -y

Останавливаем сервис

service nginx stop

Файлы nginx хранит по пути /etc/nginx/:

root@pve1:~# ls -l /etc/nginx/

total 56

drwxr-xr-x 2 root root 3 Oct 13 22:21 conf.d

-rw-r--r-- 1 root root 1077 Aug 19 12:31 fastcgi.conf

-rw-r--r-- 1 root root 1007 Aug 19 12:31 fastcgi_params

-rw-r--r-- 1 root root 2837 Aug 19 12:31 koi-utf

-rw-r--r-- 1 root root 2223 Aug 19 12:31 koi-win

-rw-r--r-- 1 root root 3957 Aug 19 12:31 mime.types

drwxr-xr-x 2 root root 2 Aug 19 12:31 modules-available

drwxr-xr-x 2 root root 12 Oct 13 22:03 modules-enabled

-rw-r--r-- 1 root root 1299 Oct 13 22:05 nginx.conf

-rw-r--r-- 1 root root 180 Aug 19 12:31 proxy_params

-rw-r--r-- 1 root root 636 Aug 19 12:31 scgi_params

drwxr-xr-x 2 root root 3 Oct 13 22:03 sites-available

drwxr-xr-x 2 root root 2 Oct 13 22:05 sites-enabled

drwxr-xr-x 2 root root 4 Oct 13 22:03 snippets

-rw-r--r-- 1 root root 664 Aug 19 12:31 uwsgi_params

-rw-r--r-- 1 root root 3071 Aug 19 12:31 win-utf

Давайте удалим базовую WEB страницу, она нам не нужна

rm /etc/nginx/sites-enabled/default

Ничего страшного это всего лишь simlink, оригинал лежит тут: /etc/nginx/sites-available/default

Все файлы дополнительных конфигураций можно располагать в папке /etc/nginx/conf.d/

Она как раз подключена в основном файле конфигурации.

Создадим файл настройки для нашего PVE1:

nano /etc/nginx/conf.d/proxmox.conf

Заполним его такими настройками

upstream proxmox {

server "pve1.gregory-gost.ru";

}

server {

listen 80 default_server;

rewrite ^(.*) https://$host$1 permanent;

}

server {

listen 443;

server_name _;

#ssl on;

#ssl_certificate /etc/pve/local/gregory-gost.ru.crt;

#ssl_certificate_key /etc/pve/local/device.key;

proxy_redirect off;

location / {

proxy_http_version 1.1;

proxy_set_header Upgrade $http_upgrade;

proxy_set_header Connection "upgrade";

proxy_pass https://localhost:8006;

proxy_buffering off;

client_max_body_size 0;

proxy_connect_timeout 3600s;

proxy_read_timeout 3600s;

proxy_send_timeout 3600s;

send_timeout 3600s;

}

}

В общем основная суть того, что происходит.

При запросах по доменному имени pve1.gregory-gost.ru мы попадаем на 80 порт(стандартный HTTP) и нас перенаправляет на 443 порт(HTTPS) на котором работает WEB Proxmox-VE.

Ну а там запрос поступает уже на свой внутренний адрес и порт: https://localhost:8006 при этом для нас, все скрыто за кулисами nginx 🙂

По сути, именно таким образом все это и работает.

Если вы столкнулись с ошибкой «401 no token»:

Необходимо отредактировать файл запуска сервиса nginx

systemctl edit nginx.service

и добавить такие строки

[Unit]

Requires=pve-cluster.service

After=pve-cluster.service

Не забудем перезапустить нужные службы

systemctl daemon-reload

service nginx restart

Спасибо за наводку комментатору: Pavel !

Заключение

Статья получилась достаточно большой. Хотя это еще не все, вы могли заметить закомментированные строки связанные с SSL сертификатами.

Возможно позже я разберусь с этим и дополню статью, а пока приходится мириться с паникой браузера в отношении непроверенных сертификатов.

Существуют и системы альтернативные BIND. Например PowerDNS, Unbound, djbdns, Dnsmasq.

Вы можете рассмотреть их для реализации похожего функционала.

Мне остается только напомнить про дальнейшие шаги по реализации своего домашнего сервера:

- Torrent Transmission — качалка торрентов. Домашний Сервер: Часть 4 – Настройка Transmission daemon в контейнере LXC Proxmox-VE

- Plex Mediaserver — домашний медиа сервер. Домашний Сервер: Часть 5 – Установка и настройка Plex Media Server в контейнере LXC Proxmox-VE

Делитесь своими методиками и способами реализации доменной системы. Читателям будет интересно узнать про альтернативы! 🙂

Благодарю за ваше время!

Всего хорошего на просторах Интернета 😉

UPD: 21.06.2020

Добавлена информация для корректной совместной работы nginx и pve по https (расширенный протокол http)

Спасибо комментатору Pavel !!!