Но здесь мы имеем в виду животных, а не привидений! Первый вопрос, который, возможно, приходит в голову, зачем отправляли животных в космос? «Изначально животные в космосе служили только для проверки живучести космических полетов, прежде чем были предприняты попытки пилотируемых космических полетов», вот почему.

Топ-10 животных-космонавтов:

10 мышей

С 1950-х годов было предпринято несколько попыток отправить мышей в космос и успешно их вернуть. В 1950 году одна мышь была размещена на борту пятого полета серии запусков V2 Альберта, но полет оказался неудачным, так как вышла из строя система восстановления парашюта. В следующем году, то есть в 1951 году, американская ракета Aerobee взлетела с 11 мышами, а в 1958 году США снова отправили в небо трех мышей в рамках проекта под названием «Mouse In Able», который потерпел неудачу, когда все трое погибли. В результате еще одной попытки погибли еще 14 мышей после их взлета в 1959 году. Как говорится, настойчивость принесет успех, поэтому в 1961 году французский космический центр отправил в космос крысу по имени Гектор, которая после полета на высоту 93 см. миль успешно вернули. Гектора теперь называют первой крысой, посетившей это место.

9 Морская Свинка

9 марта 1961 года первая морская свинка успешно вторглась в космос на советском космическом корабле Спутник-9 вместе с группой других животных (собак, рептилий и мышей). Примерно тридцать лет спустя, в 1990 году, Китай отправился в путешествие для 60 растений и некоторых животных, включая морских свинок, на биоспутнике FSW-13, который успешно вернулся домой.

8 тритонов

В 1985 году была запущена миссия «Бион-7» с несколькими животными, в том числе двумя монетами и 10 тритонами. Пытаясь изучить, как тело реагирует на травмы в космосе, ученый отрезал передние конечности и удалил часть линз бедного тритона. В космосе они наблюдали значительный феномен, заключающийся в том, что тритоны могли быстрее восстанавливаться. На протяжении многих лет тритонов несколько раз отправляли в космос для экспериментальных целей, например, в других полетах Биона, и несколько раз экспериментировали в японском космическом летном аппарате в 1995 году, космической станции «Мир» и др.

7 лягушек

НАСА отправило в космос двух лягушек-быков в 1970 году в рамках программы под названием «Отолит орбитальной лягушки» (OFO). Это была процедура исследования, чтобы выяснить, как отолит (который относится к механизму, контролирующему равновесие во внутреннем ухе) будет адаптироваться к невесомости. Программа оказалась успешной с точки зрения необходимого количества данных, которые удалось собрать исследователям, но бедных лягушек так и не удалось найти.

6 Рыба

Чтобы собрать больше данных об отолитовом органе, в 1973 году на космическом корабле Skylab 3 была отправлена пара рыб-мумихогов. Этот особый вид был выбран из-за их способности выживать в экстремальных условиях, и поэтому эти рыбы также использовались в более поздних космических исследованиях. Но с годами в космос были отправлены и другие виды, такие как меченосцы, устричные жабы, гуппи, зебра Данио и другие.

5 Черепахи и черепахи

Черепахи были одними из первых животных, которые вышли в космос. В 1968 году Советы отправили двух черепах на космическом корабле Zond 5 с намерением отправить их в глубокий космос. Zond 5 сделал петлю вокруг Луны, прежде чем благополучно вернуться на Землю вместе с черепахами, которые лишь немного похудели. Интересно, что в 1974 году Советский Союз отправил черепах в космос на 90 дней, установив рекорд по продолжительности пребывания любого животного в космосе.

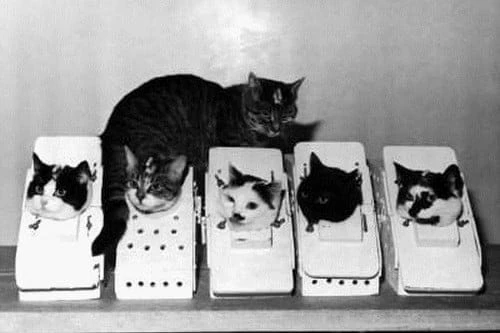

4 кошки

Похоже, что французы не спешили переправлять животных в космос. Вслед за крысами они решили отправить в космос первого кота (по имени Феликс) в октябре 1963 года. Феликс был запущен на ракете Вероник AGI и благополучно вернулся. Ходят слухи, что Феликс сбежал незадолго до запуска, а кошкой, которая отправилась в космос вместо него, была женщина по имени Фелисетт.

3 Паука

Первыми, кто вторгся в космос, были два европейских садовых паука по имени Анита и Арабелла в космической миссии Skylab 3 1973 года. Исследователи хотели выяснить, как космические полеты и невесомость влияют на их способность создавать сети. Было замечено, что продолжительность создания сети была больше, но, как ни удивительно, имела более высокое качество. К сожалению, Анита и Арабелла умерли из-за обезвоживания, но теперь их тела выставлены в Смитсоновском институте.

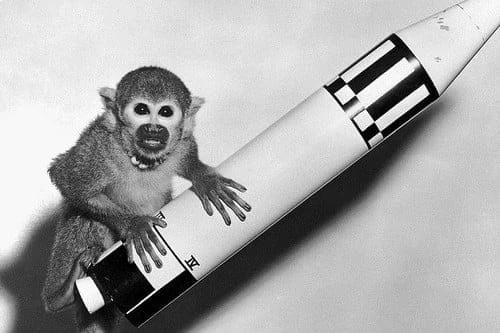

2 обезьяны

С 1940-х годов многие страны предприняли несколько попыток отправить обезьян в космос. Некоторые потерпели неудачу, а некоторые преуспели. В 1961 году Хэм стал первым шимпанзе, побывавшим в космосе. В том же году Энос был тем же первым шимпанзе, который облетел Землю на орбите. Помимо собак, обезьяны – второй вид животных, которые чаще всего путешествовали в космос.

1 Собаки

Лайка, самый известный космический путешественник, не являющийся человеком, была не только первой собакой, полетевшей в космос, но и первым живым существом, коснувшимся орбиты. Она летела 3 ноября 1957 года на ракете Спутник-2, но, к сожалению, умерла через несколько часов из-за перегрева и стресса. Только в 1960-х годах технологии и человеческие знания достигли того уровня, когда животные могли начать безопасно возвращаться на Землю.