Клавиша Tab на клавиатуре помогает выполнять различные функции, от навигации по Windows до редактирования любого письменного документа. Никто не понимает, насколько привычка использовать клавишу Tab засела в нашей мышечной памяти, пока клавиша не перестанет работать.

В последнее время многие пользователи сталкивались с такой проблемой в своей системе Windows 11. Хотя проблема специфическая, существует множество способов решить проблему на вашем ПК, учитывая, что это проблема программного обеспечения. В этом руководстве вы найдете исчерпывающий список исправлений для возникшей проблемы.

1. Проверьте оборудование

Первый и самый важный шаг перед тем, как приступить к устранению проблемы, – это физически осмотреть клавишу Tab и убедиться, что под колпачком клавиши нет повреждений от воды или частиц.

Кроме того, нажмите пару раз и убедитесь, что ощущения совершенно нормальные. Если вы слышите какой-либо скрип или потрескивание или сопротивление при нажатии, это может быть связано с физическими проблемами с ключом, и, возможно, его необходимо заменить.

2. Подключите внешнюю клавиатуру

Подключение внешней клавиатуры также является отличным способом убедиться, что проблема не связана с аппаратным обеспечением.

Если клавиша работает, когда вы подключили внешнюю клавиатуру, возможно, нужно исправить не операционную систему, а саму клавиатуру.

3. Запустите средство устранения неполадок с клавиатурой

Если вы исключили проблемы с оборудованием, следующим шагом будет выяснить, нет ли системных проблем или проблем с конфигурацией вашей клавиатуры. Средство устранения неполадок с клавиатурой поможет вам обнаружить и устранить проблему.

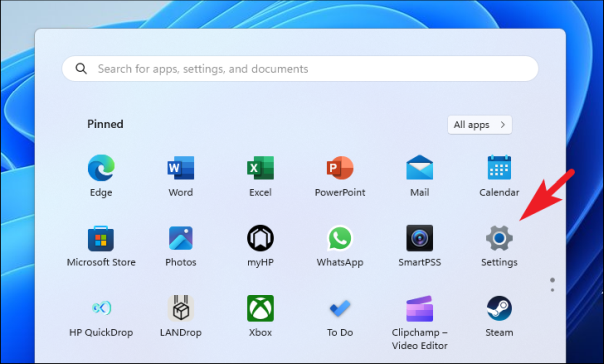

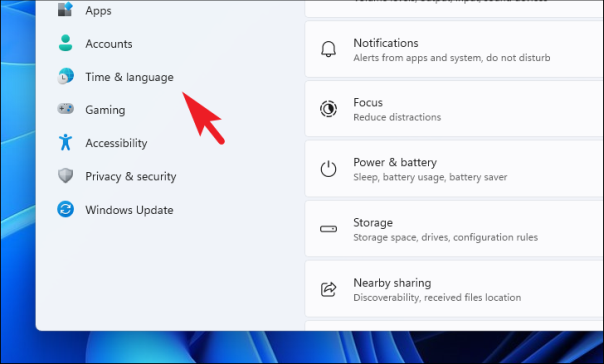

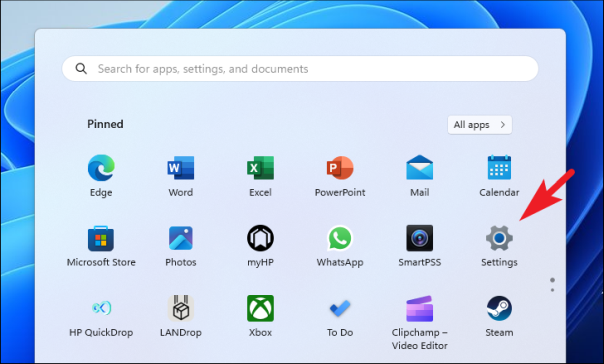

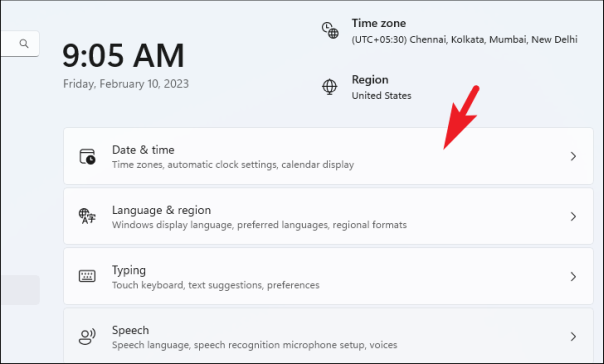

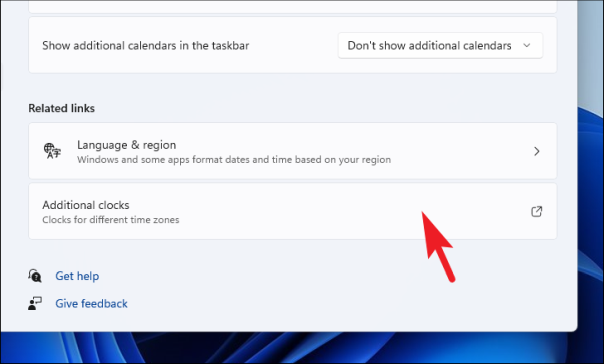

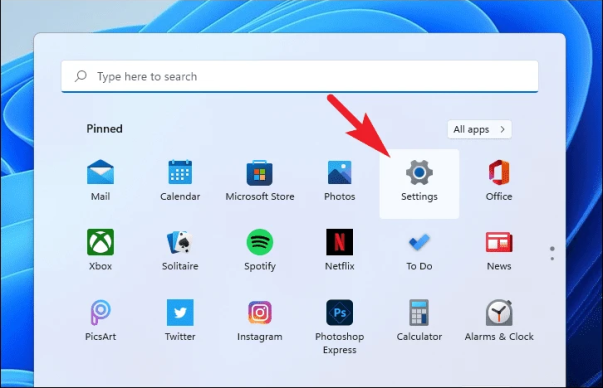

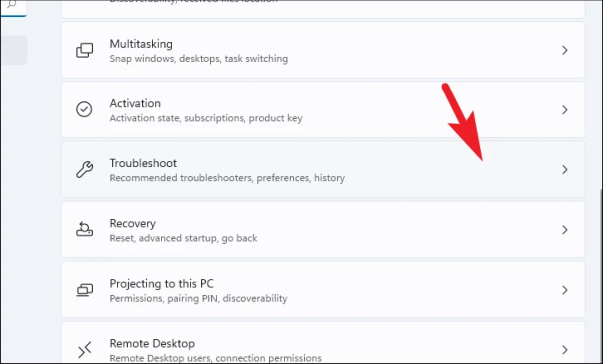

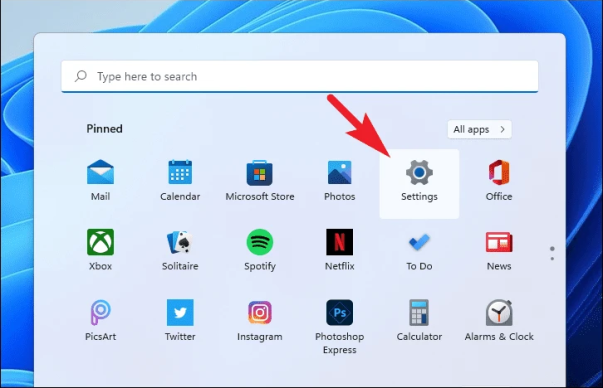

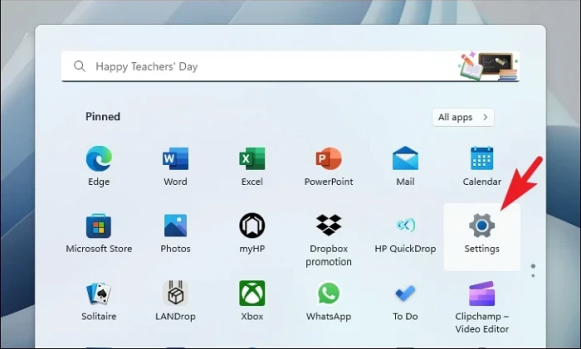

Сначала перейдите в меню «Пуск» и щелкните значок приложения «Настройки».

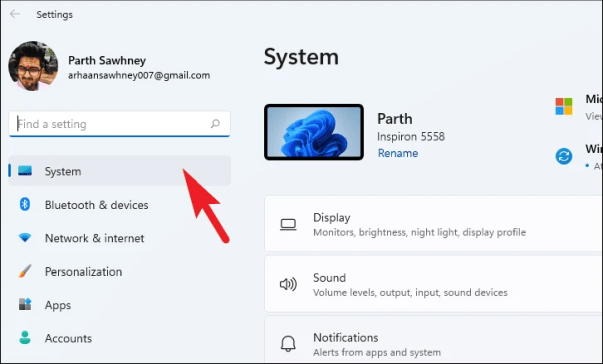

Затем убедитесь, что вы выбрали вкладку «Система» на левой боковой панели.

После этого в правой части окна нажмите на плитку «Устранение неполадок», чтобы продолжить.

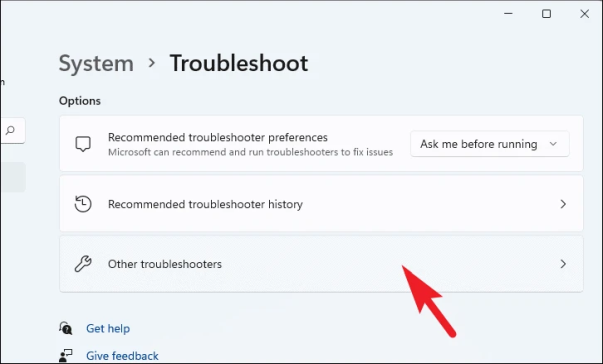

Затем нажмите на плитку «Другое средство устранения неполадок» на странице настроек «Устранение неполадок».

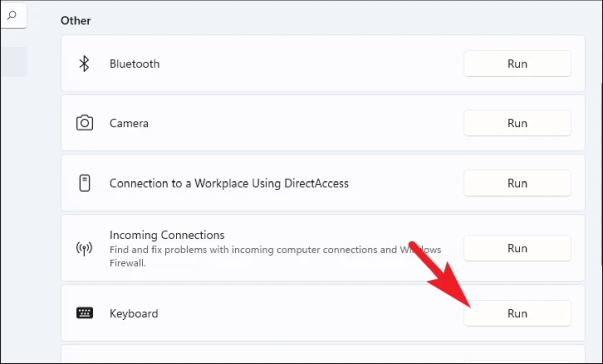

Затем найдите на странице раздел «Другое» и нажмите кнопку «Выполнить» на плитке «Клавиатура», чтобы запустить средство устранения неполадок с клавиатурой.

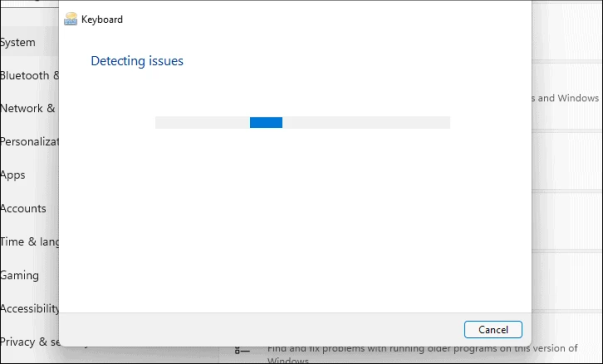

Затем Windows обнаружит проблемы с вашими периферийными устройствами, а также проблемы с драйверами, если таковые обнаружатся, и предложит изменения и исправления в том же окне. Следуйте инструкциям мастера по устранению неполадок, чтобы решить проблему.

4. Отключите залипание и фильтрацию клавиш на вашем компьютере

Залипание клавиш помогает сохранить активную клавишу-модификатор, даже если физическая клавиша нажата и отпущена. Хотя эта функция потрясающая, иногда она может мешать работе других клавиш. Более того, многие пользователи смогли решить проблему с помощью этого метода.

Сначала перейдите в меню «Пуск» и щелкните значок приложения «Настройки», чтобы продолжить.

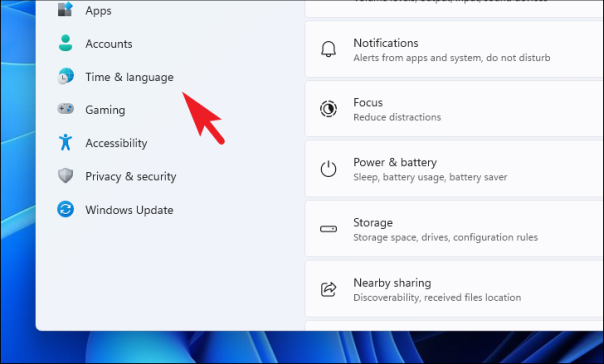

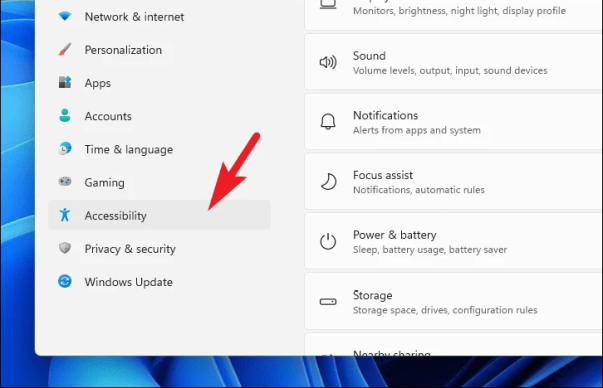

Затем нажмите на вкладку «Специальные возможности» на левой боковой панели, чтобы продолжить.

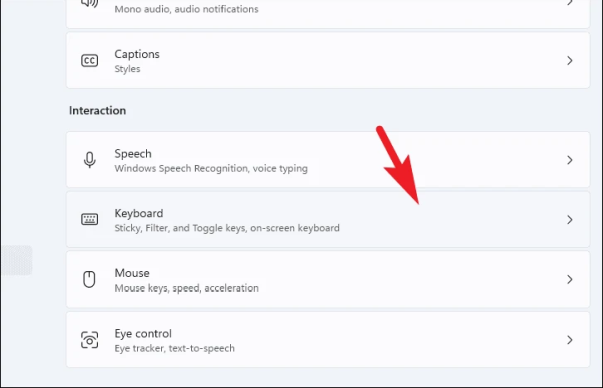

Затем в правой части окна нажмите на плитку «Клавиатура».

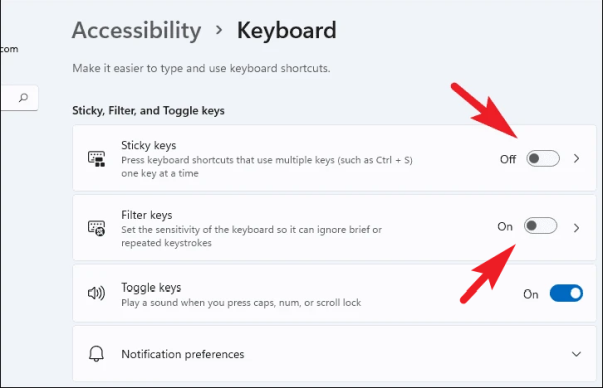

Затем отключите переключатель рядом с параметром «Залипание клавиш». Аналогичным образом отключите переключатель для параметра «Ключи фильтра».

После этого проверьте, работает ли ключ снова.

5. Обновите драйвер клавиатуры

Драйвер клавиатуры на вашем устройстве Windows можно обновить тремя основными способами. Вы можете обновить его из приложения «Настройки», использовать диспетчер устройств для поиска последней версии драйвера или принудительно обновить его.

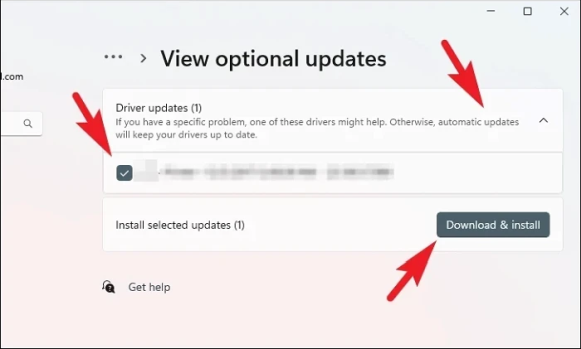

Чтобы обновить драйвер с помощью приложения «Настройки», перейдите в меню «Пуск» и нажмите на плитку «Настройки».

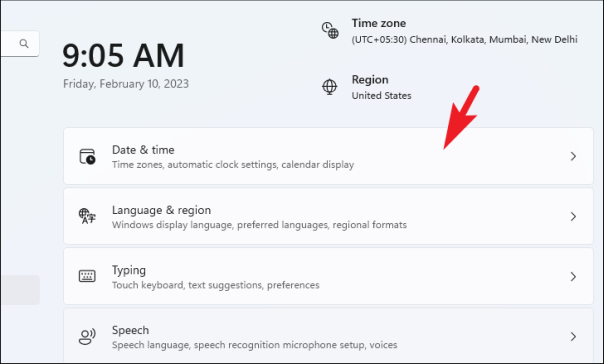

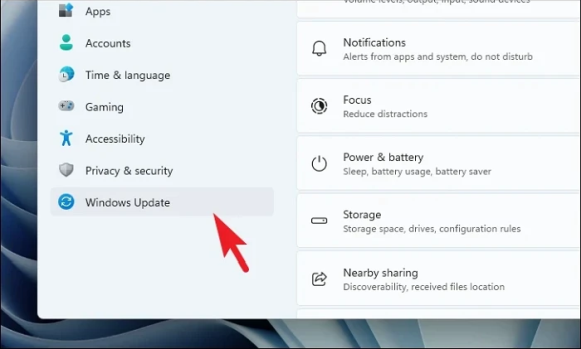

Затем нажмите вкладку «Центр обновления Windows» на левой боковой панели.

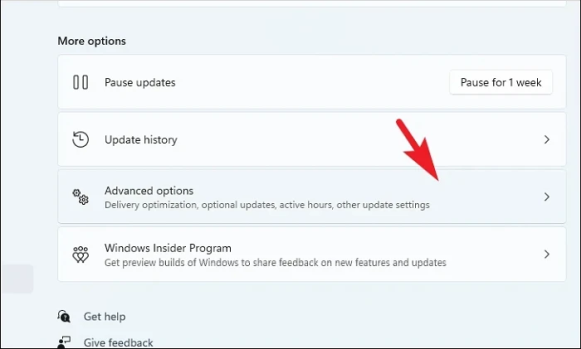

Далее нажмите на плитку «Дополнительные параметры» в правом разделе, чтобы продолжить.

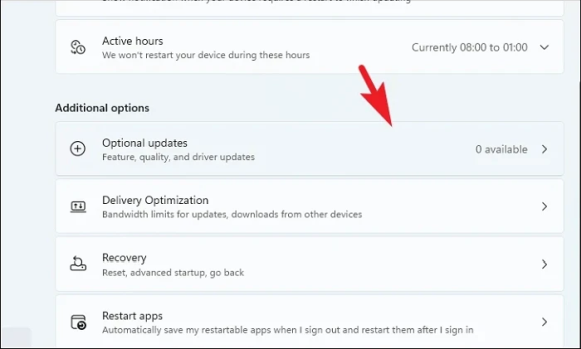

Далее нажмите на плитку «Необязательные обновления», чтобы продолжить.

Затем выберите обновления, имеющие в качестве суффикса или префикса слово «клавиатура», установив соответствующие флажки. Наконец, нажмите кнопку «Загрузить и установить».

После установки перезагрузите компьютер и проверьте, заработал ли ключ снова.

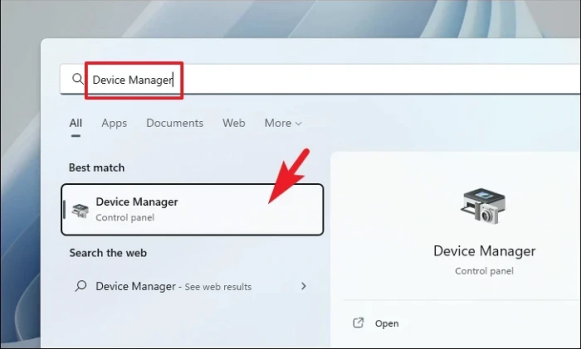

Если вы хотите обновить драйвер с помощью диспетчера устройств, перейдите в меню «Пуск» и введите «Диспетчер устройств». Затем нажмите на плитку «Диспетчер устройств», чтобы продолжить.

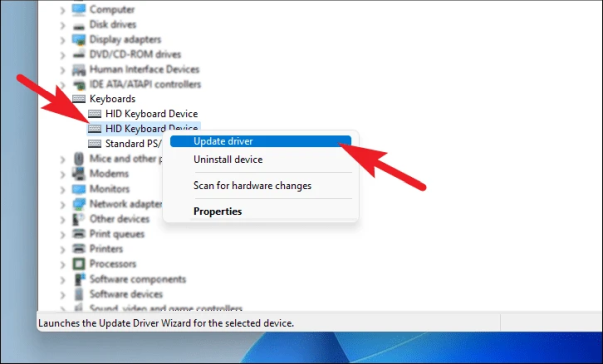

После этого дважды щелкните параметр «Клавиатуры», чтобы развернуть раздел. Затем щелкните правой кнопкой мыши «HID-клавиатура» или «Стандартная клавиатура PS/2» и выберите в контекстном меню пункт «Обновить драйвер». Это откроет отдельное окно на вашем экране.

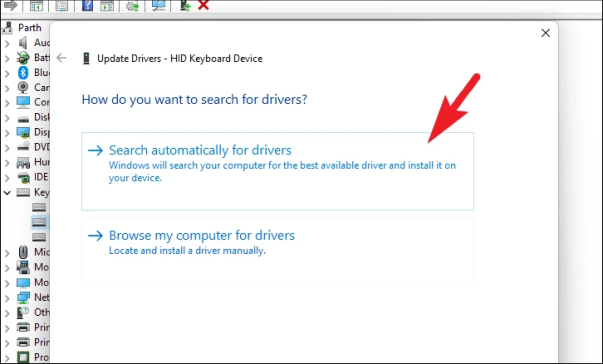

Теперь в отдельно открытом окне нажмите «Автоматический поиск драйверов», чтобы Windows сделала всю работу за вас. В противном случае, если у вас уже загружен пакет драйверов, нажмите «Выполнить поиск драйверов на моем компьютере».

6. Включить службу ввода с клавиатуры и планшета

Если вы столкнулись с этой проблемой и с другими клавишами на клавиатуре, возможно, служба клавиатуры остановлена/отключена. К счастью, вы можете просто запустить или повторно включить его самостоятельно.

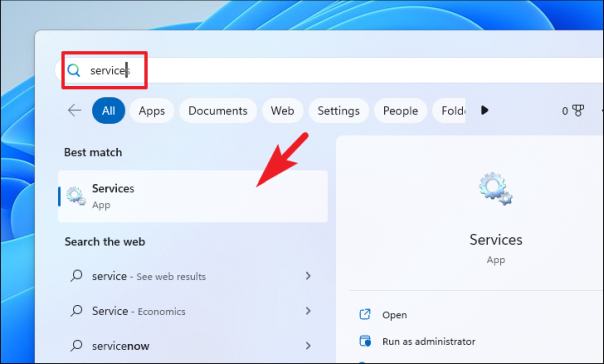

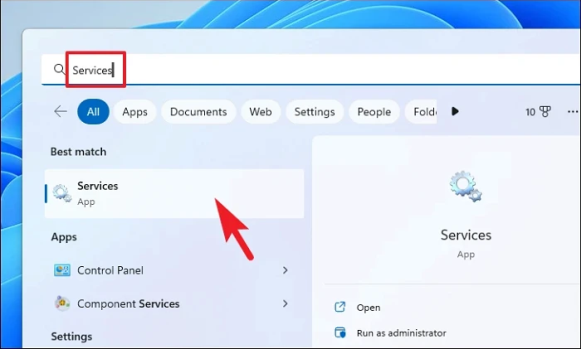

Сначала откройте меню «Пуск» и введите «Сервис», чтобы выполнить поиск. Затем в результатах поиска нажмите на плитку «Услуги».

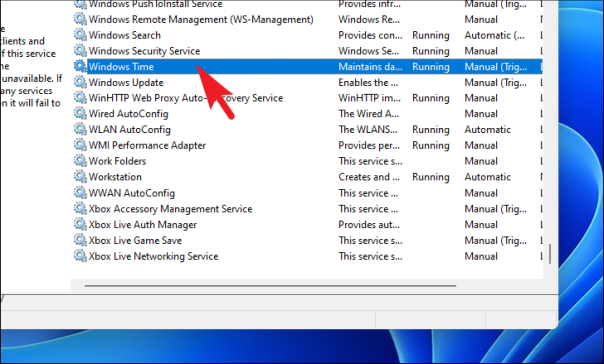

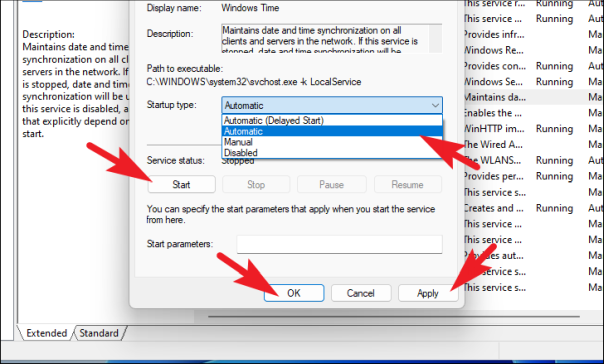

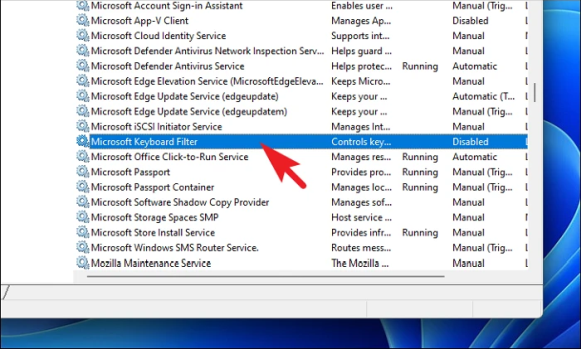

Теперь найдите службу «Microsoft Keyboard Filter» и дважды щелкните ее. Это откроет отдельное окно на вашем экране.

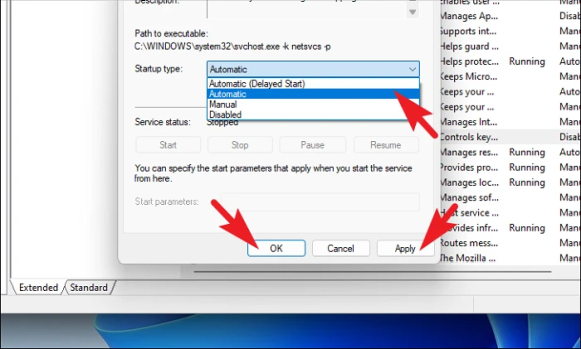

Затем нажмите раскрывающееся меню, а затем «Тип запуска», выберите параметр «Автоматически» и нажмите кнопки «Применить» и «ОК», чтобы сохранить изменения.

Аналогичным образом повторите тот же процесс с параметром «Служба ввода планшетного ПК» из списка.

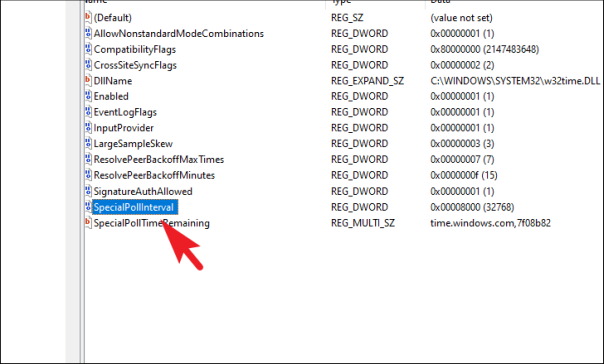

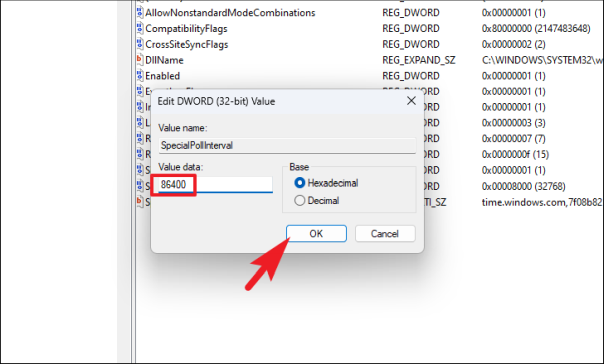

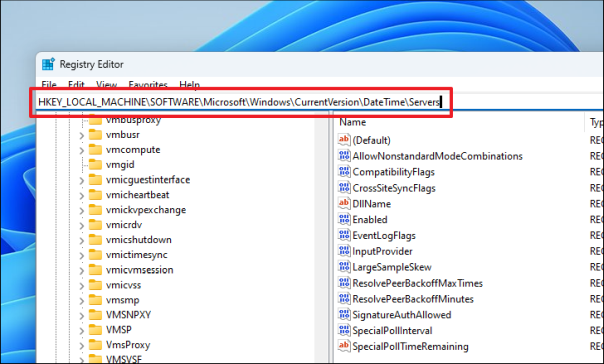

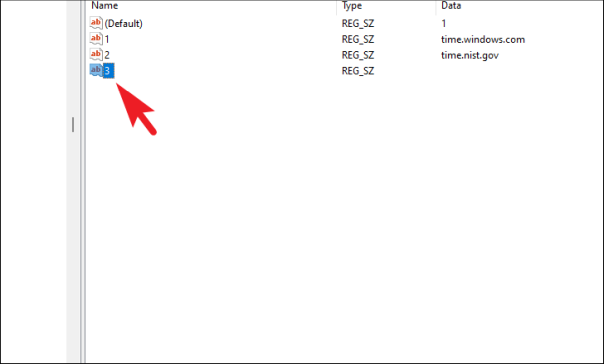

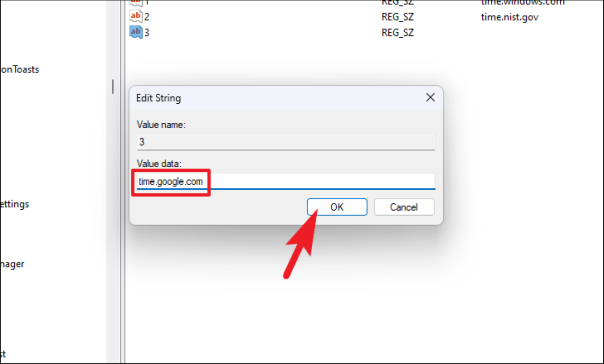

7. Изменить файл реестра

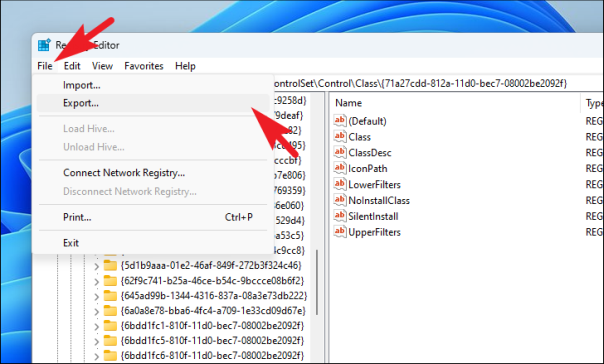

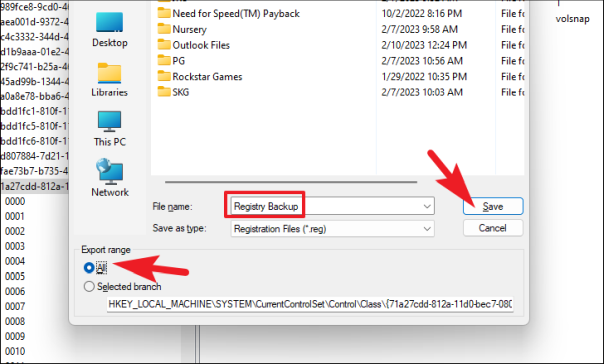

Если проблема возникает именно при использовании сочетания клавиш Alt+Tab, вы можете изменить файл реестра, который вернет интерфейс Alt+Tab для отображения. эскизы вместо Windows.

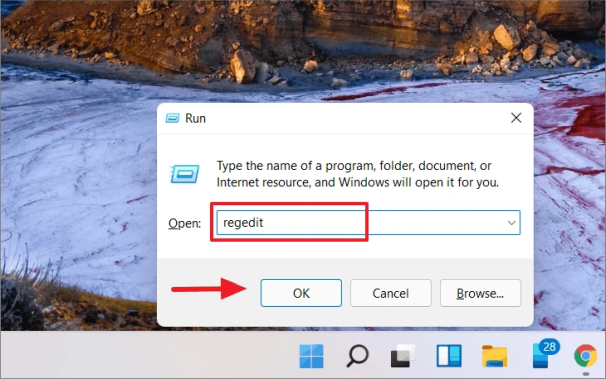

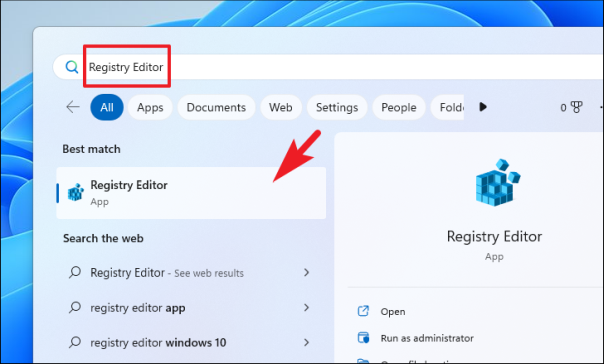

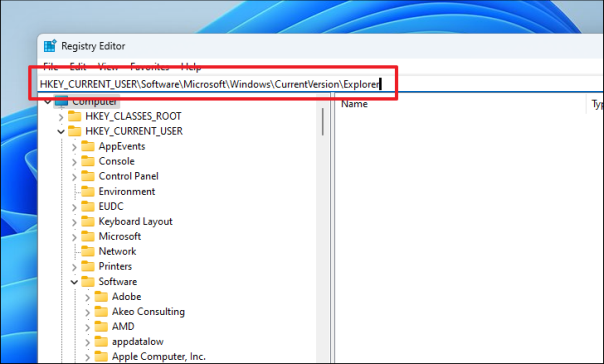

Сначала откройте меню «Пуск» и введите «Реестр», чтобы выполнить поиск. Затем в результатах поиска нажмите «Редактор реестра».

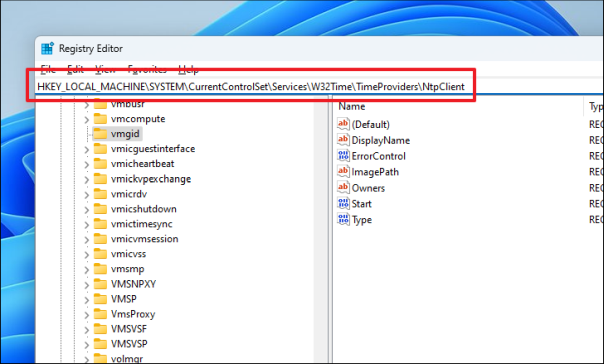

После этого введите или скопируйте+вставьте указанный ниже адрес в адресную строку и нажмите Enter, чтобы перейти в каталог.

HKEY_CURRENT_USERSoftwareMicrosoftWindowsCurrentVersionExplorer

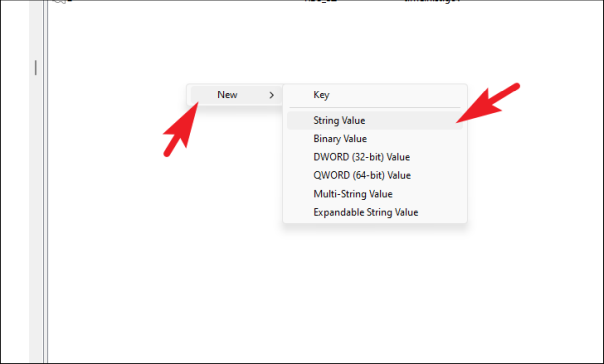

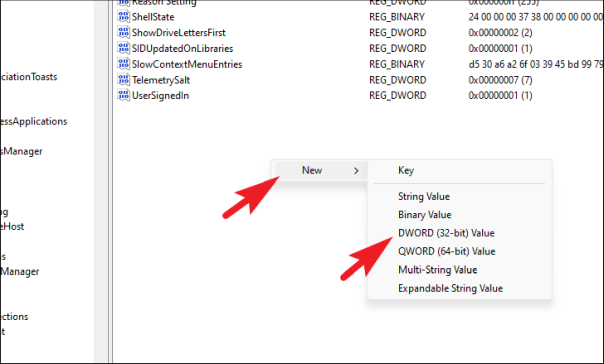

После этого щелкните правой кнопкой мыши правую часть окна и наведите указатель мыши на параметр «Создать». Затем выберите параметр «DWORD».

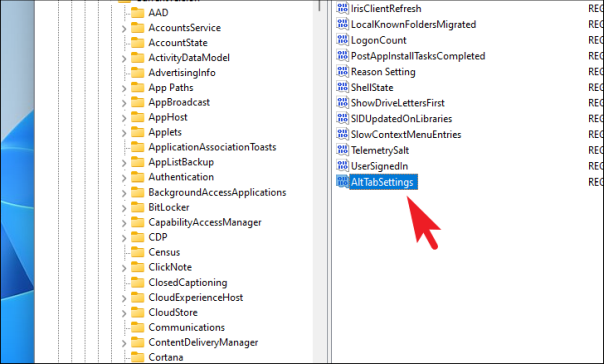

После этого переименуйте файл в AltTabSettings и дважды щелкните его, чтобы открыть его свойства.

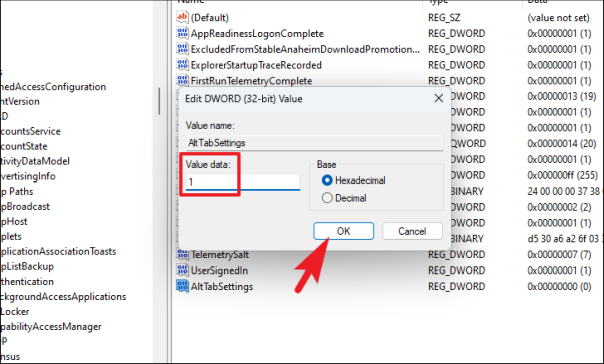

После этого введите 1 в поле данных значения и нажмите кнопку «ОК», чтобы сохранить изменения.

После этого перезагрузите компьютер и проверьте, устранена ли проблема.

8. Запустите DISM и SFC

Возможно, ваши системные файлы были повреждены или повреждены из-за неполного обновления Windows или неправильного удаления сторонних приложений. В противном случае это также может быть связано с вредоносными программами / вирусами в вашей системе. Хотя такая вероятность маловероятна, убедиться, что это не так, не помешает.

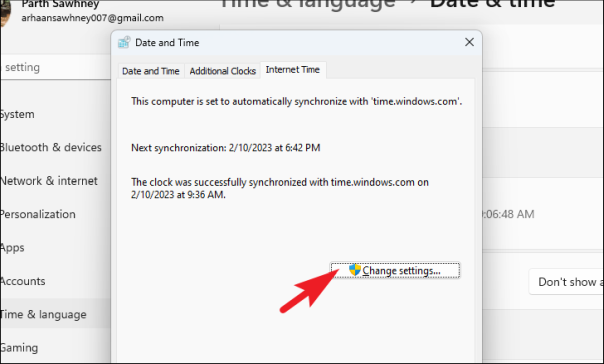

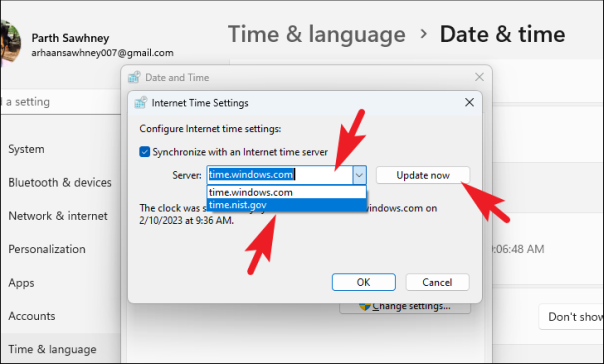

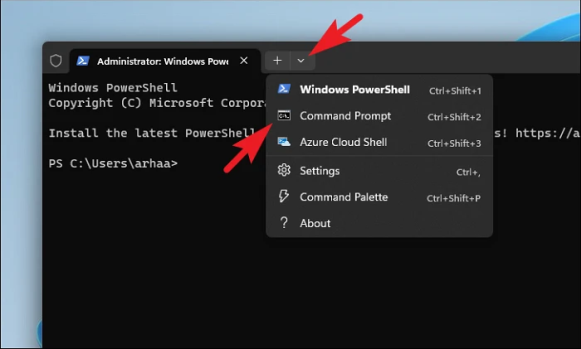

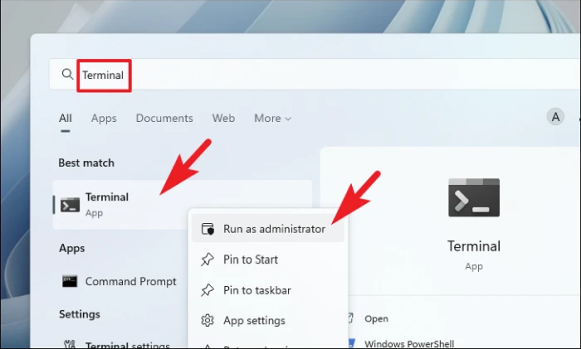

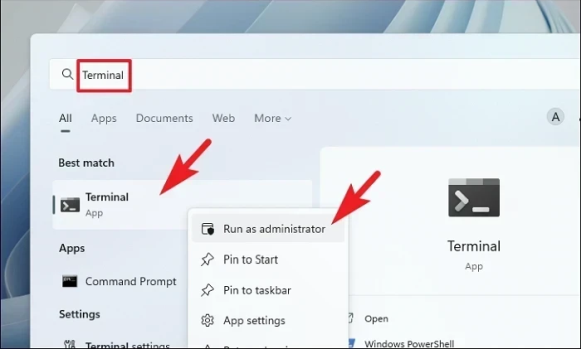

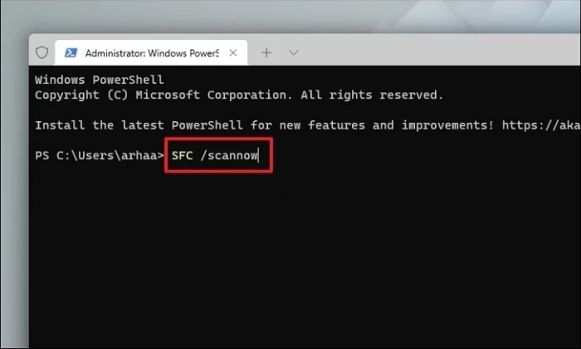

Сначала перейдите в меню «Пуск» и введите «Терминал», чтобы выполнить поиск. Затем в результатах поиска щелкните правой кнопкой мыши плитку «Терминал» и выберите параметр «Запуск от имени администратора».

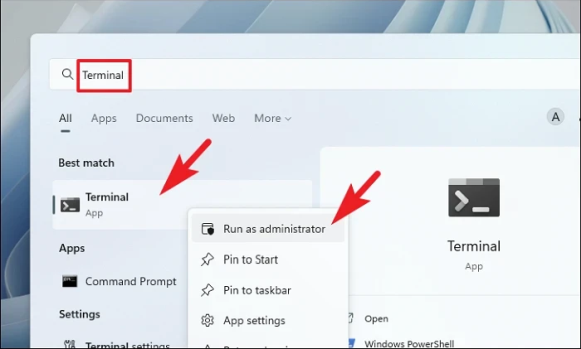

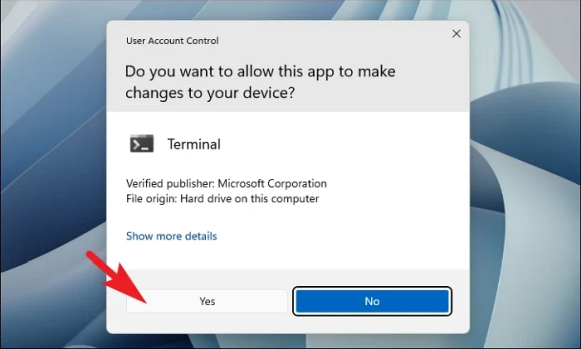

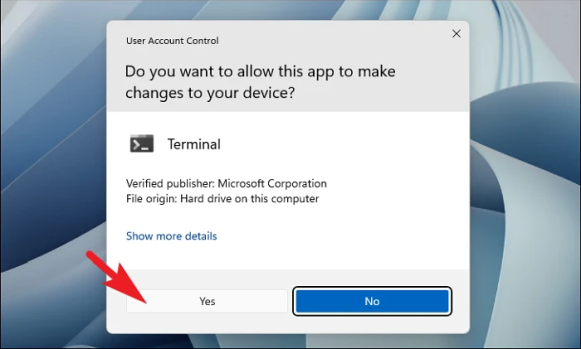

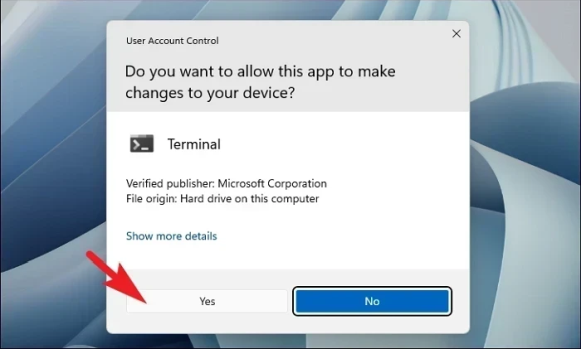

Теперь на вашем экране появится окно UAC (Контроля учетных записей). Если вы не вошли в систему с учетной записью администратора, введите учетные данные для нее. В противном случае нажмите кнопку «Да».

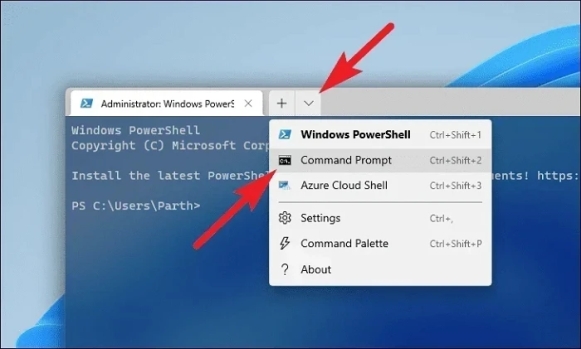

После этого нажмите значок «шеврон» (стрелка вниз) и выберите параметр «Командная строка».

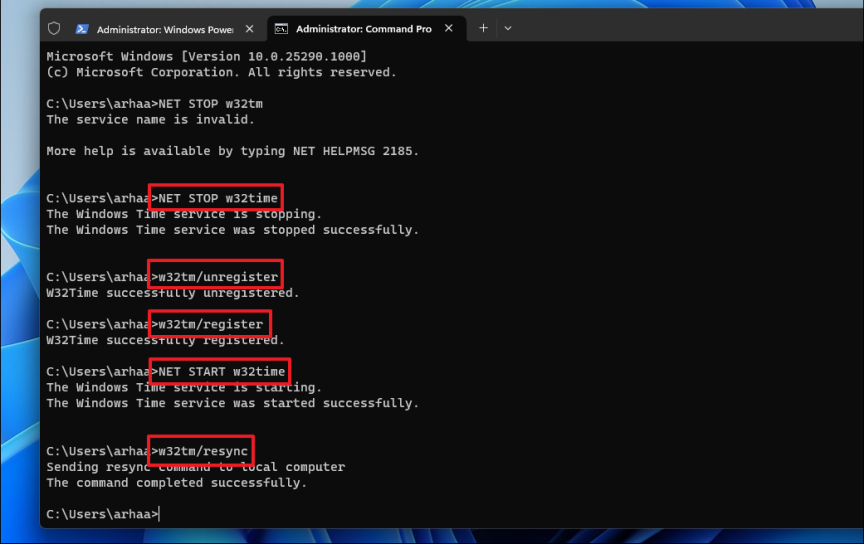

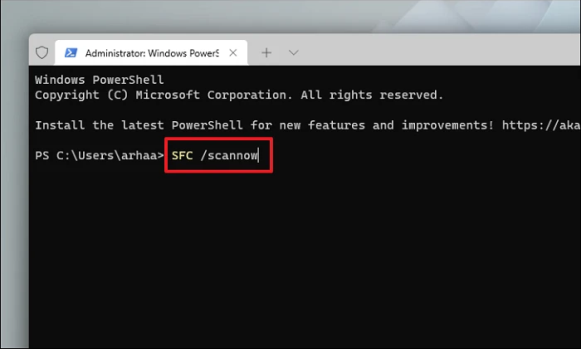

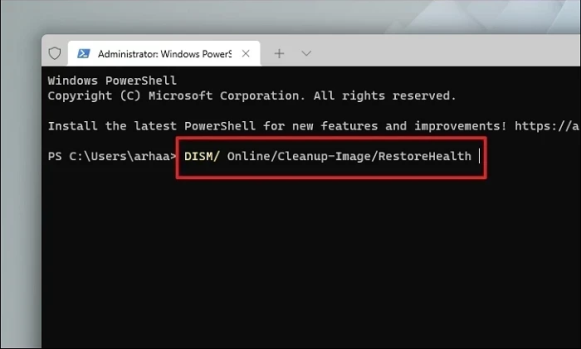

Затем введите или скопируйте и вставьте указанную ниже команду и нажмите Enter на клавиатуре. Это восстановит текущий установленный образ ОС на вашем устройстве.

DISM/ Online/Cleanup-Image/RestoreHealth

После этого введите или скопируйте и вставьте следующую команду, чтобы проверить и восстановить системные файлы на вашем ПК.

SFC /scannow

После успешного выполнения перезагрузите компьютер и проверьте, можете ли вы обновить его.

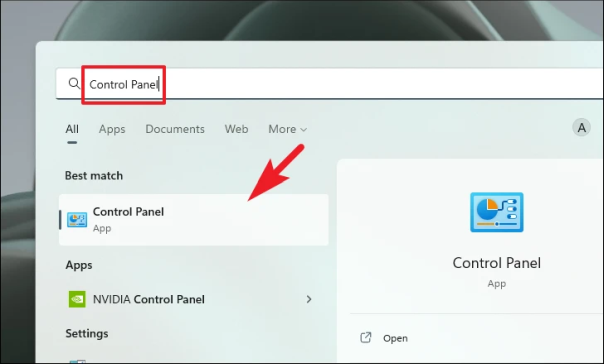

9. Откат к точке восстановления системы

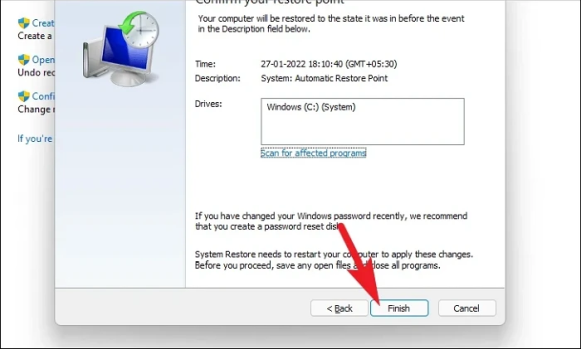

Если вы заметили проблему после установки стороннего приложения или службы и у вас есть ранее созданная точка восстановления системы, вы можете легко вернуться к ней, чтобы решить проблему.

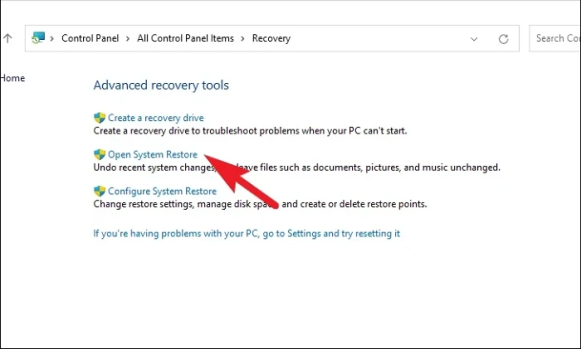

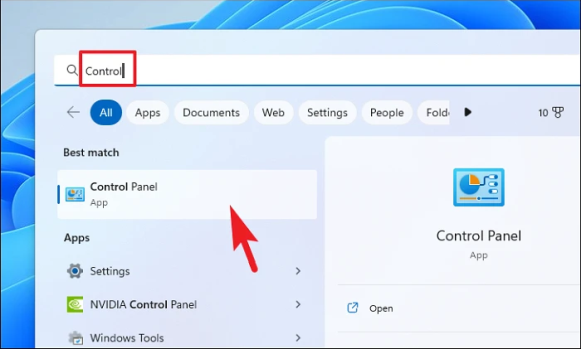

Перейдите в меню «Пуск» и введите Control, чтобы выполнить поиск. Затем в результатах поиска нажмите плитку «Панель управления», чтобы продолжить.

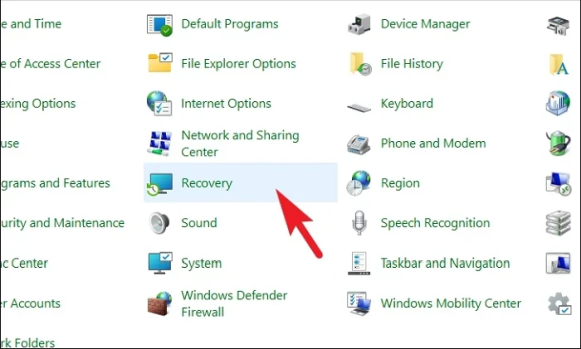

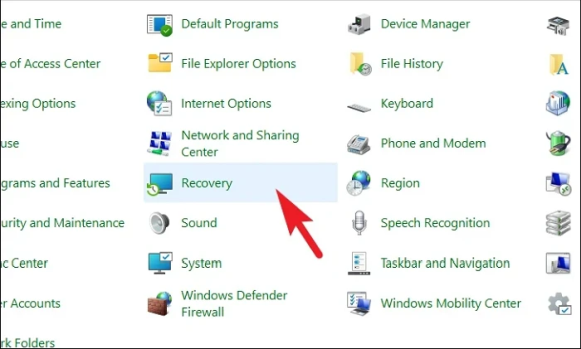

После этого найдите и нажмите плитку «Восстановление» в сетке значков.

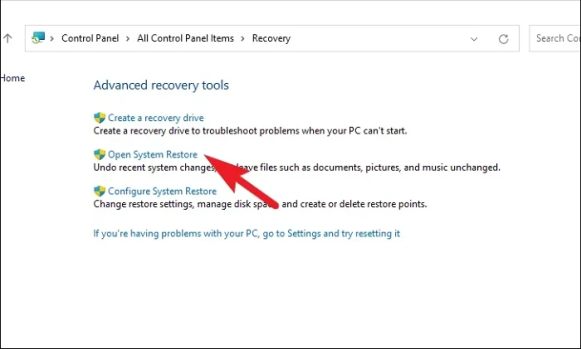

Далее выберите из списка пункт «Открыть восстановление системы». Это откроет отдельное окно на вашем экране.

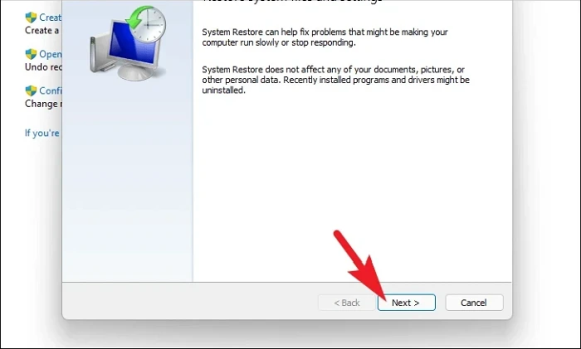

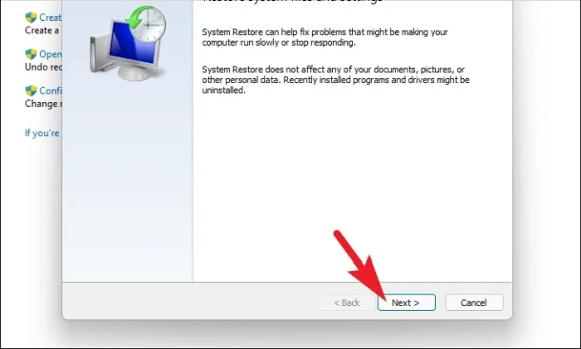

В отдельно открывшемся окне нажмите кнопку «Далее».

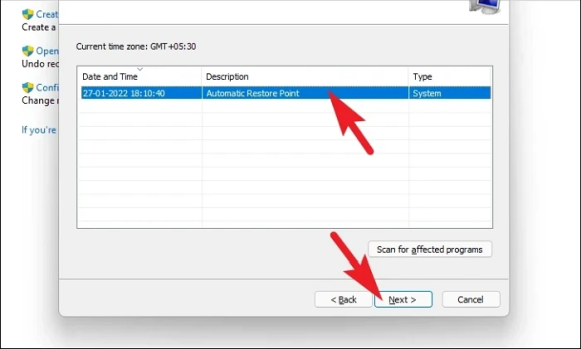

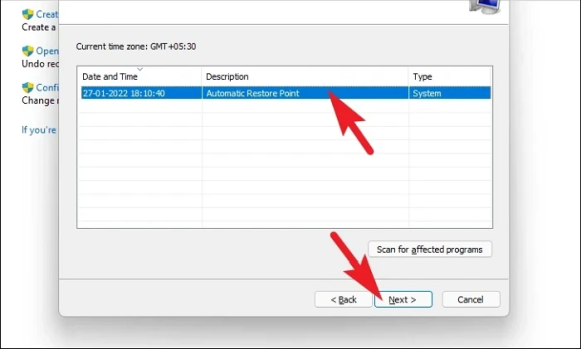

Все созданные точки восстановления системы будут перечислены на экране. Нажмите, чтобы выбрать нужный, а затем нажмите кнопку «Далее», чтобы начать процесс отката.

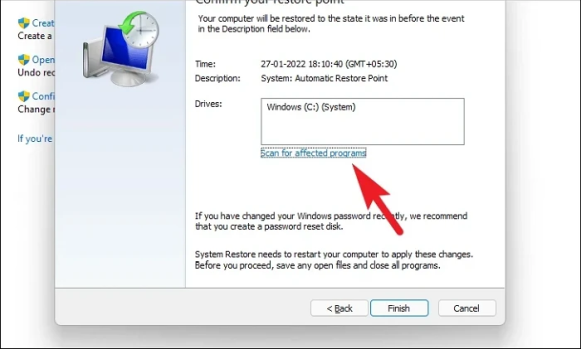

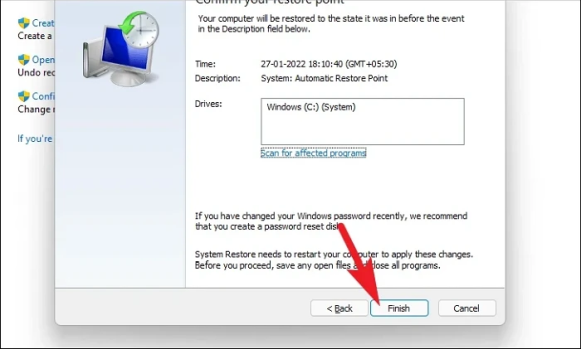

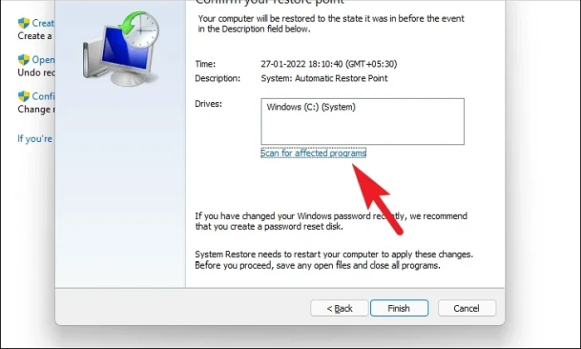

Далее отобразится список дисков, на которые повлияет откат, а также временная метка созданной точки восстановления. Вы также можете проверить программы, которые будут затронуты; нажмите кнопку «Сканировать на наличие уязвимых программ». На экране появится новое окно.

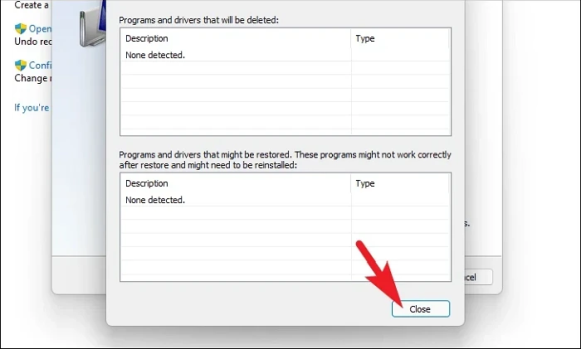

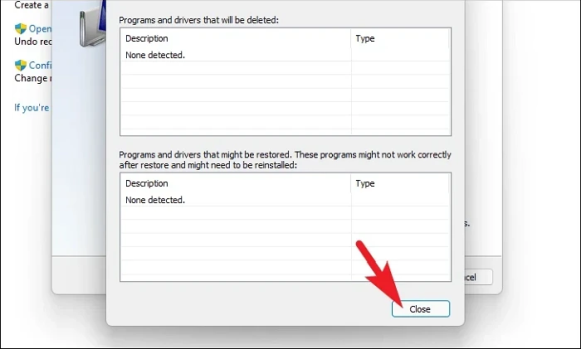

В новом окне вы можете просмотреть программы, которые будут удалены, и те, которые будут восстановлены (поскольку на тестовом ПК никакие программы затронуты не будут, список на скриншоте ниже пуст). Нажмите кнопку «Закрыть», чтобы перейти к предыдущему окну.

Наконец, нажмите кнопку «Готово», чтобы начать процесс отката.

После завершения отката проверьте, правильно ли работает ключ.

Неработающая клавиша Tab — особая проблема. Однако вы определенно сможете решить проблему с помощью исправлений, упомянутых в этом руководстве.

2023-02-17T13:33:57

Вопросы читателей