В этой статье я разбираю списки в Python 3. Вы узнаете, какими свойствами обладают списки и как можно с ними работать.

Архив рубрики: Публикации

Python 3. Строки

В этой статье я разбираю строки в Python 3. Вы узнаете, какими свойствами обладают строки и как можно с ними работать.

MKLINK — создание символической ссылки на файл или каталог

MKLINK — создание символической ссылки на файл или каталог

MKLINK — это команда в операционной системе Windows, которая позволяет создавать символьные или жесткие ссылки на файл или папку. Символьные ссылки представляют собой ссылки на файлы или папки, которые могут указывать на любое место в файловой системе. Жесткие ссылки представляют собой ссылки, которые указывают на определенный файл или папку в файловой системе.

Для использования команды MKLINK необходимо открыть командную строку Windows с правами администратора.

Примеры использования команды MKLINK

- Создание символьной ссылки на файл:mklink «C:путькссылкессылка.txt» «C:путькфайлуфайл.txt»

В данном примере будет создана символьная ссылка `ссылка.txt` на файл `файл.txt` в указанном пути

- Создание символьной ссылки на папку:mklink /d «C:путькссылке» «C:путькпапке»

В данном примере будет создана символьная ссылка `ссылка` на папку `папка` в указанном пути

- Создание жесткой ссылки на файл (доступно только в NTFS):mklink /h «C:путькссылкессылка.txt» «C:путькфайлуфайл.txt»

В данном примере будет создана жесткая ссылка `ссылка.txt` на файл `файл.txt` в указанном пути

- Удаление ссылки:del «C:путькссылкессылка.txt»

Данная команда удалит ссылку `ссылка.txt` в указанном пути

Команда MKLINK полезна для создания ссылок на файлы или папки, что позволяет сократить размер либо изменить структуру файловой системы, сохраняя доступ к исходным файлам или папкам. Также она может быть использована для создания резервных копий файлов и папок. Отметим, что команда MKLINK доступна только в операционных системах Windows, начиная с версии Vista.

2023-03-01T02:32:24Список команд CMD

Как включить или отключить автовоспроизведение в Windows 11

В этой статье объясняется, как включить или отключить автозапуск в Windows 11.

Настройки автозапуска позволяют пользователям выбирать различные действия, когда устройства вставлены или подключены к компьютеру с Windows .

По умолчанию Windows отображает уведомление, чтобы выбрать, какие действия следует предпринять при вставке носителя или подключении нового устройства. Эти настройки применяются к таким носителям, как фотографии, музыка и видео, которые хранятся на дисках, компакт-дисках, DVD-дисках, камерах и телефонах.

Windows позволяет сбросить настройки автозапуска, изменить ранее выбранные действия, а также полностью отключить или включить автозапуск.

Windows также позволяет пользователям обходить настройки автозапуска, удерживая нажатой клавишу SHIFT при вставке внешнего носителя в свой компьютер, чтобы отобразить уведомление о том, какое действие следует предпринять.

Включить или отключить автозапуск в Windows 11

Как упоминалось выше, пользователи могут включать или отключать автозапуск в Windows, чтобы уведомления не отображались. Windows не может действовать, когда носитель вставлен или подключен к их компьютеру.

Вот как это сделать.

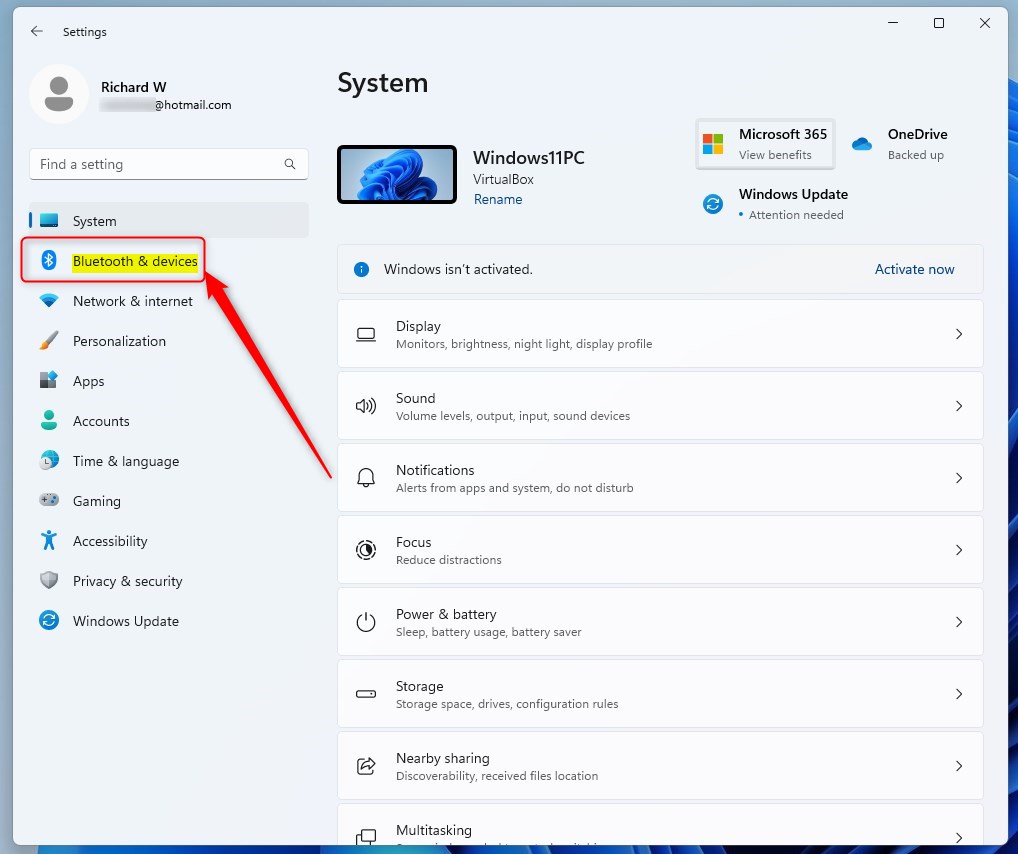

Сначала откройте приложение «Параметры Windows».

Вы можете сделать это, щелкнув меню «Пуск» и выбрав Settings. Или нажмите сочетание клавиш (Windows key+I), чтобы запустить приложение «Настройки».

Когда откроется приложение «Настройка», нажмите Bluetooth & devicesкнопку слева.

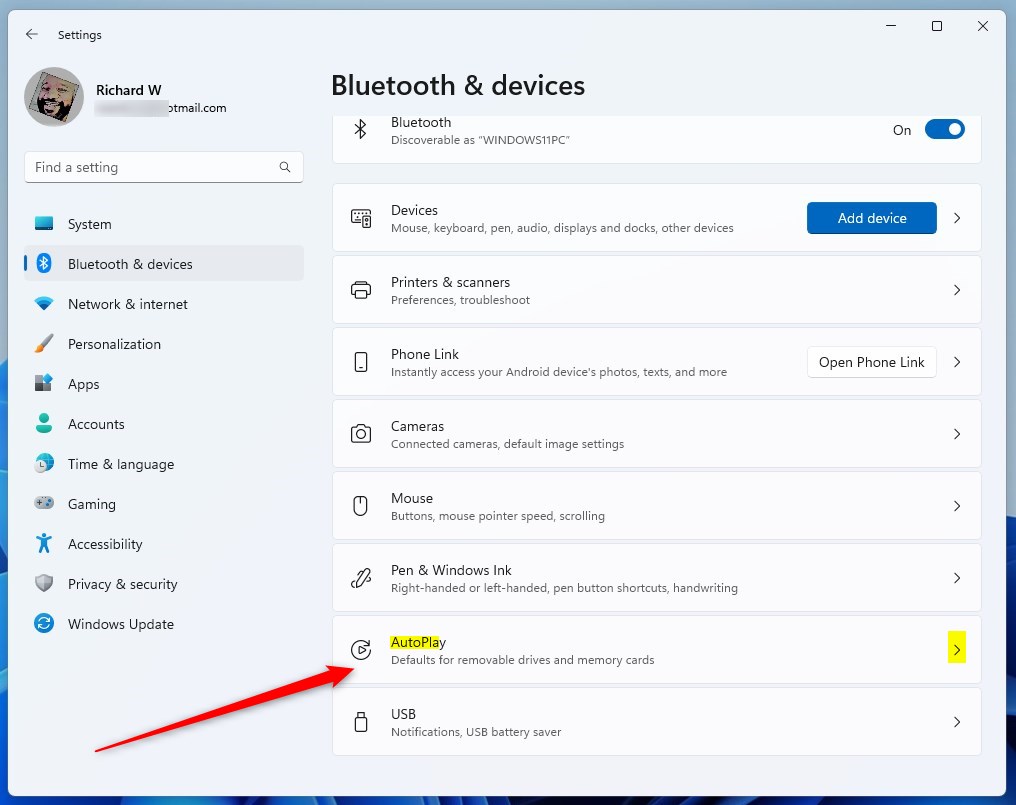

Справа выберите AutoPlayплитку, которую нужно развернуть.

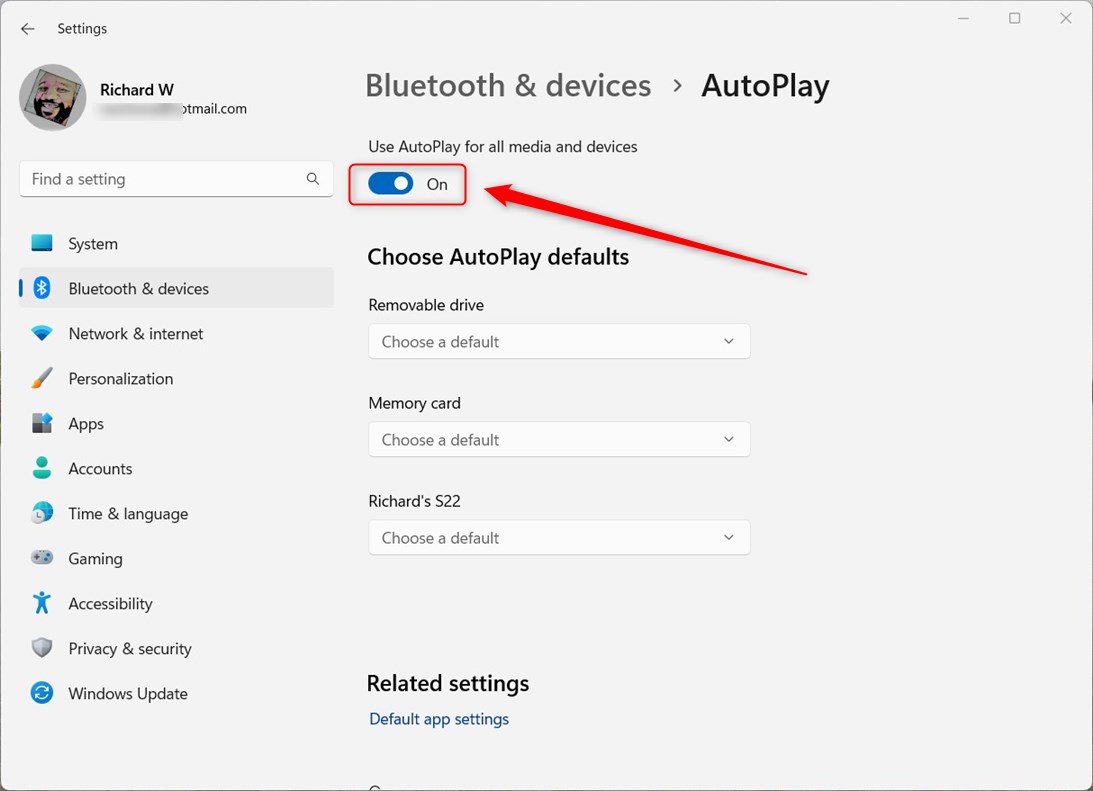

На Bluetooth & devices -> AutoPlayпанели настроек переведите AutoPlay кнопку в положение Onили Off, чтобы включить или отключить автозапуск в Windows.

Выйдите из приложения «Настройки», когда закончите.

Включите или отключите автозапуск с помощью приложения панели управления.

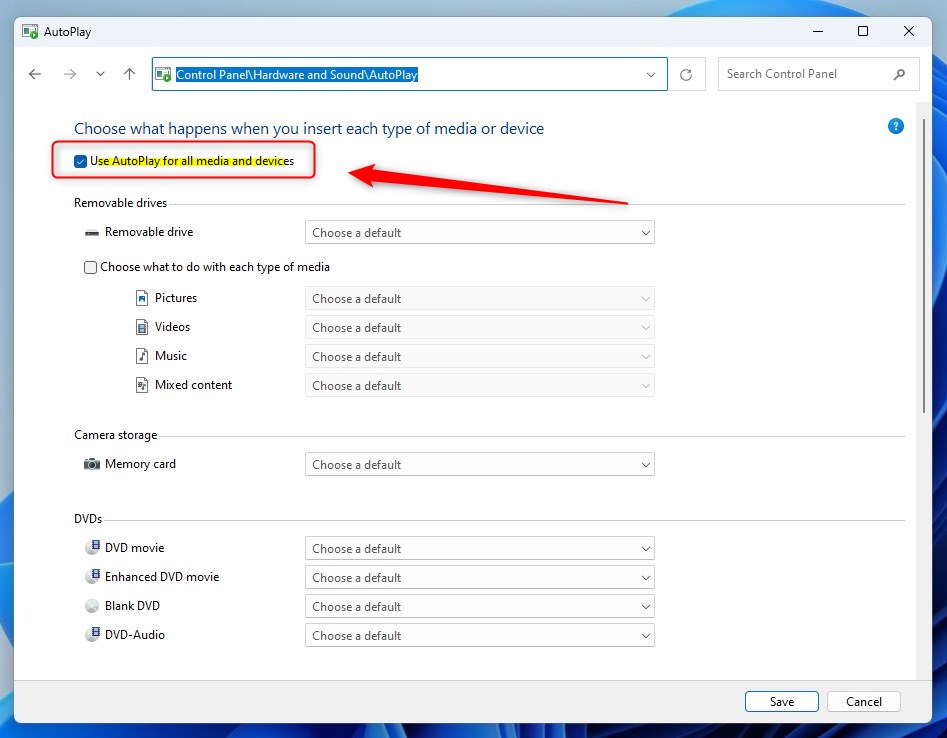

Другой способ включить или отключить автозапуск в Windows — из Control Panelприложения. Для этого сначала откройте приложение «Панель управления».

Затем перейдите в Панель управления -> Оборудование и звук -> Панель автозапуска.

Панель управления -> Оборудование и звук -> Автозапуск

На странице настроек автозапуска установите или снимите флажок «Использовать автозапуск для всех носителей и устройств», чтобы включить или отключить автозапуск в Windows.

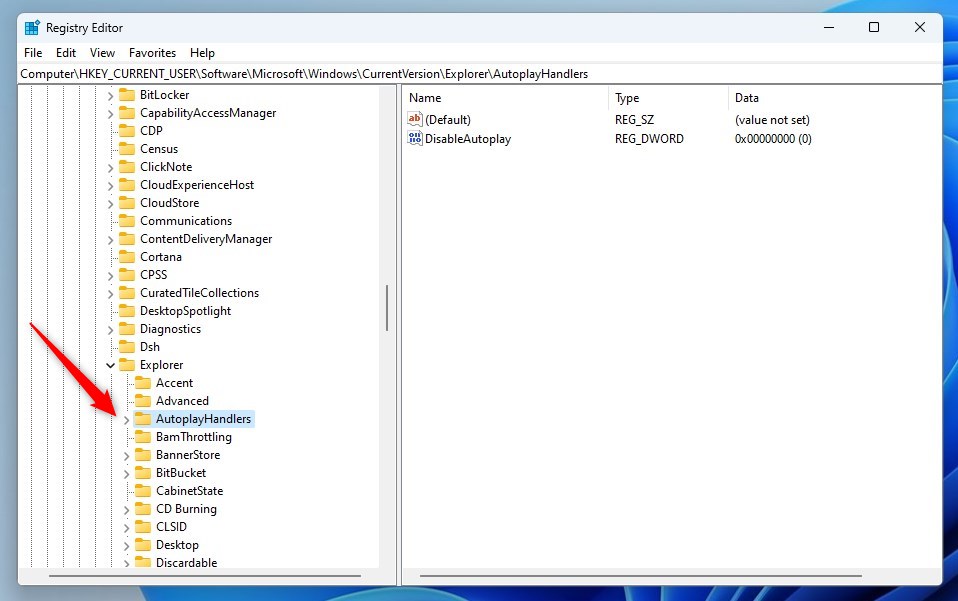

Включить или отключить автозапуск через реестр Windows

Еще один способ включить или отключить функцию автозапуска в Windows — использовать редактор реестра Windows.

Сначала откройте реестр Windows и перейдите к указанному ниже пути к ключу папки.

HKEY_CURRENT_USERSoftwareMicrosoftWindowsCurrentVersionExplorerAutoplayHandlers

Если вы не видите ключ папки, щелкните его правой кнопкой мыши и создайте папки подраздела (). AutoplayHandlersExplorerAutoplayHandlers

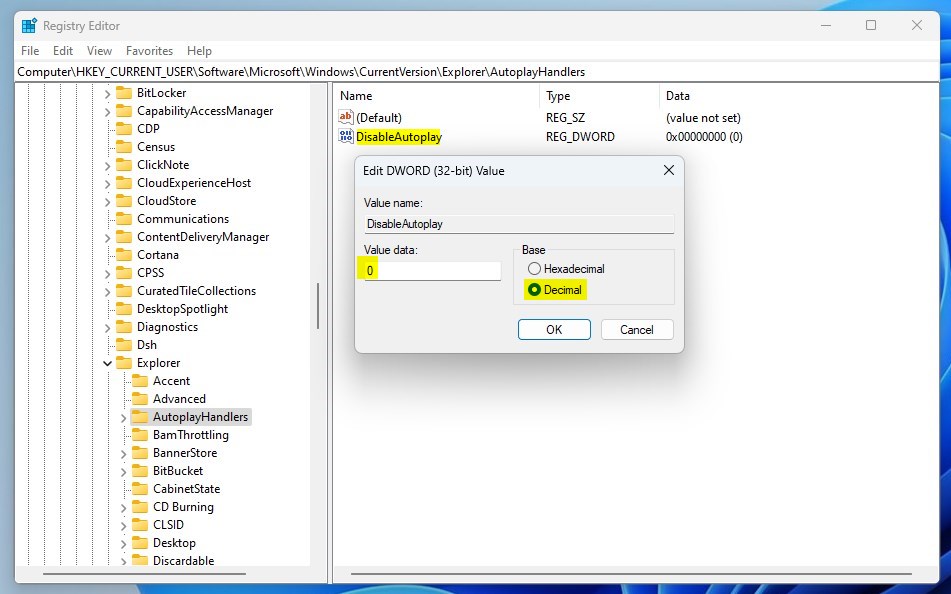

Щелкните правой кнопкой мыши AutoplayHandlersна правой панели ключа папки и выберите «Создать» -> «Значение DWORD (32-разрядное)». Затем введите новый ключ с именем DisableAutoplay.

Дважды щелкните имя нового ключевого элемента (DisableAutoplay) и убедитесь, что для параметра «Базовый» установлено значение «Десятичное число», а затем обновите данные «Значение», убедившись, что вы сохранили существующее значение:

- Чтобы включить эту функцию. Тип 0.

- Чтобы отключить эту функцию. Тип 1.

Сохраните изменения и перезагрузите компьютер.

Это должно сделать это!

Вывод:

В этом посте показано, как включить или отключить функцию автозапуска в Windows 11. Если вы обнаружите какие-либо ошибки выше или вам есть что добавить, воспользуйтесь формой комментариев ниже.

Что такое Notion AI и чем он отличается от ChatGPT и Bing AI

Какое одно слово или, вернее, два слова, вы повсюду слышите в эти дни? Правильно — искусственный интеллект! ИИ стал последним увлечением в мире технологий, и новые инструменты появляются быстрее, чем вы успеваете их обдумать.

Но не каждый инструмент ИИ окажет влияние на рынок, который начинает насыщаться. ChatGPT и Bing AI уже вызвали немало волнений. И теперь Notion AI — новое дополнение к этому списку. Но если вы начинаете перегружаться всеми этими инструментами, которые, кажется, начинают растворяться в одной категории ИИ, не волнуйтесь. Все они могут быть инструментами на основе ИИ, но они сильно отличаются друг от друга, и мы поможем вам понять, как именно.

Что такое понятие ИИ

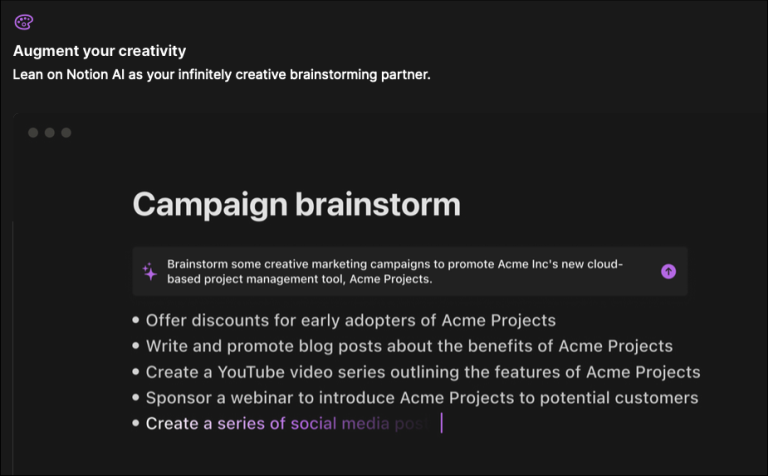

Notion AI — это набор функций искусственного интеллекта, которые вы можете найти в приложении для повышения производительности и создания заметок Notion. Благодаря множеству организационных инструментов, таких как управление задачами, списки дел, отслеживание проектов, создание закладок и т. д., Notion является чрезвычайно популярным инструментом рабочего пространства для команд и организаций.

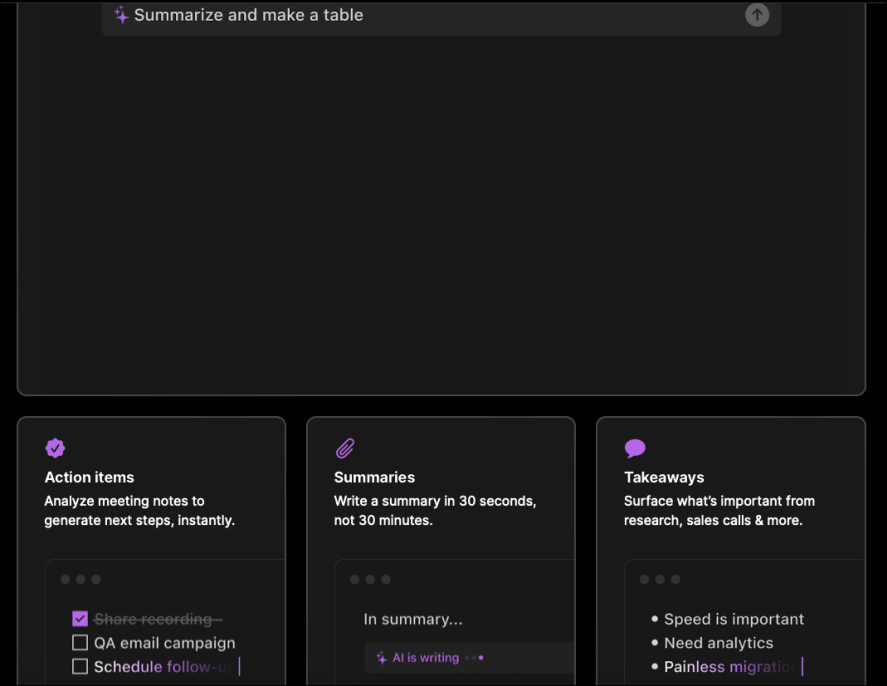

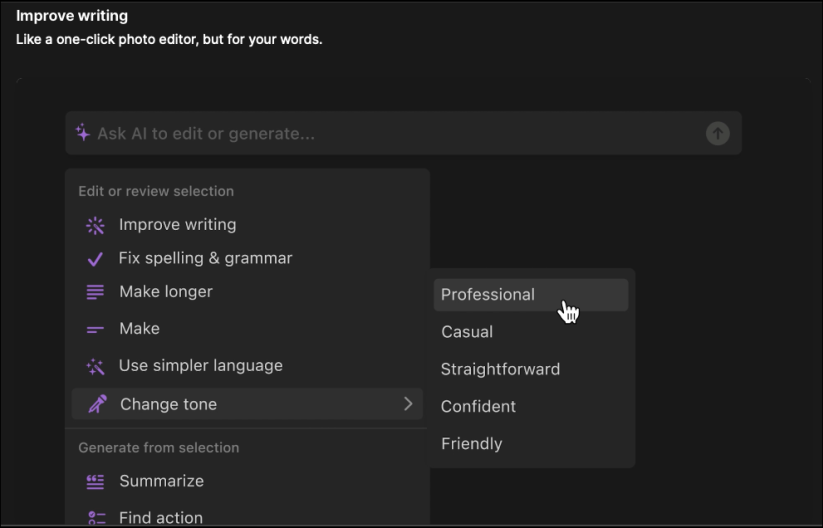

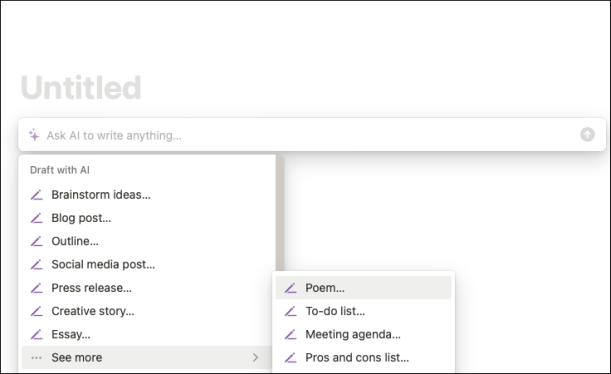

Notion AI призван дополнить ваш опыт работы в приложении Notion. Для доступа к нему нет отдельного веб-приложения. В настоящее время ИИ может помочь вам писать, обобщать, проводить мозговой штурм, редактировать, переводить и переписывать контент, среди прочего. В отличие от других инструментов искусственного интеллекта, которые вы должны использовать отдельно, преимущество использования Notion AI заключается в том, что он работает в приложении Notion. Итак, если вы уже являетесь пользователем Notion, вы найдете его наиболее полезным.

Вы можете выполнять различные задачи с помощью Notion AI. Например, если у вас уже есть заметки в приложении Notion, вы можете попросить ИИ обобщить их и даже представить их в различных формах, таких как таблица, действия и т. д., без необходимости переходить в другое приложение.

Вы даже можете попросить его переписать любой контент в другом тоне, помочь вам провести мозговой штурм идей и сделать его вашим компаньоном по письму, попросив его продолжить то, что вы написали. Он также может писать сообщения в блогах, пресс-релизы, сообщения в социальных сетях, эссе, рассказы и т. д. с нуля. В целом, это может помочь вам выполнить множество письменных задач за более короткий период времени.

Он обучен на больших языковых моделях, что позволяет ему понимать контекст и писать текст за вас.

Вы можете получить доступ к Notion AI на странице Notion, используя spaceключ, /команды (косая черта) или выделив любой текст и попросив AI выполнить действие.

Notion AI против ChatGPT против Bing AI

Теперь, когда вы знаете, что такое Notion AI, давайте посмотрим, чем он отличается от двух самых популярных инструментов искусственного интеллекта в Интернете прямо сейчас — ChatGPT и Bing AI.

ChatGPT — это диалоговая модель, которая генерирует ответы в человеческом стиле. Он может отвечать как на общие, так и на технические вопросы. Он не только может объяснить вам такие понятия, как теория Большого взрыва, в более простых терминах, но также может помочь вам с вопросами кодирования. Как и в случае с Notion AI, вы также можете обратиться к нему за помощью, чтобы обобщить или переписать контент или набросать идеи с нуля.

Но поскольку ChatGPT является автономным инструментом, вам придется копировать и вставлять любой контент снова и снова в веб-приложение, чтобы заставить его делать такие вещи, как обобщение, переписывание, предоставление элементов действий и т. д. Однако, по своей сути, это инструмент для общения с чат-ботом, не настроенный на то, чтобы помогать вам с письменными задачами, как это делает Notion AI.

С другой стороны, у Bing AI совершенно другая цель. Интегрированный в поисковую систему Bing в браузере Microsoft Edge, его основная цель — помочь вам с вашими поисковыми запросами и помочь вам более эффективно находить информацию.

Он также имеет режим чата, в котором пользователи могут общаться с Bing AI, но, поскольку это не является его основной целью, Bing AI генерирует ответы, которые нервируют пользователей, когда разговор становится длиннее. Фактически, Microsoft недавно ограничила количество ответов Bing AI в режиме чата; после определенного числа он полностью избегает предоставления какого-либо ответа, и вам приходится начинать новый чат.

Notion AI не имеет диалоговых возможностей, таких как ChatGPT, или функций поиска, таких как Bing AI. Его цель — помочь вам писать лучше, и он прекрасно справляется с этой задачей. Ни один из других инструментов не может помочь вам улучшить ваше письмо так, как это может сделать Notion AI. Notion AI также доступен в мобильных приложениях Notion, что делает его гораздо более доступным, чем другие.

В отличие от Bing AI, Notion AI не подключен к Интернету и не имеет информации за последние несколько месяцев. В этом отношении он похож на ChatGPT. Поэтому иногда он может предоставлять устаревшую информацию. Кроме того, как и любой другой инструмент ИИ, он может предоставлять предвзятую или вредную информацию, несмотря на его обучение.

Понятие ценообразования ИИ

Понятие AI резко отличается от ChatGPT и Bing AI в одном аспекте; это не бесплатно. Хотя Notion AI находился в стадии альфа-тестирования с ноября 2022 года, вы могли использовать его бесплатно, если у вас был доступ. Но теперь это платная функция после ее общего выпуска. Каждый пользователь Notion может бесплатно опробовать ИИ за ограниченное количество ответов — 20 на участника. Однако бесплатные ответы доступны только до 5 апреля 2023 года. Каждый ответ, который генерирует ИИ, засчитывается в вашу бесплатную квоту. Даже если вы попросите его «Попробовать еще раз» для подсказки, это будет засчитано как ответ.

В конце концов, вам придется купить дополнительный план для Notion AI, когда у вас закончатся бесплатные ответы или когда закончится период акции. Это стоит около 8–10 долларов в месяц на члена в зависимости от вашего плана и способа оплаты. С дополнительной подпиской каждый участник в вашей рабочей области получает доступ к неограниченным ответам от ИИ.

ChatGPT, с другой стороны, можно использовать бесплатно, но вы всегда можете получить доступ из-за перегрузки сервера, в то время как подписка ChatGPT Plus стоит 20 долларов в месяц. В настоящее время Bing AI также можно использовать бесплатно, но есть список ожидания для получения доступа к поисковому роботу.

Notion AI — отличный инструмент для пользователей, которым нужен уникальный и мощный инструмент искусственного интеллекта для генеративного письма. И если вы уже используете инструменты Notion для совместной работы со своей командой, вам не составит труда попробовать их.

Как использовать AUR с Arch Linux

Репозиторий пользователей Arch называется AUR. Это предоставляемая пользователями библиотека пакетов для Arch Linux, управляемая сообществом. Хотя Arch Linux официально не поддерживает эти инструменты, менеджер пакетов Pacman упрощает их сборку и управление ими. Пакеты AUR часто более поздние, чем пакеты в официальном репозитории Arch Linux, поскольку они обычно создаются из исходного кода. Но пакеты AUR не включены в официальные репозитории Arch Linux и могут быть не так хорошо протестированы или стабильны, как официальные пакеты. В этой статье рассказывается, как можно использовать AUR в Arch Linux.

Зачем использовать AUR?

Использование AUR в Arch Linux возможно по нескольким причинам, включая следующие:

Доступ к дополнительным приложениям : AUR предоставляет пользователям доступ к различным приложениям, которые не включены в официальный репозиторий Arch Linux. Программное обеспечение, которое не считается «бесплатным» или «открытым исходным кодом», или более новые варианты существующего программного обеспечения могут подпадать под эту категорию.

Пакеты, поддерживаемые сообществом : сообщество Arch Linux несет ответственность за поддержку AUR. Поскольку люди, которые разрабатывают и поддерживают эти пакеты, с энтузиазмом относятся к технологиям, которые они упаковывают, в результате могут получиться более качественные и более свежие пакеты.

Гибкость : установка пакетов из AUR позволяет пользователям изменять настройки Arch Linux, добавляя компоненты, которые могут быть недоступны в официальном репозитории. Пользователи с особыми требованиями или интересами могут найти это полезным.

Простота использования : использование менеджера пакетов Pacman и таких утилит, как Yaourt, которые упрощают процесс получения, создания и установки пакетов AUR, делают установку пакетов из AUR достаточно простой.

Update и Upgrade Arch Linux

Прежде чем взглянуть на использование утилиты AUR в Arch Linux, убедитесь, что все необходимые компоненты уже установлены. Он включает в себя обновление уже установленных инструментов вместе с установкой новых инструментов. Поэтому мы используем утилиту Pacman для обновления и обновления нашего Arch Linux с последующей опцией –Syu. Параметр «-Syu» указывает Pacman синхронизировать базы данных пакетов и выполнить полное обновление системы. Вывод показывает, что базы данных пакетов (основная, дополнительная, сообщество и мультибиблиотека) уже обновлены и доступных обновлений нет. Затем система сообщает, что делать нечего, что означает, что система уже обновлена и нет свежих обновлений для установки.

[andreyex@andreyex ~]$ sudo pacman -Syu

Установите пакет Base-Devel

Пришло время установить пакет base-devel в нашей системе Arch Linux. Он включает в себя все необходимые пакеты сборки нашего Arch Linux. Команда, используемая для этой инструкции, отключает диспетчер пакетов «pacman», за которым следует опция «-S», чтобы загрузить и установить пакет base-devel из «Git». Вывод показывает, что «Git» уже обновлен и что base-devel — это группа из 26 пакетов, которые будут установлены. Общий установленный размер составляет 309,48 МБ. Затем система предлагает пользователю подтвердить, хотят ли они продолжить установку. Если они выберут «да», процесс установки запускает различные хуки, такие как создание учетных записей пользователей системы, перезагрузка конфигурации системного администратора, создание временных файлов, активация ConditionNeedsUpdate и обновление файла каталога информации.

[andreyex@andreyex ~]$ sudo pacman -S git base-devel

Клонировать пакет AUR

Возможно, вы знали, что браузер Google Chrome является одним из пакетов AUR, который официально не поддерживается системой Arch Linux. Таким образом, если вы хотите установить его в своей системе, вам необходимо сначала клонировать его, используя инструкцию по клонированию с официального сайта контроля версий «Git». Поэтому мы пытаемся выполнить следующую инструкцию по клонированию Git, за которой следует URL-адрес репозитория google-chrome в Git. При выполнении этой инструкции репозиторий google-chrome клонируется на нашу локальную машину, которой является Arch Linux. Папка с именем «google-chrome» содержит клонированный пакет. Выходные данные показывают ход процесса клонирования, включая количество загружаемых объектов, сжатие файлов и общий размер репозитория. После завершения клонирования отображается сообщение «Готово».

[andreyex@andreyex ~]$ git clone https://aur.archlinux.org/google-chrome.git

После клонирования пакета AUR google-chrome мы используем этот пакет. Команда «cd», что означает «change directory (изменить каталог)», используется для просмотра файловой системы компьютера. В этом случае операция используется для переключения в каталог с именем «google-chrome» из текущего рабочего каталога. Рабочий каталог, в котором теперь выполняется команда, должен содержать каталог.

[andreyex@andreyex ~]$ cd google-chrome/

Команда makepkg — это инструмент, который используется для сборки пакетов для дистрибутива Arch Linux и его производных. Параметры «-sri» указывают makepkg выполнить сборку только из исходного кода, используя «-s», -r: для установки необходимых пакетов для сборки пакета и -i: для установки пакета после его сборки. Вывод показывает, что makepkg собирает пакет «google-chrome» с номером версии «109.0.5414.119-1. Затем он проверяет зависимости среды выполнения и устанавливает все отсутствующие зависимости. В данном случае это пакет ttf-liberation версии 2.1.5-1. Он показывает общий размер загрузки и общий установленный размер для этого пакета. Затем он запрашивает у пользователя подтверждение для продолжения установки. Затем он извлекает пакет ttf-liberation-2.1.5-1. Окончательно, он проверяет зависимости времени сборки и извлекает исходники из Интернета. Эта команда успешно устанавливает пакет google-chrome в Arch Linux и его производных.

andreyex@andreyex google-chrome]$ makepkg -sri

Есть еще один способ установить пакеты AUR, если команда makepkg не работает по какой-то скрытой причине. Используйте пакет «yay» для установки пакета AUR, такого как Google Chrome, как показано ниже:

[andreyex@andreyex yay]$ yay -Ss google-chrome

Заключение

Важно помнить, что пакеты AUR официально не поддерживаются программистами Arch Linux и могут быть не так тщательно протестированы или стабильны, как авторизованные пакеты. Перед установкой очень важно ознакомиться с отзывами и рекомендациями по пакету. В этой статье мы объяснили, как легко установить некоторые пакеты AUR, такие как Google Chrome, на Arch Linux. Здесь объясняется метод, который охватывает клонирование пакета Google Chrome на локальном компьютере Arch Linux с помощью инструкции по клонированию Git.