Сегодня мы рассмотрим систему полнотекстового поиска, она позволяют искать слова в большом наборе документов и сортируют результаты поиска по релевантности найденных документов запросу. Алгоритмы полнотекстового поиска относятся к числу важнейших среди алгоритмов коллективного разума. Новые идеи в этой области помогли сколотить целые состояния. Широко распространено мнение, что своей быстрой эволюцией от академического проекта к самой популярной поисковой машине в мире система Google обязана прежде всего алгоритму ранжирования страниц PageRank.

Что такое поисковая машина

Итак, давайте же создадим здоровую конкуренцию мировым поисковикам!) Статья так же будет полезна начинающим SEO специалистам, т.к. покажет некоторые величины, которые могут влиять на позиции вашего сайта в поиске.

Первый шаг при создании поисковой машины – разработать методику сбора документов. Иногда для этого применяется ползание (начинаем с небольшого набора документов и переходим по имеющимся в них ссылкам), а иногда отправной точкой служит фиксированный набор документов, быть может, хранящихся в корпоративной сети интранет.

Далее собранные документы необходимо проиндексировать. Обычно для этого строится большая таблица, содержащая список документов и вхождений различных слов. В зависимости от конкретного приложения сами документы могут и не храниться в базе данных; в индексе находится лишь ссылка (путь в файловой системе или URL) на их местонахождение

Ну и последний шаг – это, конечно, возврат ранжированного списка документов в ответ на запрос. Имея индекс, найти документы, содержащие заданные слова, сравнительно несложно; хитрость заключается в том, как отсортировать результаты. Можно придумать огромное количество метрик, и недостатков в них.

class Indexer:

def __init__(self):

self.conn = psycopg2.connect("dbname='postgres' user='postgres' password='120789' host='localhost'")

self.cur = self.conn.cursor()

self.cur.execute("set search_path to 'rambler_search'")

self.grab = Grab()

def __del__(self):

self.conn.close()

def dbcommit(self):

self.conn.commit()

Код паука

Эта функция в цикле обходит список страниц, вызывая для каждой функцию addtoindex. Далее она получает все ссылки на данной странице и добавляет их URL в список newpages. В конце цикла newpages присваивается pages, и процесс повторяется.

Эту функцию можно было бы определить рекурсивно, так что при обработке каждой ссылки она вызывала бы сама себя. Но, реализовав поиск в ширину, мы упростим модификацию кода в будущем, позволив пауку ползать непрерывно или сохранять список неиндексированных страниц для последующего индексирования. Кроме того, таким образом мы избегаем опасности переполнить стек.

# Начинаем со списка страниц для индексации

# опускаемся в глубину на 2 уровня

def crawl(self, pages, depth=2):

rambler_news_href_pattern = re.compile(r'(^http://news.rambler.ru/[d]+)')

for i in range(depth):

newpages={}

for page in pages:

try:

self.grab.go(page)

except:

print "Could not open %s" % page

continue

try:

article_text = '' # текст статьи

for paragraph in self.grab.tree.xpath("//p[contains(@class, 'b-article__paragraph')]"):

article_text += paragraph.text_content()

self.addtoindex(page, article_text) # записываем в базу текст статьи с индексацией

links = self.grab.tree.xpath("//a")

for link in links:

if ('href' in link.attrib):

url = urljoin(page, link.attrib['href']).split('#')[0]# делаем полную ссылку и удаляем часть за # если она есть

match = rambler_news_href_pattern.findall(url)

if match:

url = match[0]

if url[0:4] == 'http' and not self.isindexed(url):

newpages[url] = 1

linkText = link.text_content() # текст ссылки

self.addlinkref(page, url, linkText) # записываем в базу текст ссылки с индексацией

self.dbcommit()

except Exception, e:

print "Could not parse page %s" % page, e

pages = newpages

Построение индекса

Наш следующий шаг – подготовка базы данных для хранения полнотекстового индекса. Я уже говорил, что такой индекс представляет собой список слов, с каждым из которых ассоциировано множество документов, где это слово встречается, и место вхождения слова в документ. В данном примере мы анализируем только текст на странице, игнорируя все нетекстовые элементы. Кроме того, индексируются только сами слова, а все знаки препинания удаляются. Такой метод выделения слов несовершенен, но для построения простой поисковой машины сойдет.

Создание схемы

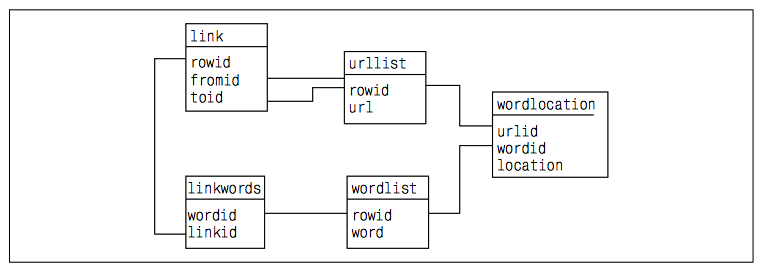

Подождите запускать программу – нужно сначала подготовить базу данных. Схема простого индекса состоит из пяти таблиц. Первая (url_list) – это список проиндексированных URL. Вторая (word_list) – список слов, а третья (word_location) – список мест вхождения слов в документы. В оставшихся двух таблицах хранятся ссылки между документами. В таблице link хранятся идентификаторы двух URL, связанных ссылкой, а в таблице link_words есть два столбца – word_id и link_id – для хранения слов, составляющих ссылку. Вся схема изображена на рисунке ниже. Код запросов приводить не буду, должны ведь и вы поработать)))

Выделение слов на странице

def getwords(html):

words = []

for split_str in html.split():

t = re.split("[s;:-_*".,?!()'&#«»]", split_str)

words += [a.lower() for a in t if a != '' and len(a) > 3]

return words

Добавление в индекс

Теперь мы готовы написать код метода addtoindex. Он вызывает две функции, написанные в предыдущем разделе, чтобы получить список слов на странице. Затем эта страница и все найденные на ней слова добавляются в индекс и создаются ссылки между словами и их вхождениями в документ. В нашем примере адресом вхождения будет считаться номер слова в списке слов.

def addtoindex(self, url, text):

if self.isindexed(url): return # если уже индексирована - пропускаем

print 'Indexing %s' % url

# Получаем слова из текста

words = getwords(text)

# Получаем id url'а

url_id = self.getentryid('url_list', 'url', url)

# Связываем слова с этим урлом

for i, word in enumerate(words): # пронумеруем слова

word_id = self.getentryid('word_list', 'word', word)

self.cur.execute("insert into word_location(url_id, word_id, location) values (%d, %d, %d)" % (url_id, word_id, i))

self.dbcommit()

# Узнаем id записи в БД, если нет

# иначе записываем и возвращаем новый

def getentryid(self, table, field, value, createnew=True):

self.cur.execute("select id from %s where %s = '%s'" % (table, field, value))

cur = self.cur.fetchone()

if not cur:

# print (table, field, value)

self.cur.execute("insert into %s (%s) values ('%s') returning %s.id" % (table, field, value, table))

cur = self.cur.fetchone()

self.dbcommit()

return cur[0]

else:

return cur[0]

# Возвращаем True, если посещали страницу

def isindexed(self, url):

self.cur.execute("select id from url_list where url = '%s'" % url)

u = self.cur.fetchone()

if u:

# Проверяем, что паук посещал страницу

self.cur.execute("select count(1) from word_location where url_id = %d" % u[0])

v = self.cur.fetchone()

if v[0]:

return True

return False

Последняя функция, необходимая нам для начала индексирования — это addlinkref. Как следует из ее названия, она заносит ссылки и слова из которых они состоят к нам в БД.

def addlinkref(self, urlFrom, urlTo, linkText):

words = getwords(linkText)

from_id = self.getentryid('url_list', 'url', urlFrom)

to_id = self.getentryid('url_list', 'url', urlTo)

if from_id == to_id: return

self.cur.execute("insert into link(from_id, to_id) values (%d, %d) returning link.id" % (from_id, to_id))

link_id = self.cur.fetchone()[0]

for word in words:

word_id = self.getentryid('word_list', 'word', word)

self.cur.execute("insert into link_words(link_id, word_id) values (%d, %d)" % (link_id, word_id))

Ну что же, на этом этапе мы можем запустить паука и создать базу данных)

Запросы

ого, грубого поиска, по абсолютному вхождению фразы в новость.

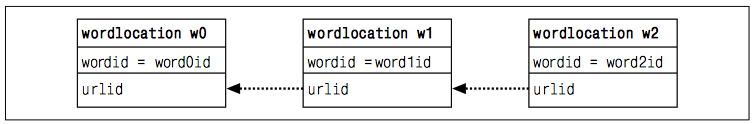

Таблица word_location обеспечивает простой способ связать слова с документами, так что мы можем легко найти, какие страницы содержат данное слово. Однако поисковая машина была бы довольно слабой, если бы не позволяла задавать запросы с несколькими словами. Чтобы исправить это упущение, нам понадобится функция, которая принимает строку запроса, разбивает ее на слова и строит SQL-запрос для поиска URL тех документов, в которые входят все указанные слова.

def get_match_rows(self, query):

select_query_add = []

join_query_add = []

where_query_add = []

main_search_query = """

SELECT wl0.url_id, %s

FROM word_location wl0

%s

WHERE %s

"""

query_words = getwords(query)

query_word_ids = []

for query_word in query_words:

self.cur.execute("select id from word_list where word = '%s'" % query_word)

query_word_id = self.cur.fetchone()

if query_word_id:

query_word_ids.append(query_word_id[0])

if query_word_ids:

for position, query_word_id in enumerate(query_word_ids):

if position:

join_query_add.append('JOIN word_location wl%d ON wl%d.url_id = wl%d.url_id' % (position, position-1, position))

select_query_add.append('wl%d.location' % position)

where_query_add.append('wl%d.word_id = %d' % (position, query_word_id))

main_search_query = main_search_query % (', '.join(select_query_add), ' '.join(join_query_add), ' and '.join(where_query_add))

self.cur.execute(main_search_query)

search_results = self.cur.fetchall()

return search_results, query_word_ids

SELECT wl0.url_id, wl0.location, wl1.location

FROM word_location wl0

JOIN word_location wl1 ON wl0.url_id = wl1.url_id

WHERE wl0.word_id = 2734 and wl1.word_id = 2698

В результате, получаем список кортежей и список с id слов. Каждый кортеж — это сто список вида (id новости, позиция 1го слова, позиция 2го слова…)

Ранжирование по содержимому

В этом разделе мы рассмотрим несколько способов вычисления ранга

на основе самого запроса и содержимого страницы, а именно:

- Частота слов

Количество вхождений в документ слова, указанного в запросе, помогает определить степень релевантности документа.

- Расположение в документе

Основная тема документа, скорее всего, раскрывается ближе к его началу.

- Расстояние между словами

Если в запросе несколько слов, то они должны встречаться в документе рядом.

# Функция, которая взвешивает результаты

def get_scored_list(self, rows, word_ids):

total_scores = {row[0]: 0 for row in rows}

if rows:

# Список весовых функций

weight_functions = [

]

for (weight, scores) in weight_functions:

for url in total_scores:

total_scores[url] += weight * scores[url]

return total_scores

# Возвращает полный урл по id

def get_url_name(self, url_id):

self.cur.execute("select url from url_list where id = %d" % url_id)

return self.cur.fetchone()[0]

# Основная функция поиска

def search(self, search_sentence):

search_results, word_ids = self.get_match_rows(search_sentence)

scores = self.get_scored_list(search_results, word_ids)

ranked_scores = [(score, url) for (url, score) in scores.items()]

ranked_scores.sort()

ranked_scores.reverse()

for (score, url_id) in ranked_scores[0:10]:

print '%ft%s' % (score, self.get_url_name(url_id))

return word_ids, [r[1] for r in ranked_scores[0:10]]

Наиболее важна здесь функция get_scored_list, код которой мы будем постепенно уточнять. По мере добавления функций ранжирования мы будем вводить их в список weight_functions и начнем взвешивать полученные результаты.

Функция нормализации

имо как-то нормализовать их, то есть привести к одному и тому же диапазону и направлению.

Функция нормализации принимает на входе словарь идентификаторов и рангов и возвращает новый словарь, в котором идентификаторы те же самые, а ранг находится в диапазоне от 0 до 1. Ранги масштабируются по близости к наилучшему результату, которому всегда припи- сывается ранг 1. От вас требуется лишь передать функции список рангов и указать, какой ранг лучше – меньший или больший:

def normalize_scores(self, scores, smallIsBetter=0):

vsmall = 0.00001 # Avoid division by zero errors

if smallIsBetter:

minscore = min(scores.values())

return {u: float(minscore)/max(vsmall, l) for (u,l) in scores.items()}

else:

maxscore = max(scores.values())

if maxscore == 0: maxscore = vsmall

return {u: float(c)/maxscore for (u,c) in scores.items()}

return scores

Весовые функции

Частота слов

Метрика, основанная на частоте слов, ранжирует страницу исходя из того, сколько раз в ней встречаются слова, упомянутые в запросе. Если я выполняю поиск по слову python, то в начале списка скорее получу страницу, где это слово встречается много раз, а не страницу о музыканте, который где-то в конце упомянул, что у него дома живет питон.

def frequency_score(self, rows):

counts = {row[0]:0 for row in rows}

for row in rows:

counts[row[0]] += 1

return self.normalize_scores(counts)

Чтобы активировать ранжирование документов по частоте слов, измените строку функции get_scored_list, где определяется список weight_functions, следующим образом:

weight_functions = [(1.0,self.frequency_score(rows))]

Расположение в документе

Еще одна простая метрика для определения релевантности страницы запросу – расположение поисковых слов на странице. Обычно, если страница релевантна поисковому слову, то это слово расположено близко к началу страницы, быть может, даже находится в заголовке.

def location_score(self, rows):

locations = {}

for row in rows:

loc = sum(row[1:])

if locations.has_key(row[0]):

if loc < locations[row[0]]:

locations[row[0]] = loc

else:

locations[row[0]] = loc

return self.normalizescores(locations, smallIsBetter=1)

Расстояние между словами

Если запрос содержит несколько слов, то часто бывает полезно ранжировать результаты в зависимости от того, насколько близко друг к другу встречаются поисковые слова. Как правило, вводя запрос из нескольких слов, человек хочет найти документы, в которых эти слова концептуально связаны. Рассматриваемая метрика допускает изменение порядка и наличие дополнительных слов между поисковыми.

def distance_score(self, rows):

mindistance = {}

# Если только 1 слово, любой документ выигрывает

if len(rows[0]) <= 2:

return {row[0]: 1.0 for row in rows}

mindistance = {}

for row in rows:

dist = sum([abs(row[i]-row[i-1]) for i in xrange(2, len(row))])

if mindistance.has_key(row[0]):

if dist < mindistance[row[0]]:

mindistance[row[0]] = dist

else:

mindistance[row[0]] = dist

return self.normalize_scores(mindistance, smallIsBetter=1)

Использование внешних ссылок на сайт

Все обсуждавшиеся до сих пор метрики ранжирования были основаны на содержимом страницы. Часто результаты можно улучшить, приняв во внимание, что говорят об этой странице другие, а точнее те сайты, на которых размещена ссылка на нее. Особенно это полезно при индексировании страниц сомнительного содержания или таких, которые могли быть созданы спамерами, поскольку маловероятно, что на такие страницы есть ссылки с настоящих сайтов.

Простой подсчет ссылок

Простейший способ работы с внешними ссылками заключается в том, чтобы подсчитать, сколько их ведет на каждую страницу, и использовать результат в качестве метрики. Так обычно оцениваются научные работы; считается, что их значимость тем выше, чем чаще их цитируют.

def inbound_link_score(self, rows):

unique_urls = {row[0]: 1 for row in rows}

inbound_count = {}

for url_id in unique_urls:

self.cur.execute('select count(*) from link where to_id = %d' % url_id)

inbound_count[url_id] = self.cur.fetchone()[0]

return self.normalize_scores(inbound_count)

Описанный алгоритм трактует все внешние ссылки одинаково, но такой уравнительный подход открывает возможность для манипулирования, поскольку кто угодно может создать несколько сайтов, указывающих на страницу, ранг которой он хочет поднять. Также возможно, что людям более интерес

Пространства имен модулей

С технической точки зрения каждому модулю соответствует отдельный файл, и интерпретатор создает объект модуля, содержащий все имена, которым присвоены какие-либо значения в файле модуля. Проще говоря, модули – это всего лишь пространства имен (места, где создаются имена), и имена, находящиеся в модуле, называются его атрибутами.В данной тематике мы разберем как работает этот механизм.

ort module2

Автор: Няшный Человек

Дата публикации: 2014-08-16T04:04:00.000+03:00

Рекомендование предметов

В прошлом посте мы с Вами разобрались, как ранжировать людей по вкусам и говорить кто на нас похож больше всех. Теперь займемся связанной задачей — рекомендацией фильмов!

Рекомендование предметов

Найти подходящего критика – это, конечно, неплохо, но в действительности-то я хочу, чтобы мне порекомендовали фильм. Можно было бы посмотреть, какие фильмы понравились человеку с похожими на мои вкусами, и выбрать из них те, что я еще не смотрел. Но при таком подходе можно было бы пропустить много классных фильмов. Или посмотреть фильм, который понравился только ему.

Чтобы разрешить эти проблемы, необходимо ранжировать сами фильмы, вычислив взвешенную сумму оценок критиков. Берем каждого из отобранных критиков и умножаем его оценку подобия со мной на оценку, которую он выставил каждому фильму. Вот пример из книжки, надеюсь будет понятно)

Смысл в том, чтобы мнение критика с похожими на мои вкусами вносило больший вклад в общую оценку, чем мнение критика, не похожего на меня. В строке «Итого» приведены суммы вычисленных таким образом величин.

select v1.film_id,

count(1),--количество людей тоже ставивших голоса фильму кроме меня

evkl.sum_koef -- сумма подобия людей(со мной) голосовавших за этот фильм

from votes v1

join votes v2 on v1.film_id=v2.film_id

join (

select sum(evkl.vote*evkl.koef)/sum(evkl.koef) sum_koef, evkl.film_id

from(

select

v1.user_id,

v1.vote,

v1.film_id,

1/(1+(|/sum((v1.vote-v2.vote)^2))) koef--евклидово не взвешенное расстояние

from votes v1

join votes v2 on v1.film_id=v2.film_id

where v1.user_id <> v2.user_id

and v2.user_id=4722023 -- мой id

group by v1.user_id, v1.film_id, v1.vote

) evkl

group by evkl.film_id

) evkl on v1.film_id=evkl.film_id

where v1.user_id <> v2.user_id

and v2.user_id=4722023 -- мой id

group by v1.film_id, evkl.sum_koef

order by evkl.sum_koef desc

Таким образом фильмы с одинаковыми оценками(которые поставил я), стали взвешенными и выстроились в порядке, которые по идее мне понравились чуточку больше)))

Ну что же — это уже, как минимум не плохо) Но и основная задача, рекомендации фильмов, решается не сложнее).

select

v1.film_id,

sum(v1.vote*evkl.koef)/sum(evkl.koef)

from votes v1

join (

select

v1.user_id,

1/(1+(|/sum((v1.vote-v2.vote)^2))) koef--евклидово не взвешенное расстояние

from votes v1

join votes v2 on v1.film_id=v2.film_id

where v1.user_id <> v2.user_id

and v2.user_id=4722023

group by v1.user_id

order by v1.user_id

) evkl on evkl.user_id=v1.user_id

--фильтруем, чтобы за фильм голосовало не менее 10 человек

join (

select film_id, count(1) from votes group by film_id having count(1)>10

) flms on flms.film_id=v1.film_id

group by v1.film_id

order by sum(v1.vote*evkl.koef)/sum(evkl.koef)

Вот и все!) Что нам нужно знать об этой ф-ии. Ну во первых мы ввели ограничение на минимальное кол-во голосов за фильм в 10, чтобы не вышло так, что кому-то понравился фильм, у вас с этим критиком коэффициент близкий у 1 и соответственно фильм имеет хороший вес.

И теперь про отличие этой цифры от той, что выставлена на самом сайте kinopoisk.ru. А отличие простое: там просто средне арифметическая по голосам и кол-ву голосовавших, а эта чисто ваша, рассчитанная исходя из сходства вкусов Вас и тех кто голо

совал. Поэтому при таком подходе, у разных людей у одного и того же фильма будут разные оценки, иногда абсолютно разные!)))

Фильтрация по схожести образцов

Техника, которую мы применяли до сих пор, называется коллаборативной фильтрацией по схожести пользователей. Альтернатива известна под названием «коллаборативная фильтрация по схожести образцов». Когда набор данных очень велик, коллаборативная фильтрация по схожести образцов может давать лучшие результаты, причем многие вычисления можно выполнить заранее, поэтому пользователь получит рекомендации быстрее.

Итак, создадим табличку, куда будем записывать коэффициенты схожести фильмов между собой.

CREATE TABLE movies_similarity

(

id serial NOT NULL,

film_id1 integer NOT NULL,

film_id2 integer NOT NULL,

pirson_koef double precision NOT NULL,

CONSTRAINT movies_similarity_pk PRIMARY KEY (id)

)

Туда при помощи запроса и конструкции INSERT INTO запишем данные фильмов, которые мы оценили уже на сайте.

Выдача рекомендаций

Теперь вы готовы выдавать рекомендации, пользуясь словарем данных о схожести образцов без обращения ко всему набору данных. Необходимо получить список всех образцов, которым пользователь выставлял оценки, найти похожие и взвесить их с учетом коэффициентов подобия. Давайте разберем пример:

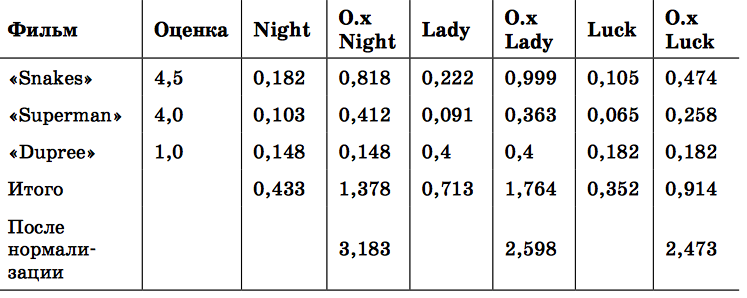

В каждой строке указан фильм, который я смотрел, и оценка, которую я ему выставил. Для каждого фильма, который я не смотрел, имеется столбец, где показано, насколько он похож на виденные мной фильмы. Например, коэффициент подобия между фильмами «Superman» и «The Night Listener» равен 0,103. В столбцах с названиями, начинающимися с О.x, показана моя оценка, умноженная на коэффициент подобия; поскольку я поставил фильму «Superman» оценку 4,0, то, умножая число на пересечении строки «Superman» и столбца «Night» на 4,0, получаем: 4,0 × 0,103 = 0,412.

В строке «Итого» просуммированы коэффициенты подобия и значения в столбцах «О.x» для каждого фильма. Чтобы предсказать мою оценку фильма, достаточно разделить итог для колонки «О.x» на суммарный коэффициент подобия. Так, для фильма «The Night Listener» прогноз моей оценки равен 1,378/0,433 = 3,183.

select

ms.film_id1,

case when sum(ms.pirson_koef)<>0

then

sum(v.vote*ms.pirson_koef)/sum(ms.pirson_koef)

else

0

end

from votes v

join movies_similarity ms on ms.film_id2=v.film_id

where v.user_id=4722023

group by ms.film_id1

order by case when sum(ms.pirson_koef)<>0

then

sum(v.vote*ms.pirson_koef)/sum(ms.pirson_koef)

else

0

end desc

В общем из тех 14 фильмов, что я лайкнул мне посоветовали посмотреть — «Голова-ластик»

Ну что же…думаю этим и займусь) А вы найдите себе фильм на вечер!)

Автор: Pavel Petropavlov

Подбор предметов

Подбор схожих предметов

Практика Евклида

select

v1.film_id, v2.film_id,

1/(1+(|/sum((v1.vote-v2.vote)^2))),--евклидово не взвешенное расстояние

count(1)--кол-во общих фильмов(вес для ф-ии)

from votes v1

join votes v2 on v1.user_id=v2.user_id

where v1.film_id <> v2.film_id

and v2.film_id=326

group by v1.film_id, v2.film_id

--having count(1)>10

order by 1/(1+(|/sum((v1.vote-v2.vote)^2))) desc, count(1) desc

Для сравнения возьмем фильм «Побег из Шоушенка». Метод Евклида посчитал, что на него больше всего похож фильм «Реал Мадрид». Спросите чем? Отвечу:

select

v1.film_id, v2.film_id,

v1.vote vote1, v2.vote vote2, v1.user_id, v2.user_id

from votes v1

join votes v2 on v1.user_id=v2.user_id

where v1.film_id <> v2.film_id

and v2.film_id=326

and v1.film_id=155080

5 разных людей смотрели оба фильма и поставили не много не мало все 10ки!!! Но конечно, данный алгоритм никак не учитывает жанры, режиссеров или актеров. Однако никто не мешает ввести вам такие дополнительные фильтрующие весовые функции.

Практика Пирсона

select

v1.film_id,

case when ((sum(v1.vote^2)+1)-(sum(v1.vote)^2)/count(1)::float)*((sum(v2.vote^2)+1)-(sum(v2.vote)^2)/count(1)::float) <> 0

then

(sum(v1.vote*v2.vote)-(sum(v1.vote)*sum(v2.vote))/count(1)::float)/(|/((sum(v1.vote^2)+1)-(sum(v1.vote)^2)/count(1)::float)*((sum(v2.vote^2)+1)-(sum(v2.vote)^2)/count(1)::float))

else

0

end,

count(1)--кол-во общих критиков(вес для ф-ии)

from votes v1

join votes v2 on v1.user_id=v2.user_id

where v1.film_id <> v2.film_id

and v2.film_id=326 --фильм для сравнения

group by v1.film_id, v2.film_id

--having count(1)>10

order by

case when ((sum(v1.vote^2)+1)-(sum(v1.vote)^2)/count(1)::float)*((sum(v2.vote^2)+1)-(sum(v2.vote)^2)/count(1)::float) <> 0

then

(sum(v1.vote*v2.vote)-(sum(v1.vote)*sum(v2.vote))/count(1)::float)/(|/((sum(v1.vote^2)+1)-(sum(v1.vote)^2)/count(1)::float)*((sum(v2.vote^2)+1)-(sum(v2.vote)^2)/count(1)::float))

else

0

end

desc,

count(1) desc

Запустив пирсона, получим совсем другой фильм — «Крезанутые». И это всего при 2х общих критиках. В общем советую Вам обратить внимание на закомментированную строку с having, считаю что нужно ее применить для более точного совпадения)

Автор: Pavel Petropavlov

Машинное обучение. Начало.

Предисловие

В поисках данных

Итак, нам нужны данные — много данных!) И желательно интересных. Не знаю, как вы, но я долго думать не стал и воспользовался сайтом kinopoisk.ru, надеюсь сильно бить не будут, ведь мы будем взращивать их будущие кадры(т.е. Вас!)))

CREATE TABLE votes

(

id serial NOT NULL, --уникальный идентификатор

user_id integer NOT NULL, --id пользователя с сайта

film_id integer NOT NULL, --id фильма с сайта

vote smallint NOT NULL, --оценка фильму пользователем от 1 до 10

CONSTRAINT vote_id PRIMARY KEY (id)

)

Объяснять столбцы не буду!!!))) Если все получилось, давайте добавим данных. Бить меня не нужно, можно только корректировать, я для Вас написал следующее чудо, запускаем и…не ждем, а приступаем к работе, он и сам справится, за несколько лет)) У меня на момент написания этих строк обработано 9000 пользователей из как минимум 4722023 (спалился:)

import re, psycopg2

from lxml.html import parse

from lxml.cssselect import CSSSelector

def get_user_voites():

user_start_num = 200

user_end_num = 4722023

try:

conn=psycopg2.connect("dbname='postgres' user='postgres' password='120789' host='localhost'")

cur = conn.cursor()

page_num_sel = CSSSelector('div.pagesFromTo')

for user_num in xrange(user_start_num, user_end_num):

vote_film_list = []

loop_bool = True

page_num = 1

while loop_bool:

try:

page = parse('http://www.kinopoisk.ru/user/%s/votes/list/ord/date/page/%s/' % (user_num, page_num))

vote_count_div = int(page_num_sel(page)[0].text.split()[-1])

items = page.xpath("//div[contains(@class, 'item')]")

for item in items:

try:

film_div = item.find("div[@class='info']").find("div[@class='nameRus']").find("a")

vote_num = int(item.find("div[@class='num']").text)

film_id = re.search('film/(d)+/$', film_div.values()[0]).group(0)[5:-1]

film_name = film_div.text

vote = item.find("div[@class='vote']").text

if vote and film_id:

vote_film_list.append({'vote': vote, 'user_id': user_num, 'film_id': film_id})

except:

pass

if vote_num <= vote_count_div:

page_num += 1

print vote_num, page_num, vote_count_div, len(vote_film_list)

cur.executemany("""INSERT INTO votes(user_id, film_id, vote) VALUES (%(user_id)s, %(film_id)s, %(vote)s)""", vote_film_list)

conn.commit()

vote_film_list = []

except Exception, e:

print e

loop_bool = False

except Exception, e:

print "I am unable to connect to the database.", e

finally:

if conn:

conn.close()

Автор: Pavel Petropavlov

Линейный поиск

Рассматриваем, левую и правую границы отрезка массива, где находится нужный нам элемент. Исследования начинаются с первого элемента отрезка. Если искомое значение не равно значению функции в данной точке, то осуществляется переход к следующей точке. Т.е., в результате каждой проверки область поиска уменьшается на один элемент.

def linearSearch(li, x):

i = 0

length = len(li)

while ili[i]:

i+=1

return i if iНиклаус Вирт описал модернизацию метода, при которой мы избавляемся от одного сравнения на каждом витке цикла. А именно от проверки окончания строки. Для этого мы добавляем искомый элемент в самый конец, что гарантирует нам остановку по одному условию, а финальная проверка на позицию найденного элемента, покажет подставной он или нет)

def linearSearchVirt(li, x):

i = 0

length = len(li)-1

while x x<> li[i]:

i+=1

return i if iВот и весь линейный поиск!)

Но есть более интересный метод - двоичный поиск, милости просим к изучению.Автор: Pavel Petropavlov