Вероятность того, что вы никогда не слышали о Ctrl Alt Delete, очень мала. Большинство людей сталкивались с ним, и многие, вероятно, используют его регулярно. Однако вы хотите узнать больше о том, что такое Ctrl Alt Del на вашей клавиатуре? Для чего она используется и как отправить эту комбинацию клавиш на удаленный компьютер? Для получения дополнительной информации читайте далее:

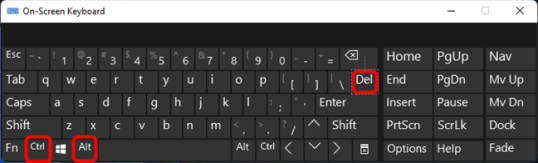

Ctrl Alt Delete, также известная как Ctrl + Alt + Del, — это сочетание клавиш, используемое на компьютерах и ноутбуках, которое, в зависимости от контекста, позволяет быстро перезагрузить устройство или вывести экран с некоторыми основными настройками Windows. Но сначала давайте посмотрим, как выполняется Ctrl Alt Delete: на клавиатуре компьютера или ноутбука одновременно нажмите клавиши Ctrl и Alt. Затем, удерживая их, нажмите третью клавишу сочетания клавиш: Delete или Del.

Что происходит, когда вы нажимаете Ctrl Alt Delete?

На ПК с Windows при использовании сочетания клавиш Ctrl Alt Delete могут произойти две вещи:

- Если вы используете UEFI или BIOS вашего компьютера или когда ваш компьютер загружается, но еще не завершил запуск Windows, нажатие Ctrl Alt Del один раз мгновенно перезагрузит компьютер.

- Если Windows работает, нажатие Ctrl Alt Delete на клавиатуре прерывает все, что вы делаете с ней, и загружает простой экран с несколькими основными параметрами на выбор. Прочтите следующий раздел этой статьи, чтобы увидеть их.

Для чего в Windows используется Ctrl Alt Delete?

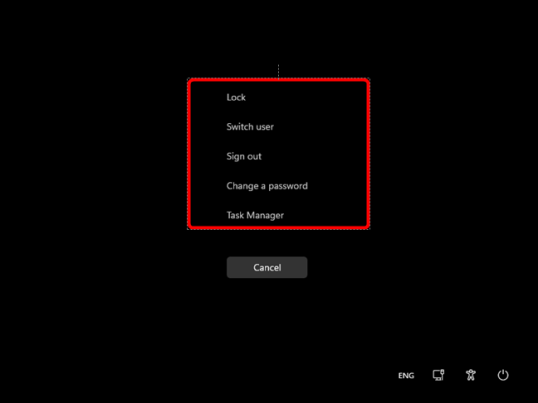

В Windows 11 и Windows 10, основных настольных операционных системах на сегодняшний день, нажатие Ctrl Alt Delete дает вам доступ к следующим параметрам:

- Блокировка — щелчок по этой опции блокирует ваш компьютер с Windows, чтобы другие пользователи не могли получить доступ к вашей учетной записи, пока вас нет. Если вы хотите , чтобы вернуться к работе, вы должны разблокировать компьютер с помощью любого знака в методах вы предварительно настроен, как Windows, Hello Face, PIN — код, или обычный-старый пароль.

- Сменить пользователя — этот параметр позволяет вам войти на компьютер или устройство Windows, используя другую учетную запись пользователя. При переключении на нового пользователя не закрываются приложения или окна, открытые текущей учетной записью пользователя. Это только переводит их в состояние сна, чтобы вы могли быстро переключаться между различными учетными записями пользователей Windows.

- Выйти — выбор этой опции выводит вас из вашей учетной записи , закрыв все программы и окна, которые вы могли открыть, поэтому убедитесь, что вы сначала сохранили свою работу.

- Диспетчер задач. При нажатии или касании Диспетчера задач открывается одноименный инструмент Windows. Диспетчер задач очень полезен, когда вам нужно управлять работой приложений, процессов и служб на вашем ПК с Windows.

- Изменить пароль — этот параметр отображается только в том случае, если вы используете автономную локальную учетную запись на ПК с Windows. Нажатие на него позволяет изменить пароль пользователя, но только если вы знаете старый пароль, поэтому вы не можете использовать его для сброса забытого пароля.

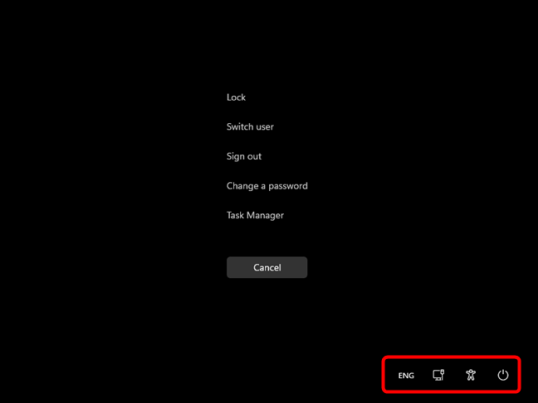

Кроме того, в правом нижнем углу экрана Windows Ctrl Alt Del вы также получаете несколько кнопок, которые позволяют выполнять несколько других важных функций. В зависимости от вашего устройства вы можете видеть кнопки для:

- Power позволяет выключить, перезагрузить или перевести компьютер с Windows в спящий режим.

- Доступность дает вам доступ к ряду базовых удобства инструментов доступа , таких как рассказчик, лупой, экранная клавиатура, или залипание клавиш.

- Сеть показывает состояние подключения к сети и, если вы используете Wi-Fi , позволяет подключаться к беспроводным сетям или отключаться от них.

- Язык позволяет переключать активный язык клавиатуры, если у вас установлено более одного языка.

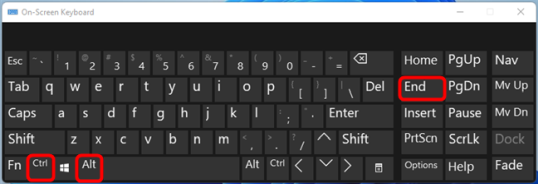

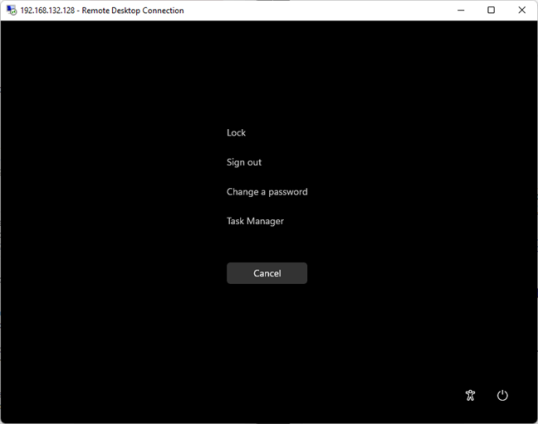

Как нажать Ctrl Alt Del в сеансах удаленного рабочего стола

Если вы находитесь на удаленном компьютере с Windows через подключение к удаленному рабочему столу и хотите использовать сочетание клавиш Ctrl Alt Delete, вы можете быстро обнаружить, что это не работает. Вместо того, чтобы действовать на удаленном компьютере, Ctrl Alt Del действует на компьютере, с которого вы подключаетесь. Чтобы отправить Ctrl Alt Delete на удаленный компьютер, вам нужно немного изменить комбинацию клавиш. При удаленном подключении нажмите Ctrl Alt End вместо Ctrl Alt Del.

Если вы это сделаете, удаленный компьютер интерпретирует вашу команду как Ctrl Alt Delete.

Что не так с Ctrl Alt Del?

Иногда сочетание клавиш Ctrl Alt Delete может не работать, даже если вы нажимаете его несколько раз. Почему так происходит? Что ж, есть несколько возможных причин:

- Для начала перед запуском Windows проверьте, работает ли нажатие Ctrl Alt Del . Если это не так, то, скорее всего, проблема с вашей клавиатурой. Возможно, одна из трех клавиш — Ctrl, Alt или Delete — сломана, или, может быть, вся ваша клавиатура подошла к концу.

- Однако, если Ctrl Alt Delete работает до загрузки Windows, проблема, скорее всего, связана с программным обеспечением. Это может быть ошибка в операционной системе, приложение, которое работает некорректно и приводит к зависанию вашего компьютера, или даже какое-то вредоносное ПО, влияющее на ваше устройство Windows. В этом случае проверьте, работает ли он в безопасном режиме . Если это так, вам придется выполнить некоторые действия по устранению неполадок и/или удалить вредоносное ПО, чтобы попытаться избавиться от проблем. С другой стороны, если он не работает в безопасном режиме, мы рекомендуем просто попытаться переустановить Windows, так как это наиболее вероятный способ исправить то, что сломано.

Для чего вы используете Ctrl Alt Delete?

Теперь вы знаете больше о том, что такое Ctrl Alt Del и для чего он используется. Вы также узнали, как отправить Ctrl Alt Delete на удаленный компьютер и что может помешать его работе. Так для чего вы используете Ctrl Alt Delete? Какова его основная цель в вашем случае? Сообщите нам об этом в комментариях ниже.

2021-10-13T20:36:33

Вопросы читателей