Коммутатор и маршрутизатор являются двумя важными компонентами сети. Хотя оба являются соединительными устройствами в сети, и иногда люди принимают их за одно и то же, оба имеют разную функциональность. В этом разделе мы увидим, чем коммутатор и маршрутизатор отличаются друг от друга. Читать

Роутер Tenda F6: быстрый, простой и надежный выбор для беспроводной сети

Роутер Tenda F6 – это недорогое устройство, которое предназначено для создания быстрой и стабильной беспроводной сети в доме или офисе. Это устройство имеет простой и интуитивно понятный интерфейс управления, который позволяет настроить все необходимые параметры с минимальными усилиями. Благодаря высокой скорости и надежности соединения, роутер Tenda F6 может стать идеальным выбором для тех, кто ищет быстрый и простой в использовании роутер. В этой статье мы рассмотрим основные преимущества роутера Tenda F6 и почему он может быть идеальным выбором для вашей домашней или офисной сети.

Роутер Tenda F6: быстрый, простой и надежный выбор

Если вы ищете роутер для организации быстрой и стабильной беспроводной сети, то Tenda F6 может быть идеальным решением для вас. Ниже мы рассмотрим основные преимущества этого устройства. Читать

Оптимизатор: бесплатный, открытый и бесплатный оптимизатор для Windows.

Оптимизатор: бесплатный, открытый и бесплатный оптимизатор для Windows.

Поскольку, говоря о Бесплатное программное обеспечение и открытый исходный кодЭто включает в себя все разработки программного обеспечения (такие как: настольные и мобильные операционные системы и приложения, а также веб-системы).Это нормально, что многие из них доступны как для GNU / LinuxЧто касается Android, Windows, macOS и iOS.

По этой причине время от времени нам нравится комментировать некоторые разработки бесплатного программного обеспечения с открытым исходным кодом, кроссплатформенные или родные только для операционных систем, отличных от GNU/Linux. И, в соответствии с этим, сегодня мы обратимся приложение для окон называть «Оптимизатор». Который работает как полезный бесплатный, открытый и бесплатный оптимизатор для Windows, который фокусируется на том, чтобы быть расширенная утилита настройки чтобы пользователи могли восстановить свою конфиденциальность и повысить свою безопасность в указанной проприетарной, закрытой и коммерческой операционной системе.

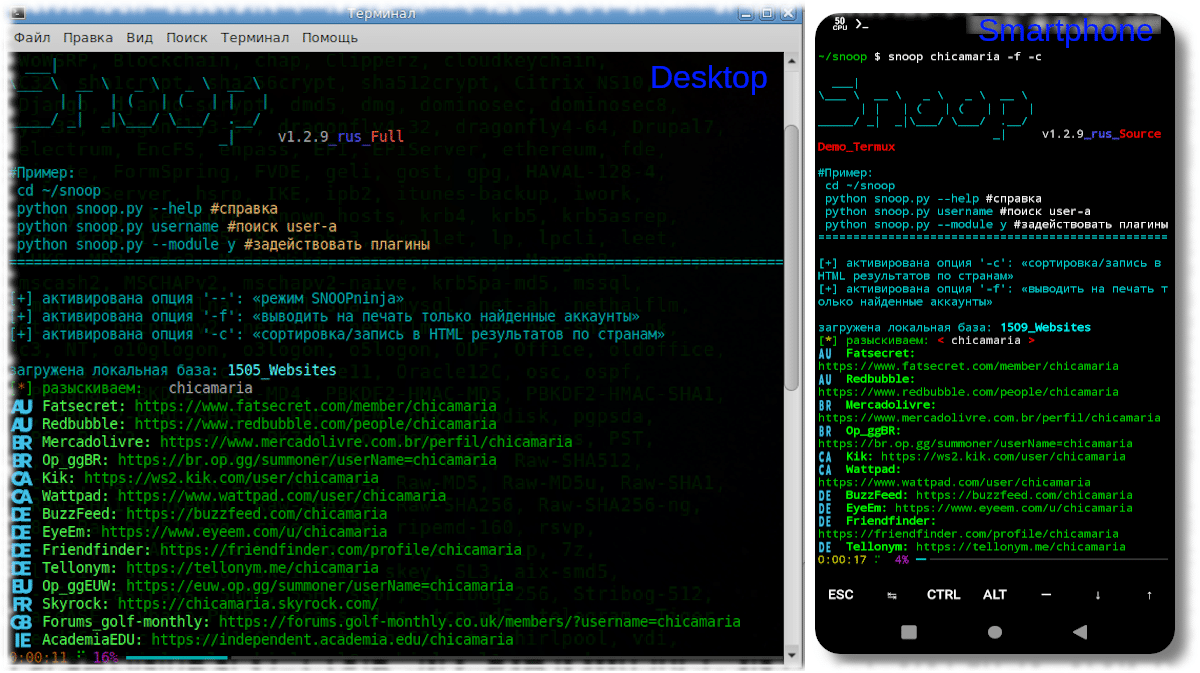

Появляется Snoop 1.3.7, инструмент для поиска учетных записей пользователей в общедоступных данных.

Snoop — исследовательская работа (собственная база данных/закрытый багбаунти) в области поиска и обработки общедоступных данных в Интернете.

Недавно анонсирован выход новой версии проекта Snoop 1.3.7, которая разрабатывает криминалистический инструмент OSINT, который ищет учетные записи пользователей в общедоступных данных (разведка на основе открытых источников).

Программа сканирует различные сайты, форумы и социальные сети для обнаружения наличия имени пользователя, которое вы ищете, то есть позволяет пользователю определить, на каких сайтах есть пользователь с указанным ником.

HopToDesk: бесплатное кроссплатформенное приложение для удаленного рабочего стола.

HopToDesk: бесплатное кроссплатформенное приложение для удаленного рабочего стола.

Несколько месяцев назад мы представили новое захватывающее бесплатное и открытое приложение для удаленного рабочего стола под названием РустДеск. И по этому поводу мы сказали, что это отличная и современная альтернатива бесплатному и закрытому приложению TeamViewer. И, как это обычно бывает в области бесплатного программного обеспечения, открытого исходного кода и GNU/Linux, сегодня мы представим интересную его вилку, называемую «ХопТоДеск».

Однако, как и в предыдущей возможности, мы повторяем, что существует множество других бесплатных и открытых решений для удаленного управления рабочим столом. Среди которых выделяются: Реммина, NoMachine, уксус. Которые очень хорошо покрывают основные нужды и потребности в этой области техники. Будучи подходящей альтернативой TeamViewer o AnyDesk, которые, хотя и являются бесплатными приложениями для Linux, также являются проприетарными и закрытыми.

Выделенные серверы: насколько они необходимы в 2023 году?

Когда вы планируете использовать выделенный (dedicated) сервер для размещения своего бизнес-сайта, важно знать, какие у вас есть варианты, чтобы вы могли выбрать тот, который больше всего соответствует вашим потребностям. Чем эта статья полезна для вас в этом случае? Это поможет вам отличить действительно хороший выделенный сервер от остальных, поскольку мы собрали ключевые данные для краткого изучения. Кроме того, это покажет вам, насколько важны выделенные серверы в 2023 году.

Однако, если вы еще не готовы к этому на данный момент, эта статья все равно поможет вам понять, насколько важными становятся аренда dedicated сервера, представив некоторые действительно ценные идеи. Кроме того, вы можете просто передумать, увидев преимущества использования выделенного хостинг-провайдера и полного контроля над собственным частным сервером.

Вопросы, которые будут рассмотрены:

- Что такое выделенный хостинг и выделенный сервер?

- Как это соотносится с другими типами хостинга?

- Зачем и когда вам понадобится выделенный сервер?

Начнем с того, что такое выделенный хостинг?

По сути, выделенный хостинг — это тип интернет-хостинга, который предоставляет физический сервер (или серверы) одному клиенту со всеми ресурсами сервера. Что делает его таким отличным выбором для владельцев бизнеса, так это тот факт, что он обеспечивает полный контроль над машиной. Это означает, что пользователь может оптимизировать и настраивать такие вещи, как производительность и безопасность, для конкретных требований, целей и потребностей.

Вкратце: что такое выделенный сервер и насколько важны выделенные серверы в 2023 году?

Выделенный сервер — это отдельный частный сервер, который вместе со своими функциями, возможностями и параметрами предназначен исключительно для одного пользователя. В принципе, если у вас есть выделенный сервер, вы полностью контролируете все ресурсы, такие как процессор, оперативная память, хранилище, максимальная скорость загрузки, а также приложения и скрипты, которые вы планируете установить на свой сервер.

Кроме того, вы получаете выгоду от его способности обрабатывать огромный трафик без каких-либо проблем с производительностью сайта, замедлений или простоев.

Как это соотносится с другими типами хостинга?

Если мы хотим сравнить, например, выделенный сервер с общим планом хостинга, различия довольно очевидны:

Виртуальный хостинг:

- Ваш веб-сайт живет рядом с другими веб-сайтами;

- Другие пользователи используют тот же сервер;

- Более высокие риски для безопасности

- Вы делитесь всеми ресурсами;

- Более дешевые планы хостинга;

- Низкие требования к техническим навыкам;

- Расходы на обслуживание распределяются между всеми пользователями;

- Обычно поставляется с предустановленными программами для удовлетворения общих потребностей веб-сайтов.

Выделенный хостинг:

- Это быстрее, надежнее и безопаснее;

- предлагает больше ресурсов, таких как процессор, оперативная память, пропускная способность и другие;

- Все ресурсы используются только вашим сайтом;

- Поддерживает большие веб-сайты с высоким трафиком;

- Улучшенные возможности управления и возможность его дальнейшей настройки;

- Более высокие затраты на обслуживание.

Вот пример, который мы совсем недавно получили от одного из наших клиентов. И это покажет вам, насколько важны выделенные серверы в 2023 году. Раньше он полагался на решение для совместного хостинга от другого провайдера. Однажды он получил огромный всплеск посещаемости сайта после маркетинговой кампании, которую опубликовала его команда. В результате его общий сервер превысил лимиты ресурсов и не мог обрабатывать увеличившийся трафик, который попадал на его страницу. Весь веб-сайт потерпел крах. Вместо этого он решил перейти на наши решения для выделенного хостинга, которые способны обрабатывать быстро увеличивающийся трафик, не вызывая никаких проблем.

Зачем и когда вам понадобится выделенный сервер?

К 10 основным проблемам, влияющим на надежность и приводящим к значительному простою веб-сайта, относятся:

Одна из самых важных вещей при выборе хостинга — получить прочную основу для вашего бизнес-сайта. Выделенный сервер в этом случае идеален, поскольку он фокусируется на ключевых факторах, таких как оптимальная работа и время безотказной работы, надежность, стабильность, бесперебойный доступ и т.д. И он способен преодолеть проблемы, о которых говорилось выше. Что крайне важно для любого корпоративного и бизнес-сайта. Особенно в 2023 году, когда начинается прошлый год со всеми его проблемами, такими как экономический спад, глобальная рецессия, постпандемические “последствия” и изменения в деловой и рабочей культуре.

Что касается того, когда вам понадобится выделенный сервер, вот несколько сценариев.

- Когда ваш онлайн-бизнес настроен на рост и вы ожидаете миллионов посещений страниц в месяц.

- На случай, если вы храните много гигабайт данных.

- Если вашим приоритетом является первоклассная изолированная безопасность, повышенная надежность, быстрая скорость загрузки сайта.

- Если у вас есть техническое образование, и вам будет проще управлять и настраивать сервер самостоятельно.

- Для веб-сайтов с высоким трафиком, таких как сайты электронной коммерции, интернет-магазины, финансовые сайты и другие.

- Также идеально, когда вы планируете устанавливать программы и выбираете программу

Почему стоит выбрать выделенный сервер?

Потому что это гибкая услуга хостинга для тех, кому нужно решение, предоставляющее больше возможностей, чем традиционный виртуальный хостинг. Вы будете единственным, у кого будет доступ к серверу со всеми ресурсами.