Web3 относится к следующему поколению Интернета, децентрализованной и более безопасной версии текущего Web 2.0.

Он построен на технологии блокчейна, которая позволяет создавать децентрализованные приложения (DApps) и выполнять смарт-контракты.

Web3 все еще находится на начальной стадии разработки, и потребность в квалифицированных специалистах высока, что сегодня стало одним из самых прибыльных секторов рынка труда.

В этой статье я расскажу обо всех основных навыках, необходимых для веб-разработки.

Почему разработка Web3 важна?

По мере того, как все больше отраслей внедряют технологию блокчейна, спрос на квалифицированных разработчиков Web3 и разработчиков блокчейнов стремительно растет.

Стать разработчиком Web3 означает, что вы будете в авангарде технологической революции, способствуя созданию более безопасного, прозрачного и ориентированного на пользователя Интернета.

Разработка Web3 важна, поскольку она позволяет нам создавать более безопасный и прозрачный онлайн-опыт. Это позволяет нам выйти за рамки ограничений Web2 и вступить в новую эру децентрализации и безопасного управления идентификацией.

Web3 также предлагает разработчикам возможность создавать действительно надежные приложения с открытым исходным кодом, что может привести к улучшению пользовательского опыта и снижению затрат для компаний.

Web3 обещает Интернет, в котором пользователи будут владеть своими данными и пожинать плоды своего творчества. С появлением технологии блокчейна наши цифровые личности могут быть защищены от третьих лиц с помощью криптографии.

Кроме того, эта технология позволяет осуществлять одноранговые транзакции, не полагаясь на сторонних посредников или посредников, которые могут отобрать прибыль у пользователей, участвующих в этих действиях.

Как стать разработчиком Web3?

Разработка технологии Web3 — это новая захватывающая область.

Он предлагает разработчикам возможность создавать более распределенные приложения, разработку которых можно выполнить быстрее и дешевле, а также обеспечивает более простую и безопасную платежную среду для обмена данными.

Для тех, кто хочет самостоятельно стать разработчиком Web3, есть несколько ключевых шагов, которые необходимо предпринять, чтобы добиться успеха в этой области.

Прежде всего, важно изучить основы веб-разработки и получить опыт работы с HTML, CSS и JavaScript.

Этот опыт даст вам основу для развития ваших знаний о технологиях Web3, таких как блокчейн и смарт-контракты.

Кроме того, знакомство с такими библиотеками, как Solidity, может быть полезно для понимания того, как эти технологии блокчейна взаимодействуют и работают в сетях распределенных систем.

Если вы готовы, вы сможете узнать о технологии объединения и тому подобном позже!

1. Изучите основы технологии блокчейн

Чтобы стать опытным разработчиком Web3, важно понимать основы технологии блокчейн.

Технология блокчейн произвела революцию в нашем понимании транзакций, данных и коммуникации.

Технология блокчейн обеспечивает безопасный и неизменный способ хранения и обмена информацией на глобальной платформе, что делает децентрализованное финансирование более эффективным, чем когда-либо прежде.

Если вы хотите изучить эту революционную технологию, изучение основ блокчейна является важным первым шагом.

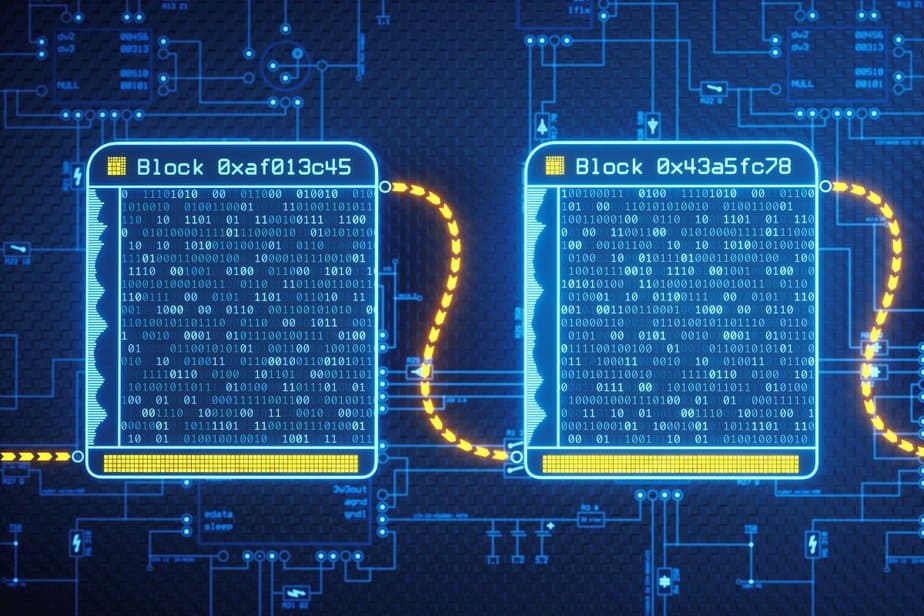

Чтобы начать изучение технологии блокчейна, лучше всего понять, как работают блокчейны, познакомившись с двумя их основными компонентами: блоками и цепочками.

В каждом блоке хранится определенный объем данных транзакций, связанных с цепочкой для создания защищенной записи.

Затем эта цепочка передается всем пользователям в так называемой системе распределенного реестра, гарантируя, что ни одно физическое или юридическое лицо не сможет манипулировать какими-либо хранимыми записями.

2. Поймите децентрализацию

Децентрализация означает распределение контроля и полномочий по сети вместо того, чтобы полагаться на единый централизованный объект. Это гарантирует, что ни одна сторона не сможет манипулировать системой или контролировать ее, что повышает безопасность и доверие.

Децентрализация — это концепция, которая существует уже много веков, но в современном мире она становится все более важной. Децентрализация означает рассредоточение полномочий по принятию решений от централизованного источника, такого как правительство или крупная организация.

По сути, децентрализация позволяет более мелким организациям самостоятельно принимать решения, которые в противном случае принимались бы центральным источником. Это может привести к большей автономии и более эффективному принятию решений внутри организации или системы.

Преимущества децентрализации многочисленны. Оно может создать среду, в которой люди смогут лучше контролировать свою жизнь и то, как они решат использовать доступные им ресурсы.

Децентрализованные системы также имеют тенденцию быть более устойчивыми к потрясениям, таким как стихийные бедствия или экономические спады, поскольку решения не зависят только от одного органа или организации.

3. Узнайте о механизмах консенсуса

Механизмы консенсуса — это алгоритмы, которые позволяют согласовывать данные внутри децентрализованной сети.

Популярные механизмы консенсуса включают Proof of Work (PoW) и Proof of Stake (PoS). Механизмы консенсуса являются основой технологии блокчейна, предлагая безопасный и надежный способ перемещения структур данных и обработки транзакций.

В результате очень важно понимать механизмы консенсуса, если вы хотите принять участие в мире блокчейна.

Мой путь изучения механизмов консенсуса начался с алгоритма Bitcoin Proof of Work (PoW), поскольку это был первый в мире механизм консенсуса, используемый криптовалютами.

PoW работает, когда майнеры соревнуются друг с другом, решая сложные математические задачи и получая вознаграждение за свои усилия. Этот метод эффективен, но также дорог с точки зрения энергопотребления и эффективности времени.

Это побудило меня изучить дополнительные альтернативные механизмы консенсуса, которые потенциально могли бы предложить улучшенные решения по сравнению с PoW.

4. Узнайте о смарт-контрактах

Смарт-контракты — это самоисполняющиеся контракты, условия соглашения между сторонами которых записаны непосредственно в коде. Они автоматически выполняются при выполнении заранее определенных условий, что устраняет необходимость в посредниках.

Смарт-контракты, основанные на технологии блокчейн, быстро меняют способы обмена товарами и услугами.

Смарт-контракты обеспечивают безопасный, надежный и эффективный способ совершения транзакций без необходимости использования сторонних посредников.

Транзакции выполняются прозрачно и экономически эффективно, поскольку все данные хранятся в распределенном реестре, доступном для всех участников, участвующих в самом смарт-контракте.

Это устраняет временные задержки и потенциальные риски, связанные с традиционными контрактами между организациями, расположенными в разных географических точках.

Смарт-контракты предлагают нам большую свободу, позволяя нам определять условия для каждой транзакции, в которой мы участвуем.

Мы также можем создавать в смарт-контрактах положения, которые предусматривают штрафы или вознаграждения в зависимости от того, как участвующие стороны выполняют свои обязательства в рамках разработчика смарт-контракта и в сроки.

4. Познакомьтесь с Эфириумом

Ethereum — самая популярная платформа для разработки Web3, поэтому крайне важно понимать ее ключевые концепции.

Знакомство с Ethereum стоит всем, кто интересуется разработкой блокчейна космического стека криптовалют. Ethereum, созданный в 2015 году, представляет собой открытую программную платформу на основе блокчейна, которая позволяет разработчикам создавать децентрализованные приложения (dApps).

Он также предоставляет пользователям новый способ самостоятельного завершения и создания смарт-контрактов или оптимизации смарт-контрактов, которые пишутся и управляются автоматически с помощью кода, вместо того, чтобы полагаться на ручные процессы.

Итак, создаём смарт-контракты Ethereum. Базовая технология, лежащая в основе Ethereum, произвела революцию во взглядах многих людей на технологию криптовалюты и блокчейна.

Ethereum предлагает инвесторам дополнительный уровень безопасности по сравнению с более традиционными инвестициями в криптовалюту. Это связано с тем, что его транзакции хранятся в неизменяемом цифровом реестре, который нельзя подделать или изменить после регистрации в блокчейне.

Кроме того, все транзакции, выполняемые в сети Ethereum, проверяются другими пользователями и поэтому остаются анонимными, если не указано иное.

5. Поймите эфир и газ

Эфир — это собственная криптовалюта сети Ethereum, используемая для оплаты транзакций и вычислительных услуг. Газ — это единица измерения количества вычислительных усилий, необходимых для выполнения операции на Ethereum.

Эфир и газ — две наиболее важные основные концепции, когда дело доходит до понимания таких криптовалют, как Биткойн, Эфириум и Лайткойн.

Ether — это токен криптовалюты, используемый для проведения транзакций в блокчейне Ethereum, а Gas — это криптовалютное топливо, которое обеспечивает эти транзакции.

Количество эфира или газа, необходимое для завершения транзакции на Ethereum, определяется алгоритмом Gwei, который рассчитывает, сколько газа потребуется для обработки конкретной транзакции.

Это помогает обеспечить бесперебойную работу Ethereum и предотвращает перерасход пользователями ненужных комиссий.

Под газом понимается стоимость выполнения операций в рамках смарт-контрактов в Ethereum.

Количество газа, необходимое для любой конкретной транзакции, зависит от различных факторов, включая перегрузку сети, тип исполняемого смарт-контракта, сложность его выполнения, а также требования к хранению данных.

Он служит экономическим стимулом для майнеров, которые проверяют блоки, решая сложные математические задачи.

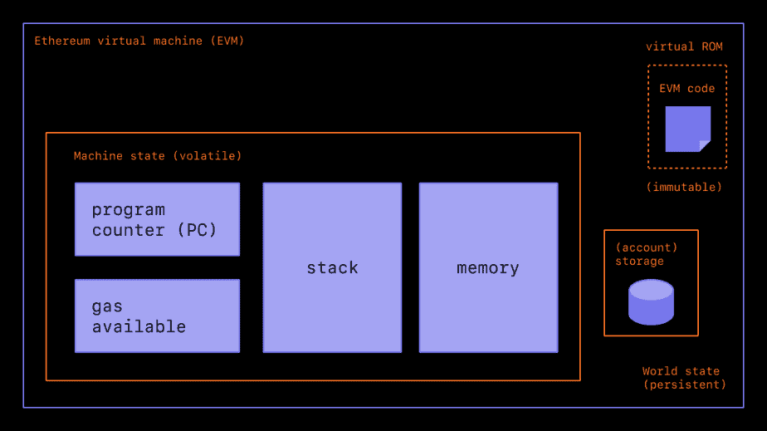

6. Узнайте о виртуальной машине Ethereum (EVM).

Источник: Фонд Эфириума.

Виртуальная машина Ethereum (EVM) — это среда выполнения для создания смарт-контрактов в блокчейне Ethereum. Это полная по Тьюрингу виртуальная машина, которая позволяет разработчикам создавать и развертывать смарт-контракты с использованием различных языков программирования.

Виртуальная машина Ethereum (EVM) — невероятно мощный инструмент для разработчиков смарт-контрактов. Это глобальная децентрализованная среда выполнения приложений для выполнения смарт-контрактов в блокчейне Ethereum.

EVM позволяет пользователям писать и выполнять код на виртуальной машине, которая может работать автономно, то есть работать без вмешательства человека.

EVM также очень прост и безопасен для платежей, поскольку все транзакции проверяются майнерами по всей сети, прежде чем они будут обработаны и навсегда сохранены в блокчейне.

Его высокий уровень безопасности гарантирует, что никакие злоумышленники не смогут попытаться подделать код или данные, хранящиеся в этой системе.

Кроме того, благодаря децентрализации не существует единой точки отказа, и он не может быть закрыт или подвергнут цензуре какой-либо отдельной организацией.

В целом, изучение виртуальной машины Ethereum (EVM) необходимо как разработчикам блокчейнов, так и пользователям разработчиков программного обеспечения блокчейнов, которые хотят создавать приложения с использованием платформы Ethereum.

7. Изучите децентрализованные приложения (DApps)

dApps — это приложения, созданные на базе блокчейн-платформы, такой как Ethereum.

Они используют смарт-контракты, чтобы обеспечить децентрализованное и не требующее доверия взаимодействие между разработчиками программного обеспечения блокчейна и пользователями на разных платформах.

Децентрализованные приложения (dApps) революционизируют наше взаимодействие с технологиями. Это компьютерные программы, построенные на основе децентрализованных сетей, таких как технология блокчейна, которые позволяют пользователям взаимодействовать напрямую, не полагаясь на центральный орган власти.

Это создает среду, в которой доверие распределяется между всеми участниками, а решения принимаются открыто и прозрачно.

В результате dApps могут обеспечить большую безопасность и надежность, чем традиционные приложения.

Потенциал dApps очень широк: от финансовых услуг, таких как одноранговые платежи, до приложений для социальных сетей, которые стимулируют пользователей участвовать и принимать участие в онлайн-сообществах.

Кроме того, из-за своей распределенной природы их можно использовать для создания новых бизнес-моделей, которые раньше не могли существовать из-за отсутствия доверия между сторонами или ограниченного доступа к инфраструктуре.

8. Освоить язык программирования Solidity

Solidity — наиболее широко используемый язык программирования для написания и разработки смарт-контрактов на платформе Ethereum. Обучение Solidity необходимо для создания и развертывания смарт-контрактов в блокчейне.

Меня всегда интересовало программирование и использование различных языков программирования, поэтому, когда я узнал о языке программирования Solidity, я понял, что хочу этому научиться.

Solidity — это объектно-ориентированный язык высокого уровня, используемый для языков программирования, реализующих смарт-контракты на различных платформах блокчейна.

Он существует с 2014 года и стал основным языком для разработчиков, желающих писать децентрализованные приложения Ethereum.

Изучение этого популярного языка программирования может оказаться непростой задачей, но при достаточной самоотдаче и усилиях его можно освоить.

При изучении языка программирования Solidity необходимо в первую очередь понять несколько ключевых концепций, чтобы максимально эффективно использовать его возможности.

Например, четкое понимание того, как работают структуры и типы данных и как объявляются переменные, необходимо для создания эффективных программ.

9. Изучите интерфейсную веб-разработку

Для создания пользовательских интерфейсов для DApps необходимо глубокое понимание веб-разработки внешнего интерфейса.

Проведя исследования и прочитав обзоры, я считаю, что это отличный способ начать путь веб-разработчика. Благодаря возможностям HTML, CSS и JavaScript вы можете создавать пользовательские интерфейсы, которые будут одновременно функциональными и эстетически приятными для использования компаниями на своих веб-сайтах.

Мои навыки разработки программного обеспечения будут значительно улучшены за счет получения знаний в области веб-разработки веб-интерфейса.

От понимания того, как браузеры работают с языками разметки, такими как HTML и XML, до использования таблиц стилей CSS для стилизации страниц, я стану более опытным в мире веб-разработки.

Более того, изучив различные инструменты разработчика, такие как библиотеки Bootstrap или jQuery, я могу применять их, чтобы сэкономить время в процессе разработки, обеспечивая при этом качественные производственные результаты.

а. HTML, CSS и JavaScript

Освойте основные технологии внешнего интерфейса, HTML, CSS и JavaScript, чтобы создавать визуально привлекательные и интерактивные пользовательские интерфейсы для своих DApps.

б. Библиотека Web3.js

Web3.js — это библиотека JavaScript, которая обеспечивает связь между клиентским приложением и блокчейном Ethereum. Это важный инструмент для интеграции смарт-контрактов с пользовательскими интерфейсами.

10. Создавайте и развертывайте свои собственные проекты

Применение навыков, полученных на онлайн-курсах, на практике имеет решающее значение для закрепления ваших знаний и получения реального опыта.

а. Разработайте собственное децентрализованное приложение

Создайте и разверните собственное DApp, чтобы продемонстрировать свои навыки и получить ценные отзывы от пользователей.

б. Участвуйте в хакатонах и мастер-классах

Присоединяйтесь к хакатонам и семинарам, чтобы сотрудничать с другими разработчиками и проектами с открытым исходным кодом, учиться у экспертов и совершенствовать свои навыки в конкурентной среде.

Заключение

Чтобы стать разработчиком смарт-контрактов Web3, требуется преданность своему делу и постоянное обучение, но это дает возможность внести свой вклад в будущее Интернета.

Овладев концепциями блокчейна, Ethereum, Solidity, разработкой смарт-контрактов и веб-разработкой внешнего интерфейса, вы будете на пути к тому, чтобы стать квалифицированным разработчиком Web3.

Часто задаваемые вопросы

Сколько времени нужно, чтобы стать веб3-разработчиком?

Время, необходимое для того, чтобы стать разработчиком Web3, зависит от вашего опыта и стремления к обучению разработчиков Web3. При последовательных усилиях вы можете рассчитывать на то, что овладеете навыками работы с разработчиками Web3 в течение 6–12 месяцев.

Нужен ли мне опыт программирования, чтобы стать разработчиком Web3?

Наличие опыта программирования полезно, но не является обязательным. Однако вам все равно придется изучить объектно-ориентированный язык программирования, такой как Solidity и JavaScript, для разработки DApps и создания смарт-контрактов.

Могу ли я сделать карьеру в сфере веб3-разработки?

Да, разработка Web3 — это быстрорастущая область с высоким спросом на квалифицированных разработчиков блокчейнов. Многие компании внедряют технологию блокчейна, а разработчики Web3 могут использовать сети блокчейнов для разработки и внедрения смарт-контрактов и поиска возможностей в различных отраслях.

Какие еще инструменты разработки языков программирования и платформы блокчейна мне следует изучить?

Помимо Ethereum, популярные блокчейн-платформы включают Binance Smart Chain, Cardano, Polkadot и Solana. Каждая платформа имеет свои уникальные функции и экосистему разработчиков.

Как я могу быть в курсе последних тенденций разработки Web3?

Следя за новостями отрасли, взаимодействуя с сообществами разработчиков Web3, а также участвуя в конференциях и семинарах, вы сможете быть в курсе последних тенденций и лучших практик в разработке Web3.

Как я могу стать разработчиком Web3?

Разработчики Web 3.0 — это инженеры-программисты, которые накопили специальные знания о компьютерном оборудовании, обеспечивающие децентрализованный обмен данными и технологии распределенного хранения. Требуется глубокое знание языков программирования, включая Java Rust JavaScript.

Какие навыки нужны разработчику Web3?

Другие технические навыки, необходимые для работы в Web3, включают Blockchain, Basic & Ethereum, физику твердого тела, программирование, смарт-контракты и веб-разработку внешнего интерфейса. Вы также изучите JavaScript и другие языки программирования, а также маркетинг, финансы, операции и аналитику.

Чем занимается разработчик Web3?

Разработчики Web3: Разработчики Web3 могут работать как внешние, внутренние и полноценные разработчики. Типичные задания включают разработку и тестирование программного обеспечения, проектирование интерфейсов и разработку контрактов.