В наш цифровой век любой, кто использует компьютер, мобильный телефон или любое интеллектуальное устройство, может быть взломан. Как только хакер проникнет в систему, он сможет украсть все, что попадется ему в руки: ваши деньги, ваши личные данные, учетные данные или ваши файлы.

Взломанный компьютер можно использовать для установки на ваш компьютер вредоносного ПО с целью кражи ваших файлов, запуска кибератак на другие системы, шпионажа за вами, отслеживания ваших действий, рассылки спама по электронной почте и фишинговых атак другим людям, а также шифрования ваших файлов с целью получения выкупа.

Вы можете легко определить, что ваш компьютер взломан, если следить за этими признаками взлома в вашей системе Windows 11. Если у вас уже есть скрытые подозрения, что ваш компьютер может быть скомпрометирован, эта статья поможет вам это подтвердить.

1. Вы получаете сообщение с требованием выкупа

Самый очевидный признак того, что вас взломали, — это внезапное получение сообщения о выкупе из ниоткуда. Эти сообщения могут принимать различные формы, например, прямые сообщения, электронные письма или даже отображаться на вашем экране с помощью вредоносных программ, таких как программы-вымогатели.

Представьте себе, что вы загружаете свой компьютер и видите сообщение с требованием выкупа, блокирующее вас из вашей системы. Вы не можете ничего нажать или закрыть окно. В некоторых случаях они заявят, что ваши учетные записи были скомпрометированы, а информация украдена, и даже предоставят вам некоторые доказательства по электронной почте или в сообщении.

В любом случае они сообщат вам, что вас взломали, и потребуют какую-либо форму оплаты, обычно в криптовалюте. В противном случае они пригрозят выбросить данные в Интернет или потерять ваши файлы навсегда.

Не платите выкуп. Даже если вы заплатите, нет никакой гарантии, что вы восстановите доступ к своему компьютеру или вернете украденные файлы. Если они утверждают, что ваши онлайн-аккаунты взломаны, немедленно войдите в эти учетные записи, измените пароли и, если возможно, включите двухфакторную аутентификацию. Затем обратитесь к поставщику услуг и сообщите, что вас взломали.

Если вы стали жертвой атаки программы-вымогателя и ваша система заблокирована, сотрите жесткий диск и восстановите его из резервной копии (если она у вас есть) или переустановите ОС.

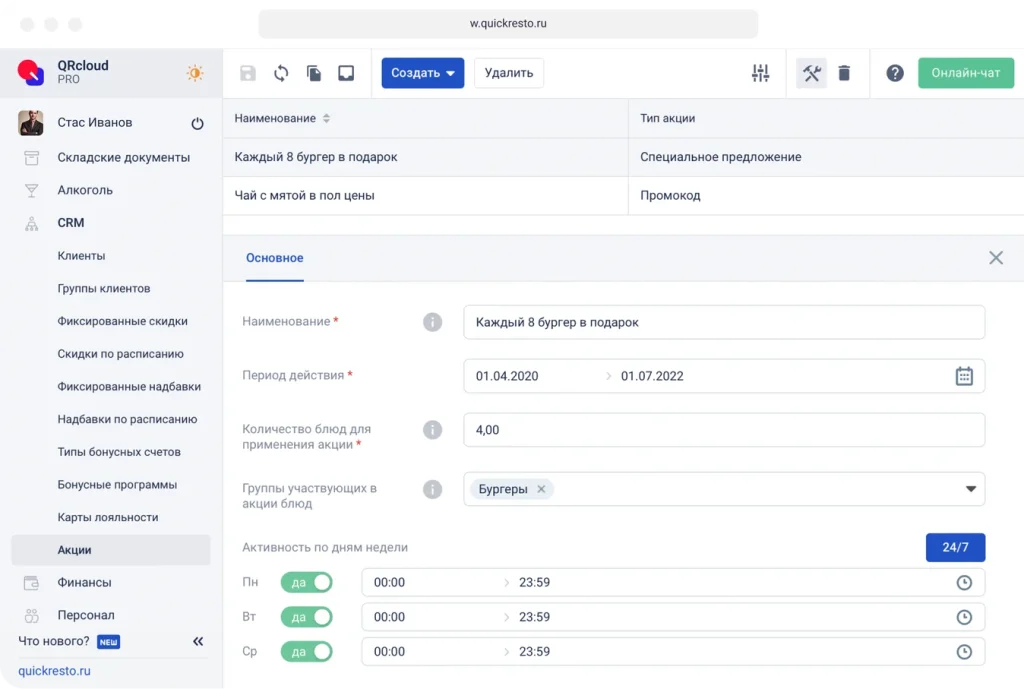

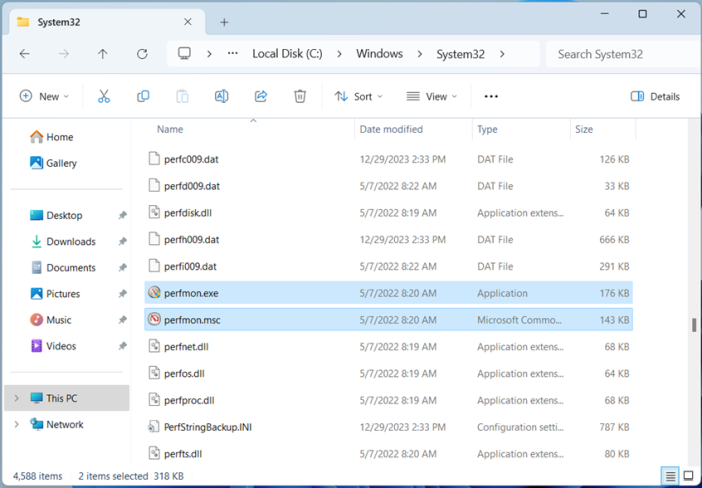

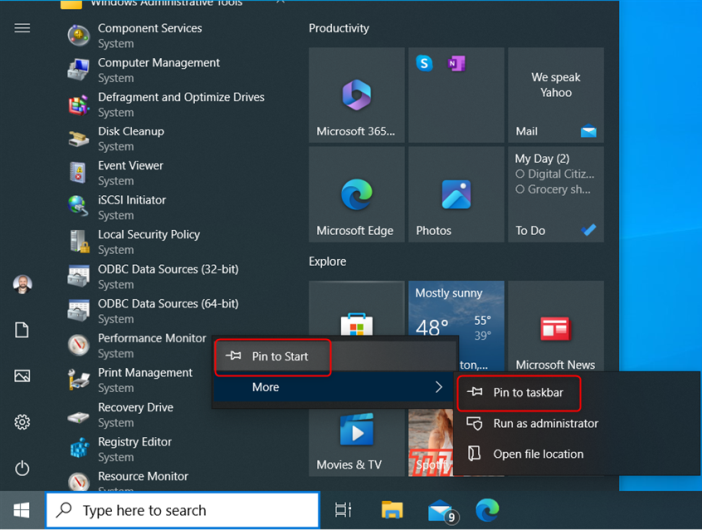

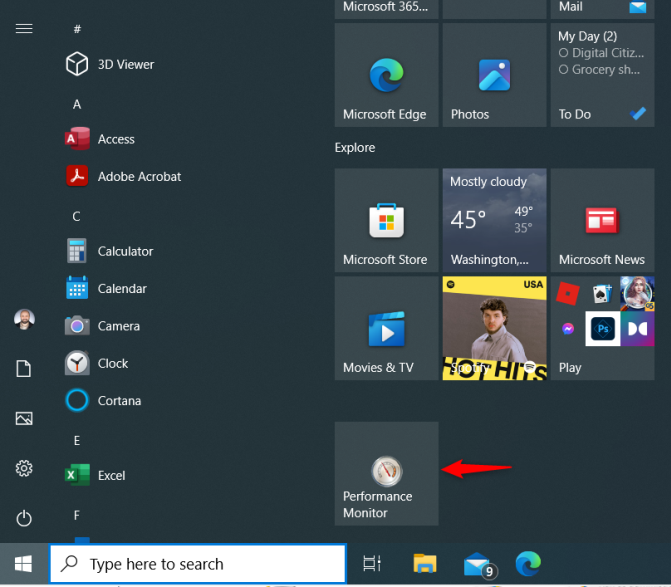

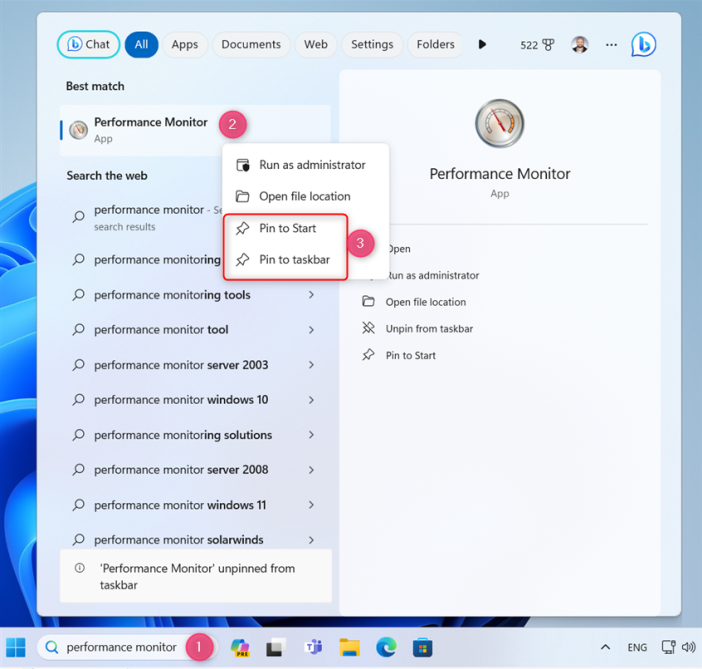

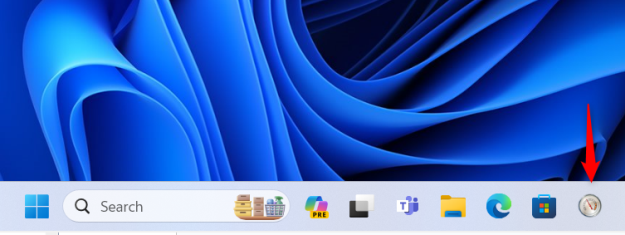

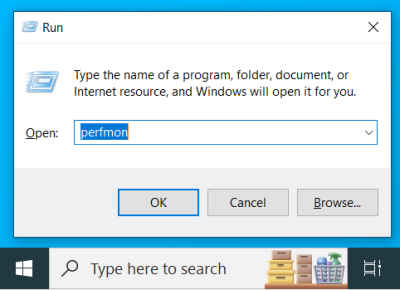

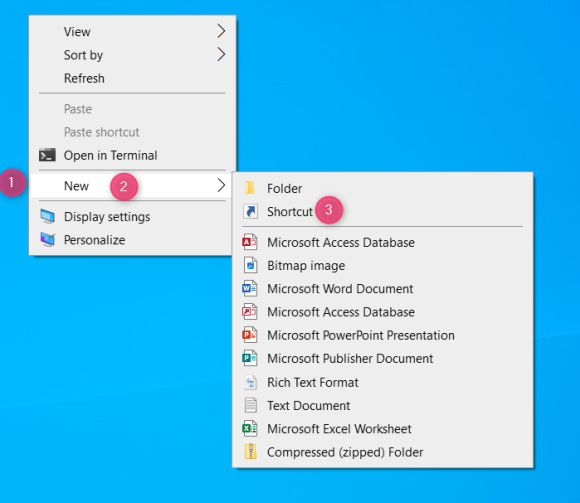

2. Подозрительное программное обеспечение на вашем компьютере

Обнаружение новых программ, установленных на вашем компьютере с Windows 11, является серьезным сигналом того, что он, возможно, был взломан, особенно если вы являетесь единственным пользователем.

Хотя производитель вашего устройства может предварительно устанавливать различные приложения, а устанавливаемое вами программное обеспечение (особенно бесплатное) часто поставляется в комплекте с дополнительными программами, вполне вероятно внезапное появление новых и незнакомых приложений при запуске вашей системы, на панели задач, в панели уведомлений или на рабочем столе. признак заражения вредоносным ПО.

Не все вредоносные программы будут видны на панели задач, панели задач или на рабочем столе. Вместо этого он может тихо работать в фоновом режиме. Откройте диспетчер задач и найдите любые странные имена с высокой загрузкой процессора, памяти, дискового пространства или сети, которые вы не можете объяснить.

Хакеры часто устанавливают эти вредоносные программы на ваш компьютер без вашего ведома, чтобы украсть личные данные, отслеживать онлайн-активность или даже получить контроль над устройствами. Если вы наткнетесь на какие-либо незнакомые приложения, установленные на вашем компьютере, не игнорируйте их. Покопайтесь, чтобы узнать, являются ли они законными или вредоносными. Ищите обзоры, отчеты и предупреждения из надежных источников.

3. Вредоносные процессы в диспетчере задач

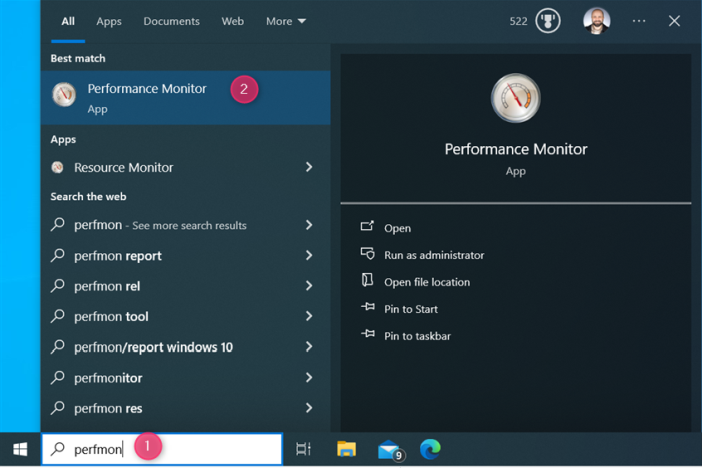

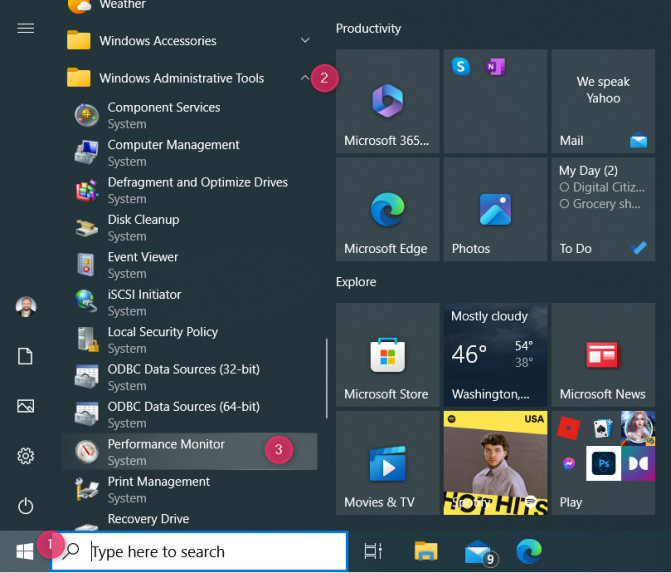

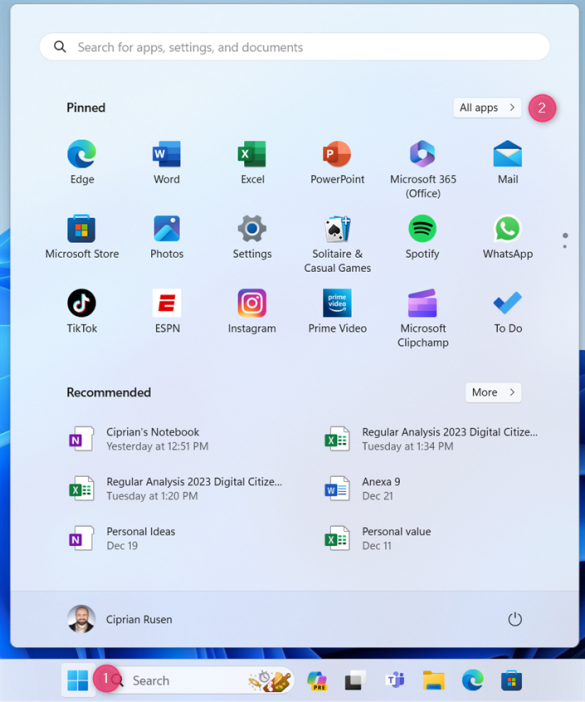

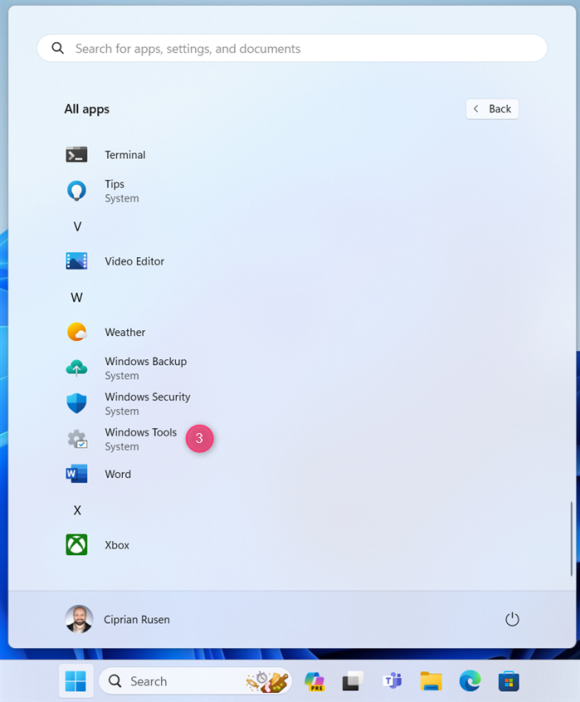

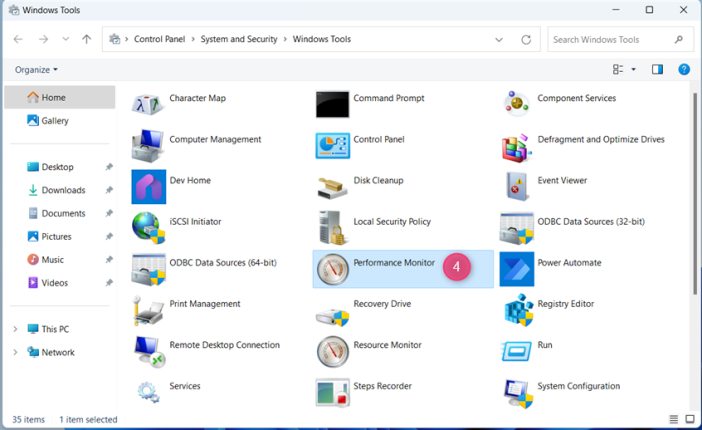

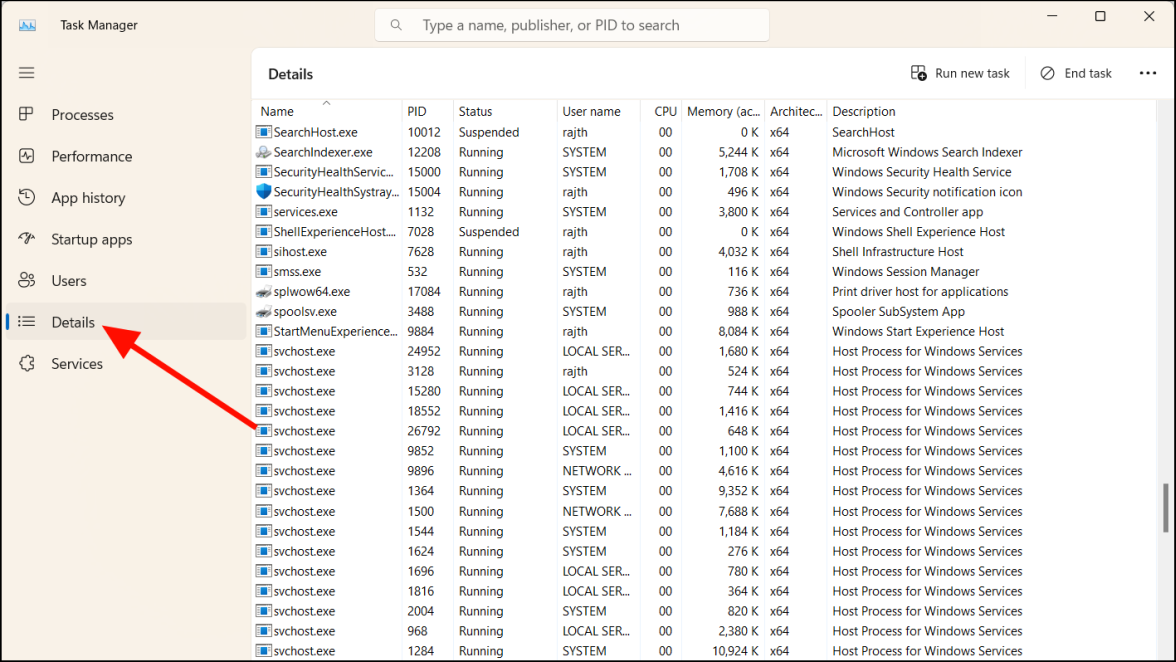

Диспетчеры задач Windows отображают все программы и процессы, запущенные на вашем компьютере. Его можно использовать для обнаружения вредоносных или неизвестных процессов, которые используют много ресурсов или пропускную способность сети. Вот как это можно сделать:

- Откройте диспетчер задач, щелкнув правой кнопкой мыши на панели задач и выбрав «Диспетчер задач».

- Перейдите на вкладку «Подробности» и найдите все подозрительные процессы. Вы также можете проверить раздел «Описание», чтобы узнать, к каким сервисам принадлежит процесс.

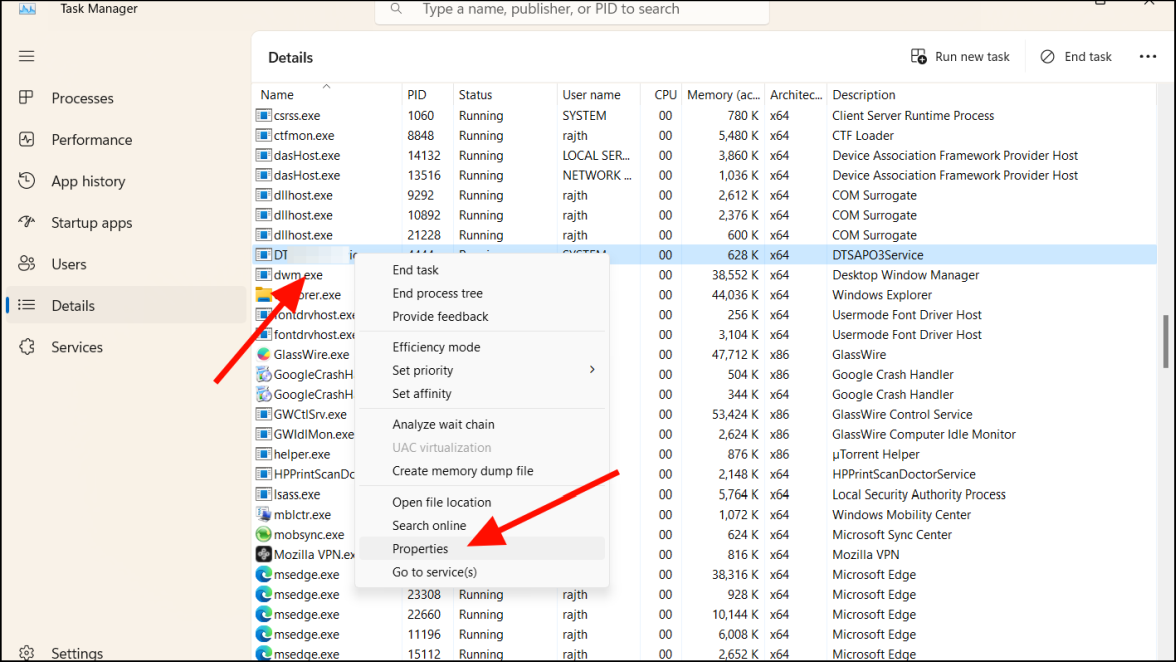

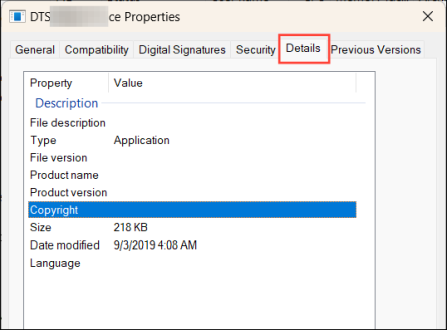

- Щелкните правой кнопкой мыши по подозрительному процессу и выберите «Свойства». Если процесс принадлежит доверенной сторонней службе, вам, вероятно, не о чем беспокоиться. Однако всегда полезно проверить подлинность процесса.

- Затем перейдите на вкладку «Подробности», чтобы получить дополнительную информацию о процессе.

- Если сведения о процессе кажутся подозрительными или в разделе «Описание файла» или «Авторские права» отсутствует информация, как показано на изображении выше, то, скорее всего, это вредоносное ПО.

Выполнив эти шаги, вы сможете найти и устранить любые вредоносные процессы и приложения, которые могут представлять угрозу вашей конфиденциальности и безопасности.

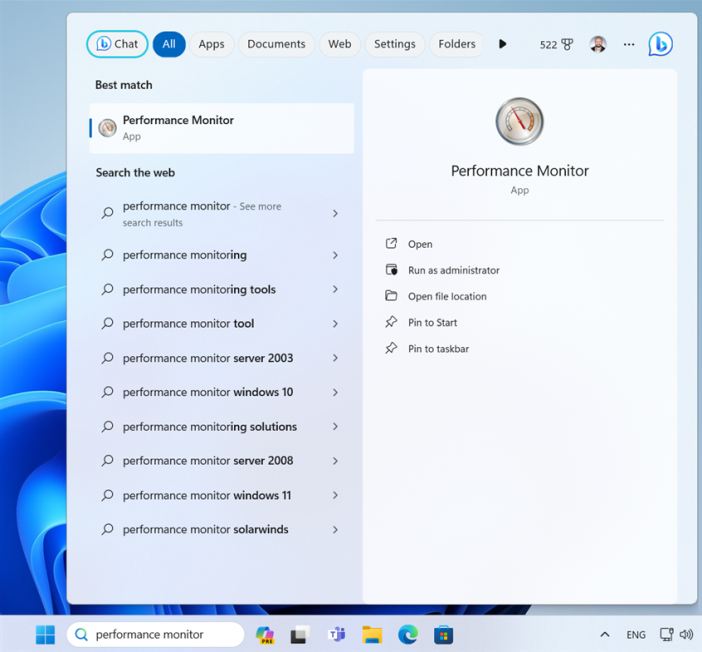

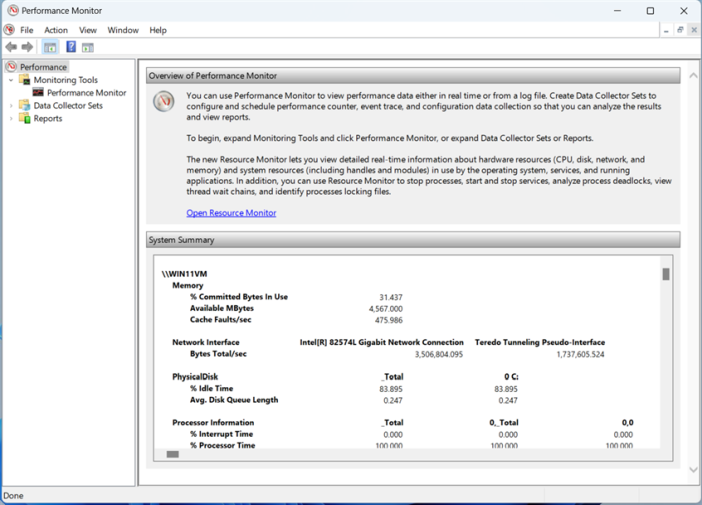

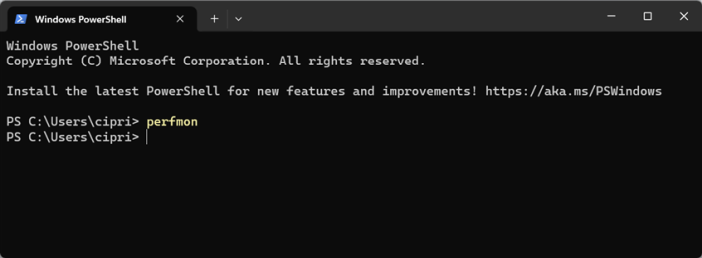

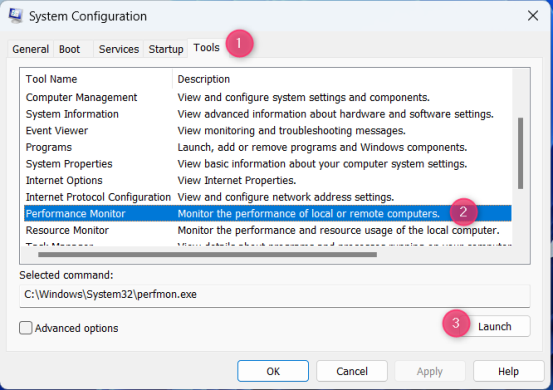

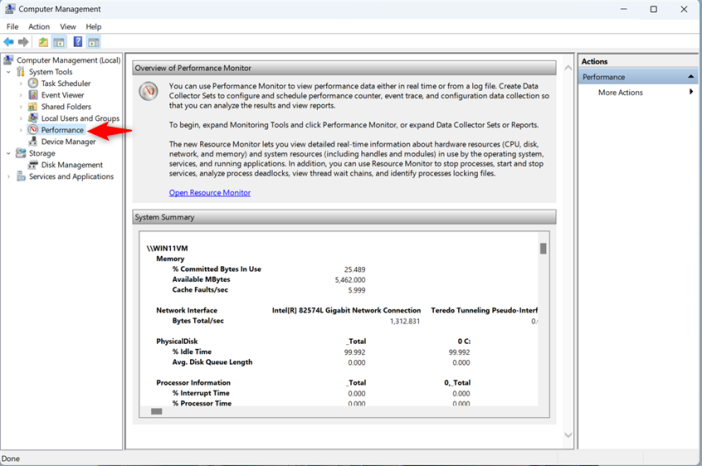

4. Необычная сетевая активность

Если вы заметили необычный всплеск сетевой активности, особенно когда вы не используете какие-либо онлайн-приложения или службы, это может означать, что вас взломали. Хакер может удаленно подключиться к вашему компьютеру, чтобы получить доступ или использовать вашу пропускную способность в злонамеренных целях, например для присоединения к бот-сети. Обычно это приводит к увеличению использования сети.

Вы можете установить инструменты мониторинга сетевого трафика, такие как Glasswire или Nagios Core, чтобы отслеживать, какие приложения используют пропускную способность вашего компьютера. Если вы предпочитаете интерфейс командной строки, вы можете использовать встроенную команду Windows «netstat», чтобы проверить все активные подключения и открытые порты на вашем ПК.

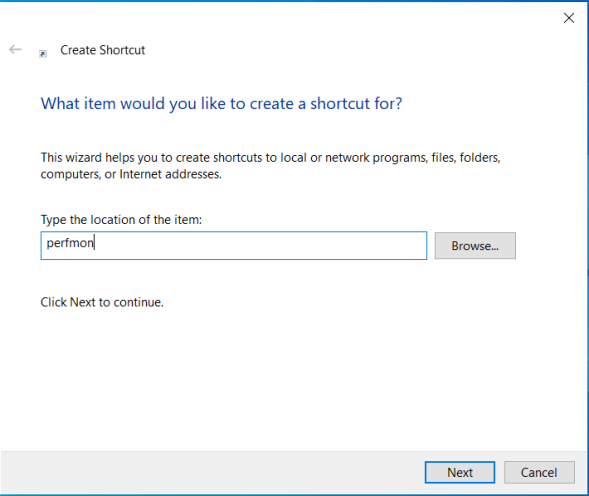

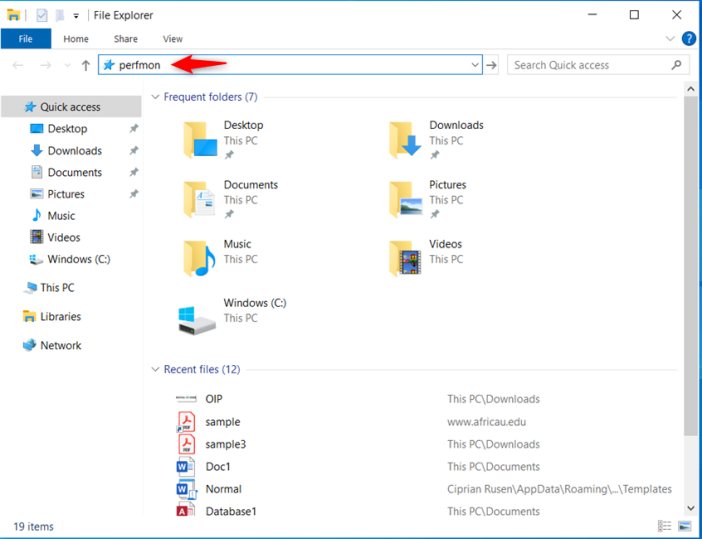

5. Проверьте наличие подозрительных соединений

Как упоминалось ранее, вредоносное ПО использует удаленные подключения к компьютеру или серверу хакеров, куда отправляются данные, или хакер использует вашу пропускную способность для проведения атак на другие компьютеры. Все это требует внешнего подключения к вашему компьютеру. Проверив любое подозрительное соединение, вы сможете узнать, были ли вас взломаны.

Ищите подозрительные связи

Ваш компьютер может поддерживать скрытые соединения, которые хакеры используют, чтобы шпионить за вами. К счастью, вы можете обнаружить эти соединения с помощью встроенного инструмента Windows под названием «Командная строка».

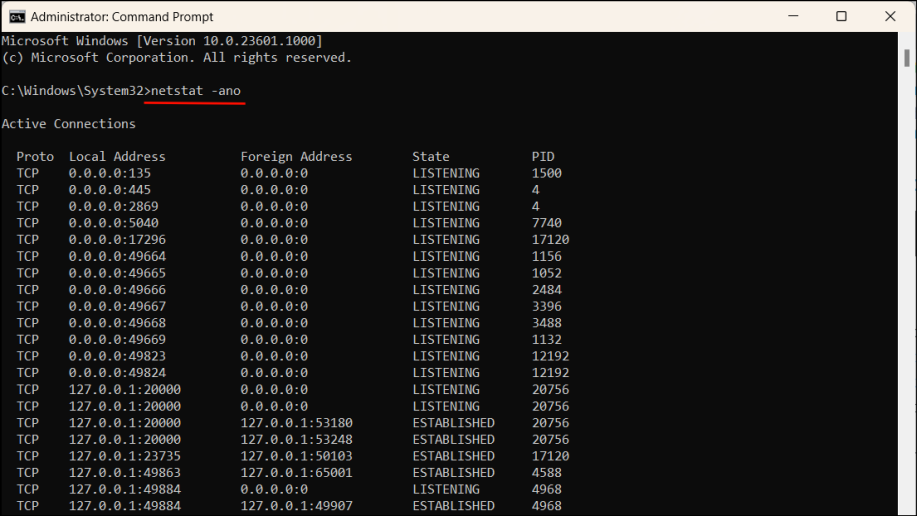

- Откройте командную строку от имени администратора.

- Затем введите следующую команду в окно и нажмите

Enter:

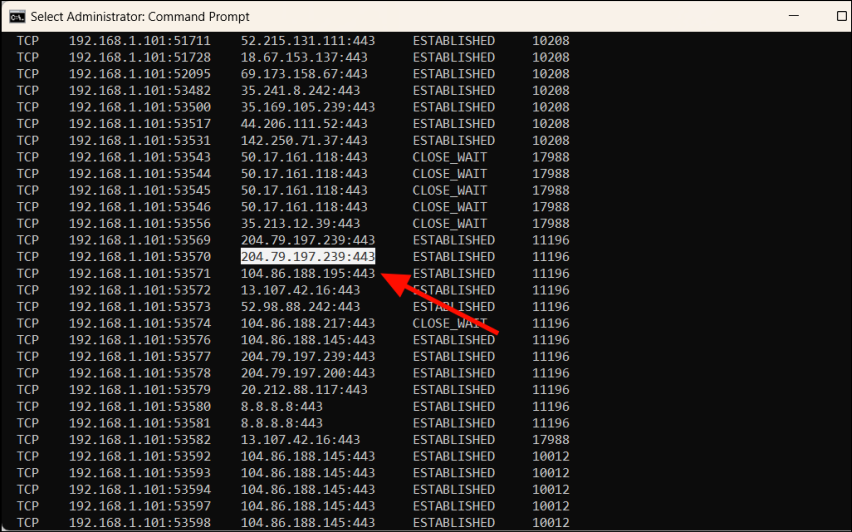

netstat -ano

Эта команда отобразит список всех активных TCP-соединений на вашем компьютере. Сосредоточьтесь на столбце «Состояние», особенно на соединениях, помеченных как «Установленные». Эти соединения указывают на связь в реальном времени между вашим компьютером и удаленным IP-адресом.

Анализ установленных связей

- Скопируйте IP-адрес из столбца «Внешний адрес» для любого соединения, которое кажется подозрительным. Или вы можете проверить каждый установленный IP-адрес, если вас это беспокоит.

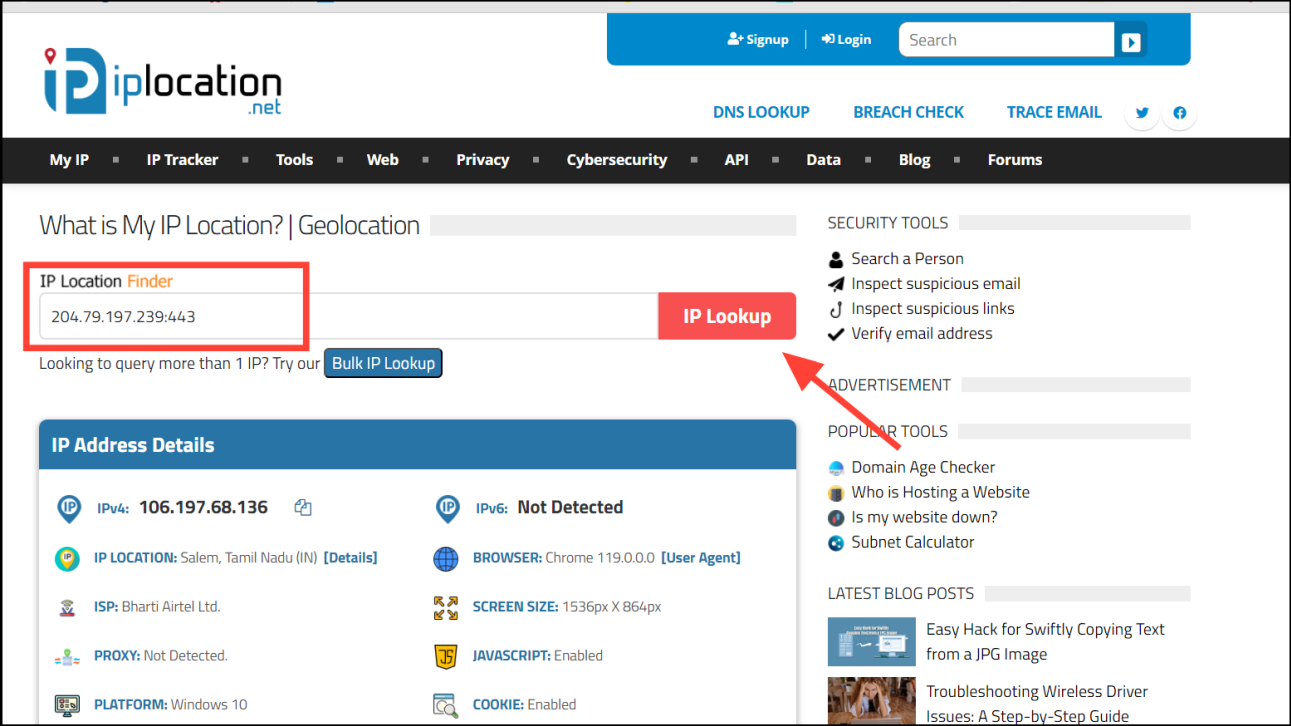

- Посетите популярный сайт поиска IP-адресов, например IPLocation.net, и вставьте скопированный IP-адрес в поле IP Location Finder. Затем нажмите кнопку «Поиск IP».

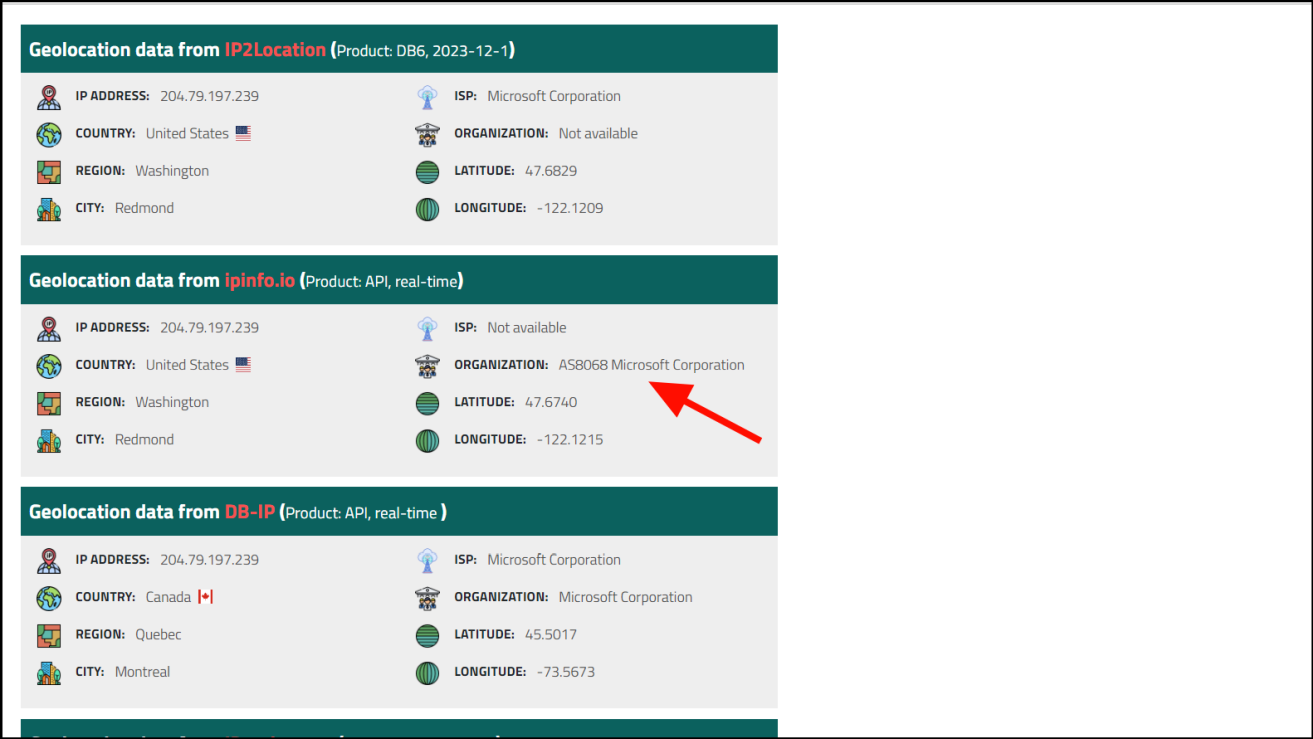

- Теперь проверьте интернет-провайдера и организацию, связанную с IP-адресом. Если он принадлежит уважаемой компании, которой вы пользуетесь, например Google или Microsoft, скорее всего, он безопасен.

- Если IP-адрес принадлежит неизвестной или подозрительной компании или компании, услугами которой вы не пользуетесь, проверьте дальше. Узнайте больше об этой компании. Если Компания подозрительна или сомнительна, значит, вас взломали.

6. Пароли/логины перестали работать

Если вы заметили, что один или несколько ваших сетевых паролей не работают, даже если вы уверены, что вводите правильные пароли, скорее всего, вас взломали.

Если ваш пароль не работает, иногда это просто временный сбой на стороне сайта. Подождите от 10 до 30 минут и повторите попытку позже. Но если ваш пароль постоянно не работает, вполне вероятно, что кто-то проник в вашу учетную запись и изменил пароль, чтобы заблокировать вас.

Мошенники-фишинг Мошенники рассылают электронные письма под видом вашего банка, компании-эмитента кредитной карты или другого надежного источника. Они попытаются обманом заставить вас нажать на ссылку или открыть вложение. Но не поддавайтесь этому! Эта ссылка ведет на поддельный веб-сайт, который выглядит так же, как настоящий. Как только вы введете туда свои данные для входа, мошенник украдет их, заблокирует вас из вашей учетной записи и сможет делать все, что захочет.

7. Подозрительные входы в систему

Некоторые хакеры не всегда могут попытаться полностью завладеть вашей учетной записью. Вместо этого они могут скрываться в фоновом режиме, используя вашу учетную запись для сбора конфиденциальной информации без вашего ведома.

Поэтому вам следует регулярно проверять активность своей учетной записи и историю входов в систему. Если вы заметили какие-либо необычные попытки входа или действия, это может означать несанкционированный доступ. Если вы заметили, что сеансы входа происходят из другой страны или происхождения, это означает, что ваша учетная запись была скомпрометирована.

Когда злоумышленники получают доступ к вашему адресу электронной почты, одна из их целей — заразить как можно больше компьютеров. Они используют вашу учетную запись электронной почты для рассылки зараженных сообщений электронной почты как можно большему количеству людей из ваших контактов, надеясь обманом заставить их перейти по вредоносным ссылкам или загрузить вредоносное ПО.

Если ваши друзья, родственники или коллеги сообщают вам, что они получили спам с вашей учетной записи электронной почты, это признак того, что ваша учетная запись взломана.

8. Периферийные устройства ведут себя странно

Еще одним явным признаком того, что ваш компьютер взломали, является то, что периферийные устройства ведут себя странно. Следите за этими признаками того, что ваши периферийные устройства были скомпрометированы:

- Кажется, что ваш курсор обладает собственным разумом: он перемещается без вашего прикосновения к мыши, нажатия на случайные места или открытия файлов и приложений.

- Ваша камера и микрофон начинают запись без вашего разрешения.

- Копирование или перемещение файлов на USB-накопитель без вашего участия.

- Принтеры и мониторы могут вести себя странно, выдавая сообщения об ошибках из ниоткуда.

Прежде чем делать какие-либо предположения, вы должны уметь отличать последствия вредоносного ПО от реальных аппаратных сбоев. Если вы заметили небольшие изменения в поведении вашего устройства во время использования компьютера, сначала проверьте наличие проблем с оборудованием. Иногда грязь может попасть внутрь мыши, вызывая случайные щелчки и движения. Плохой USB-кабель может повредить вашу веб-камеру, заставляя ее включаться и выключаться случайным образом.

9. Батарея ПК быстро разряжается, а вентиляторы работают шумно.

Ваша батарея быстро разряжается, а вентиляторы звучат так, будто вот-вот взлетят. Это признаки того, что ваш компьютер работает сверхурочно, и это может быть не из-за вас.

Обратите внимание на эти тонкие предупреждения о том, что на вашем компьютере может быть вредоносное ПО:

- Вы постоянно слышите, как вентилятор вашего компьютера работает на полной скорости, даже когда вы не делаете ничего требовательного?

- Ваш ноутбук или компьютер ощущается некомфортно теплым, даже когда вы просто пользуетесь Интернетом?

- В вашем устройстве очень быстро разряжается аккумулятор и его приходится заряжать много раз в день?

Если вы заметили какой-либо из этих признаков, стоит присмотреться к своему компьютеру. Вокруг вас может скрываться вредоносное или шпионское ПО, истощающее ваши ресурсы и подвергающее риску вашу систему.

Также возможно, что пыль и мусор засоряют вентиляторы и компоненты, вызывая неконтролируемое вращение вентиляторов и перегрев компьютера.

10. Ваш сетевой трафик и поисковые запросы перенаправляются.

Хакеры могут получить доступ к вашему маршрутизатору или браузеру и изменить его настройки, например систему доменных имен (DNS). Изменив настройки DNS, они могут перенаправить ваш трафик на вредоносные веб-сайты или серверы.

Они часто перенаправляют ваши клики и поисковые запросы на веб-сайты, которые платят им за трафик, например рекламные сайты, маркетинговые сайты или мошеннические сайты. Есть несколько признаков того, что ваш трафик перенаправляется.

- В результатах поиска часто появляются одни и те же нерелевантные веб-сайты.

- Увеличилось количество всплывающих окон и рекламы, особенно из неизвестных источников.

- Домашняя страница вашего браузера автоматически изменилась на другой веб-сайт, отличный от того, который вы установили.

Вы также можете использовать такие инструменты, как Wireshark, для анализа сетевого трафика на предмет необычной активности или подключений к подозрительным доменам.

11. Производительность вашего ПК низкая, и приложение вылетает.

Если ваш компьютер внезапно стал работать медленно и часто дает сбой, это может быть признаком того, что его взломали. Шпионское ПО, вирусы и программное обеспечение для удаленного управления могут потреблять большой объем системных ресурсов, в результате чего другие программы не могут работать должным образом.

Вот некоторые симптомы, с которыми вы можете столкнуться:

- Медленно загружаются веб-сайты и приложения.

- Воспроизведение мультимедиа зависает или заикается

- Неожиданный сбой приложения

- Проблемы с буферизацией видео и онлайн-игр

- Чрезмерное использование данных, особенно на ограниченных тарифных планах.

Откройте диспетчер задач на своем компьютере с Windows и отслеживайте загрузку ЦП каждым приложением. Если ваш компьютер ничего не делает, загрузка ЦП должна составлять 10–15%. Игры могут использовать более 50%, но любое неизвестное приложение, требующее более 30%, является поводом для беспокойства. Если приложение потребляет более 90% ресурсов вашего процессора, возможно, у вас на руках вредоносное ПО.

12. Отключенные инструменты безопасности

Если ваше программное обеспечение безопасности отключено, это очевидный признак того, что ваш компьютер мог быть скомпрометирован. Если вы заметили, что ваше программное обеспечение безопасности не работает должным образом, например, не запускается должным образом, неожиданно завершает работу, отключены обновления или не выполняется сканирование.

Некоторые вредоносные программы могут отключить ваши инструменты безопасности, делая вас уязвимыми, затрудняя обнаружение и позволяя хакерам нанести ущерб вашей системе.

Вы можете попробовать основные действия по устранению неполадок, такие как перезапуск, закрытие и повторное открытие программного обеспечения безопасности. Но если проблемы по-прежнему возникают, вы считаете, что ваш компьютер заражен вредоносным ПО. Сложные вредоносные программы, такие как программы-вымогатели, рекламное ПО и шпионское ПО, часто трудно обнаружить, заблокировать или удалить с помощью бесплатных антивирусных программ.

Вам следует регулярно сканировать свой компьютер на наличие вредоносных программ и ловить их, пока не стало слишком поздно. Вам также следует обращать внимание на предупреждения, такие как уведомления антивируса о подозрительных файлах, и тщательно их проверять. Если что-то выглядит подозрительно, удалите это!

Остерегайтесь всплывающих окон, утверждающих, что они исходят от вашего антивируса. Зачастую это мошенничество, призванное обманом заставить вас загрузить вредоносное ПО. Помните, вашему антивирусу не нужны всплывающие окна, сообщающие об угрозах. Имеет свои способы отправки уведомлений. Поэтому в следующий раз, когда появится всплывающее окно, будьте осторожны и не поддавайтесь поддельным всплывающим окнам на веб-сайтах.

13. Ваш веб-браузер изменен.

Еще одним убедительным признаком того, что ваш компьютер мог быть скомпрометирован, является то, что хакеры вносят в ваш браузер изменения, которые вы не вносили. Иногда эти изменения очевидны, например, таинственно измененная домашняя страница веб-браузера, поисковая система по умолчанию или незнакомые панели инструментов. Иногда это не так очевидно, как неизвестные плагины или расширения, которые вы не установили, или увеличение количества всплывающих окон и перенаправлений.

- Неизвестные расширения или панели инструментов. Если вы видите в своем браузере новые расширения или панели инструментов, которые вы не устанавливали, это признак того, что что-то не так. У этих панелей инструментов и расширений могут быть хитрые названия, подразумевающие, что они могут помочь вам в выполнении различных задач. Но если вы его не устанавливали, скорее всего, это вредоносное ПО. Эти расширения могут использоваться для слежки за вашей историей посещений, показа рекламы или даже кражи вашей личной информации.

- Изменения домашней страницы или поисковой системы. Как мы уже упоминали ранее, если домашняя страница вашего браузера или поисковая система были изменены без вашего ведома, это признак того, что ваша система могла быть взломана. Хакеры часто меняют эти настройки, чтобы перенаправить вас на свои веб-сайты, где они могут украсть ваши данные или использовать вас с помощью кликбейта.

- Всплывающие рекламные окна и перенаправления. Большинство веб-сайтов в Интернете поддерживают рекламу, но если вы видите на своих обычных веб-сайтах больше всплывающих окон, чем обычно, или если вас перенаправляют на незнакомые веб-сайты, это признак того, что ваш браузер возможно, он был заражен вредоносным ПО. Эти объявления и перенаправления могут быть использованы для того, чтобы заставить вас перейти по вредоносным ссылкам или загрузить вредоносные файлы.

Другие признаки включают низкую производительность браузера и необычную активность в истории вашего браузера.

14. Проверка того, были ли ваши личные данные скомпрометированы в результате утечки данных

Утечки данных — это печальная реальность, которая может случиться с кем угодно и когда угодно. Когда ваша личная информация украдена в результате утечки данных, она может оставаться незамеченной в течение многих лет, пока украденные данные не будут выставлены на продажу в даркнете или не станут общедоступными.

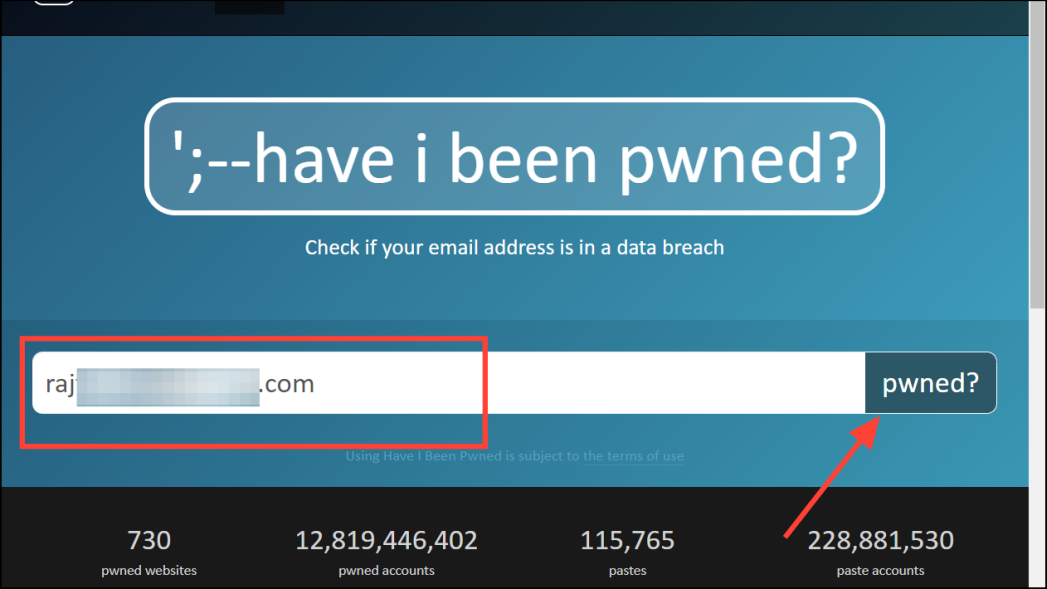

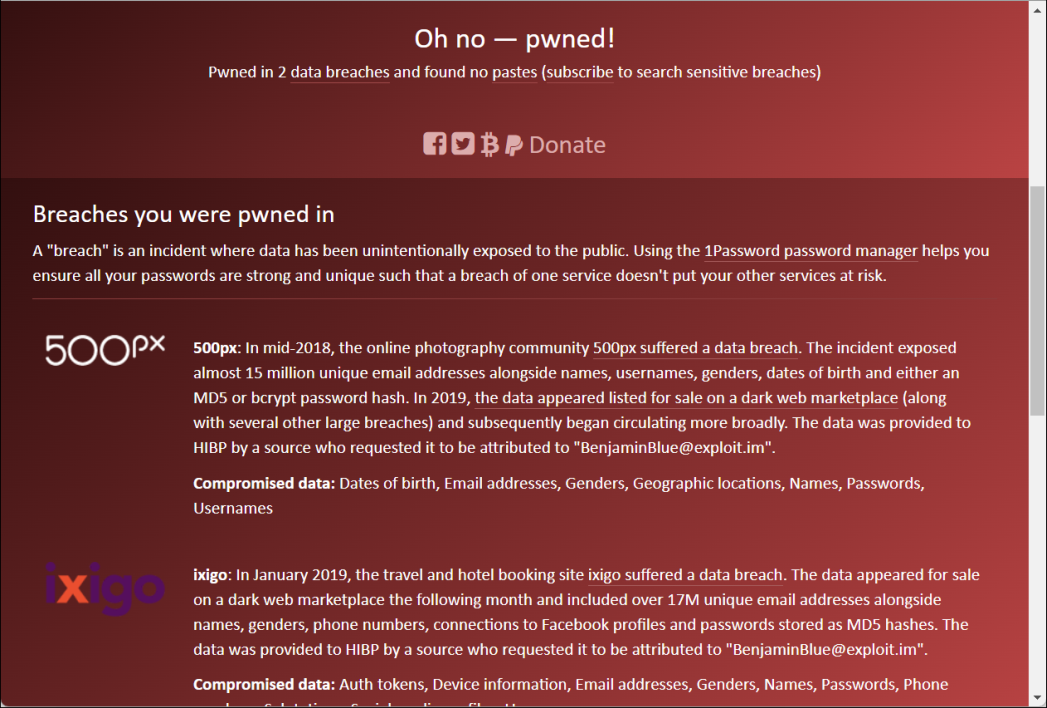

Но есть способ узнать, были ли скомпрометированы ваши данные. Некоторые веб-сайты могут проверять скомпрометированные адреса электронной почты. Одним из самых надежных веб-сайтов является «Have I Been Pwned», который поддерживает доступную для поиска базу данных всех известных утечек данных.

Have I Been Pwned — это надежный веб-сайт, который проверяет ваш адрес электронной почты по базе данных нарушений и сообщает, был ли он взломан. Он также показывает самые последние и крупнейшие нарушения.

Перейдите в раздел «Я был взломан», введите свой адрес электронной почты в поле поиска, электронные письма и нажмите «Pwned?» кнопка. Если ваш адрес электронной почты был скомпрометирован, вы увидите список нарушений и дату их возникновения.

Затем пришло время установить разные надежные пароли для каждого веб-сайта, который вы видите в списке. Вы также можете подписаться на уведомления о новых нарушениях. Это поможет защитить ваши аккаунты от взлома.

Как предотвратить взлом вашего компьютера

Хотя ни один компьютер не является полностью безопасным, соблюдение этих надежных методов может существенно защитить ваш компьютер от хакеров:

- На вашем компьютере всегда должна быть установлена надежная антивирусная программа или программа защиты от вредоносных программ.

- Прекратите установку пиратского программного обеспечения и игр, какими бы заманчивыми они ни были.

- Не открывайте сомнительные электронные письма и не нажимайте на подозрительные ссылки.

- Всегда используйте надежные пароли для своих учетных записей и избегайте использования одного и того же пароля для всех своих учетных записей.

- Будьте осторожны при использовании неизвестных или заимствованных USB-накопителей. Они могут быть заражены вредоносным ПО.

- Активируйте и настройте брандмауэр для фильтрации неизвестного трафика.

- Загружайте программное обеспечение или файлы только из надежных источников. Остерегайтесь бесплатного или пиратского контента.

- Избегайте использования общедоступного Wi-Fi для конфиденциальных действий, таких как банковские операции или онлайн-покупки.

- Регулярно создавайте резервные копии важных файлов на случай атак программ-вымогателей или кражи данных.

- Если возможно, используйте двухфакторную аутентификацию для своих учетных записей.

- Регулярно обновляйте свою Windows.

Если вы считаете, что ваш компьютер взломали, действуйте быстро, прежде чем будет нанесен еще больший ущерб. Чем дольше вы ждете, тем больше времени у злоумышленника есть для кражи ваших данных. В некоторых случаях хакеры могут получить полный контроль над вашим компьютером, сделав его доступным или даже непригодным для использования.

2024-01-04T21:39:32

Вопросы читателей