DALL-E 2 и Stable Diffusion — два примера систем искусственного интеллекта, которые могут создавать реалистичные изображения из текстовых описаний. Оба они основаны на моделях глубокого обучения, разработанных с использованием огромных наборов изображений и текстовых данных. Они могут создавать изображения, соответствующие текстовым подсказкам, а также изменять существующие изображения или создавать варианты на основе текста.

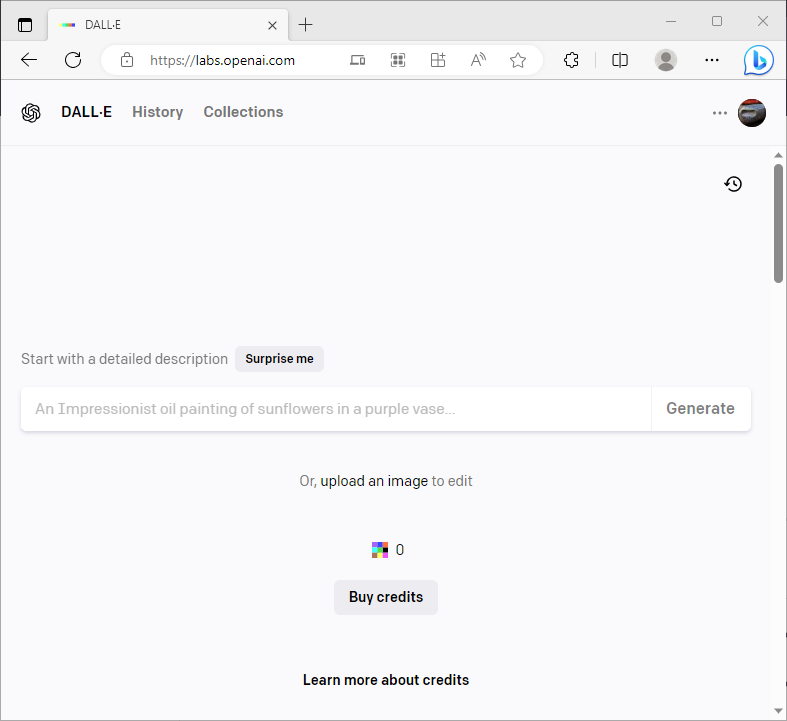

Что такое ДАЛЛ-И 2

DALL-E 2 — это система, разработанная OpenAI, исследовательской организацией, занимающейся созданием и продвижением полезного искусственного интеллекта. DALL-E 2 — это расширение DALL-E, которое было представлено в январе 2021 года как система, способная создавать изображения из текста с помощью нейронной сети под названием GPT-3.

Помимо создания оригинальных визуальных эффектов из текста, DALL-E 2 также способен закрашивать, закрашивать и переводить изображение в изображение. Заполнение недостающих или поврежденных частей изображения, например удаление объекта или восстановление поврежденной фотографии, — это процесс, известный как рисование. Практика перерисовки предполагает увеличение изображения за пределы его первоначальных ограничений, например, за счет добавления большего количества декораций или фоновых объектов. Перевод изображения в изображение — это процесс изменения стиля или содержания изображения, например преобразование эскиза в картину или изменение сезона или времени суток.

DALL-E 2 также может сочетать концепции, атрибуты и стили из разных областей, таких как животные, растения, предметы, искусство и культура. Например, он может создавать изображения животных с разными характеристиками или аксессуарами, растений разной формы или цвета, предметов из разных материалов или функций, искусства с разными жанрами или техниками и культуры с разными символами или отсылками.

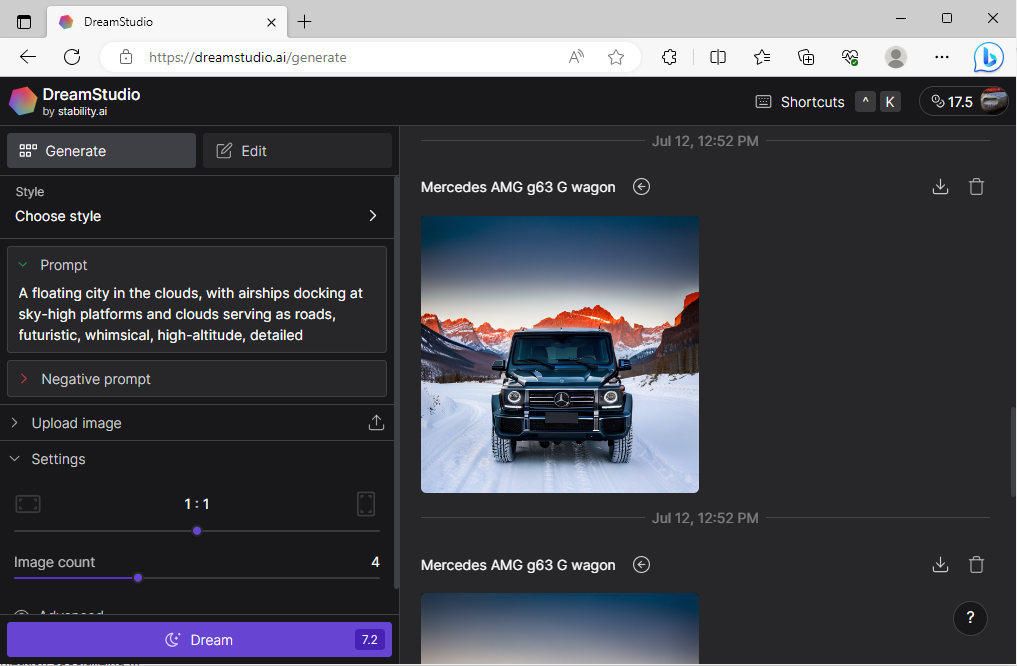

Что такое Stable Diffusion

Stable Diffusion — это система, разработанная исследователями из CompVis Group в Мюнхенском университете Людвига-Максимилиана и Runway при участии Stability AI и обучающих данных от некоммерческих организаций. Стабильная диффузия основана на новом типе модели глубокого обучения, называемой моделью скрытой диффузии (LDM), которая была изобретена теми же исследователями в 2020 году.

Чтобы создать визуальные эффекты из текста, Stable Diffusion использует процесс диффузии. Вместо добавления шума к изображению, чтобы сделать его менее четким, диффузия удаляет шум из изображения, чтобы сделать его более четким. Начиная с последовательности случайных точек, Stable Diffusion постепенно меняет этот шаблон, создавая изображение, соответствующее текстовой подсказке. Он использует другую нейронную сеть под названием CLIP, чтобы управлять процессом распространения, сравнивая изображение и текст на каждом этапе.

Разница между DALL-E 2 и Stable Diffusion

DALL-E 2 более креативен и разнообразен, но менее доступен и имеет более высокое разрешение, чем Stable Diffusion. Stable Diffusion более доступен и имеет меньшее разрешение, но менее креативен и разнообразен, чем DALL-E 2. Ниже приведены некоторые различия между ними:

| Функции | ДАЛЛ-И 2 | Стабильная диффузия |

| Разрешение | 1024×1024 пикселей | 512×512 пикселей |

| Доступность | плата, необходимая для доступа к сервису API OpenAI | Платные и бесплатные версии могут работать на большинстве потребительских устройств со скромным графическим процессором. |

| Креативность | Высокий, может сочетать понятия из разных областей, таких как животные, растения, предметы, искусство и культура. | Средний, не может так легко объединить концепции из разных областей, как DALL-E 2. |

| Разнообразие | Высокий, может генерировать разные изображения для одной и той же текстовой подсказки, например, разные породы и окрасы собак для слова «собака». | Средний, имеет тенденцию генерировать менее разнообразные изображения для одной и той же текстовой подсказки, например, похожие на вид собаки вместо «собака». |

| Качество | Высокий, может создавать четкие и реалистичные изображения для большинства текстовых подсказок, например лица для «человека». | Средний, может создавать размытые или искаженные изображения для некоторых текстовых подсказок, например лица для «человека». |

| Модельная архитектура | Этот метод основан на GPT-3 и CLIP и использует априорный код, который генерирует встроенное изображение CLIP, текстовую подпись и декодер, который генерирует изображение при условии встраивания изображения. | Использует метод, называемый диффузией, для создания визуальных эффектов из текста на основе моделей скрытой диффузии (LDM) с помощью нейронной сети CLIP. |

| Размер модели | 3,5 миллиарда параметров | 1,5 миллиарда параметров |

| Данные обучения | 250 миллионов пар изображение-текст из Интернета | 5 миллиардов пар изображение-текст от некоммерческих организаций |

Заключение

DALL-E 2 и Stable Diffusion — два впечатляющих примера систем искусственного интеллекта, которые могут создавать изображения из текста. Оба используют модели глубокого обучения, которые были разработаны с использованием огромных наборов изображений и текстовых данных и способны закрашивать, закрашивать и переводить одно изображение в другое.