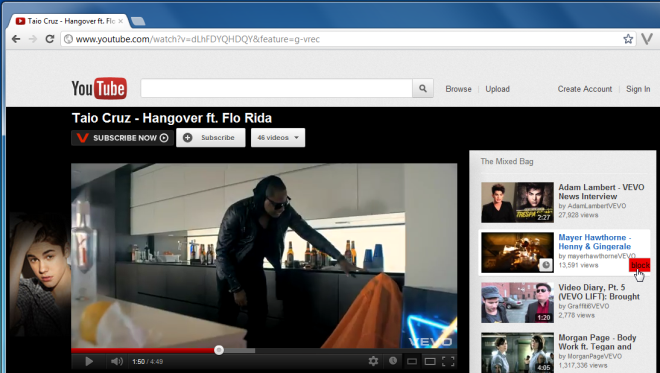

Слушая музыку или просматривая любимые видео на YouTube, мы часто отвлекаемся на связанные с или предложенный видео на боковой панели. Хотя мы всегда можем игнорировать их, может быть один достаточно настойчивый, чтобы заставить вас потерять фокус и перейти к этому видео вместо того, что вы смотрели. Хотя отвлекаться не так уж и неприятно, если вы устали вводить в заблуждение миниатюры или заголовки, тогда RE: Блокировщик каналов, расширение Chrome, это то, что вам нужно. Эта удобная утилита позволяет блокировать видео с нежелательных каналов по вашему выбору, чтобы они продолжали появляться в Предложения список. Это отличный способ отфильтровать видео с определенных каналов, которые могут испортить вам работу с YouTube.

После установки расширения всякий раз, когда вы сталкиваетесь с видео, которое вам не нравится, просто наведите указатель мыши на миниатюру, щелкните значок блокировать вариант и нажмите да при появлении всплывающего окна подтверждения. Видео будет автоматически добавлено в список заблокированных каналов, и все видео с этого конкретного канала перестанут отображаться в Связанный список.

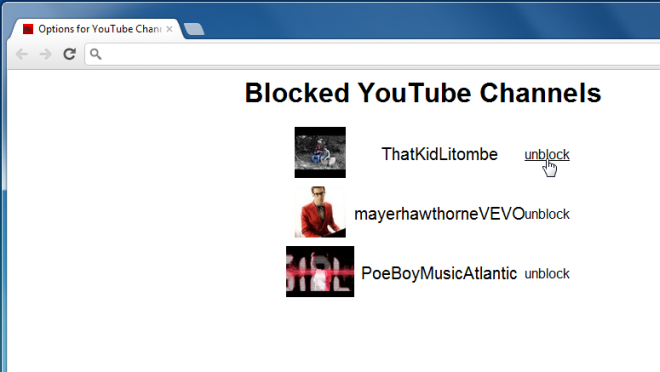

Затем вы можете управлять своими заблокированными списками, открыв Параметры страницу и разблокируйте любые каналы, когда захотите.

Расширение довольно хорошо для отсеивания нерелевантных предложений в разделе связанных видео, но если бы оно могло расширить функциональность до результатов поиска, это было бы более полезно. Связанные видео помогают нам находить больше контента для просмотра в соответствии с нашими интересами, и ими легко манипулировать каналы YouTube, но их влияние на результаты поиска намного больше. Расширение можно улучшить, добавив дополнительные фильтры для отсеивания ненужных результатов. Рейтинг видео, то есть количество лайков / антипатий, также может быть хорошим параметром для фильтрации результатов и блокировки как видео, так и каналов. На YouTube не так много собственных поисковых фильтров, поэтому все, что могло бы улучшить его или помочь сузить видео до более релевантных, было бы отличным дополнением.

RE: Channel Blocker – довольно удобное расширение, которое улучшает ваши впечатления от просмотра видео на YouTube. Этот изящный маленький инструмент не только скрывает надоедливые видео, которые продолжают появляться в списках, но и блокирует каналы для этих видео. Вы можете установить расширение по ссылке ниже.

Установите RE: Channel Blocker для Google Chrome

Если вам понравилось это расширение, вы также можете взглянуть на другие расширения Chrome, которые мы уже рассмотрели.

Сообщение Блокировать отображение определенных каналов в предложениях YouTube [Chrome] появились сначала на My Road.

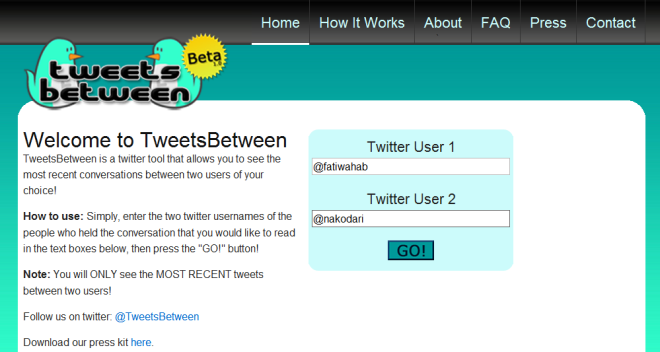

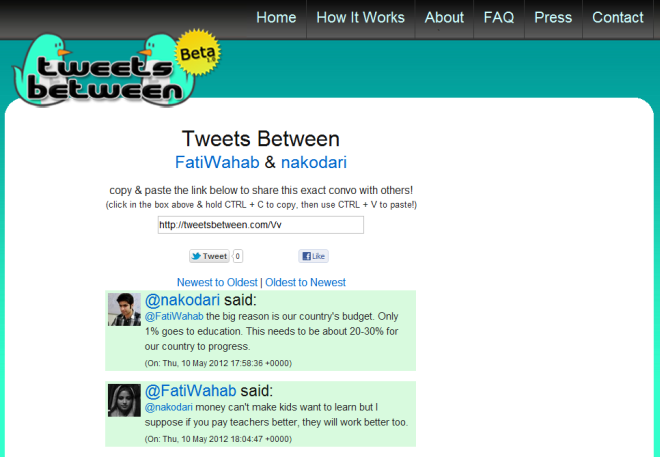

Просмотр недавних разговоров между пользователями Twitter

Твиты – это веб-приложение для Twitter, которое позволяет вам видеть последний разговор между двумя пользователями Twitter. Хотя TweetBetween – отличный инструмент, помните, что вы не можете отслеживать разговоры пользователей, у которых есть личные учетные записи Twitter. Также обратите внимание, что приложение извлекает только самые последние сообщения, поэтому вы сможете видеть разговоры только до тех пор, пока пользователи обменивались сообщениями за последнюю неделю. С его помощью вы можете быть в курсе последних сплетен между вашими любимыми людьми, знаменитостями или звездами. Больше после перерыва.

Для начала просто введите дескрипторы Twitter обоих людей в указанные поля и нажмите ИДТИ! кнопка.

После получения беседы вы сможете отсортировать ее по От новых к старым или От старых к новейшим параметры. Кроме того, вы сможете скопировать ссылку, которой вы можете поделиться с другими, или сохранить ее для дальнейшего использования.

Обратной стороной приложения является, конечно, тот факт, что можно извлечь только самые последние разговоры. хотя приложение ограничивается разговорами за последнюю неделю, вполне возможно, что между двумя пользователями могло иметь место несколько разговоров, и их невозможно просмотреть. Благодаря новому и значительно улучшенному способу просмотра разговоров в Twitters, это приложение могло бы лучше добавить дополнительные функции для просмотра старых разговоров. Функция сохранения разговоров и последующего обмена ими – это, конечно, отличный и разумный способ обмена и сохранения разговоров в Твиттере. Приложение не сообщает, что произойдет, если твит, сделанный пользователем, будет опубликован в Твиттере, но вполне вероятно, что разговор все еще будет существовать, если вы сохранили его в этом приложении до того, как он был удален.

С точки зрения интерфейса, представление беседы читабельно, но общий дизайн можно было бы немного очистить, чтобы акцент был больше на беседе, а ссылка общего доступа была выделена немного больше.

TweetsBetween – классное и простое в использовании приложение, которое позволяет отслеживать последние сплетни, сохранять разговоры или делиться ими с другими. По словам разработчика, в ближайшее время приложение будет дополнено новым дизайном и функциями. Если вы заядлый пользователь Twitter, вы можете найти TweetsBetween весьма полезным.

Если вам понравилось это приложение, вы можете также просмотреть другие веб-приложения, которые мы рассмотрели до сих пор.

Сообщение Просмотр недавних разговоров между пользователями Twitter появились сначала на My Road.

Вкладки поиска по ключевым словам, сортировка по заголовку / URL / времени [Chrome]

Одной из самых больших неприятностей, связанных с работой с большим количеством вкладок, является то, что ручки вкладок сжимаются так близко друг к другу, что значки значков исчезают. Затем, в других случаях, вы можете захотеть быстро найти слово или фразу на всех открытых вкладках, закрыть набор вкладок или переместить существующие вкладки в новое окно. Search Plus – это расширение браузера для Chrome, которое предлагает вам набор полезных функций, которые улучшают работу с вкладками. Расширение действует как поисковая система для открытых вкладок. Это помогает найти нужные вкладки, если вы можете ввести название сайта, который ищете. Поиск выполняется по окнам, поэтому не имеет значения, в каком окне открыта вкладка.. Расширение позволяет выполнять различные операции, такие как поиск определенной текстовой строки на всех вкладках, сбор вкладок в одно окно, вставка текста в заголовки вкладок, захват изображений из вкладок и многое другое.

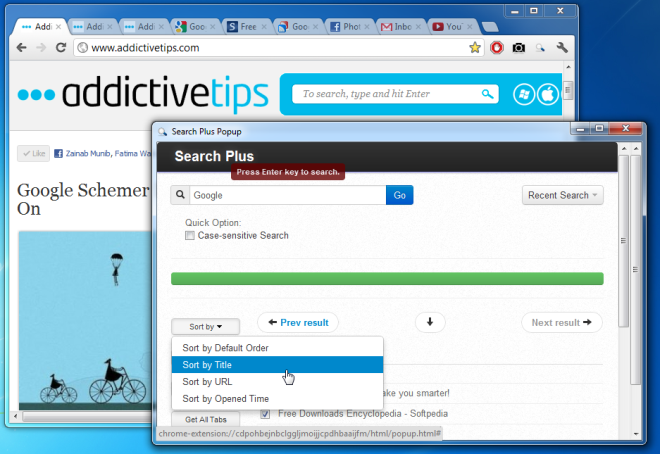

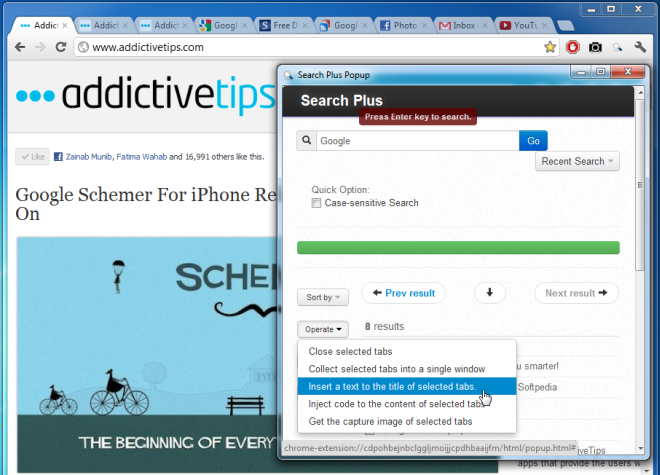

После установки расширения все, что вам нужно сделать, это нажать кнопку на панели инструментов и ввести ключевое слово во всплывающем окне. Этот изящный маленький инструмент затем отобразит список совпадающих заголовков вкладок в новом всплывающем окне вместе с Сортировать по, работать, выбирать а также Получить все вкладки параметры. Кроме того, ключевые слова, которые вы ищете, сохраняются в Недавний поиск выпадающее меню.

Все подходящие результаты поиска будут отображены в списке. Каждый элемент в списке снабжен флажком, который можно щелкнуть, чтобы выбрать вкладки. Выбрав набор вкладок, вы сможете отсортировать их по Порядок по умолчанию, заголовок, URL а также Открытое время. Вы также сможете получить доступ ко всем вашим предыдущим условиям поиска, нажав на Недавний поиск вариант.

В Работать раскрывающееся меню позволяет Закрыть выбранные вкладки, собрать выбранные вкладки в одном окне, вставить текст в заголовок выбранных вкладок и т. д., тогда как Выбирать опция позволяет вам Выбрать все вкладки, отменить выбор всех вкладок и более.

Search Plus предоставляет возможности быстрого поиска, позволяя эффективно управлять всеми открытыми вкладками. С его помощью вы можете быстро искать вкладки по ключевым словам и применять к ним различные полезные операции. Если вы обнаружите, что работаете со слишком большим количеством вкладок, вам обязательно стоит попробовать это расширение.

Установите Search Plus для Google Chrome

Если вам понравилось это расширение, вы также можете взглянуть на нашу демонстрацию расширений Chrome.

Сообщение Вкладки поиска по ключевым словам, сортировка по заголовку / URL / времени [Chrome] появились сначала на My Road.

Обмен изображениями в режиме реального времени с возможностью перетаскивания и оповещений на рабочем столе

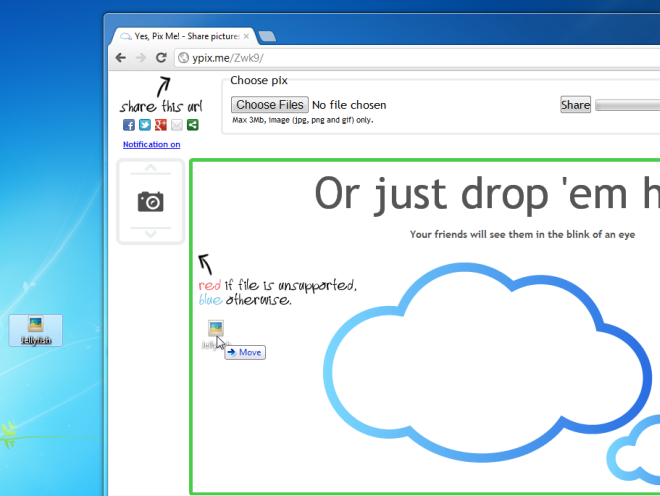

Любите отправлять фотографии своим друзьям и близким, но ненавидите отправлять их по электронной почте или загружать их в различные облачные сервисы? Если это так, то вам действительно нужно попробовать Да, Pix Me! Этот простой, но полезный инструмент для совместной работы позволяет мгновенно обмениваться изображениями с помощью функции перетаскивания. Услуга не требует какой-либо установки или регистрации; все, что вам нужно сделать, это перетащить изображение из вашего локального хранилища, чтобы сгенерировать для него уникальный URL-адрес, которым вы затем можете поделиться с любым количеством людей. Любой, у кого есть ссылка, увидит изображения или скриншоты, всплывающие на своих экранах, как только вы перетащите их на веб-сайт, и они могут сделать то же самое – загрузить свои собственные изображения, чтобы вы могли их увидеть. Больше мимо прыжка.

Чтобы начать совместное использование, щелкните значок Выбрать файлы в верхнем левом углу страницы или просто перетащите изображение в поле в центре страницы.

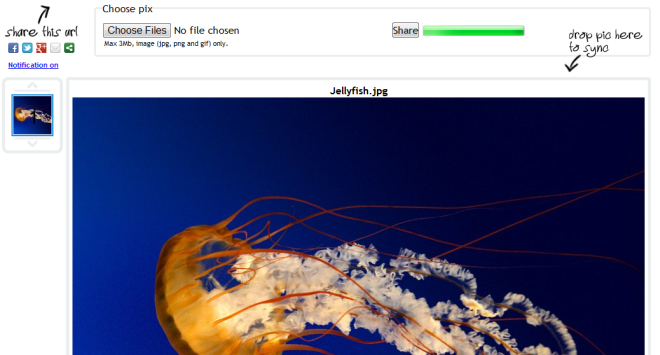

Затем нажмите кнопку Делиться кнопку, чтобы получить уникальный URL-адрес для совместного использования. На данный момент приложение поддерживает совместное использование изображений в форматах JPG, PNG и GIF и имеет ограничение на размер файла не более 3 МБ. Вы также можете включить или отключить уведомления в левой части страницы.

Обратите внимание, что, хотя приложение оптимально работает как в Google Chrome, так и в Firefox, уведомления поддерживаются только в Chrome. Да, Pix Me! не только предоставляет вам очень удобный и удобный механизм обмена изображениями, но также позволяет работать в любом количестве сеансов, так как вы всегда можете обновить веб-сайт, чтобы сгенерировать новый URL-адрес, инициируя новый сеанс.

Если вам понравилось это приложение, вы можете также просмотреть другие веб-приложения, которые мы рассмотрели до сих пор.

Сообщение Обмен изображениями в режиме реального времени с возможностью перетаскивания и оповещений на рабочем столе появились сначала на My Road.

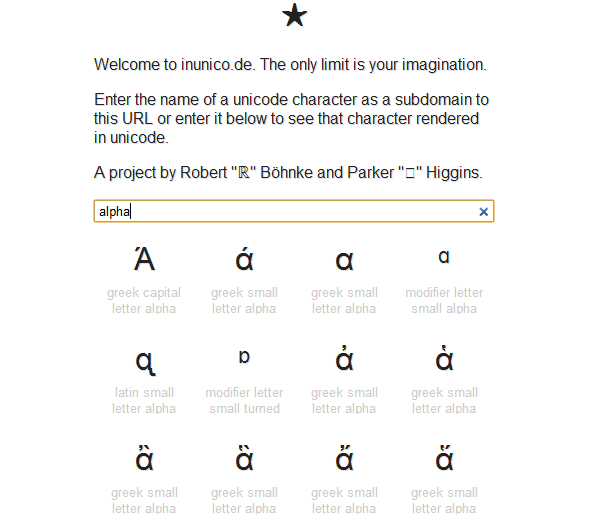

Inunico.de – это поисковая система в реальном времени для символов Юникода

Интернет завален символами Unicode, и иногда, даже зная имя символа, мы склонны забывать его точную форму, символ и детали. Это где Inunico.de, веб-приложение, может пригодиться. Приложение позволяет просматривать различные символы Unicode, просто вводя имя символа, после чего отображаются совпадающие символы Unicode из своей базы данных.Inunico.de имеет аккуратный минималистичный интерфейс, что делает его исключительно простым в использовании. Все, что вам нужно сделать, это просто ввести имя символа Unicode и нажать Enter. Будет отображена таблица результатов со всеми возможными совпадениями. Каждый символ имеет имя, прописные и строчные буквы. Если вы знаете точное имя своего символа Юникода, вы даже можете использовать его имя в качестве поддомена службы, чтобы перейти непосредственно к этой букве.

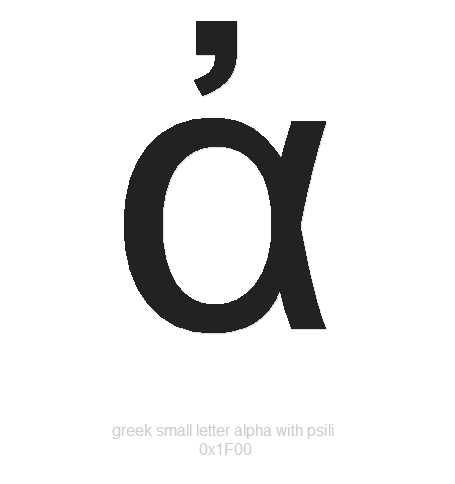

Вы можете щелкнуть любой символ, чтобы просмотреть его в большем размере или скопировать в буфер обмена.

Веб-приложение предназначено для быстрой справки, если вы смутно помните, как называется персонаж, но не можете его нарисовать. Есть некоторые веб-приложения, такие как Shapecatcher, которые просят вас рисовать фигуры, а затем идентифицируют их из тех, что находятся в его базе данных. Он фокусируется на форме персонажа, тогда как inunico.de использует имя персонажа, чтобы помочь его идентифицировать. Поиск символов, который он выполняет, уточняется, поскольку вы продолжаете вводить текст, это поможет вам найти нужный, даже если вы помните, как «звучало» имя.

Inunico.de – удобная утилита, которая позволяет быстро искать и искать символы Юникода со всеми их вариациями. Его можно использовать для идентификации определенного персонажа и понимания различных похожих. Если вам часто нужно искать символы, то вам обязательно стоит добавить его в свой список закладок.

Если вам понравилось это расширение, вы также можете взглянуть на другие расширения Chrome, которые мы уже рассмотрели.

Сообщение Inunico.de – это поисковая система в реальном времени для символов Юникода появились сначала на My Road.

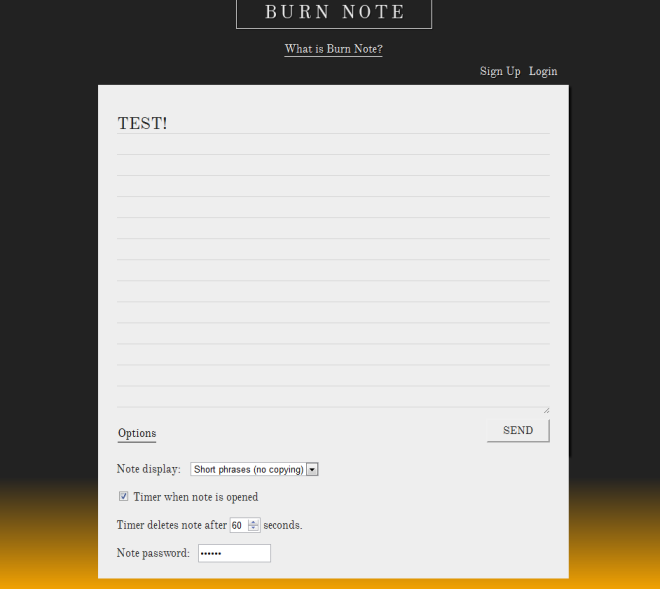

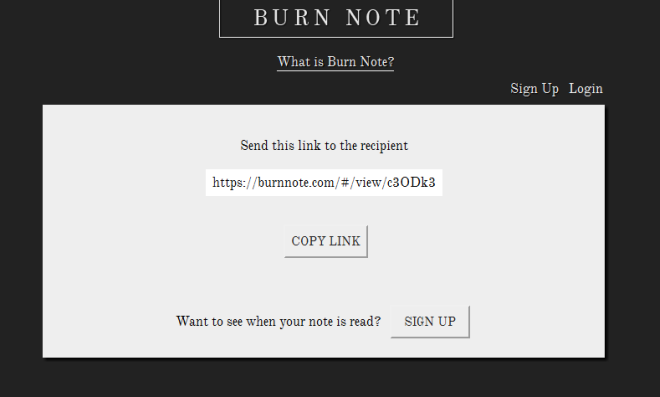

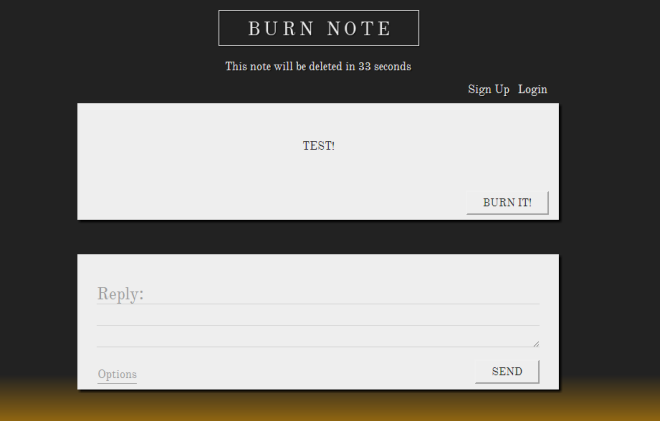

Отправляйте личные сообщения, которые автоматически удаляются по истечении установленного времени

Не так давно мы рассмотрели DUE.IM, службу текстовых сообщений, которая позволяла отправлять одноразовые читаемые личные сообщения другим пользователям. BurnNote – аналогичное веб-приложение, которое предлагает те же функции, но с дополнительными опциями. Служба позволяет отправлять личные сообщения другим пользователям, которые можно просмотреть только один раз, и которые удаляются по прошествии определенного времени. Удаленные записи записи полностью стираются с серверов BurnNote, поэтому никто не может их восстановить. Все, что вам нужно сделать, это ввести свое сообщение (пароль, номер, ссылку, заметку и т. Д.), И служба мгновенно сгенерирует частный URL-адрес, которым вы можете поделиться со своими друзьями. Как только сообщение будет прочитано получателем, BurnNote автоматически «сожжет» его, гарантируя, что оно останется конфиденциальным. Вот как все просто!

Для начала введите свое личное сообщение, установите таймер, введите пароль (необязательно) и нажмите послать кнопка. «Тип» заметки можно определить в раскрывающемся меню, которое включает Обычный текст (копирование ОК), короткие фразы (без копирования) а также Подзорная труба (без копирования).

BurnNote мгновенно сгенерирует уникальный URL-адрес, который вы можете скопировать в буфер обмена, щелкнув значок Копировать ссылку кнопка.

Когда получатель получит сообщение, таймер будет отображаться вверху страницы. По истечении времени сообщение будет автоматически удалено с сервера. Обратите внимание, что при повторном щелчке по URL-адресу ‘Здесь нет записки’ отображается сообщение.

Сервис не требует регистрации или входа в систему и имеет простой интерфейс, позволяющий быстро отправлять личные сообщения. Если вы хотите делиться секретными сообщениями с друзьями, и конфиденциальность является проблемой, то BurnNote может стать для вас удобным инструментом.

Если вам понравилось это приложение, вы можете также просмотреть другие веб-приложения, которые мы рассмотрели до сих пор.

Сообщение Отправляйте личные сообщения, которые автоматически удаляются по истечении установленного времени появились сначала на My Road.