В статье разбираем утилиты df, du и ncdu, которые покажут занятое место на диске и помогут выяснить кто занимает на диске больше всего места. Читать

Архив рубрики: Публикации

Где в BIOS можно включить поддержку виртуализации?

Благодаря технологии виртуализации вы можете загружать несколько операционных систем на свое устройство Windows без каких-либо сторонних приложений или инструментов. Это поможет вам получить доступ к большей библиотеке приложений для использования.

Получить доступ и включить его очень просто в настройках BIOS вашего устройства. После того, как вы включили его, все, что вам нужно сделать, это включить «Hyper-V» с помощью функций Windows, чтобы установить другую операционную систему на ваше устройство. Легко, верно? Давайте идти.

Войдите в настройки UEFI из приложения «Настройки».

Есть несколько способов получить доступ к настройкам BIOS на вашем компьютере. Однако удобнее всего через приложение «Настройки».

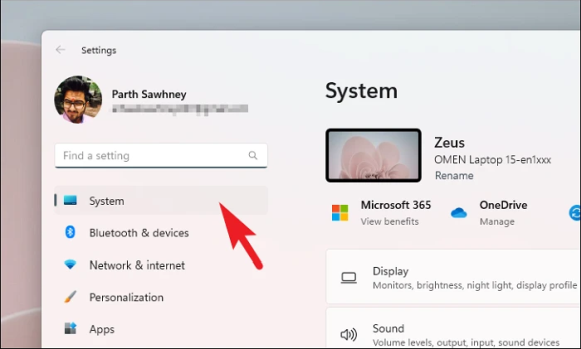

Сначала перейдите в меню «Пуск» и щелкните плитку приложения «Настройки». Либо нажмите вместе клавиши Windows+ Iна клавиатуре, чтобы открыть приложение.

После этого убедитесь, что вы выбрали вкладку «Система» на левой боковой панели.

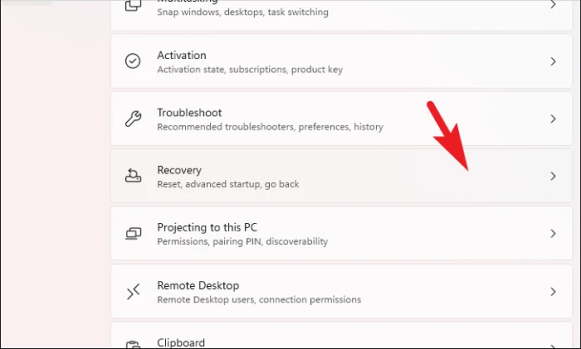

Затем нажмите «Восстановление» в правой части окна.

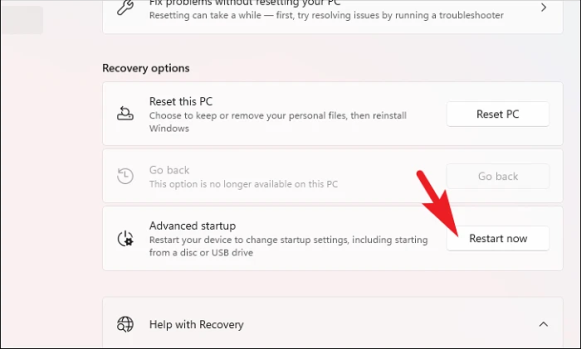

После этого нажмите кнопку «Перезагрузить сейчас», чтобы продолжить. Это выведет подсказку на ваш экран.

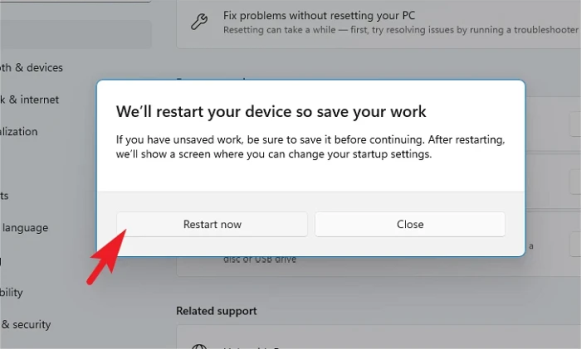

Затем нажмите кнопку «Перезагрузить сейчас», чтобы немедленно перезагрузить компьютер.

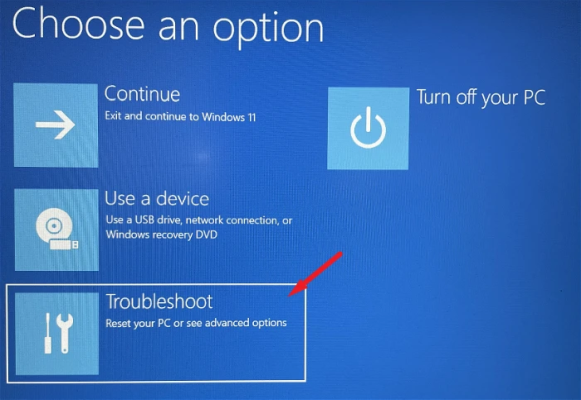

После перезагрузки компьютера нажмите плитку «Устранение неполадок».

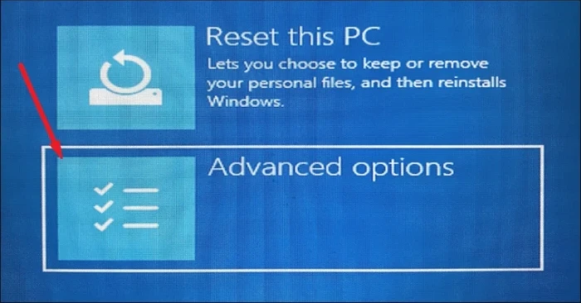

После этого нажмите на плитку «Дополнительные параметры», чтобы продолжить.

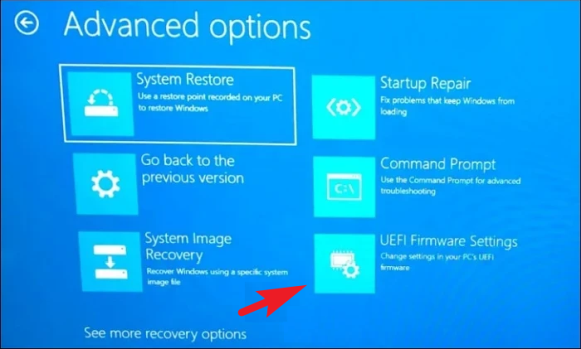

Затем нажмите плитку «Настройки встроенного ПО UEFI», чтобы продолжить. Ваш компьютер может снова перезагрузиться.

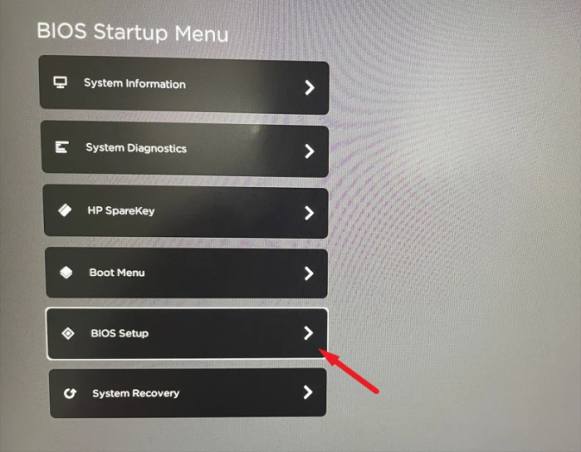

Затем в меню настройки BIOS с помощью клавиш со стрелками выделите плитку «Настройка BIOS» и нажмите пробел/Ввод, чтобы продолжить.

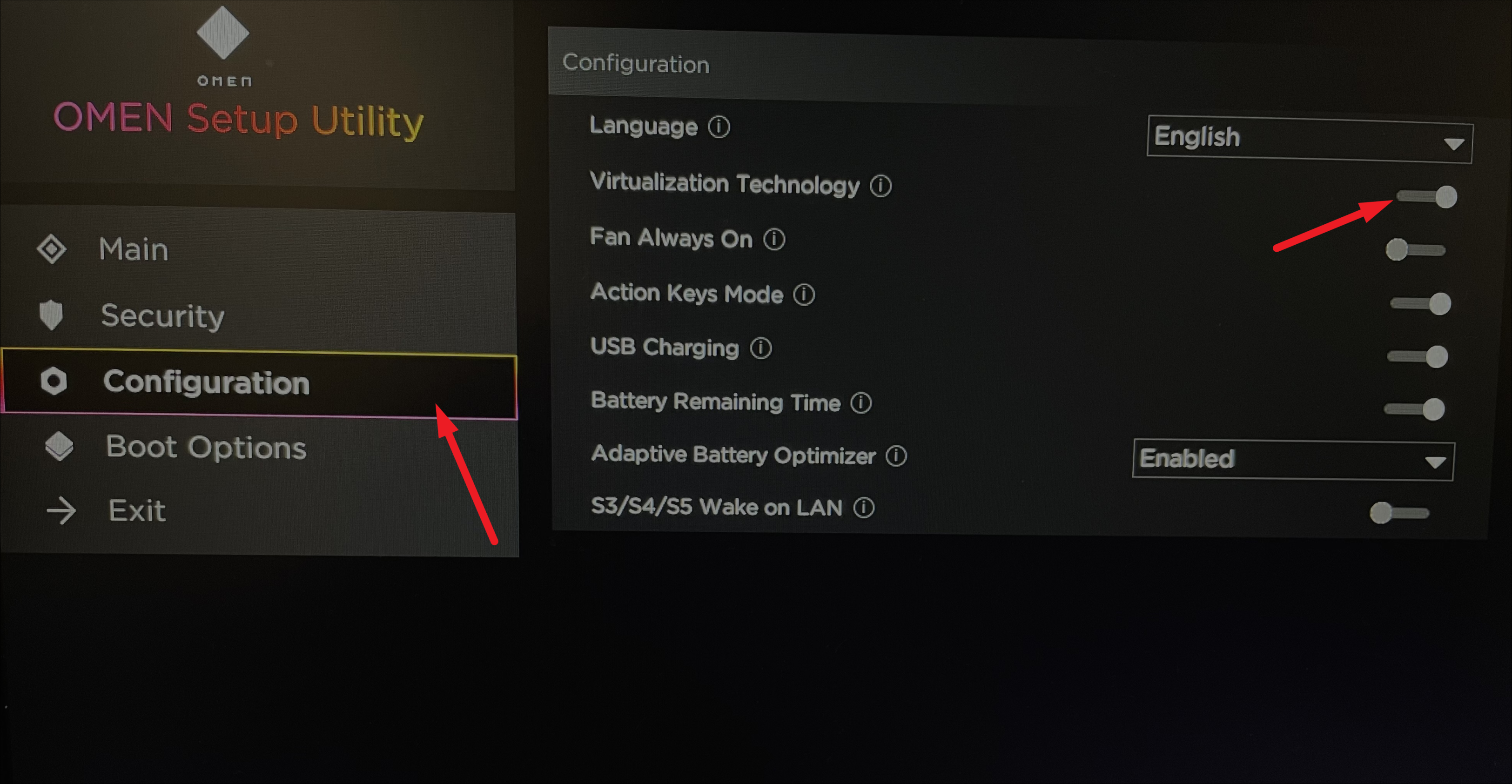

После этого нажмите на вкладку «Конфигурация» на левой боковой панели. Затем установите флажок перед опцией «Технология виртуализации».

Наконец, нажмите кнопку «Сохранить» или нажмите F10клавишу на клавиатуре, чтобы сохранить и закрыть экран.

Включите Hyper-V и платформу виртуальных машин из панели управления

После того, как вы включили виртуализацию из BIOS на своем устройстве, вам необходимо включить функцию «Hyper-V» на вашем устройстве, если вы собираетесь загружать на свое устройство отдельную операционную систему.

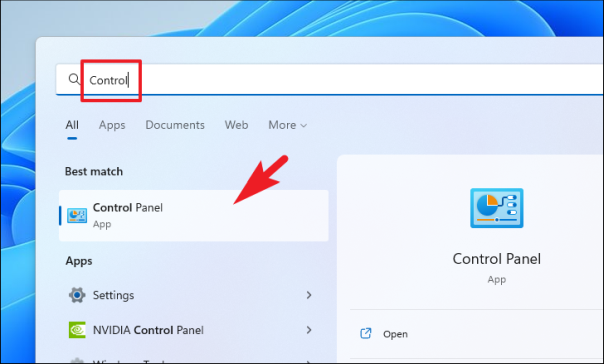

Сначала перейдите в меню «Пуск» и введите Controlпоиск. После этого щелкните плитку «Панель управления», чтобы открыть ее.

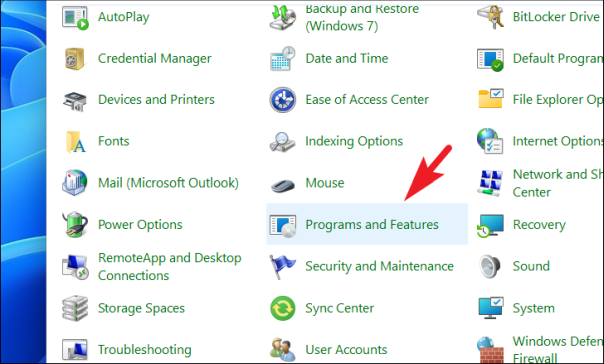

Затем нажмите на опцию «Программы и компоненты» в сетке.

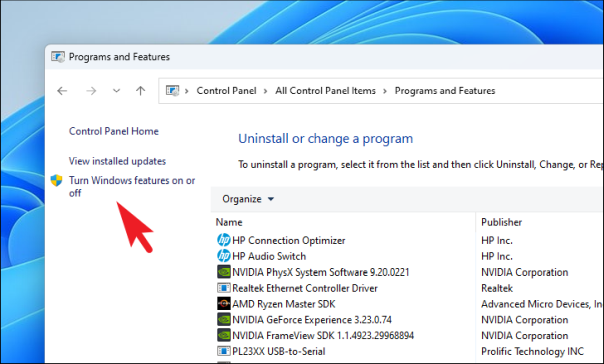

Затем нажмите «Включить или отключить функции Windows», чтобы продолжить. Это откроет отдельное окно на вашем экране.

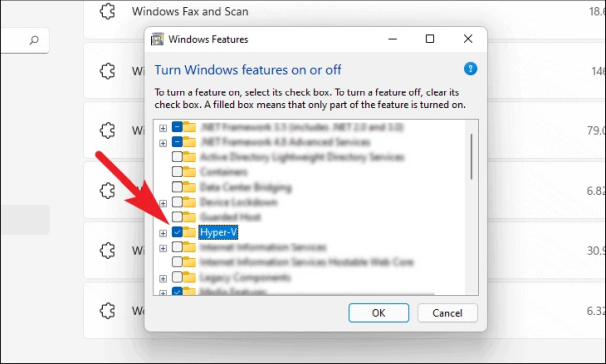

Затем найдите и установите флажок перед опцией «Hyper-V».

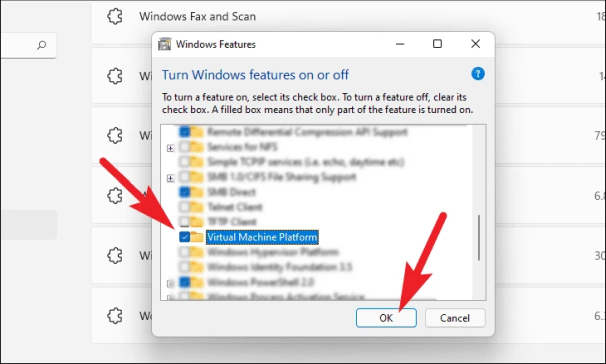

После этого установите флажок перед опцией «Платформа виртуальной машины». Затем нажмите кнопку «ОК», чтобы продолжить.

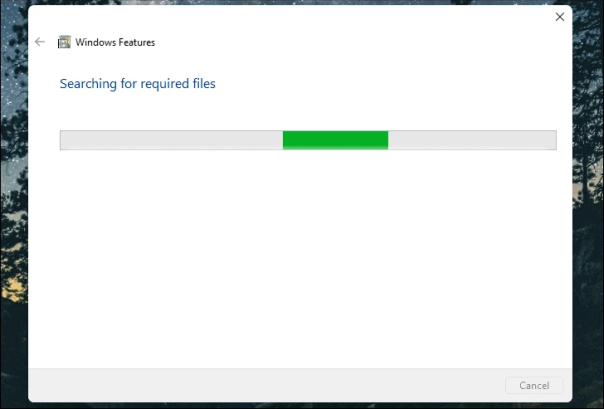

Затем Windows применит настройки к вашему ПК.

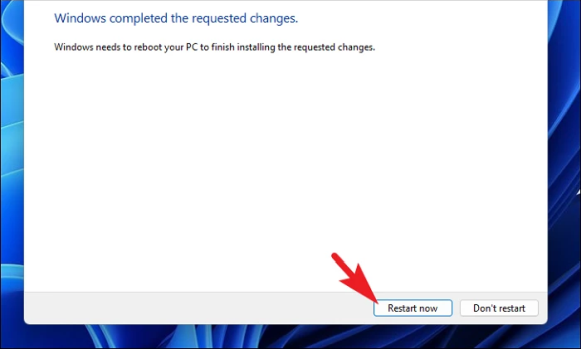

После завершения процесса нажмите кнопку «Перезагрузить сейчас», чтобы применить изменения.

Ну вот, люди. Используя вышеупомянутые простые шаги, вы можете легко включить виртуализацию на своем ПК с Windows 11.

Kata Containers 3.0 включает поддержку GPU, Linux 5.19.2, QEMU 6.2.0 и многое другое.

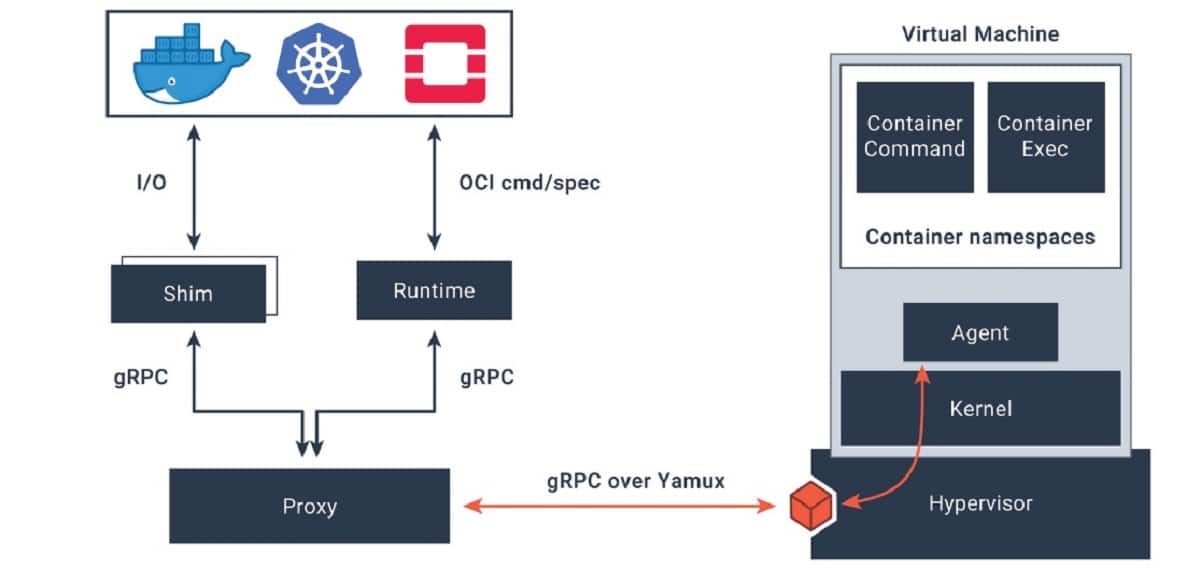

Kata Containers обеспечивает безопасную среду выполнения контейнеров с облегченными виртуальными машинами.

После двух лет разработки опубликован релиз проекта Kata Containers 3.0, что развивается стек для организации запущенных контейнеров использование изоляции на основе полных механизмов виртуализации.

В основе Kata лежит среда выполнения, которая предоставляет возможность создавать компактные виртуальные машины, работающие с использованием полноценного гипервизора, а не с использованием традиционных контейнеров, использующих общее ядро Linux и изолированных с помощью пространств имен и контрольных групп.

Утилита ss

В статье разбирается утилита ss, которая предназначена для получения информации о сетевых подключениях к серверу или от него.

Новая версия PostgreSQL 15 поставляется с улучшениями, предназначенными для повышения производительности и управления данными.

PostgreSQL — это система управления объектно-ориентированными реляционными базами данных с открытым исходным кодом.

После года разработки анонсирован выход новой стабильной ветки СУБД PostgreSQL 15, Этот выпуск включает в себя ряд улучшений, в том числе новые возможности сжатия, которые помогают в хранении и резервном копировании данных, улучшения сортировки данных для более быстрого поиска, а также новые возможности ведения журналов и SQL.

В этой новой версии, которая представлена, выделена команда SQL «MERGE», что позволяет создавать условные операторы SQL которые объединяют операции INSERT, UPDATE и DELETE в одном операторе. Например, MERGE можно использовать для объединения двух таблиц путем вставки отсутствующих записей и обновления существующих.

VirtualBox 7.0 поставляется с полным шифрованием для виртуальных машин, удаленным управлением для облачных виртуальных машин и многим другим.

Это программное обеспечение, которое позволяет создавать и запускать виртуальные машины в Windows, macOS и Linux.

Несколько дней назад Oracle объявила о выпуске новой версии VirtualBox 7.0, бесплатное программное обеспечение для виртуализации x86 и AMD64/Intel64 для серверов, настольных компьютеров и встроенных приложений, а также из его самых интересных новостей полная совместимость с эл.l Шифрование ВМ, новое ускорение Direct3D, Безопасная загрузка и TPM 1.2 и 2.0, упрощающие установку Windows 11 без взлома реестра.

Для тех, кто не знает о VirtualBox, им следует знать, что это это бесплатное программное обеспечение, а также его дополнительные дополнения для гостей, которые позволяют интегрировать хост/гость. Многие дистрибутивы Linux включают свои собственные версии гостевых дополнений, но если вы устанавливаете их из VirtualBox, версия 7 предварительно поддерживает их автоматическое обновление для гостей.