Термин «ОЗУ» — это сокращенная форма «оперативного запоминающего устройства». Он хранит запущенные в данный момент приложения и процессы и удаляет их при выключении компьютера. Чем больше у вас свободного места в оперативной памяти, тем больше программ вы сможете запускать в Windows без замедления работы. Когда программы используют все пространство оперативной памяти, используется жесткий диск. В таком случае вы должны освободить место в оперативной памяти, чтобы система могла нормально функционировать.

В этой статье вы найдете десять советов по освобождению оперативной памяти в Windows 10 для ускорения работы системы.

Вот десять советов, как освободить оперативную память в Windows 10:

- Перезагрузите Windows 10

- Отключить автозагрузку приложений

- Сканировать на наличие вредоносных программ

- Настройте виртуальную память

- Уменьшить визуальные эффекты

- Остановить фоновые приложения

- Отключить SysMain в сервисном меню

- Закройте неиспользуемые вкладки, открытые в вашем браузере

- Дефрагментируйте жесткий диск

- Очистка диска.

Давайте проверим каждый метод один за другим!

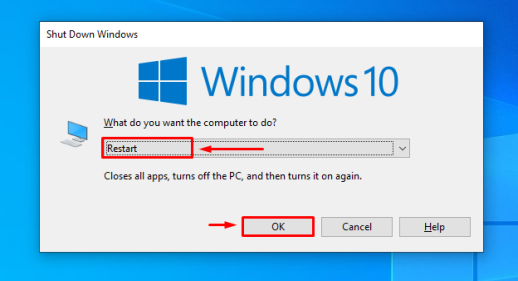

Совет 1. Перезагрузите Windows 10

Перезапуск Windows 10 закроет все приложения, использующие вашу оперативную память, работающие в фоновом режиме. Оперативная память — это энергозависимая память (в ней теряются сохраненные данные при выключении ПК), поэтому при перезагрузке ПК она закрывает все программы и процессы, использующие оперативную память, и освобождает выделенное пространство.

Чтобы перезапустить Windows 10, нажмите клавиши «Alt+F4». В результате появится всплывающее окно «Завершение работы Windows», где вам нужно выбрать «Перезагрузить» и нажать кнопку «ОК»:

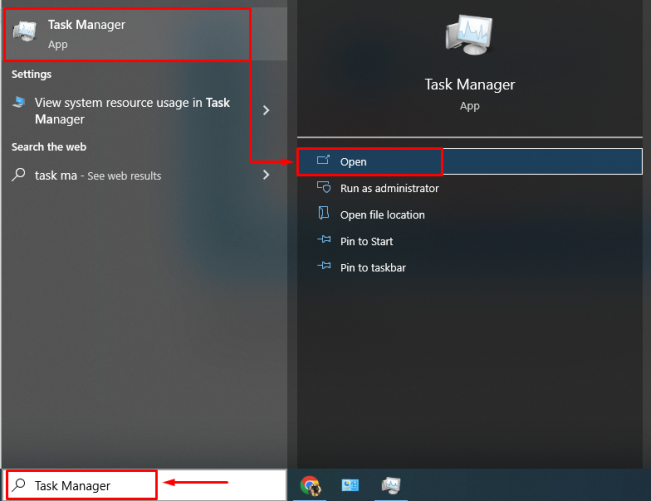

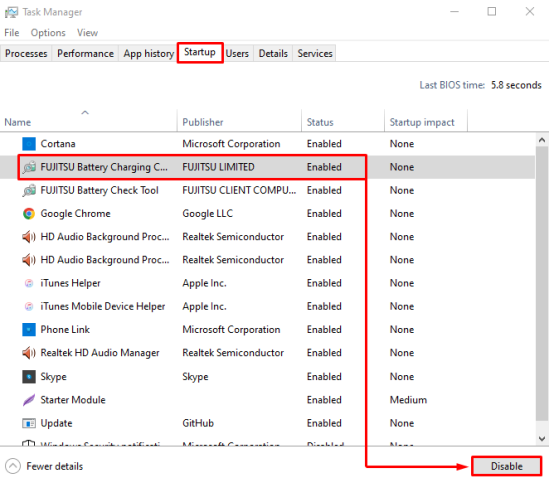

Совет 2. Отключите автозагрузку приложений

Запускаемые программы — это те программы, которые начинают работать при каждом перезапуске Windows 10. В результате эти программы увеличивают использование ОЗУ и ЦП и замедляют работу системы. Однако отключение запускаемых программ не только ускорит работу Windows 10, но и освободит оперативную память.

Для этого запустите «Диспетчер задач» из меню «Пуск», как показано ниже:

Перейдите на вкладку «Автозагрузка», выберите любую программу, которую хотите отключить, а затем нажмите кнопку «Отключить», которая находится внизу справа:

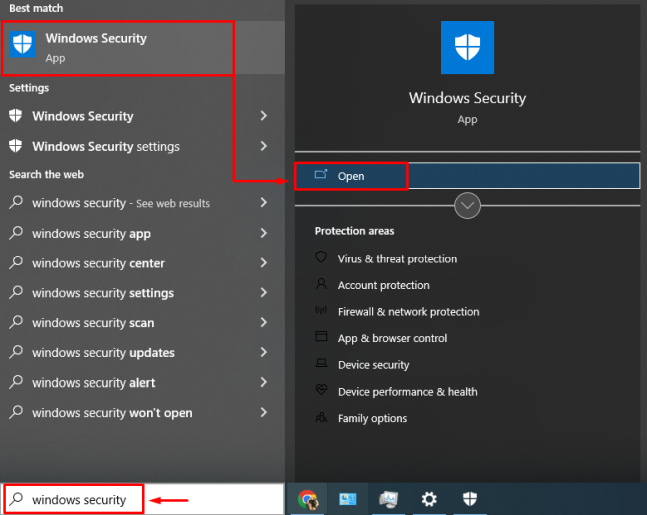

Совет 3. Сканируйте на наличие вредоносных программ

Если ваш компьютер замедляется и зависает в определенное время, это происходит из-за вредоносных программ внутри вашей системы, которые могут украсть данные. Не ждите больше и немедленно сканируйте на наличие вредоносных программ. Эта операция защитит ваши данные и освободит оперативную память.

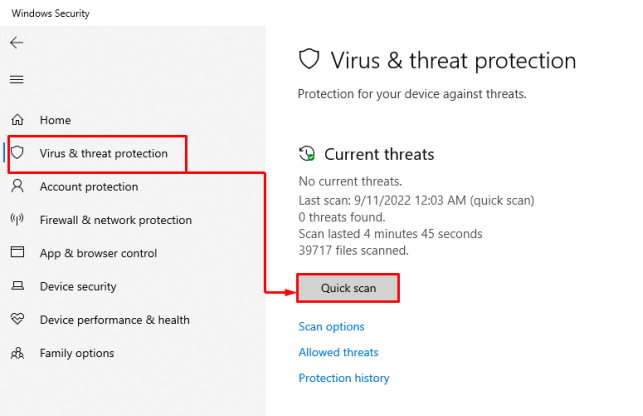

Запустите «Безопасность Windows» из «Меню Пуск»:

В окне «Безопасность Windows» перейдите на вкладку «Защита от вирусов и угроз» и нажмите «Быстрое сканирование», чтобы начать сканирование:

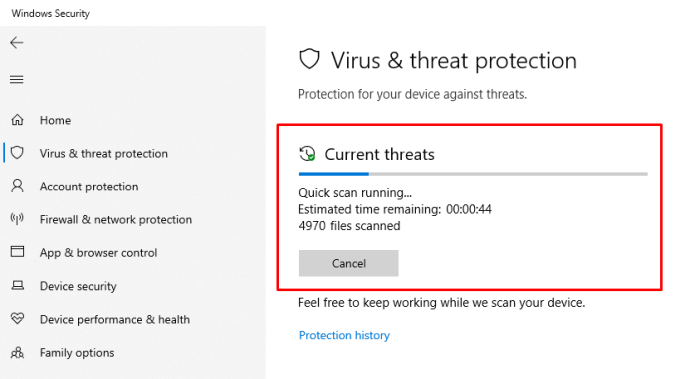

Как видите, сканирование запущено, и оно удалит вредоносное ПО, а также освободит оперативную память:

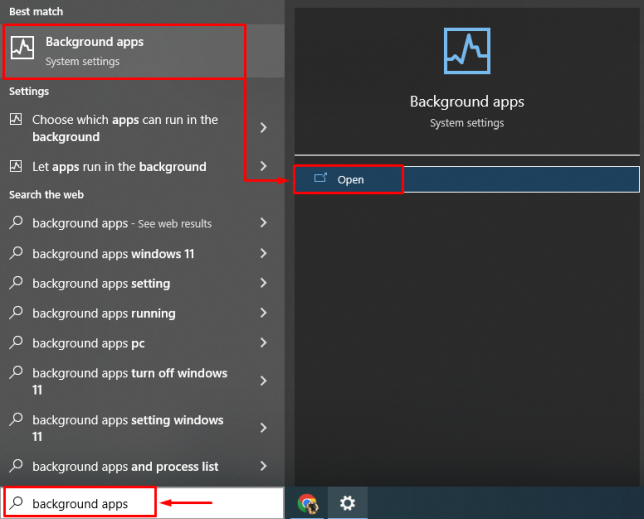

Совет 4. Настройте виртуальную память

Если вы чувствуете, что ОЗУ занимает больше места и не осталось места для запуска других программ, вы можете попробовать создать виртуальную память, превратив доступное пространство на жестком диске в виртуальную память.

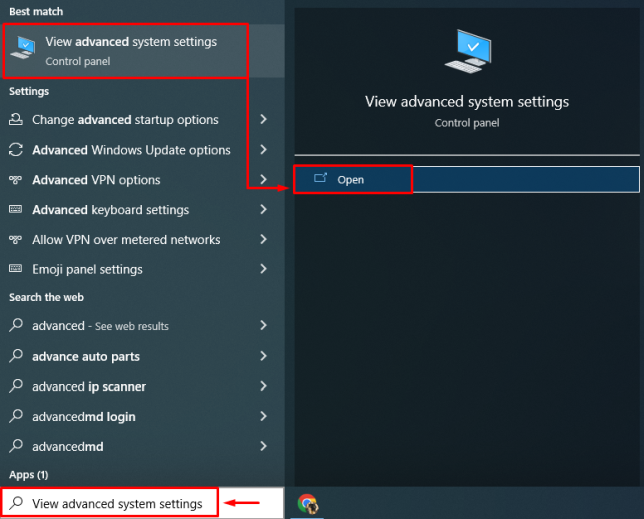

Из «Меню Пуск» запустите «Просмотр дополнительных параметров системы»:

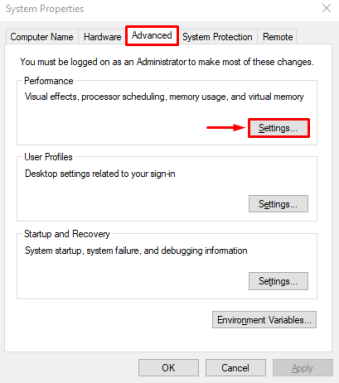

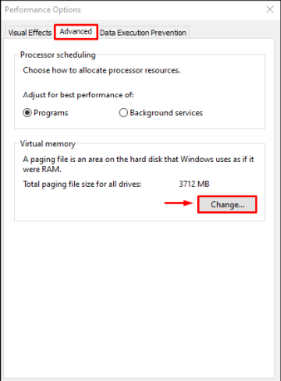

Перейдите на вкладку «Дополнительно» и нажмите «Настройки»:

Перейдите на вкладку «Дополнительно» и нажмите на кнопку «Изменить»:

Прежде всего, снимите флажок «Автоматически управлять размером файла подкачки для всех дисков», выберите «Диск C», установите переключатель «Пользовательский размер» и введите желаемый объем памяти в данные поля ввода и нажмите «ОК». » кнопка:

Это создаст виртуальную память для увеличения объема оперативной памяти.

Совет 5. Уменьшите количество визуальных эффектов

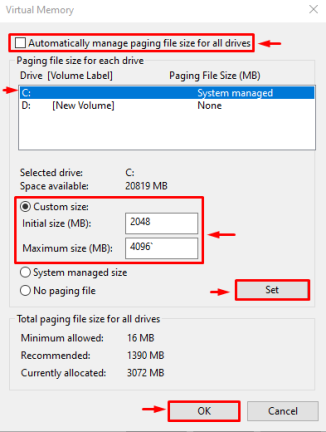

Уменьшение визуальных эффектов в Windows 10 освободит оперативную память, что напрямую повысит производительность системы.

Хотите использовать этот совет? Во-первых, в меню «Пуск» откройте «Просмотр дополнительных параметров системы». Затем в окне «Параметры производительности» перейдите на вкладку «Визуальные эффекты», установите переключатель «Настроить для лучшей производительности» и нажмите «ОК», чтобы сохранить изменения:

Это уменьшит визуальные эффекты и использование оперативной памяти.

Совет 6. Остановите фоновые приложения

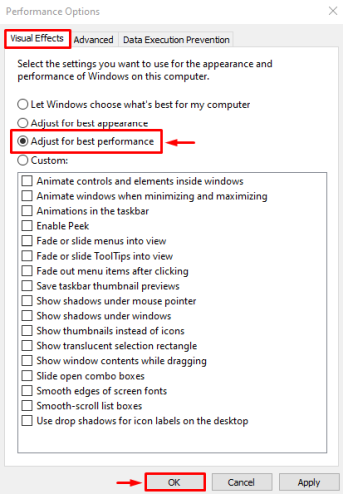

Фоновые приложения могут быть основным фактором высокого использования оперативной памяти, батареи и ЦП.

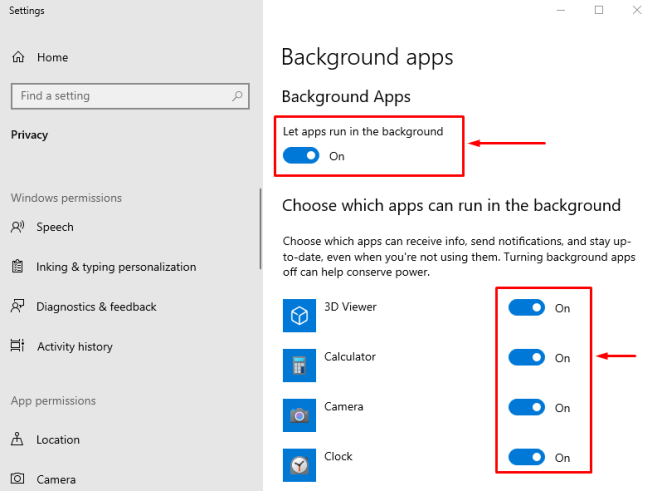

Чтобы остановить приложения, работающие в фоновом режиме, запустите параметр «Фоновые приложения» в меню «Пуск»:

Вы можете закрыть все приложения, отключив переключатели приложений в разделе «Выберите, какие приложения могут работать в фоновом режиме»:

Это закроет фоновые приложения, работающие в фоновом режиме, чтобы освободить оперативную память.

Совет 7. Отключите SysMain в сервисном меню

SysMain (ранее известная как SuperFetch) предварительно загружает наиболее часто используемые приложения или процессы в Windows 10 для лучшего взаимодействия с пользователем. Это также вызывает высокую загрузку ЦП и ОЗУ из-за его функции предварительной загрузки приложений. В частности, вы можете отключить SysMain, чтобы освободить оперативную память вашей системы.

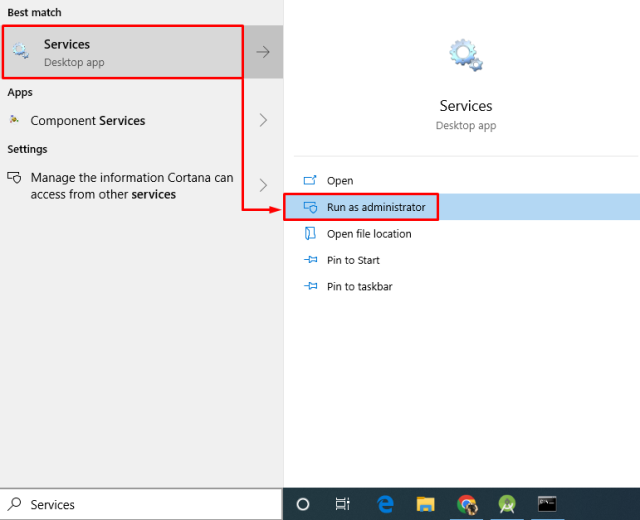

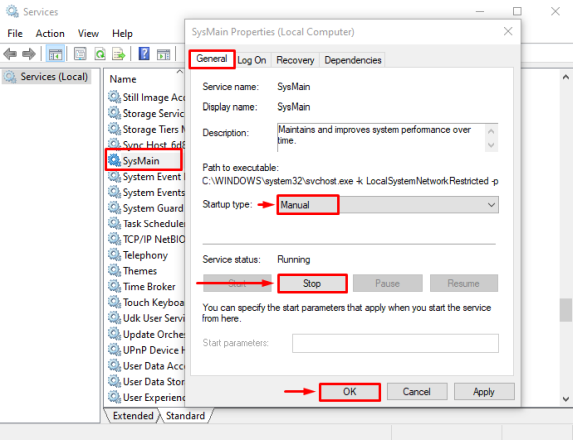

Чтобы отключить SysMain, запустите «Службы» из меню «Пуск»:

Найдите «SysMain», откройте его свойства и перейдите на вкладку «Общие». Затем установите «Тип запуска» на «Вручную» и нажмите «Стоп», чтобы остановить запущенную службу. Наконец, нажмите кнопку «ОК», чтобы отключить SysMain и сохранить изменения:

Эта операция отключит SysMain, чтобы освободить место в оперативной памяти.

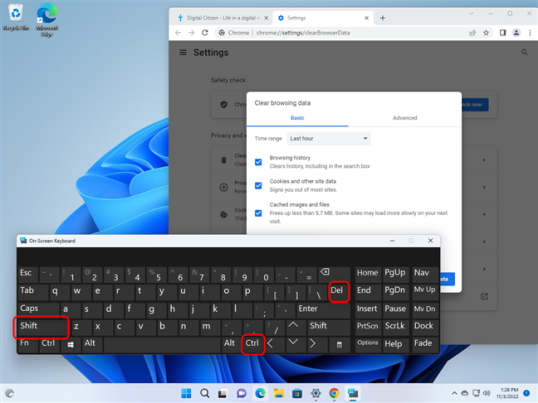

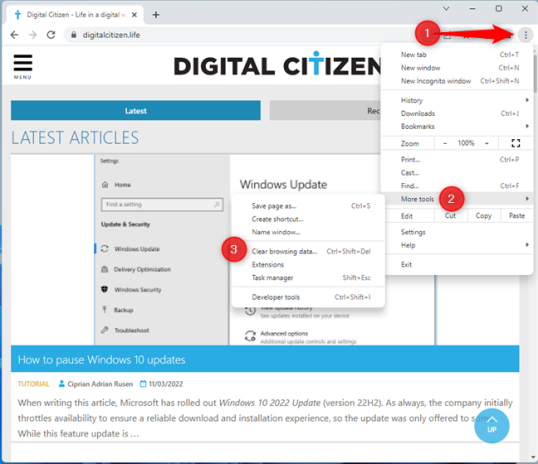

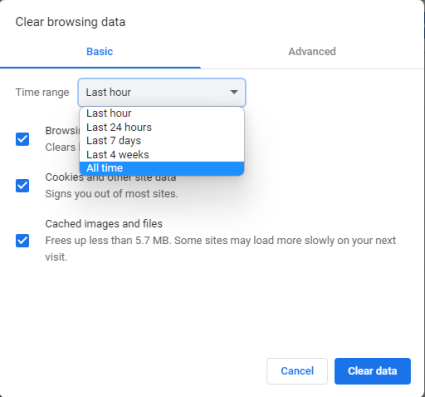

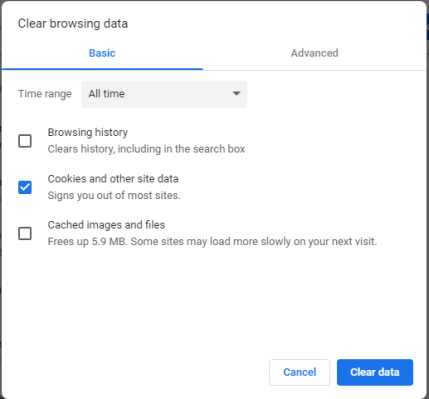

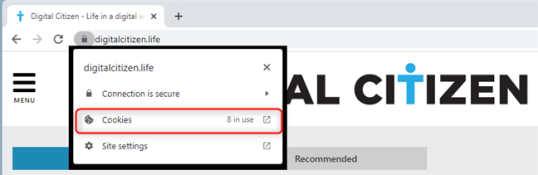

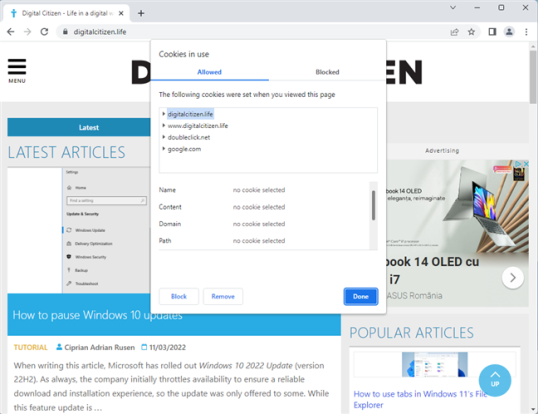

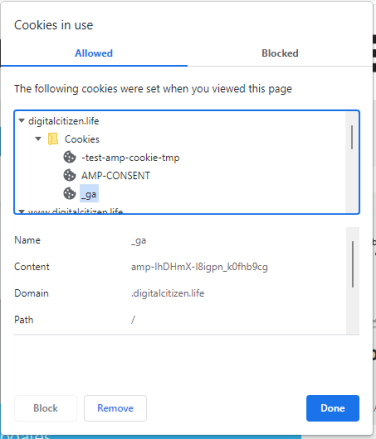

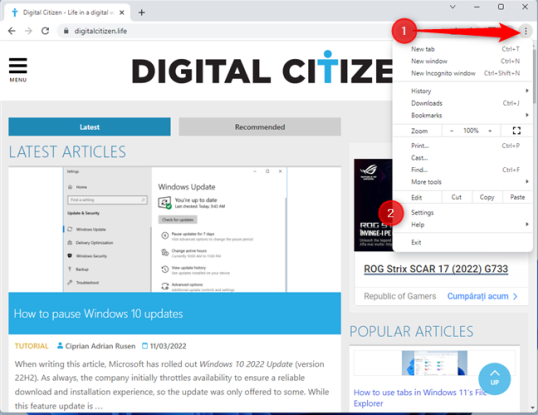

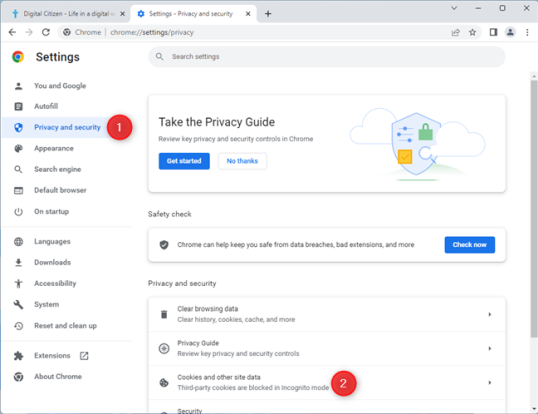

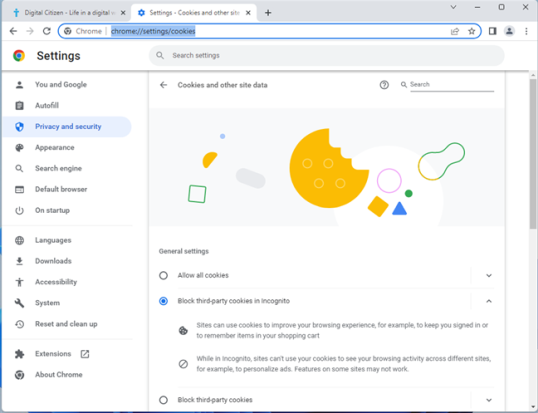

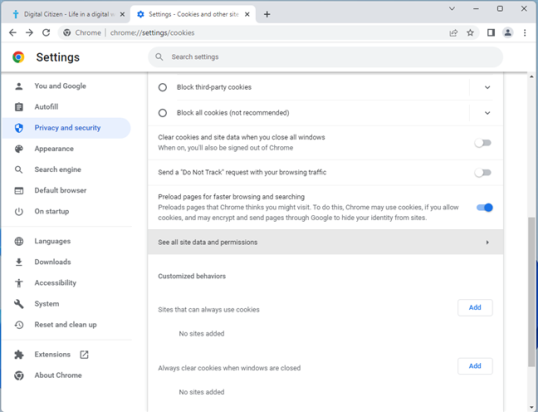

Совет 8. Закройте неиспользуемые вкладки, открытые в вашем браузере

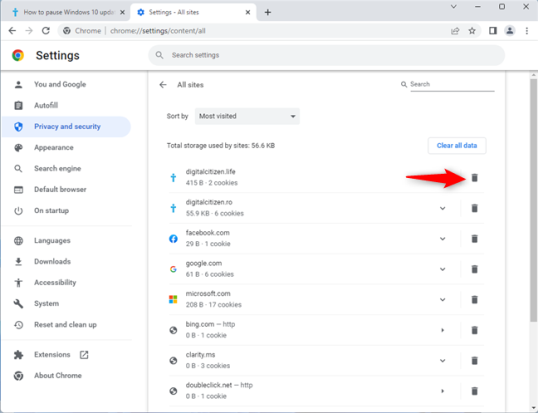

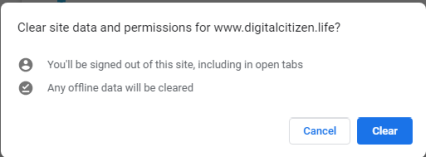

Вы могли заметить, когда используете любой интернет-браузер Windows 10; ОЗУ начинает заполняться. Это потому, что всякий раз, когда вы открываете вкладку, она создает новый процесс в оперативной памяти. Чем больше вы открываете новых вкладок, тем больше процессов будет создано в оперативной памяти. Технические пользователи обычно высмеивают браузер Chrome за использование почти всей оперативной памяти в Windows 10.

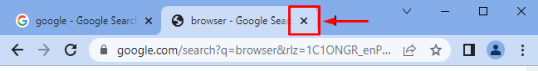

Однако вы можете закрыть вкладки в браузере, просто нажав на крестик:

Совет 9. Дефрагментируйте жесткий диск

Всякий раз, когда вы сохраняете новые файлы в Windows, система создает для них определенную часть на жестком диске. Частое сохранение или удаление файлов на жестком диске приведет к фрагментации диска, а это означает, что на жестком диске образовались пробелы, и ни один конкретный файл не может его заполнить.

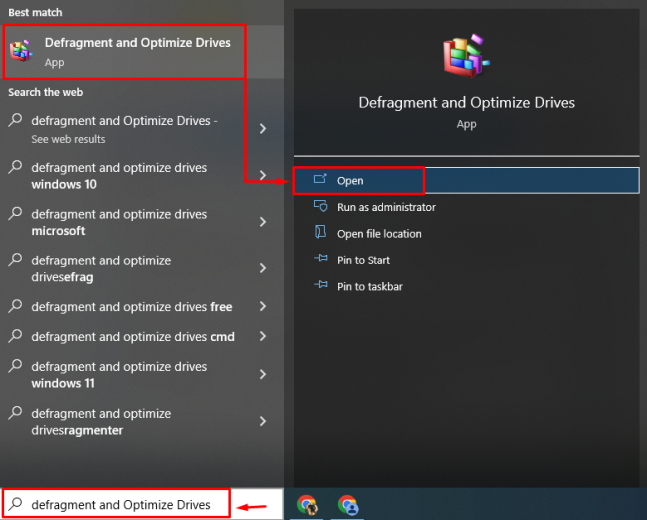

Чтобы удалить эти созданные пробелы, необходимо выполнить дефрагментацию диска. Для этого запустите «Дефрагментация и оптимизация дисков» из меню «Пуск»:

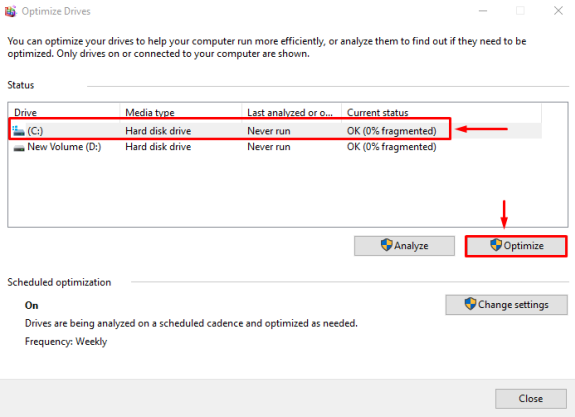

Теперь выберите диск и нажмите «Оптимизировать», чтобы начать процесс.

Примечание. Диски на нашем ПК фрагментированы, поэтому вместо «Дефрагментация диска» отображается опция «Оптимизировать». Поэтому тщательно запускайте процесс дефрагментации:

Совет 10. Очистка диска

Очистка диска — это очень полезный инструмент Windows 10, используемый для удаления временных файлов и папок, которые занимают место на диске и ОЗУ.

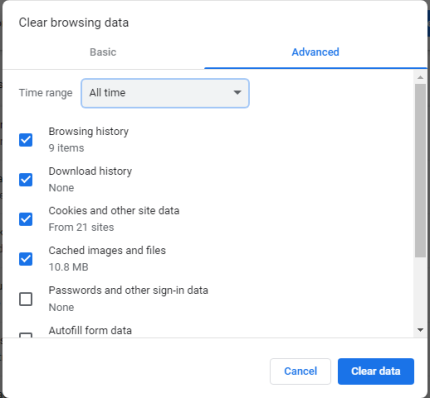

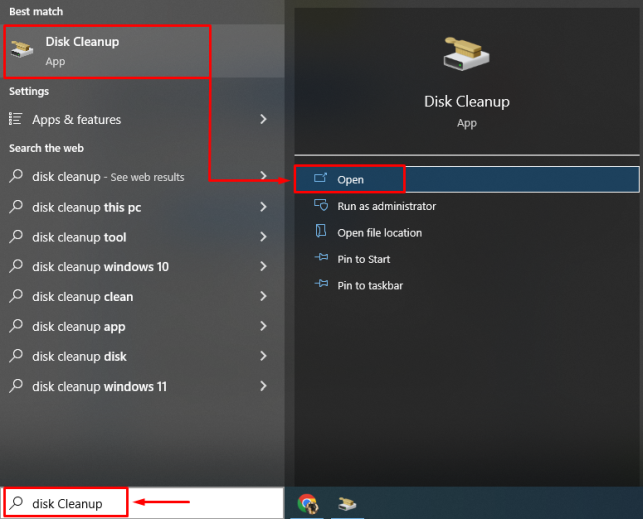

Запустите «Очистка диска» с помощью меню «Автозагрузка»:

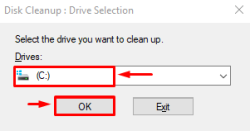

Выберите диск и нажмите кнопку «ОК»:

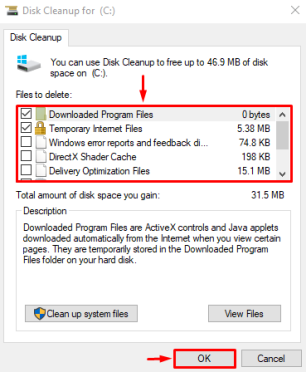

Выберите файлы, установив галочки в разделе «Файлы для удаления», и нажмите кнопку «ОК»:

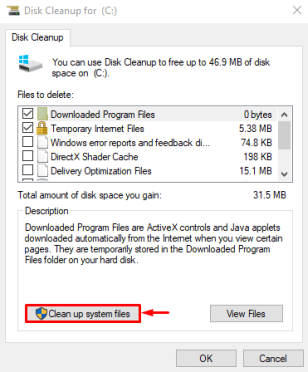

В результате вы увидите еще одну опцию «Очистить системные файлы», нажмите на нее, чтобы продолжить:

Снова выбираем диск и нажимаем кнопку «ОК»:

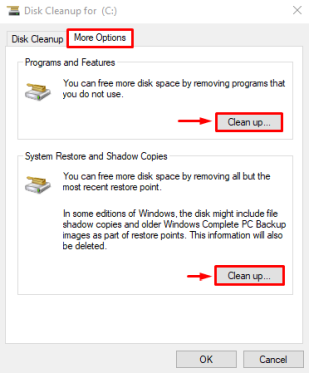

Перейдите на вкладку «Дополнительные параметры», выберите параметр «Программы и компоненты» или «Восстановление системы и теневые копии», чтобы очистить диск:

Это не только очистит диск, но и освободит место в оперативной памяти для повышения производительности Windows 10.

Вывод

Чтобы освободить оперативную память в вашей системе Windows 10, вы можете отключить запускаемые приложения, выполнить сканирование на наличие вредоносных программ, уменьшить визуальные эффекты, создать виртуальную память, перезапустить Windows, остановить фоновые приложения или выполнить дефрагментацию диска. В этой статье были рассмотрены десять советов по освобождению оперативной памяти в операционной системе Windows 10.