Если вы работали с компьютерами, вы должны знать термины ЦП и ГП. Вычисления и обработка выполняются центральным процессором. Пока GPU готов обрабатывать графические задачи. На современных компьютерах и мобильных телефонах ЦП обычно отвечает за всю обработку. Графический процессор обычно просто обрабатывает визуальные эффекты и графику для видеоигр. Это означает, что даже если у графического процессора больше возможностей, видео и анимация в веб-браузере, таком как Chrome, обрабатываются процессором. Но с GPU/аппаратным ускорением все может быть иначе.

Благодаря аппаратному ускорению Chrome игры, анимация и фильмы, в которые вы можете играть в браузере, обрабатываются графическим процессором. Графический процессор выполняет его более эффективно, а также снимает часть нагрузки с центрального процессора, позволяя ему работать более эффективно.

Преимущества и недостатки активации ускорения графического процессора в Google Chrome

Как следует из названия, GPU/аппаратное ускорение означает эффективную работу или за меньшее время. Это относится к тому, когда программа использует аппаратное обеспечение компьютера для поддержки определенных операций более эффективно, чем то, на что способно программное обеспечение. Короче говоря, чтобы ваше программное обеспечение работало более эффективно, оно снимает некоторые обязанности с аппаратных компонентов.

Аппаратное ускорение для Google Chrome, безусловно, имеет множество преимуществ. Графический процессор обрабатывает любые браузерные игры, анимацию или видео, в которые вы можете играть как часть аппаратного ускорения Chrome. Помимо улучшения работы, GPU также частично снимает нагрузку с ЦП, позволяя ЦП работать с максимальной производительностью. Если вы хотите увидеть, какое значение имеет аппаратное ускорение, вы можете посмотреть HD-видео или поиграть в видеоигры и посмотреть, замедляется ли ваш браузер или работает ли он плавно. Вы также можете заметить изменение условий изображения.

Аппаратное ускорение часто всегда включено в Google Chrome. Но если вы хотите иногда включать его, рекомендуется делать это всякий раз, когда вы используете 3D-графику, высококачественные онлайн-игры, игры с движением и HD-видео. Это приводит к высокой частоте кадров (FPS).

Перекладывание некоторых обязанностей на ваше оборудование может сделать ваш компьютер медленнее, чем он был, если он находится в нижней части диапазона. Из-за этого наличие хорошей видео- и звуковой карты необходимо для положительного опыта работы в Интернете. После включения аппаратного ускорения, если вы заметите, что ваш веб-браузер работает медленно, рассмотрите возможность его отключения и посмотрите, улучшится ли скорость.

В этой статье описываются три метода включения и отключения аппаратного ускорения в Chrome, а также способы проверки его включения и принудительного ускорения при необходимости. Функция аппаратного ускорения в Google Chrome использует графический процессор вашего компьютера для ускорения операций и высвобождения критического времени процессора.

МЕТОД 1. Включите параметр аппаратного ускорения в настройках Google Chrome.

В этом методе мы включим опцию аппаратного ускорения в Google Chrome, пройдя через настройки приложения Google Chrome.

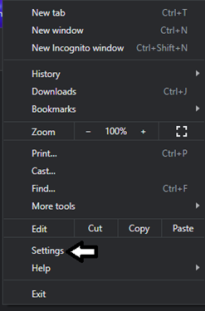

Первый шаг — запустить Chrome и перейти на вкладку «Настройки».

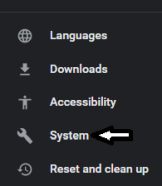

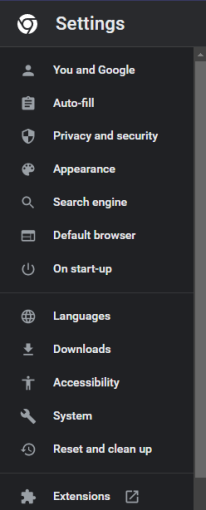

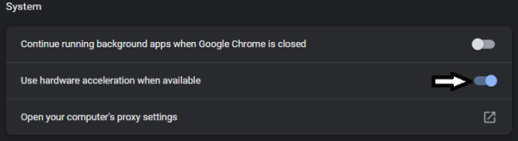

Затем найдите Система на левой боковой панели в меню настроек. В некоторых версиях Chrome система находится в раскрывающемся разделе дополнительных настроек, поэтому обязательно разверните ее.

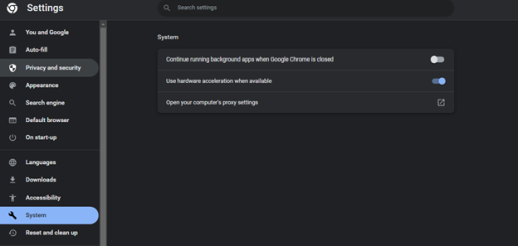

Проверьте наличие параметра «Использовать аппаратное ускорение, когда доступно» после выбора System.

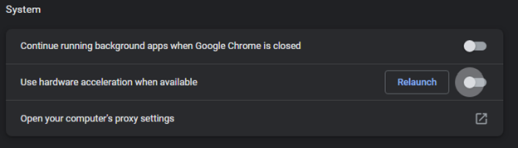

Проверьте наличие параметра «Использовать аппаратное ускорение, когда доступно» после выбора System. Там же находится переключатель включения/выключения. Переключатель обычно находится на стороне «ON». Переведите переключатель в положение «ВЫКЛ.», а затем нажмите «Перезапустить», чтобы применить изменения.

СПОСОБ 2. Включите режим аппаратного ускорения для Google Chrome с помощью редактора реестра Windows.

В этом методе мы будем использовать редактор реестра Windows, чтобы включить режим аппаратного ускорения для Google Chrome, добавив 32-битный файл значения D-WORD в папку Chrome и включив его. Этот метод ограничен только устройствами Windows, поскольку он включает реестр.

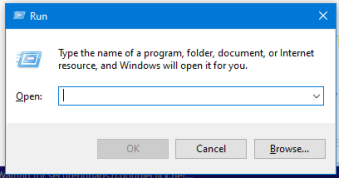

Одновременно нажав клавиши Windows и R, вы можете запустить окно «Выполнить».

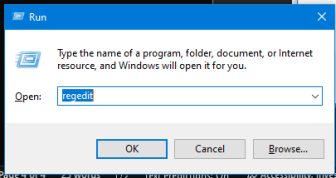

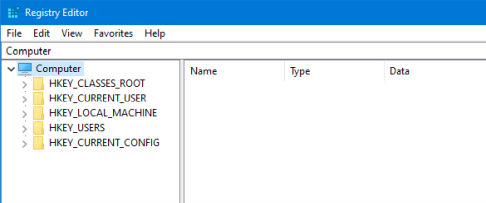

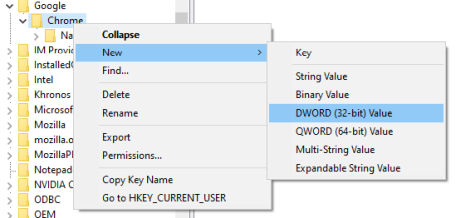

Редактор реестра запустится, как только вы введете «Regedit» и нажмете «ОК» или «Ввод».

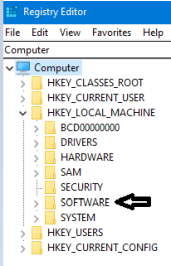

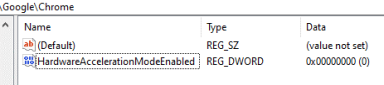

Направляем в ветку HKEY_LOCAL_MACHINESOFTWAREPoliciesGoogleChrome.

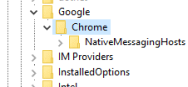

Затем щелкните правой кнопкой мыши кнопку Chrome, чтобы создать последнее 32-битное значение DWORD.

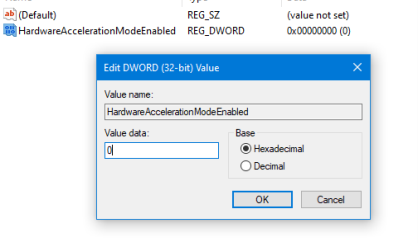

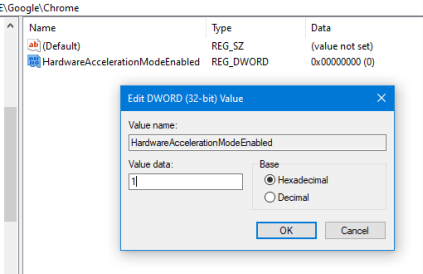

Теперь вам нужно переименовать это значение в «HardwareAccelerationModeEnabled». Включите или выключите аппаратное ускорение в Chrome, установив значение 0 или 1.

Наконец, просто перезагрузите компьютер или устройство, чтобы применить настройки.

МЕТОД 3: альтернативный способ включения или отключения ускорения графического процессора для Google Chrome

Этот альтернативный метод состоит в том, чтобы переопределить один из нескольких системных флагов и активировать ускорение, когда Chrome не хочет этого делать. Такой подход используется, когда в настройках приложения скрыта возможность включения или отключения аппаратного ускорения.

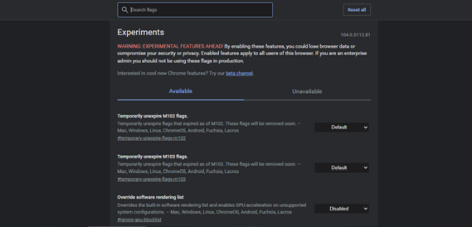

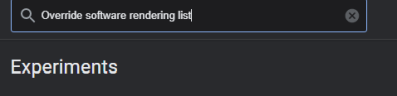

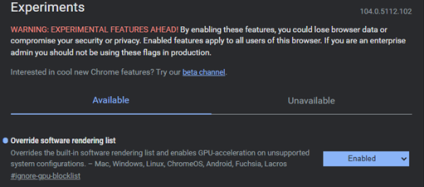

Первый шаг — ввести chrome:/flags в адресную строку Chrome.

![]()

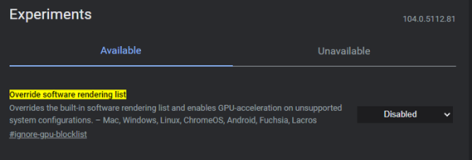

Как видно на следующем изображении, открывается страница флага. Найдите список рендеринга программного обеспечения Override, в котором используется панель поиска.

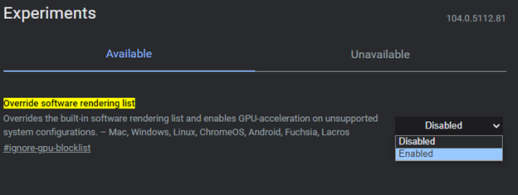

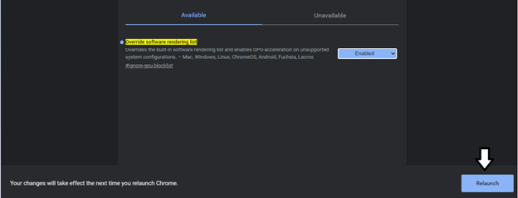

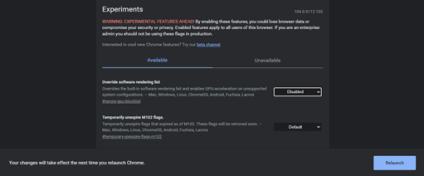

После этого разверните параметр Disabled и измените его на Enabled. После включения нажмите кнопку «Перезапустить сейчас» в правом нижнем углу.,

Теперь мы можем проверить, успешно ли включено ускорение, посетив страницу chrome://gpu. Помимо большинства вариантов, у нас должно быть аппаратное ускорение рядом с ними.

Отключить аппаратное ускорение в Chrome очень просто. Вы можете сделать это, просто следуя предыдущим инструкциям, чтобы включить его, но выбрав Disabled в списке Override software rendering.

Вывод

В этой статье подробно обсуждался режим ускорения графического процессора для Google Chrome, где были рассмотрены все аспекты. В этой статье также обсуждались преимущества и недостатки включения аппаратного ускорения или ускорения графического процессора. Мы также реализовали три различных метода включения и отключения этого режима ускорения через настройки Google Chrome, редактор реестра Windows и даже явное включение этого параметра на вкладке флагов Chrome.